Raspberry Pi에서 자체 로컬 LLM을 실행하는 방법

2022년 말 OpenAI의 놀라운 ChatGPT 3 출시 이후 LLM(대형 언어 모델)은 에세이 작성부터 복잡한 질문에 대한 답변에 이르기까지 놀라운 기능을 보여줌으로써 전 세계의 상상력을 사로잡았습니다.

그러나 LLM의 장점을 활용하기 위해 OpenAI, Google 또는 Anthropic과 같은 회사에 의존하거나 잠재적으로 개인 데이터를 공유할 필요는 없습니다. 저렴한 Raspberry Pi만 있으면 나만의 로컬 AI 채팅 기반 도우미를 설정할 수 있습니다. 이 가이드에서는 방법을 보여줍니다.

필요한 것

Raspberry Pi에서 자체 LLM을 설정하려면 다음과 같은 몇 가지 필수 구성 요소가 필요합니다.

- Raspberry Pi : LLM은 리소스 집약적이므로 최적의 성능을 위해서는 가장 강력한 Raspberry Pi를 사용하는 것이 가장 좋습니다. 이 기사를 작성할 당시에는 8GB RAM을 갖춘 Raspberry Pi 5를 선택하는 것이 좋습니다.

- Raspberry Pi OS가 포함된 microSD 카드: LLM을 실행하는 데 그래픽 사용자 인터페이스가 필요하지 않으므로 최대 성능을 위해 Raspberry Pi OS의 라이트 버전을 사용하는 것이 좋습니다(터미널 및 SSH를 사용하여 원격으로 상호 작용할 수 있음). 그러나 Raspberry Pi를 다른 작업에 사용하거나 기본 컴퓨터로 사용하는 경우 일반 버전의 Raspberry Pi OS를 사용할 수 있습니다.

- 추가 구성 요소 : Raspberry Pi 및 빠른 microSD 카드 외에도 안정적인 전원 공급 장치(공식 전원 공급 장치 권장), 초기 설정을 위한 키보드, 마우스 및 모니터(SSH를 사용하는 경우 선택 사항)가 필요합니다. 필요한 소프트웨어와 모델을 다운로드하기 위한 인터넷 연결이 필요합니다.

이러한 구성 요소를 준비하면 Raspberry Pi에서 자체 LLM 설정을 시작할 수 있습니다.

올라마 설치

Raspberry Pi에서 자체 LLM을 설정하는 첫 번째 단계는 필요한 소프트웨어를 설치하는 것입니다. 현재 로컬에서 LLM을 실행하는 데 가장 인기 있는 두 가지 선택은 llama.cpp와 Ollama입니다.

- llama.cpp 는 Raspberry Pi를 포함한 광범위한 하드웨어에서 실행될 수 있는 Meta의 LLaMA(Large Language Model Adapter)를 경량 C++로 구현한 것입니다. Georgi Gerganov가 개발했으며 2023년 3월에 출시되었습니다.

- 반면에 Ollama는 llama.cpp를 기반으로 구축되어 여러 사용자 친화적인 기능을 제공합니다. 각 모델이 예상하는 형식으로 템플릿 채팅 요청을 자동으로 처리하고 클라이언트 요청에 따라 필요에 따라 모델을 로드 및 언로드합니다. Ollama는 또한 양자화된 모델을 포함한 모델 다운로드 및 캐싱을 관리하므로 이름으로 요청할 수 있습니다.

이 가이드에서는 사용 편의성과 추가 기능 때문에 Ollama를 사용합니다.

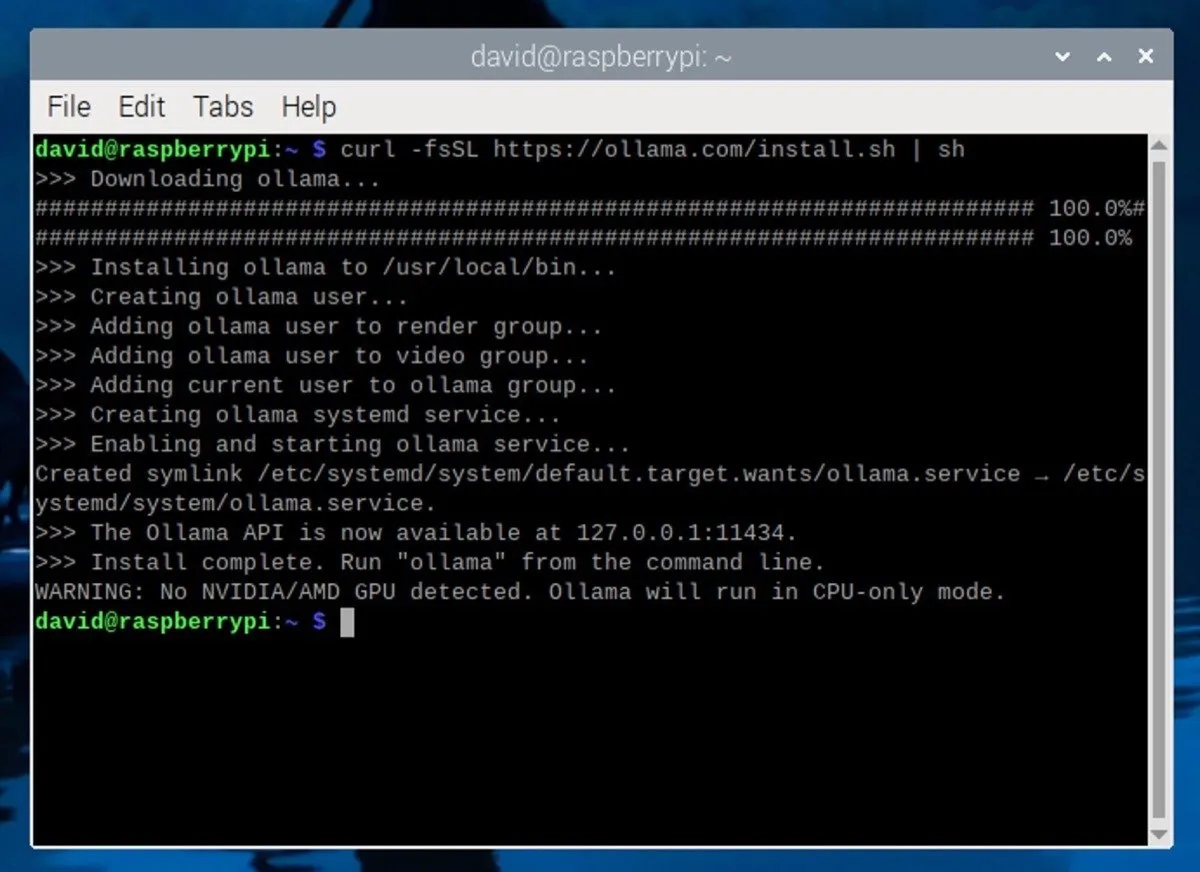

Raspberry Pi에 Ollama를 설치하려면 Raspberry Pi에서 터미널 창을 엽니다. SSH를 사용하는 경우 선호하는 SSH 클라이언트를 사용하여 Raspberry Pi에 연결하세요. 그런 다음 터미널에 다음 명령을 입력합니다.

이 명령은 공식 Ollama 웹사이트에서 설치 스크립트를 다운로드하고 실행합니다. 스크립트는 자동으로 필요한 종속성을 설치하고 Raspberry Pi에 Ollama를 설정합니다.

LLM 다운로드 및 실행

Ollama가 설치되었으면 이제 대규모 언어 모델을 다운로드할 차례입니다. 8GB RAM이 장착된 Raspberry Pi를 사용하는 경우 최대 70억 개의 매개변수(AI가 출력을 결정하는 데 사용하는 설정)로 모델을 실행할 수 있습니다.

인기 있는 선택으로는 Mistral(7B), Gemma(7B 또는 2B), Llama 2 uncensored(7B) 또는 Microsoft의 Phi-3(3.8B)이 있습니다. Ollama 라이브러리 페이지 에서 지원되는 모든 모델을 볼 수 있습니다 .

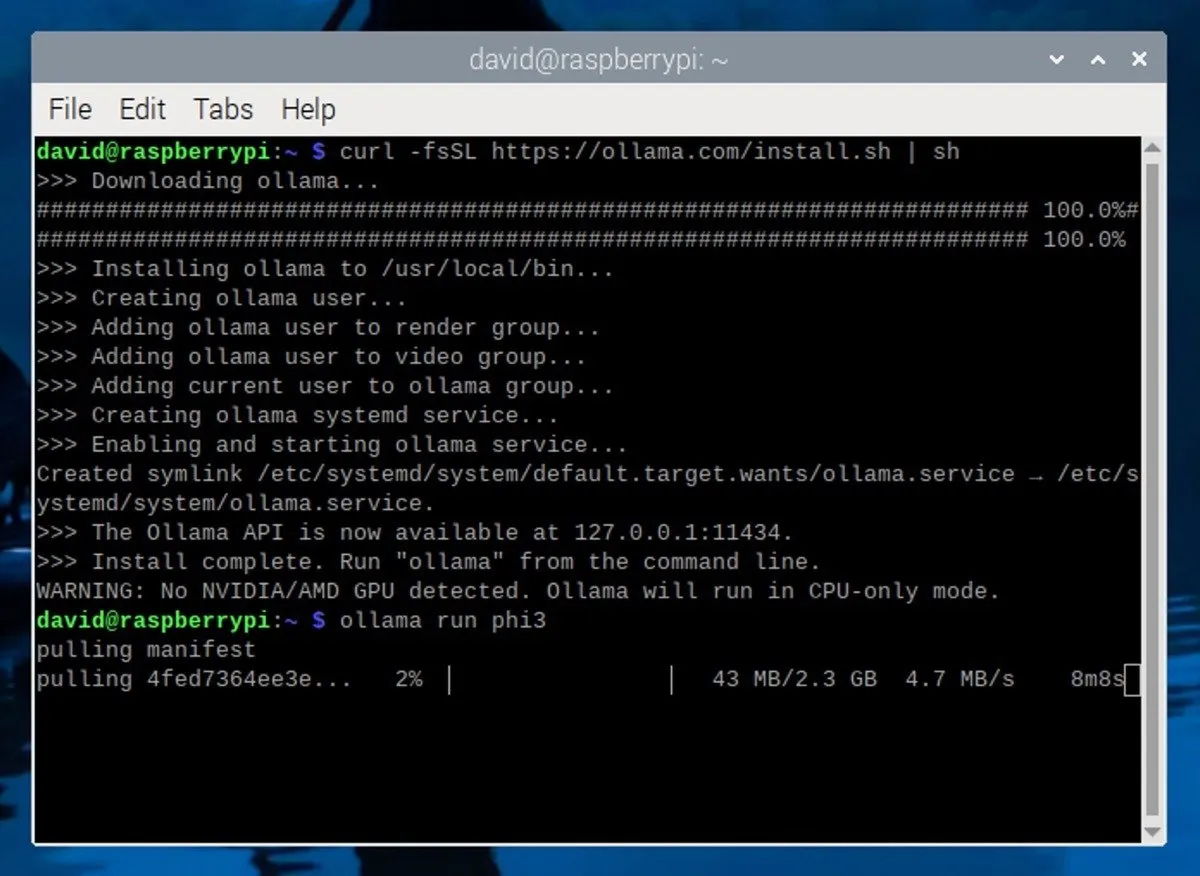

이 가이드에서는 Microsoft의 Phi-3 모델을 사용합니다 . 작은 크기와 효율성에도 불구하고 Phi-3는 매우 유능한 모델입니다. 설치하려면 터미널에서 다음 명령을 실행하면 됩니다.

이 명령은 Phi-3 모델을 다운로드 및 설치하고 해당 모델과의 대화형 채팅 세션을 자동으로 시작합니다.

Raspberry Pi에서 로컬 LLM 사용

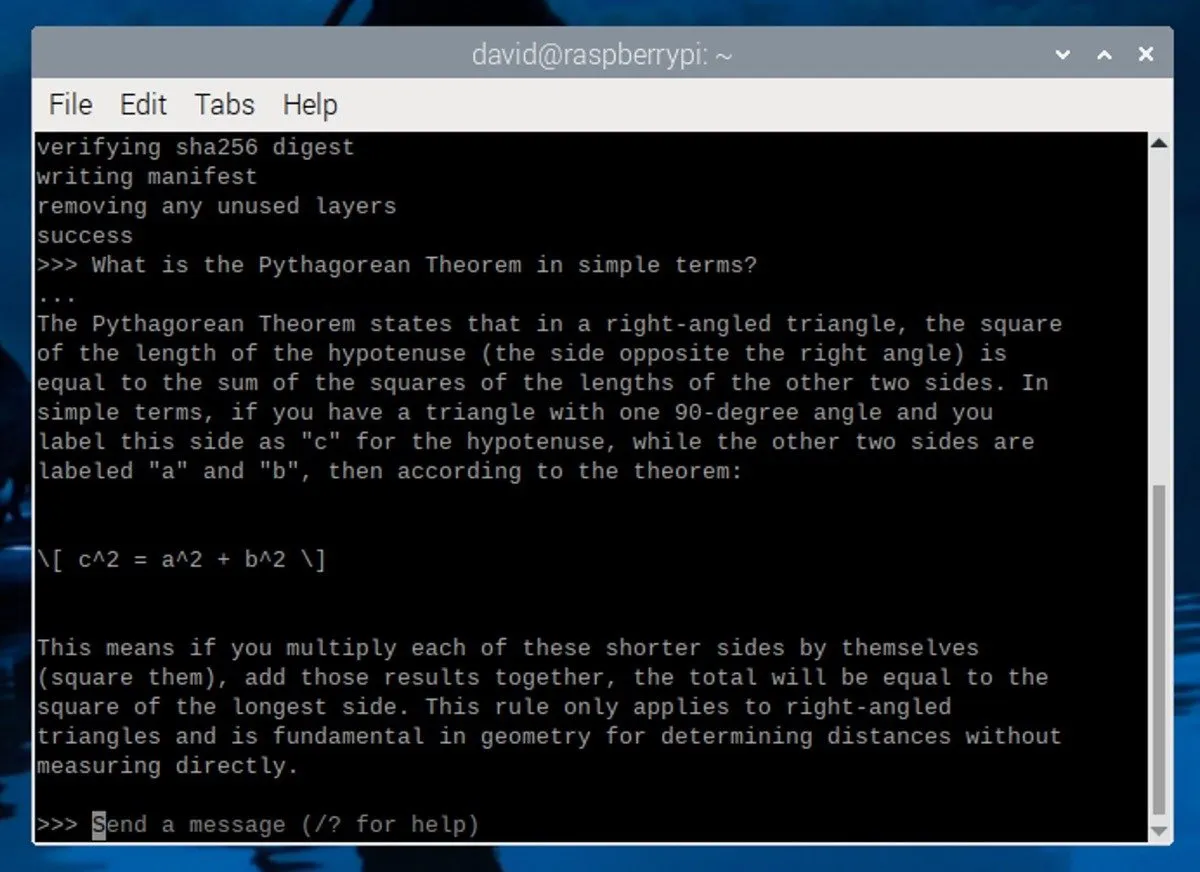

Phi-3 모델을 다운로드하고 설치하면 터미널에 다음과 같은 메시지가 표시됩니다.

이는 LLM이 실행 중이며 사용자 입력을 기다리고 있음을 의미합니다. 모델과의 상호작용을 시작하려면 메시지를 입력하고 Enter를 누르세요.

효과적인 프롬프트를 작성하기 위한 몇 가지 팁은 다음과 같습니다.

- 구체적으로 작성하십시오 . LLM이 귀하가 원하는 것을 이해할 수 있도록 명확하고 자세한 지침이나 질문을 제공하십시오.

- 컨텍스트 설정 : LLM에 보다 관련성 있는 응답을 생성하는 데 도움이 되는 몇 가지 배경 정보나 시나리오를 제공합니다.

- 역할 정의 : 스토리텔러, 교사, 기술 전문가 등 LLM이 응답에서 가정해야 하는 역할을 지정합니다.

LLM 세션을 종료하려면 Ctrl+를 누르 d거나 /bye명령을 입력하세요. 나중에 다른 세션을 시작하려면 새 터미널을 열고 ollama run phi3명령을 실행하면 됩니다. 모델은 이미 다운로드되어 있으므로 다시 다운로드할 필요 없이 빠르게 시작됩니다.

Raspberry Pi 5의 성능에는 한계가 있으며 초당 몇 개의 토큰만 출력할 수 있다는 점을 명심하세요. 더 나은 성능을 위해서는 전용 그래픽 카드가 있는 더 강력한 컴퓨터에서 Ollama를 실행하는 것이 좋습니다.

이미지 크레디트: Unsplash . David Morelo의 스크린샷.

답글 남기기