Raspberry Pi で独自のローカル LLM を実行する方法

2022年後半にOpenAIがChatGPT 3を驚異的にリリースして以来、大規模言語モデル(LLM)は、エッセイの作成から複雑な質問への回答まで、驚くべき機能を発揮して世界中の注目を集めています。

ただし、LLM の力を活用するために、OpenAI、Google、Anthropic などの企業に頼って個人データを共有する必要はまったくありません。手頃な価格の Raspberry Pi があれば、独自のローカル AI チャットベース アシスタントをセットアップできます。このガイドでは、その方法を説明します。

必要なもの

Raspberry Pi に独自の LLM をセットアップするには、いくつかの重要なコンポーネントが必要です。

- Raspberry Pi : LLM はリソースを大量に消費するため、最適なパフォーマンスを得るには、入手可能な最も強力な Raspberry Pi を使用するのが最適です。この記事の執筆時点では、8 GB の RAM を搭載した Raspberry Pi 5 が推奨されています。

- Raspberry Pi OS 搭載の microSD カード: パフォーマンスを最大限に高めるには、Raspberry Pi OS のライト バージョンの使用を検討してください。LLM を実行するためにグラフィカル ユーザー インターフェイスは不要です (ターミナルと SSH を使用してリモートで操作できます)。ただし、Raspberry Pi を他のタスクに使用したり、メイン コンピューターとして使用したりする場合は、Raspberry Pi OS の通常バージョンを使用できます。

- 追加コンポーネント: Raspberry Pi と高速 microSD カードの他に、信頼性の高い電源 (公式のものをお勧めします)、初期設定用のキーボード、マウス、モニター (SSH を使用する場合はオプション)、必要なソフトウェアとモデルをダウンロードするためのインターネット接続が必要です。

これらのコンポーネントが手元にあれば、Raspberry Pi に独自の LLM をセットアップする準備が整います。

Ollamaをインストールする

Raspberry Pi に独自の LLM を設定するための最初のステップは、必要なソフトウェアをインストールすることです。現在、LLM をローカルで実行するための最も一般的な 2 つの選択肢は、llama.cpp と Ollama です。

- llama.cpp は、Raspberry Pi を含む幅広いハードウェアで実行できる Meta の LLaMA (Large Language Model Adapter) の軽量 C++ 実装です。Georgi Gerganov によって開発され、2023 年 3 月にリリースされました。

- 一方、Ollamaは llama.cpp を中心に構築されており、いくつかのユーザーフレンドリーな機能を提供します。各モデルが期待する形式へのテンプレートチャット要求を自動的に処理し、クライアントの要求に基づいてオンデマンドでモデルをロードおよびアンロードします。また、Ollama は量子化モデルを含むモデルのダウンロードとキャッシュを管理するため、名前でモデルを要求できます。

このガイドでは、使いやすさと追加機能の点から、Ollama を使用します。

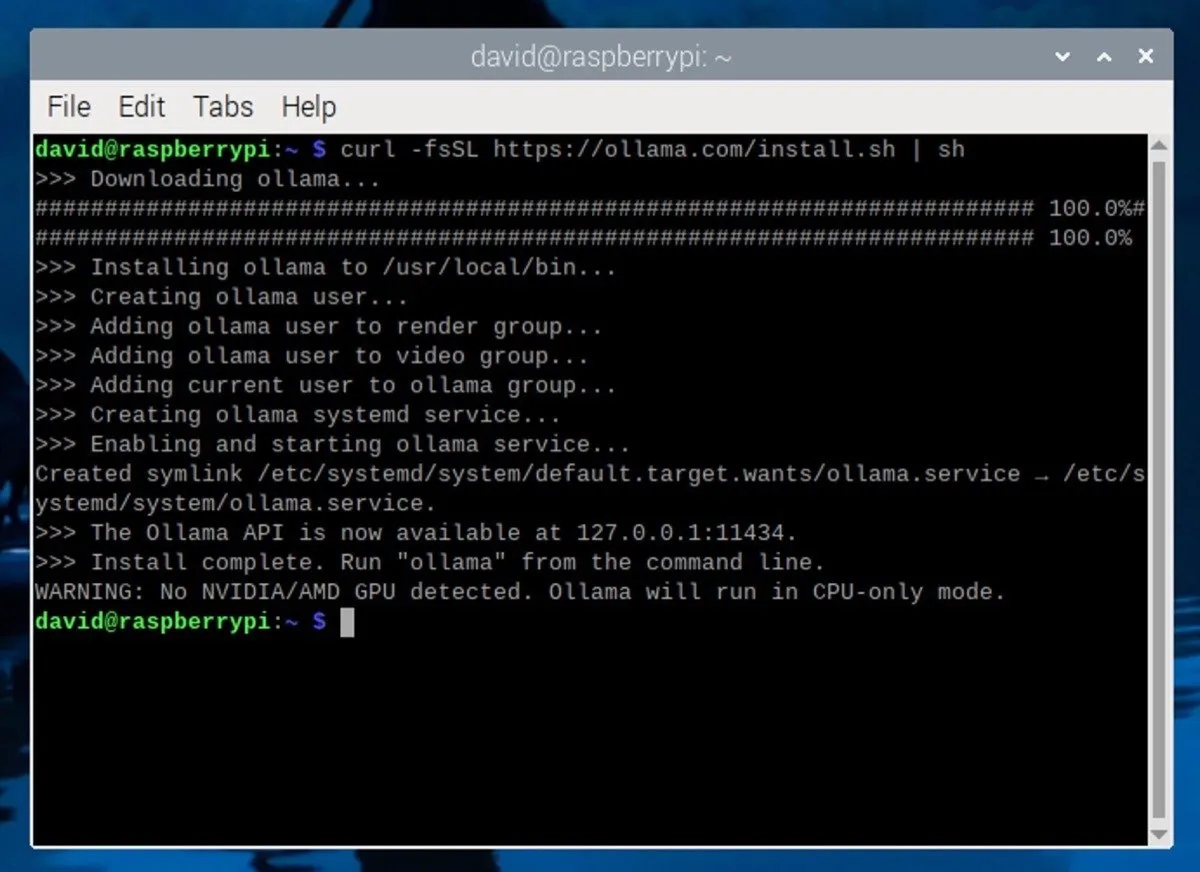

Raspberry Pi に Ollama をインストールするには、Raspberry Pi でターミナル ウィンドウを開きます。SSH を使用している場合は、好みの SSH クライアントを使用して Raspberry Pi に接続します。次に、ターミナルで次のコマンドを入力します。

このコマンドは、Ollama の公式 Web サイトからインストール スクリプトをダウンロードして実行します。スクリプトは必要な依存関係を自動的にインストールし、Raspberry Pi に Ollama をセットアップします。

LLMをダウンロードして実行する

Ollama をインストールしたら、大規模な言語モデルをダウンロードします。8 GB の RAM を搭載した Raspberry Pi を使用している場合は、最大 70 億のパラメーター (AI が出力を決定するために使用する設定) を持つモデルを実行できます。

人気のある選択肢としては、Mistral (7B)、Gemma (7B または 2B)、Llama 2 uncensored (7B)、Microsoft の Phi-3 (3.8B) などがあります。サポートされているすべてのモデルは、Ollama ライブラリ ページで確認できます。

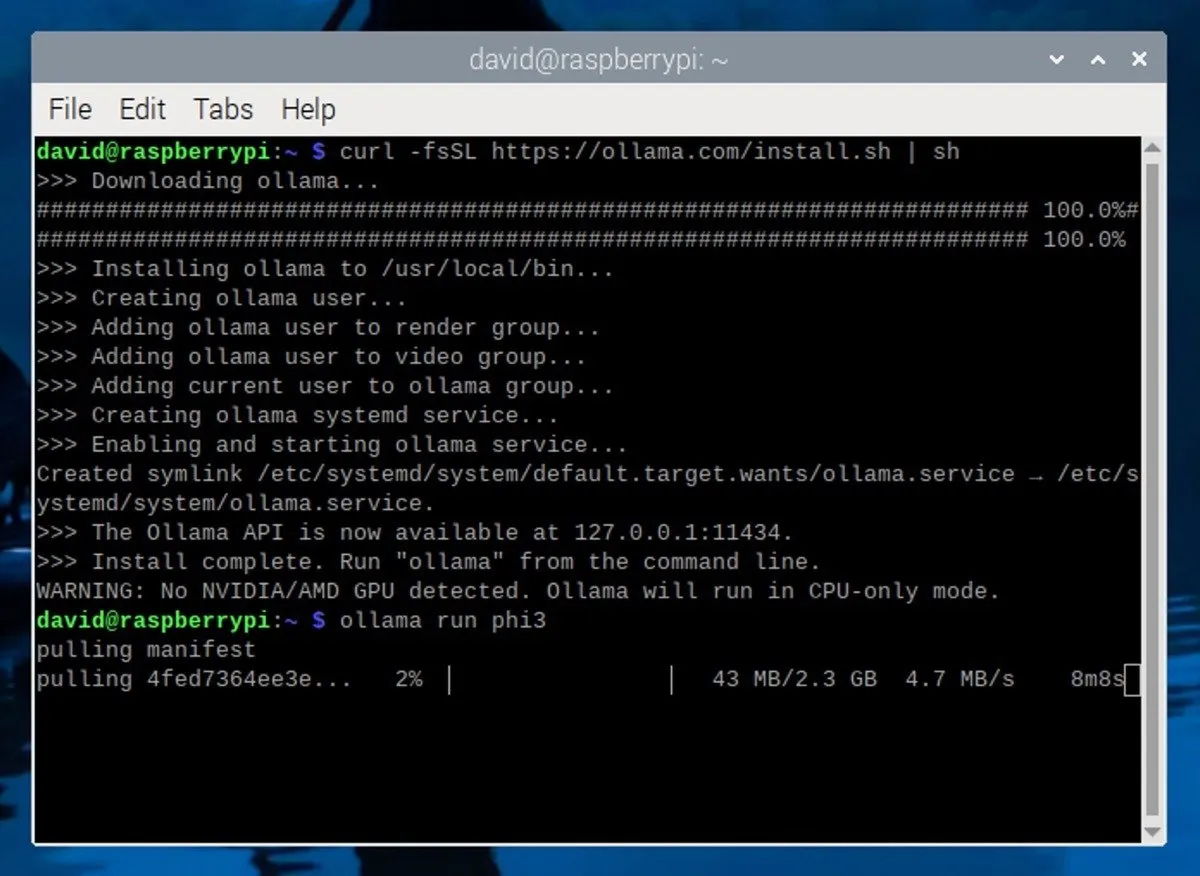

このガイドでは、 Microsoft の Phi-3 モデルを使用します。サイズが小さく効率が良いにもかかわらず、Phi-3 は非常に優れたモデルです。インストールするには、ターミナルで次のコマンドを実行するだけです。

このコマンドは、Phi-3 モデルをダウンロードしてインストールし、モデルとの対話型チャット セッションを自動的に開始します。

Raspberry Pi でローカル LLM を使用する

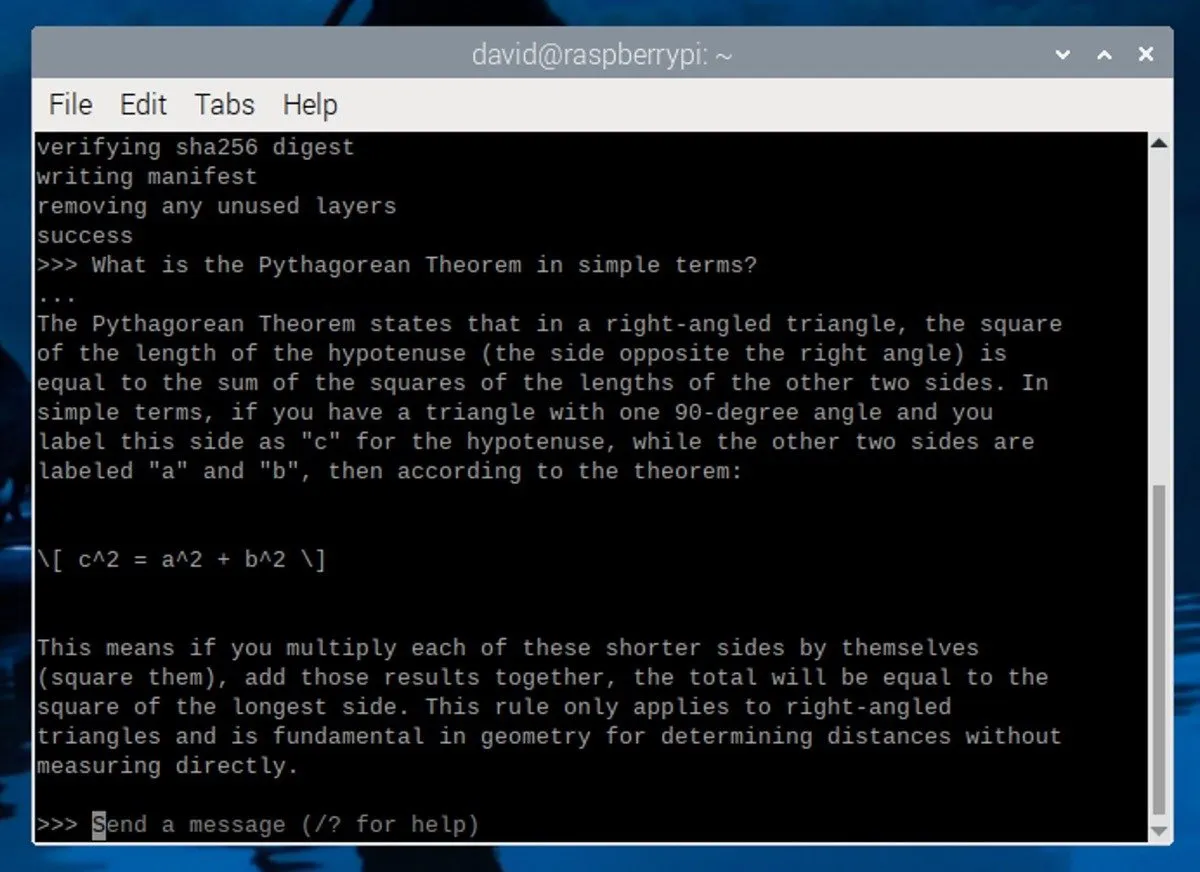

Phi-3 モデルをダウンロードしてインストールすると、ターミナルに次のようなプロンプトが表示されます。

これは、LLM が実行中で、入力を待機していることを意味します。モデルとの対話を開始するには、メッセージを入力して Enter キーを押します。

効果的なプロンプトを作成するためのヒントをいくつか紹介します。

- 具体的にしてください: LLM があなたが何を求めているのかを理解できるように、明確で詳細な指示や質問を提供してください。

- コンテキストを設定する: LLM に背景情報やシナリオを提供して、より関連性の高い応答を生成できるようにします。

- 役割を定義する: ストーリーテラー、教師、技術専門家など、LLM が応答で担うべき役割を指定します。

LLM セッションを終了するには、Ctrl+を押すdか、/byeコマンドを入力します。後で別のセッションを開始する場合は、新しいターミナルを開いてコマンドを実行しますollama run phi3。モデルはすでにダウンロードされているため、再度ダウンロードする必要なくすぐに起動します。

Raspberry Pi 5 のパフォーマンスには限界があり、1 秒あたり数トークンしか出力できないことに注意してください。パフォーマンスを向上させるには、専用のグラフィック カードを搭載したより強力なコンピューターで Ollama を実行することを検討してください。

画像クレジット: Unsplash。スクリーンショットは David Morelo によるものです。

コメントを残す