Como executar LLMs localmente no Android

O que saber

- Instale um aplicativo como o MLC Chat em seu dispositivo Android para experimentar e conversar com LLMs localmente.

- Baixe um dos modelos disponíveis e toque no ícone ‘Bate-papo’ para começar a conversar com o LLM escolhido.

- O aplicativo MLC Chat permite baixar Gemma 2b, RedPajama, Llama3, Phi-2, Mistral e Llama2.

Existem vários LLMs que você pode executar localmente no seu PC. Mas quando se trata de smartphones, as opções são um pouco limitadas. Você precisa executar um modelo de linguagem pequeno ou ter um dispositivo premium com poder de processamento suficiente para lidar com LLMs. De qualquer forma, é possível conversar com modelos de idiomas localmente e offline.

Como executar LLMs localmente no Android

Modelos de linguagem grandes são, bem, grandes e exigem muita habilidade computacional. Mas mesmo que o seu dispositivo Android tenha recursos suficientes para executar SLMs (modelos de linguagem pequena), bem como LLMs, você ainda precisa de um aplicativo que permita experimentá-los com uma interface amigável.

É aqui que um aplicativo como o MLC Chat se torna útil. Use as etapas abaixo para executar LLMs localmente em seu Android usando o aplicativo MLC Chat.

Etapa 1: instale o aplicativo MLC Chat

- Aplicativo de bate-papo MLC | Link para Download

- Primeiramente, clique no link acima e baixe o APK do aplicativo MLC Chat. Quando solicitado, toque em Baixar mesmo assim .

- Instale o aplicativo MLCChat. Uma vez feito isso, abra -o .

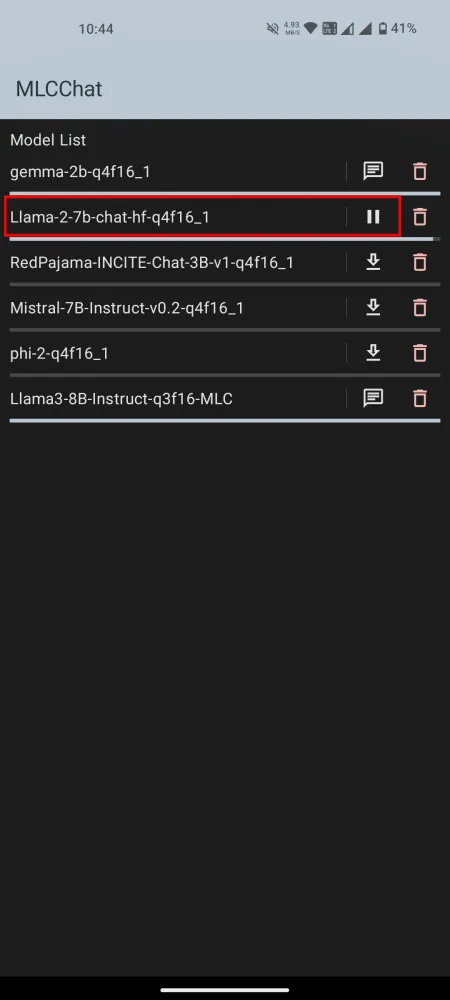

Etapa 2: Baixe um LLM

No aplicativo MLCChat, você terá uma lista de modelos disponíveis para download. Toque no link de download ao lado de um modelo de sua preferência e aguarde o download.

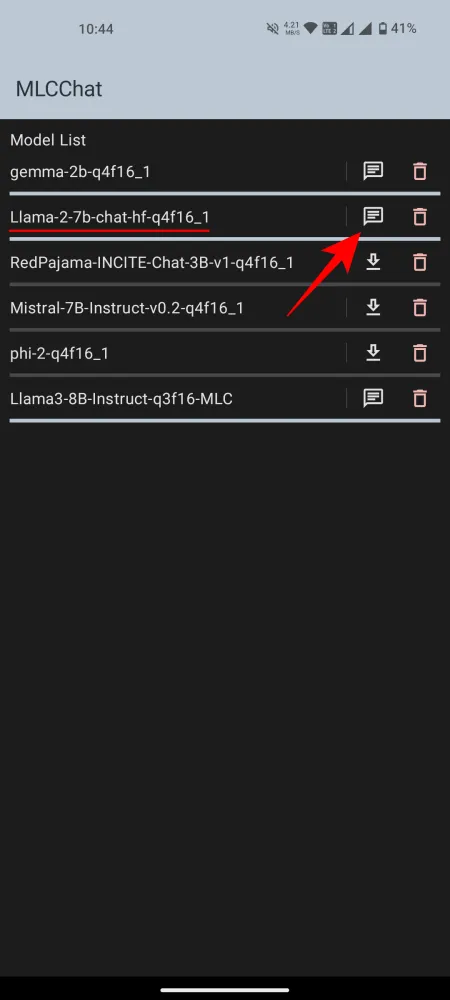

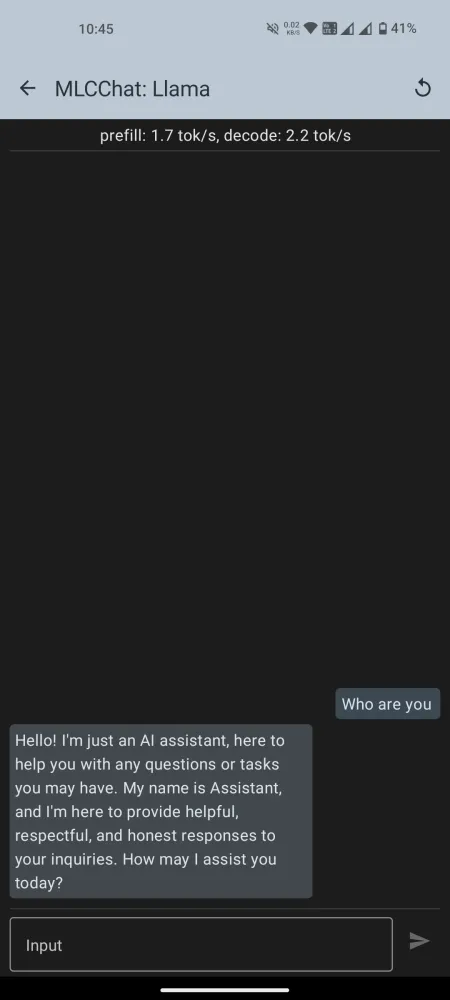

Etapa 3: execute o LLM instalado

Depois de baixado, toque no ícone de bate-papo próximo a ele para iniciar o bate-papo. Aguarde a inicialização do modelo. Quando estiver pronto, vá em frente e comece a conversar com a IA.

Observe que na lista de modelos disponíveis no aplicativo MLCChat, haverá alguns, como o Llama3, que exigirão muito poder de processamento. Mas você sempre pode instalar os modelos e testar para ver se eles estão funcionando perfeitamente. Caso contrário, tente um modelo de linguagem menor.

Em nossos testes (no Nothing Phone 1), o Gemma-2b falhou ao carregar, enquanto o Llama3 eliminou a IU do sistema. Os que funcionaram bem foram Llama-2 e Phi-2. A principal diferença entre LLMs e outros modelos de linguagem menores é a amplitude de informações nas quais eles são treinados (parâmetros). Portanto, escolha seus modelos de acordo com suas necessidades e capacidades do seu dispositivo Android.

Esperamos que você tenha conseguido instalar e executar LLMs em seu dispositivo Android localmente. Até a próxima vez!

Deixe um comentário