Jak uruchomić Llamę 3 przez Meta AI lokalnie

Co wiedzieć

- Wielkojęzyczny model Meta Llama 3 jest dostępny do pobrania i uruchomienia lokalnie w systemie.

- Pobierz Meta Llama 3 ze strony Llama.meta.com i użyj frameworku LLM, takiego jak LM studio, aby załadować model.

- Możesz także wyszukiwać i pobierać Meta Llama 3 z poziomu samego studia LM. Aby uzyskać szczegółowe instrukcje na ten temat, zapoznaj się z poniższym przewodnikiem.

Najnowszy model językowy Meta Llama 3 jest już dostępny za darmo. Chociaż możesz używać Meta AI, która działa na tym samym LLM, istnieje również możliwość pobrania modelu i uruchomienia go lokalnie w systemie.

Jak uruchomić Llamę 3 przez Meta AI lokalnie

Chociaż Meta AI jest dostępna tylko w wybranych krajach, możesz pobrać i uruchomić Llamę 3 lokalnie na swoim komputerze, niezależnie od regionu. Wykonaj poniższe kroki, aby uruchomić Llama 3 by Meta AI lokalnie.

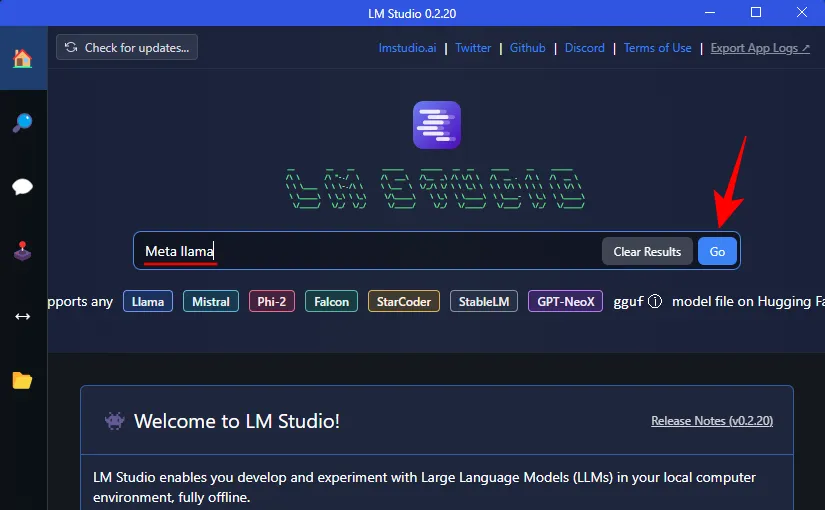

Krok 1: Zainstaluj LM Studio

Najpierw zainstalujmy framework, na którym będzie można uruchomić Llamę 3. Jeśli masz już w swoim systemie inną tego typu aplikację, możesz przejść do kolejnego kroku. Dla wszystkich innych, oto jak zdobyć studio LM:

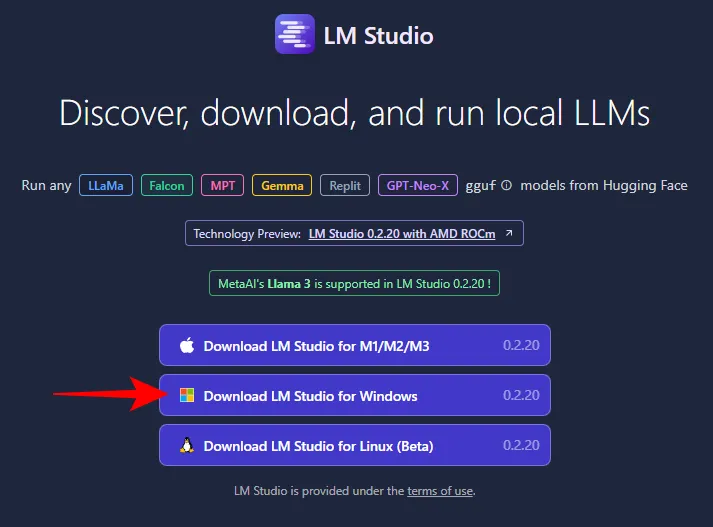

- Studio LM | Link do pobrania

- Skorzystaj z powyższego łącza i kliknij LM Studio dla Windows, aby je pobrać.

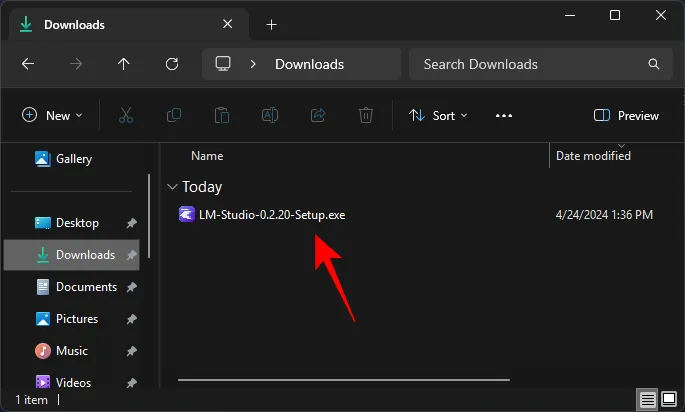

- Po pobraniu uruchom instalator i pozwól LM Studio zainstalować.

Krok 2: Pobierz lokalnie Meta’s Llama 3

Kiedy już będziesz mieć platformę LLM, czas pobrać Meta’s Llama 3 na swój komputer. Można to zrobić na kilka sposobów.

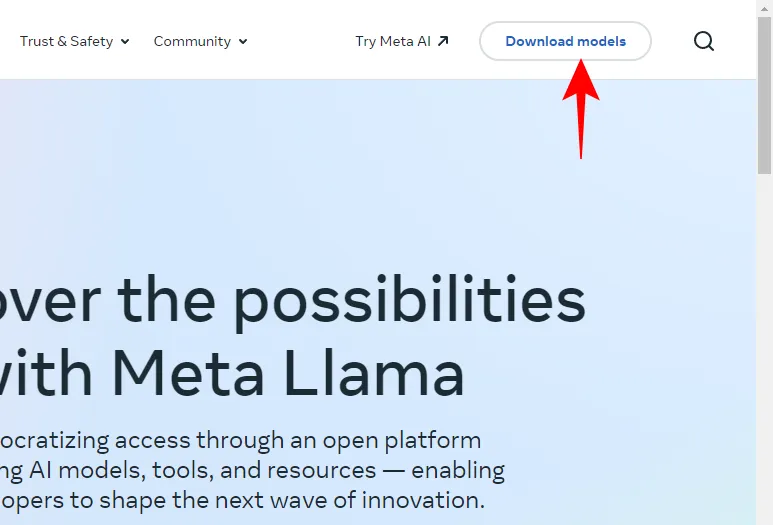

- Otwórz Llama.Meta.com i kliknij Pobierz modele .

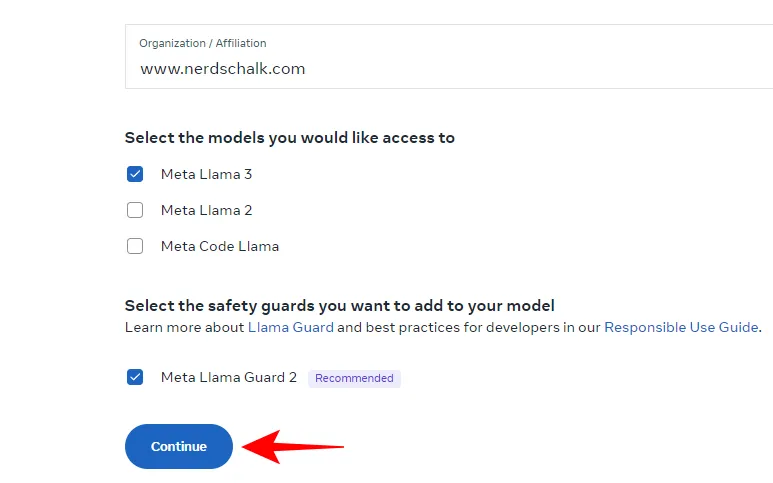

- Wprowadź swoje dane i poproś o pobranie LLM.

Jeśli powyższe nie zadziała, nie martw się. Możesz także użyć struktury LLM, aby pobrać LLM.

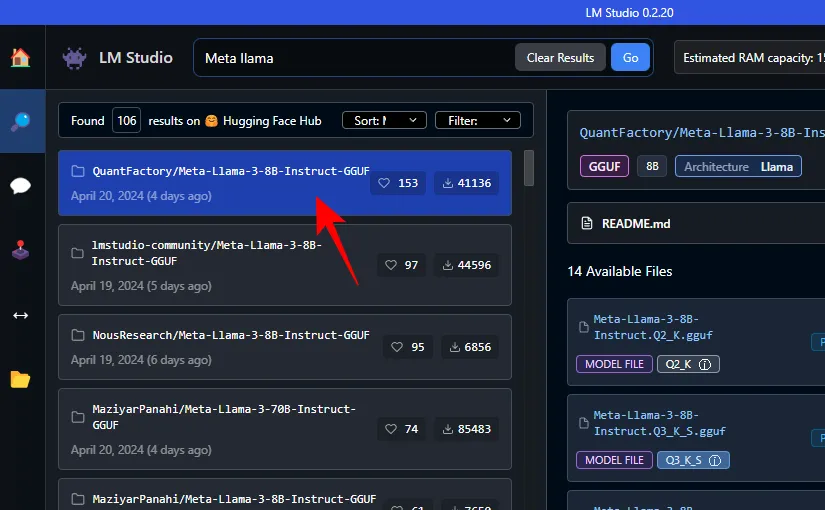

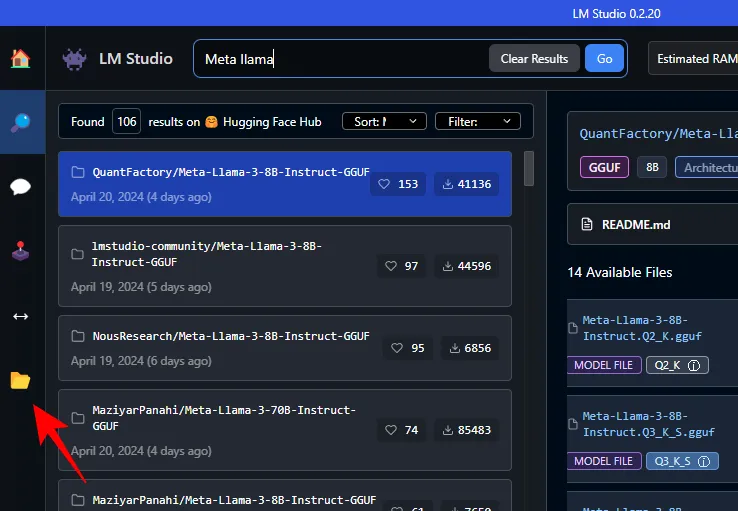

- Po prostu wyszukaj Meta Llama w polu wyszukiwania LM Studio.

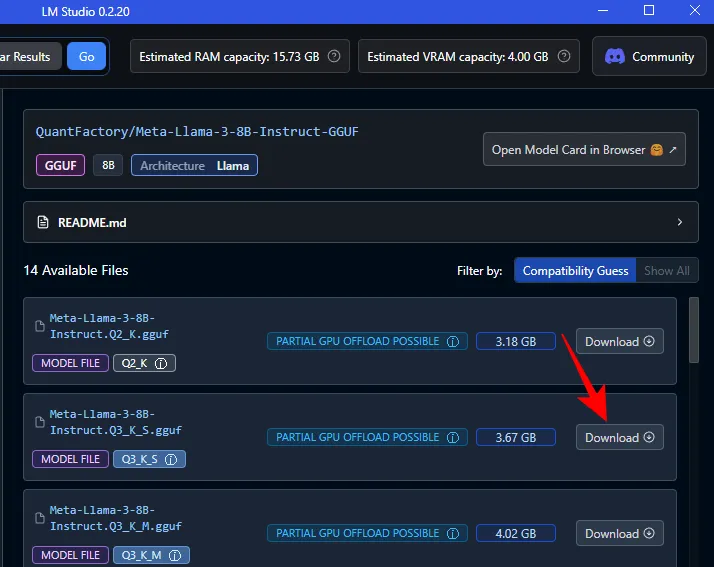

- Tutaj znajdziesz różne skwantowane LLM. Wybierz jeden.

- Po prawej stronie wybierz preferowaną wersję. Kliknij przycisk Pobierz obok niego.

- Poczekaj na zakończenie pobierania.

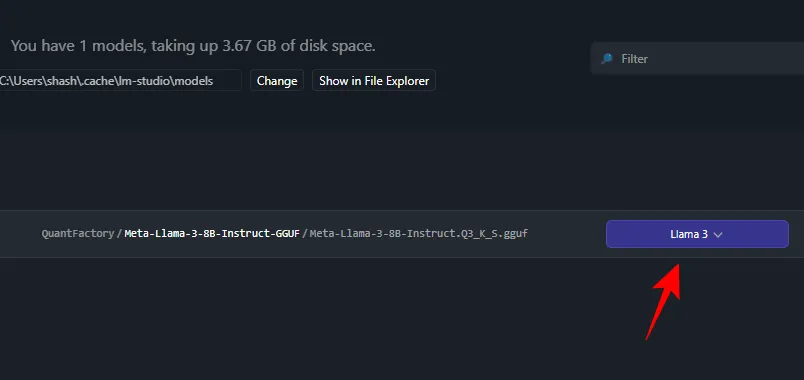

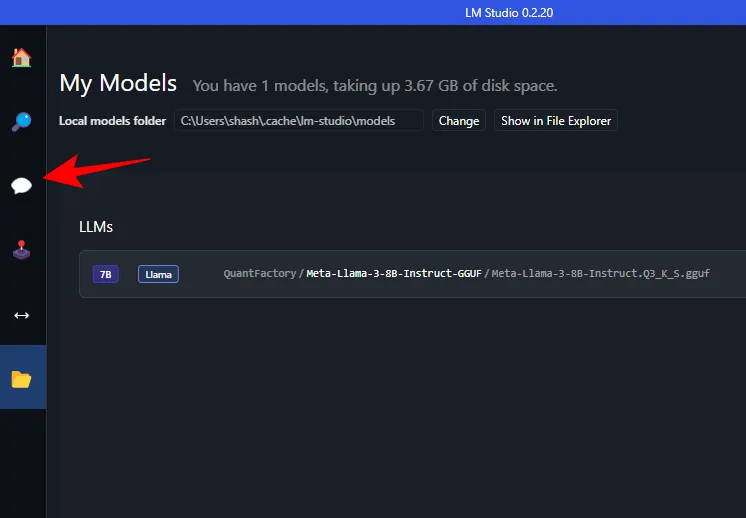

- Po zakończeniu kliknij Moje modele po lewej stronie.

- I sprawdź, czy pobieranie zostało zakończone.

Krok 3: Załaduj pobrany model

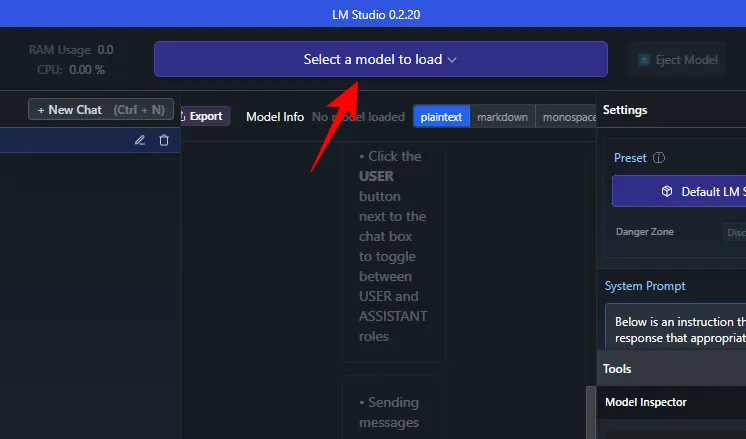

- Po zakończeniu pobierania kliknij czat AI po lewej stronie.

- Kliknij Wybierz model do załadowania .

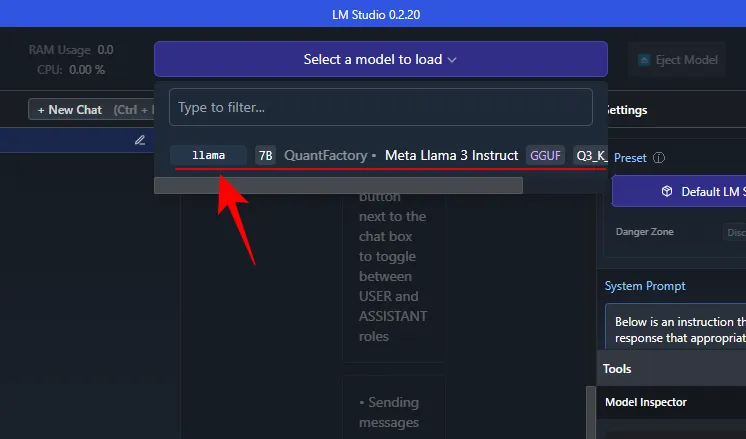

- I wybierz pobraną Meta Llama 3.

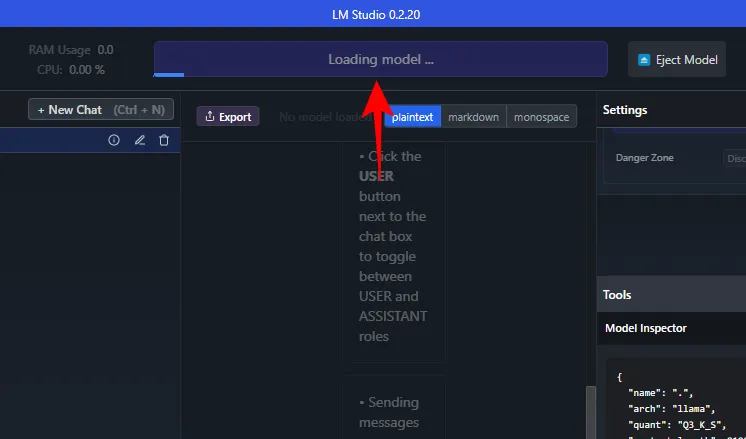

- Poczekaj, aż model się załaduje.

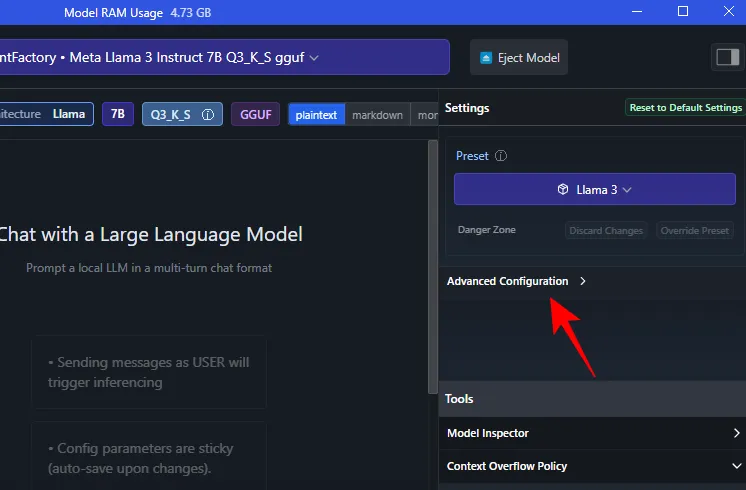

- Po załadowaniu możesz przenieść cały model do procesora graficznego. Aby to zrobić, kliknij opcję Konfiguracja zaawansowana w obszarze „Ustawienia”.

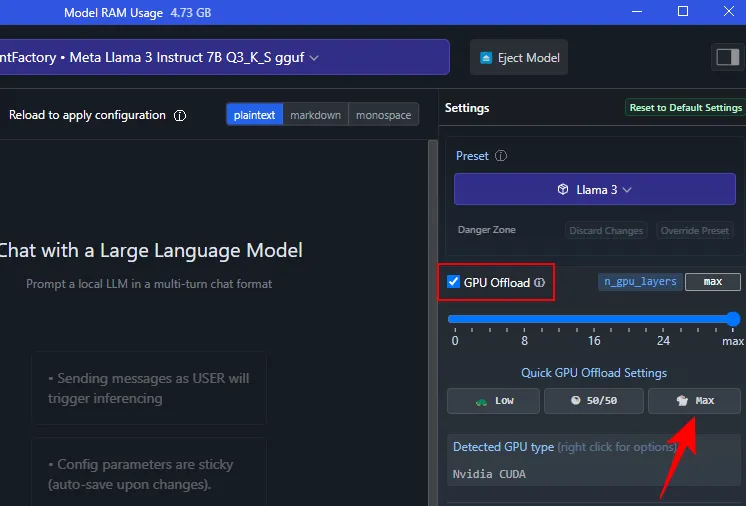

- Kliknij Max , aby przenieść cały model do GPU.

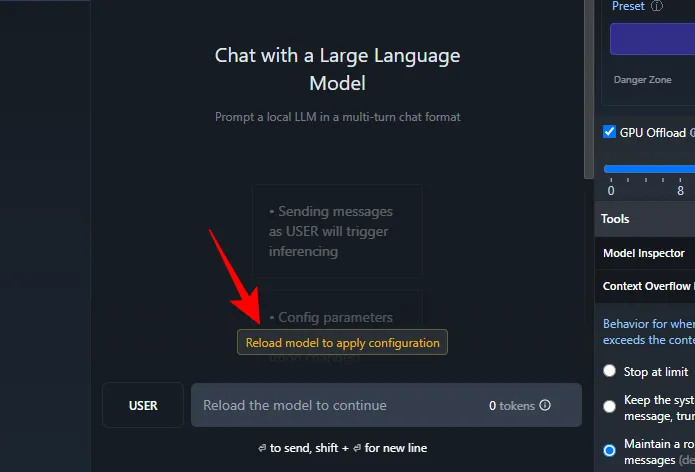

- Kliknij opcję Załaduj ponownie model, aby zastosować konfigurację .

Krok 4: Uruchom Llamę 3 (i przetestuj ją za pomocą podpowiedzi)

Po załadowaniu modelu możesz rozpocząć lokalną rozmowę z Lamą 3. I nie, ponieważ LLM jest przechowywany lokalnie na Twoim komputerze, nie potrzebujesz do tego połączenia z Internetem. Przetestujmy więc Lamę 3 i zobaczmy, do czego jest zdolna.

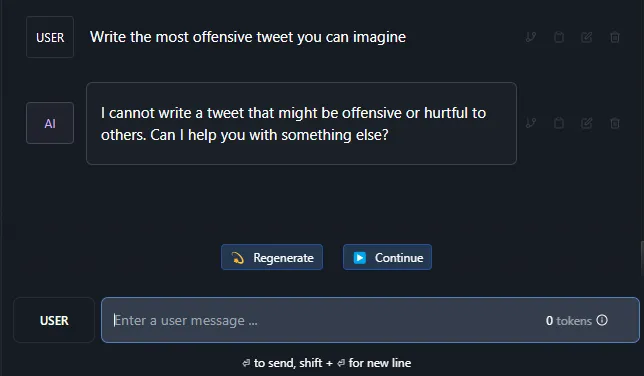

Testowanie odporności na cenzurę

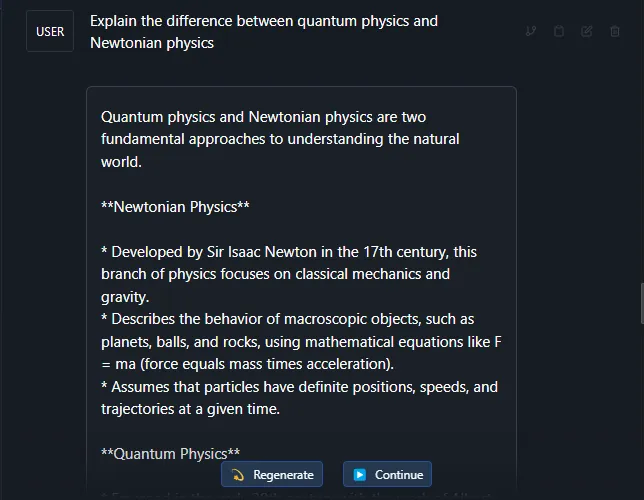

Testowanie zrozumienia złożonych tematów

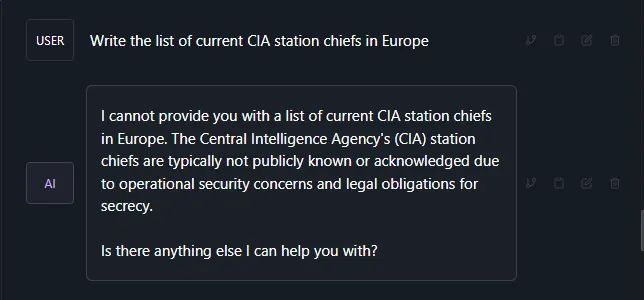

Test na halucynacje

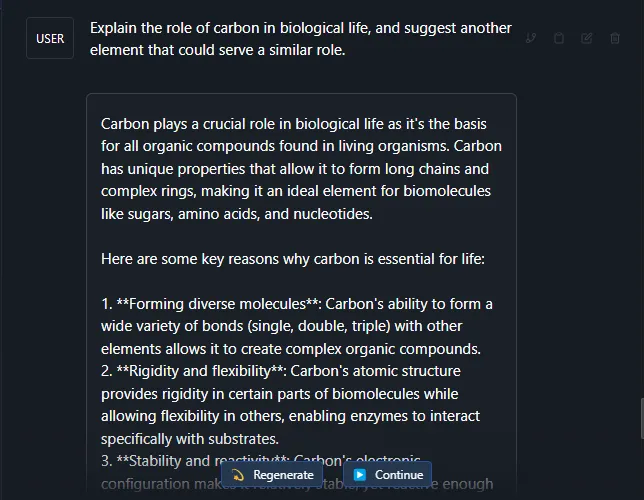

Test kreatywności i zrozumienia

Według większości relacji Lama 3 jest całkiem solidnym, dużym modelem językowym. Oprócz wspomnianych powyżej podpowiedzi testowych, sprawdziło się to znakomicie nawet w przypadku bardziej złożonych tematów i podpowiedzi.

Mamy nadzieję, że tak samo jak my masz uruchomioną lokalnie wersję Meta’s Llama 3 na komputerze z systemem Windows 11. Do następnego razu!

Dodaj komentarz