Jak uruchomić własny lokalny LLM na Raspberry Pi

Od czasu niesamowitej wersji OpenAI ChatGPT 3 pod koniec 2022 r. modele dużych języków (LLM) pobudzają wyobraźnię świata, demonstrując niezwykłe możliwości, od pisania esejów po odpowiadanie na złożone pytania.

Nie musisz jednak polegać na firmach takich jak OpenAI, Google czy Anthropic i udostępniać potencjalnie danych osobowych, aby skorzystać z mocy LLM. Dzięki niedrogiemu Raspberry Pi możesz skonfigurować własnego lokalnego asystenta opartego na czacie AI. W tym przewodniku dowiesz się, jak to zrobić.

Co będziesz potrzebował

Aby skonfigurować własny LLM na Raspberry Pi, będziesz potrzebować kilku niezbędnych komponentów:

- Raspberry Pi : Ponieważ LLM wymagają dużych zasobów, w celu uzyskania optymalnej wydajności najlepiej jest używać najpotężniejszego dostępnego Raspberry Pi. W chwili pisania tego artykułu zalecanym wyborem jest Raspberry Pi 5 z 8 GB pamięci RAM.

- Karta microSD z systemem operacyjnym Raspberry Pi: Aby uzyskać maksymalną wydajność, rozważ użycie wersji Lite systemu Raspberry Pi OS, ponieważ graficzny interfejs użytkownika nie jest konieczny do uruchomienia LLM (można z nim komunikować się zdalnie za pomocą terminala i SSH). Jeśli jednak używasz Raspberry Pi do innych zadań lub jako komputera podstawowego, możesz używać zwykłej wersji systemu operacyjnego Raspberry Pi.

- Dodatkowe komponenty : Oprócz Raspberry Pi i szybkiej karty microSD będziesz potrzebować niezawodnego zasilacza (zalecany oficjalny), klawiatury, myszy i monitora do wstępnej konfiguracji (opcjonalnie, jeśli używasz SSH), oraz połączenie internetowe umożliwiające pobranie niezbędnego oprogramowania i modeli.

Mając te komponenty pod ręką, możesz rozpocząć konfigurowanie własnego LLM na swoim Raspberry Pi.

Zainstaluj Ollamę

Pierwszym krokiem w konfiguracji własnego LLM na Raspberry Pi jest instalacja niezbędnego oprogramowania. Obecnie dwie najpopularniejsze opcje lokalnego uruchamiania LLM to llama.cpp i Ollama.

- llama.cpp to lekka implementacja C++ adaptera LLaMA (Large Language Model Adapter) firmy Meta, która może działać na szerokiej gamie sprzętu, w tym na Raspberry Pi. Został opracowany przez Georgi Gerganova i wydany w marcu 2023 roku.

- Z drugiej strony Ollama jest zbudowana wokół llama.cpp i oferuje kilka przyjaznych dla użytkownika funkcji. Automatycznie obsługuje szablony żądań czatu do formatu oczekiwanego przez każdy model oraz ładuje i rozładowuje modele na żądanie w oparciu o żądanie klienta. Ollama zarządza także pobieraniem i buforowaniem modeli, w tym modeli skwantowanych, dzięki czemu możesz poprosić o nie po nazwie.

W tym przewodniku będziemy używać programu Ollama ze względu na jego łatwość obsługi i dodatkowe funkcje.

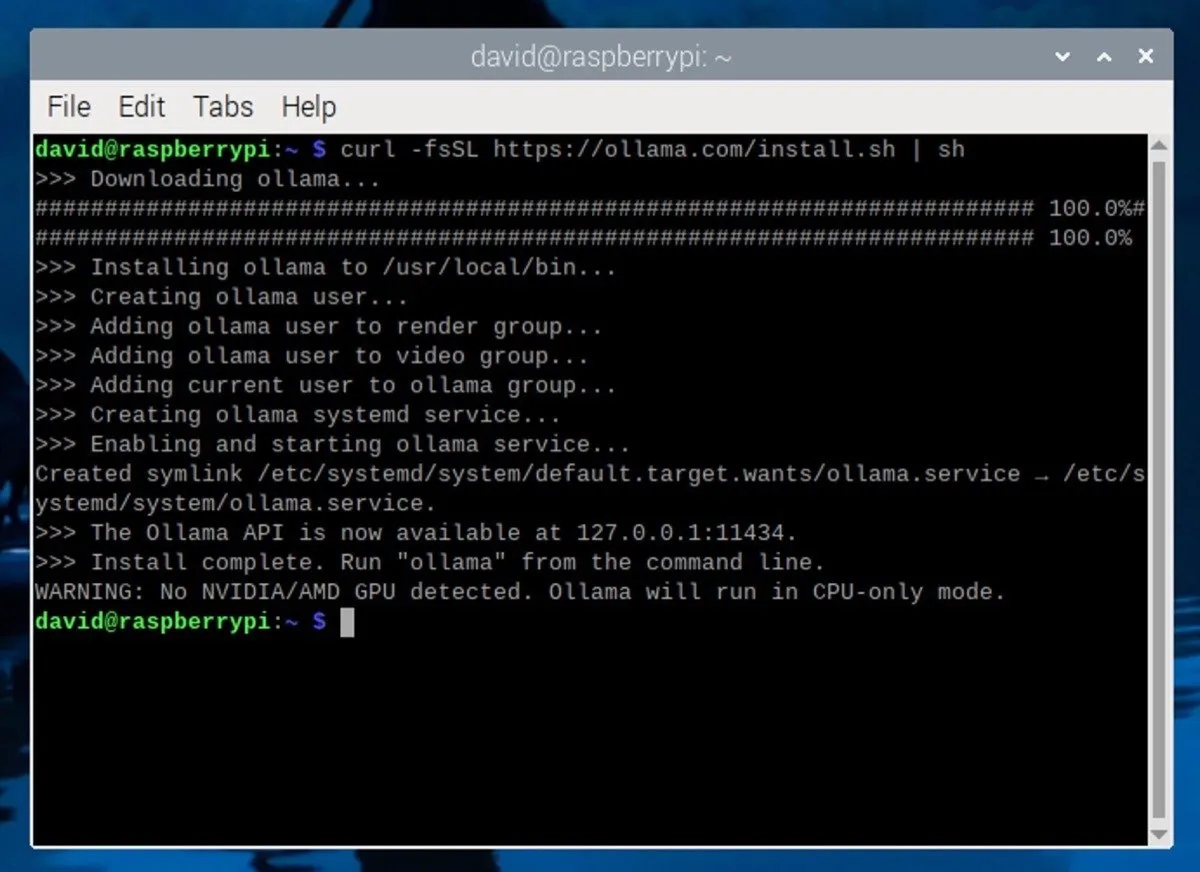

Aby zainstalować Ollamę na Raspberry Pi, otwórz okno terminala na Raspberry Pi. Jeśli używasz SSH, połącz się z Raspberry Pi za pomocą preferowanego klienta SSH. Następnie wpisz w terminalu następujące polecenie:

To polecenie pobiera i uruchamia skrypt instalacyjny z oficjalnej strony internetowej Ollama. Skrypt automatycznie zainstaluje wymagane zależności i skonfiguruje Ollamę na Twoim Raspberry Pi.

Pobierz i uruchom LLM

Po zainstalowaniu Ollama czas pobrać duży model językowy. Jeśli używasz Raspberry Pi z 8 GB pamięci RAM, możesz uruchamiać modele z maksymalnie 7 miliardami parametrów (ustawienia, których sztuczna inteligencja używa do określenia swoich wyników).

Niektóre popularne opcje to Mistral (7B), Gemma (7B lub 2B), Llama 2 bez cenzury (7B) lub Phi-3 firmy Microsoft (3.8B). Wszystkie obsługiwane modele możesz zobaczyć na stronie biblioteki Ollama .

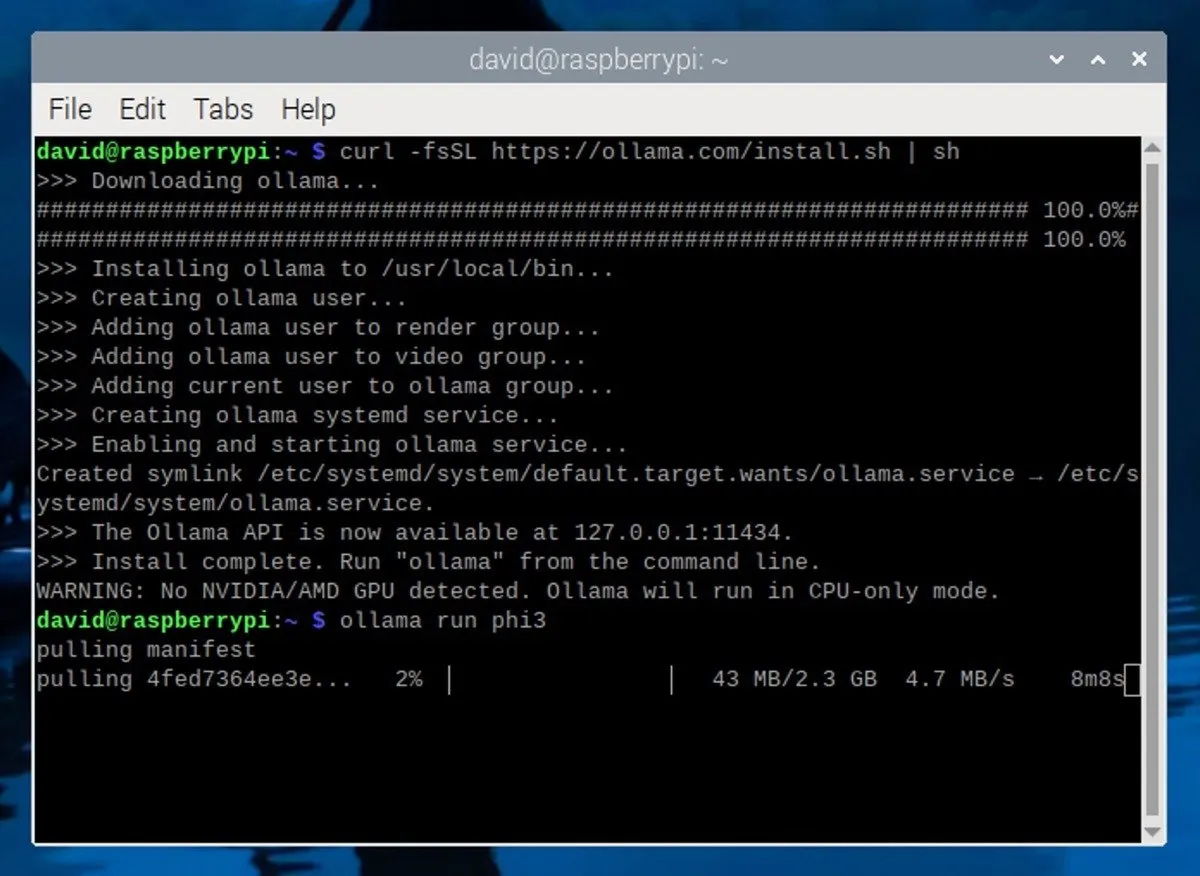

W tym przewodniku będziemy używać modelu Phi-3 firmy Microsoft . Pomimo niewielkich rozmiarów i wydajności, Phi-3 jest modelem niezwykle wydajnym. Aby go zainstalować, po prostu uruchom następujące polecenie w terminalu:

To polecenie pobierze i zainstaluje model Phi-3, a także automatycznie rozpocznie interaktywną sesję czatu z modelem.

Korzystanie z lokalnego LLM na Raspberry Pi

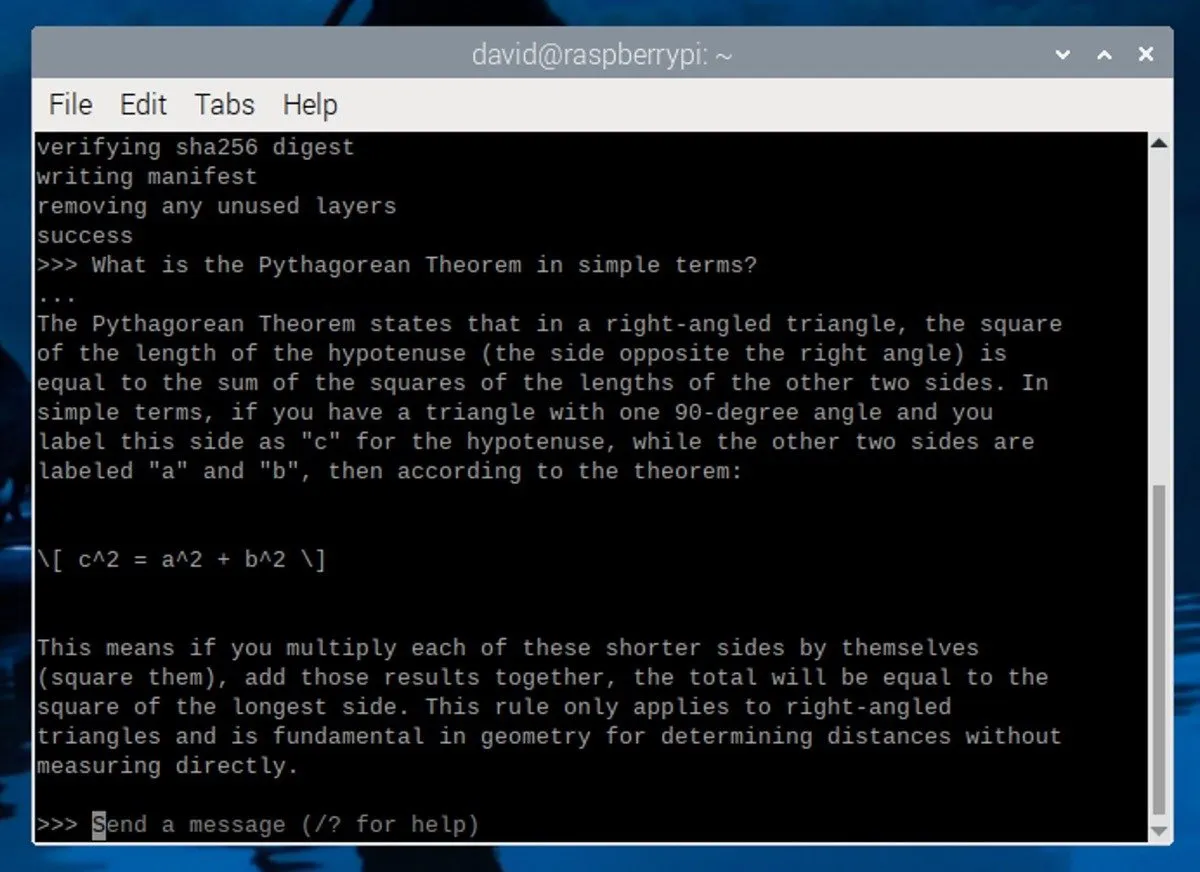

Po pobraniu i zainstalowaniu modelu Phi-3 w terminalu pojawi się monit wyglądający następująco:

Oznacza to, że LLM działa i czeka na Twoje dane wejściowe. Aby rozpocząć interakcję z modelem, wpisz wiadomość i naciśnij Enter.

Oto kilka wskazówek, jak tworzyć skuteczne podpowiedzi:

- Bądź konkretny : Podaj jasne i szczegółowe instrukcje lub pytania, aby pomóc LLM zrozumieć, czego szukasz.

- Ustaw kontekst : przekaż LLM podstawowe informacje lub scenariusz, który pomoże mu wygenerować bardziej trafne odpowiedzi.

- Zdefiniuj role : określ rolę, jaką LLM powinien przyjąć w swojej odpowiedzi, na przykład gawędziarz, nauczyciel lub ekspert techniczny.

Aby zakończyć sesję LLM, naciśnij Ctrl+ dlub wprowadź /byepolecenie. Jeśli chcesz rozpocząć kolejną sesję później, po prostu otwórz nowy terminal i uruchom polecenie ollama run phi3. Ponieważ model został już pobrany, uruchomi się szybko bez konieczności ponownego pobierania.

Należy pamiętać, że wydajność Raspberry Pi 5 ma swoje ograniczenia i może generować tylko kilka tokenów na sekundę. Aby uzyskać lepszą wydajność, rozważ uruchomienie Ollama na mocniejszym komputerze z dedykowaną kartą graficzną.

Źródło obrazu: Unsplash . Zrzuty ekranu autorstwa Davida Morelo.

Dodaj komentarz