Opera がローカル AI モデルを統合した最初の主要ブラウザに

知っておくべきこと

- Opera は、約 150 個のローカル LLM に対する組み込みサポートを追加した最初のブラウザです。

- ローカル LLM は、プライバシーとセキュリティを強化し、AI モデルにオフラインでアクセスするのに最適です。ただし、その速度はマシンの機能に依存します。

- ローカル AI モデルへのアクセスは、Opera One の開発者ストリームで利用できます。

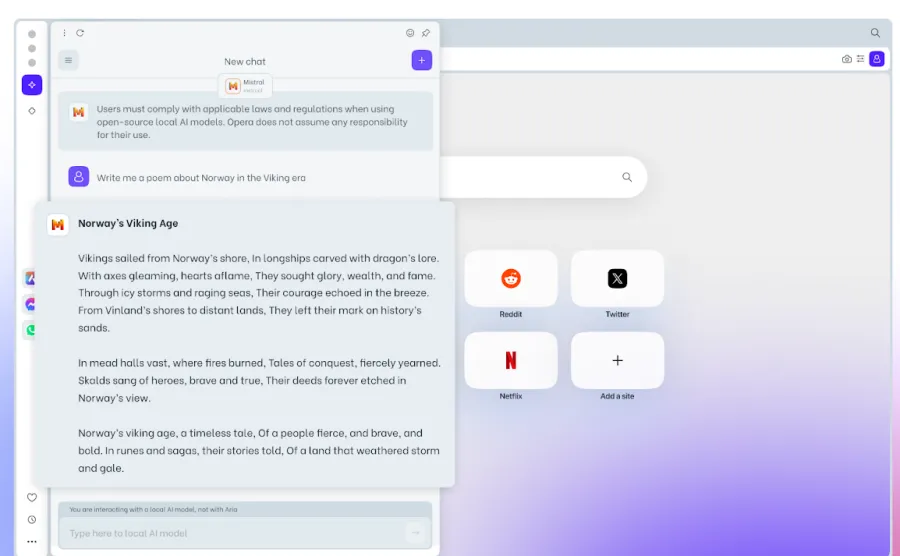

Opera は、同社の AI 統合ブラウザである Opera One の開発者ストリームに、150 種類のローカル LLM (大規模言語モデル) バリアントのサポートを統合しています。実験的な AI ローカル サポートの追加はブラウザとしては初めてのことで、ブラウザ自体から AI モデルに簡単にアクセスできるようになります。

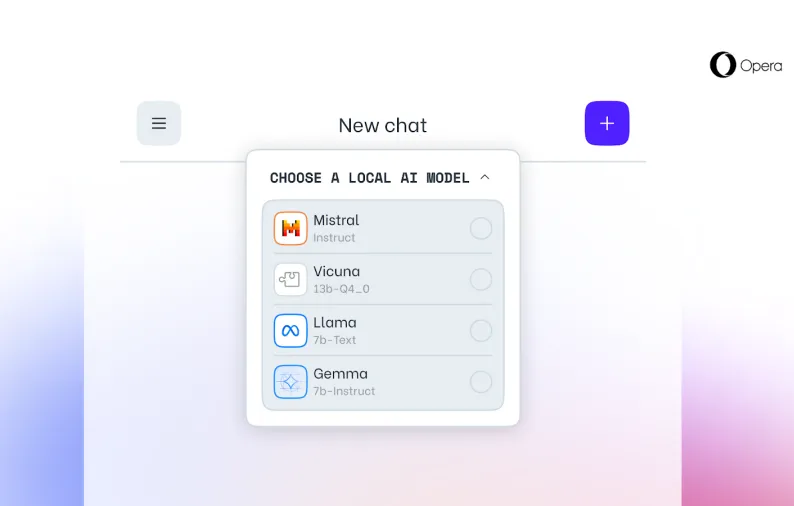

Opera One の代表的なローカル LLM には、Meta の Llama、Google の Gemma、Vicuna、Mistral AI の Mixtral などがあります。これらに加えて、Opera 独自の Aria チャットボットも存在します。

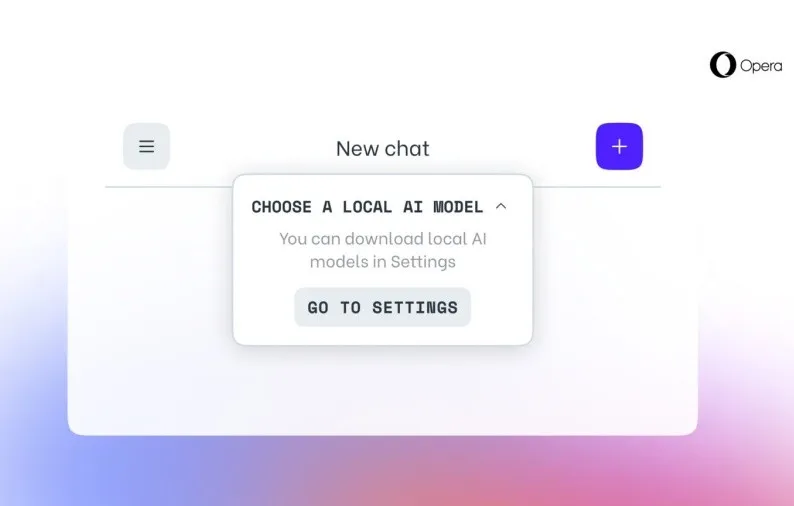

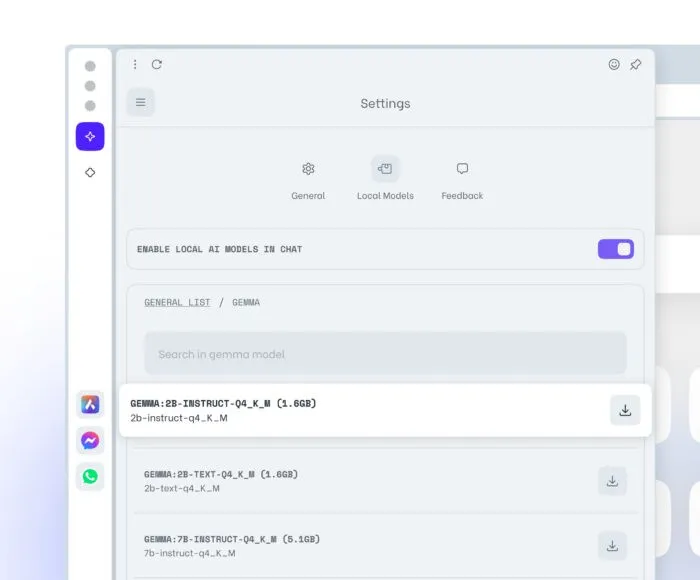

Opera One Developer ユーザーは、まずブラウザの最新バージョンにアップデートし、テストするモデルを選択して新機能を有効にし、ローカル LLM を自分のマシンにダウンロードします。一般的な LLM には 2 ~ 10 GB のストレージが必要です。ダウンロードしたら、Aria の代わりにローカル LLM に切り替えて使用できるようになります。

ローカル LLM には、データがマシンから出ないのでプライバシーとセキュリティが向上する、オフラインで使用できる、全体的にブラウザ エクスペリエンスが向上するなど、いくつかの利点があります。ローカル LLM の唯一の欠点は、処理がコンピュータのハードウェア機能に完全に依存するため、サーバーベースの LLM と比較して出力の提供が遅くなる可能性があることです。そのため、ほとんどの最新のマシンでは問題なく動作しますが、古いデバイスではリソース不足を感じる可能性があります。

それでも、ローカル AI モデルをブラウザ自体に統合することは Opera にとって大きな前進であり、他の主要ブラウザでもこれがトレンドになる可能性はあります。

コメントを残す