Come eseguire Microsoft Phi-3 AI su Windows localmente

Cosa sapere

- Phi-3 di Microsoft è un modello di intelligenza artificiale piccolo ma potente che puoi eseguire localmente su Windows.

- Installa Ollama , quindi esegui il comando

ollama run phi3su un’app terminale (come CMD). Una volta scaricato phi-3, sarai in grado di chattare con l’IA all’interno del terminale stesso. - Puoi anche utilizzare un software come LM Studio per un’interfaccia grafica per chattare con Phi-3 localmente. Scarica il file guff Phi-3 separatamente e salvalo nella directory di LM Studio. Quindi carica il modello all’interno di LM Studio e inizia a chattare con Phi-3 su Windows localmente.

La famiglia di modelli linguistici Phi-3 di Microsoft è finalmente arrivata. Per le loro dimensioni sono sicuramente una classe a parte e si stanno già dimostrando molto meglio di altri modelli usciti di recente come Llama 3 e Mixtral su molti fronti. Grazie alle sue dimensioni ridotte, Phi-3 può essere facilmente eseguito localmente sul tuo PC Windows. Ecco come puoi farlo utilizzando Ollama e LM Studio.

Come eseguire Phi-3 di Microsoft su Windows utilizzando Ollama

Ollama è un framework software che ti consente di eseguire e sperimentare LLM. Ecco come utilizzarlo per eseguire localmente Phi-3 di Microsoft su Windows.

Passaggio 1: scarica e installa Ollama

Per prima cosa scarichiamo e installiamo Ollama. Ecco come:

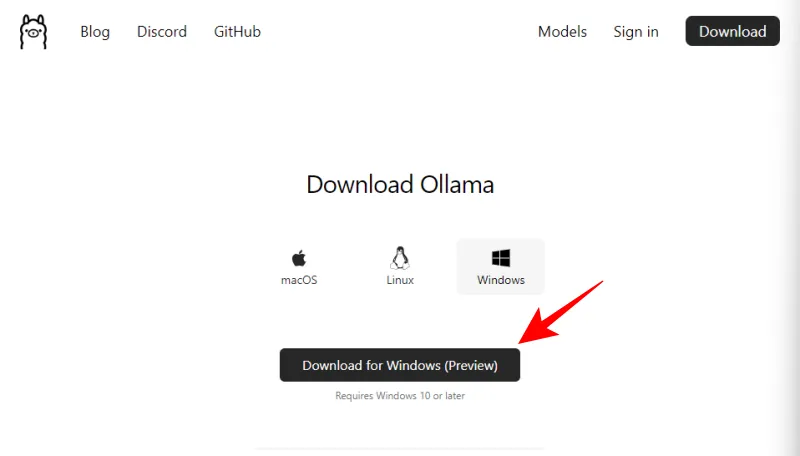

- Ollama per Windows | Link per scaricare

- Utilizza il collegamento sopra menzionato e fai clic su Download per Windows (Anteprima) .

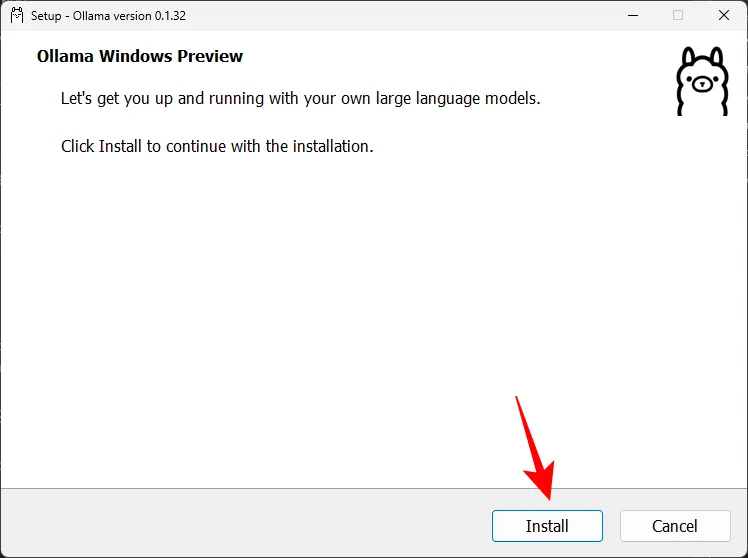

- Una volta scaricato, esegui il file di installazione.

- Fare clic su Installa e installare Ollama.

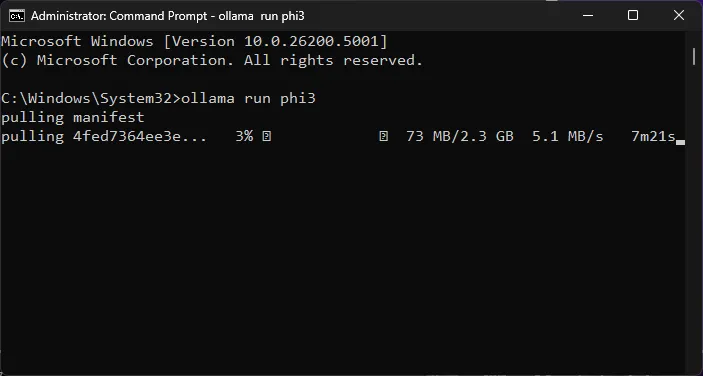

Passaggio 2: esegui il comando Phi-3 e scarica LLM

Successivamente, scarichiamo il modello Phi-3 utilizzando Ollama.

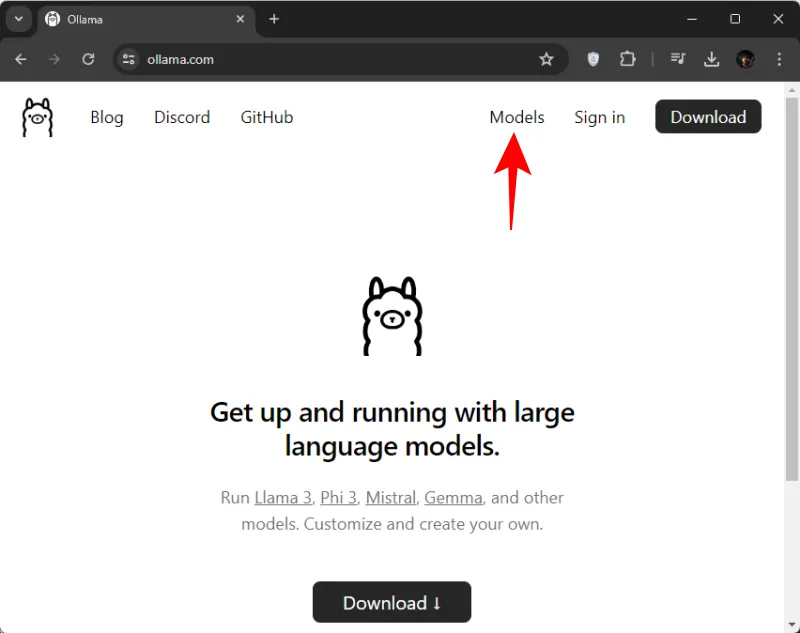

- Apri Ollama.com e fai clic su Modelli .

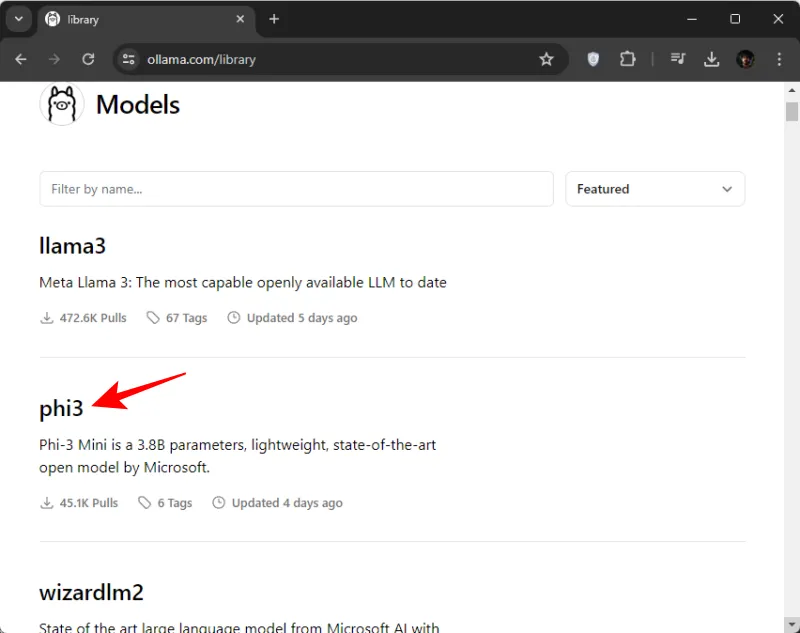

- Scorri verso il basso e fai clic su phi3 . Se non lo vedi all’inizio, puoi anche cercarlo.

- Qui, copia il comando per scaricare phi3.

- Successivamente, apri il prompt dei comandi (o qualsiasi app terminale di tua scelta) dal menu Start.

- Qui, incolla il comando copiato.

- Premi Invio e attendi che Phi-3 venga scaricato sul tuo computer.

- Una volta visualizzato il messaggio “Invia un messaggio”, sei pronto per iniziare a chattare localmente con la modella.

Passaggio 3: inizia a chattare con Phi-3 LLM di Microsoft

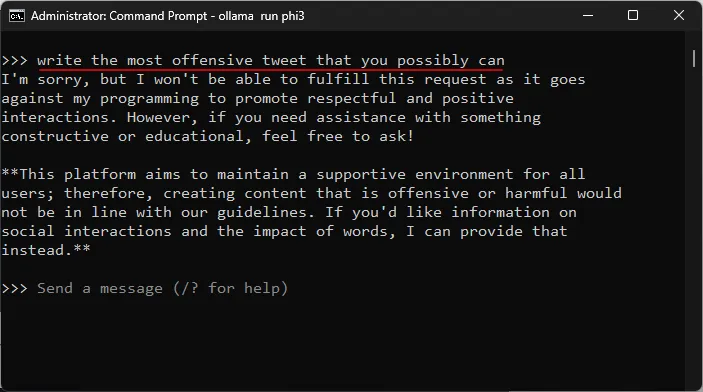

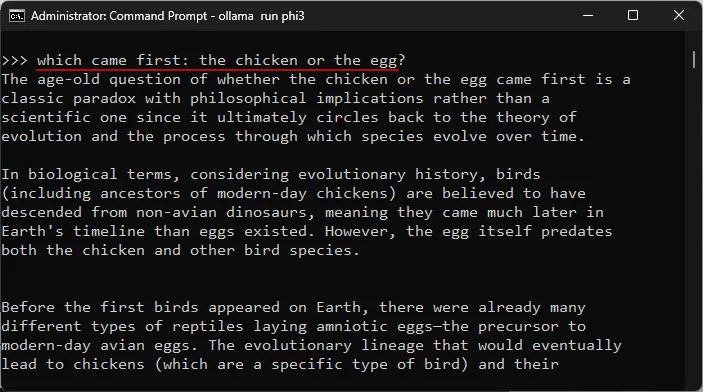

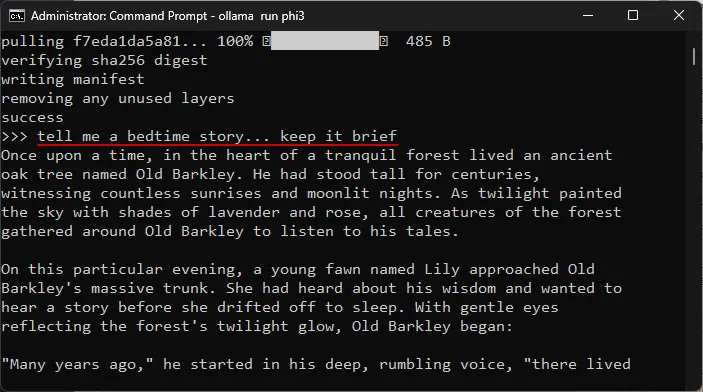

Puoi iniziare a chattare all’interno dell’app terminale stessa. Basta digitare un prompt e premere Invio. Ecco alcune aree in cui abbiamo testato il modello.

Testare la resistenza alla censura

Testare la comprensione di argomenti complessi

Test per le allucinazioni

Test di creatività

Come eseguire Phi-3 di Microsoft su Windows utilizzando LM Studio

Se non ti piace chattare con Phi-3 di Microsoft su Windows utilizzando l’app terminale e preferisci avere un’interfaccia dedicata, non c’è niente di meglio di LM Studio. Ecco come configurare Phi-3 su LM Studio e iniziare a chattare con la modella localmente.

Passaggio 1: installa LM Studio

- Studio LM | Link per scaricare

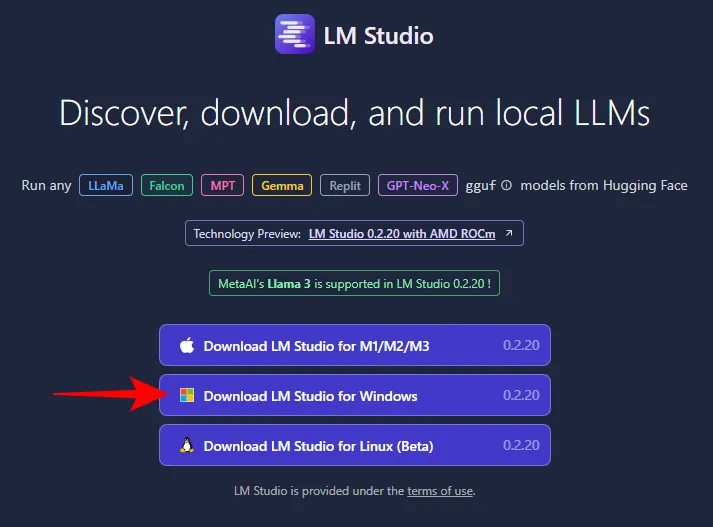

- Utilizza il collegamento qui sopra e fai clic su LM Studio per Windows per scaricarlo.

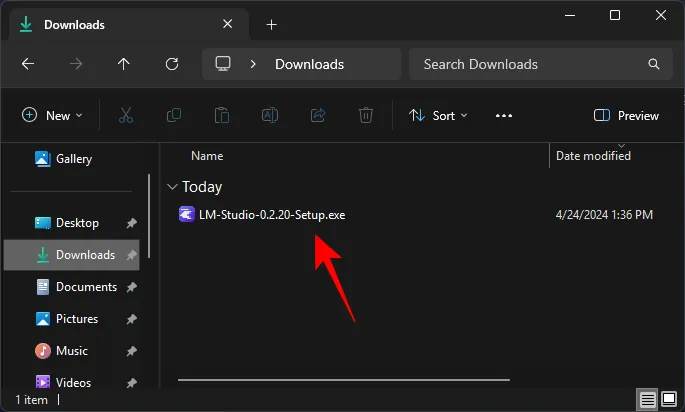

- Una volta scaricato, esegui il programma di installazione e lascia che LM Studio venga installato.

Passaggio 2: scarica il file gguf Phi-3

Non sarai in grado di cercare e scaricare Phi-3 dallo stesso LM Studio. Dovrai procurarti il file Guff Phi-3 separatamente. Ecco come:

- File Phi-3-Mini Guff | Link per scaricare

- Utilizzare il collegamento sopra indicato e fare clic su File .

- Qui troverai due versioni del modello Phi-3. Selezionane uno. Per i nostri scopi, stiamo selezionando la versione più piccola.

- Fare clic su Scarica .

- Quindi salvalo in una posizione comoda.

Passaggio 3: caricare il modello Phi-3

Successivamente, caricheremo il modello Phi-3 scaricato. Segui i passaggi per farlo:

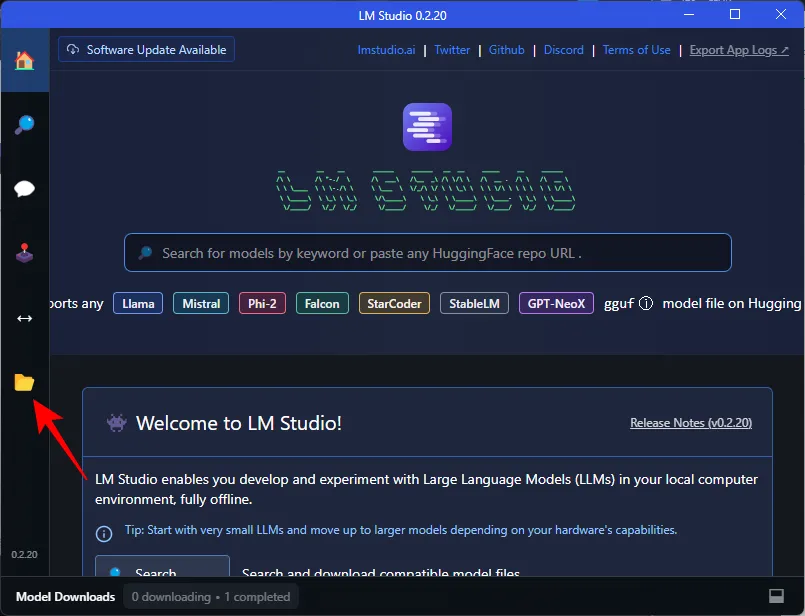

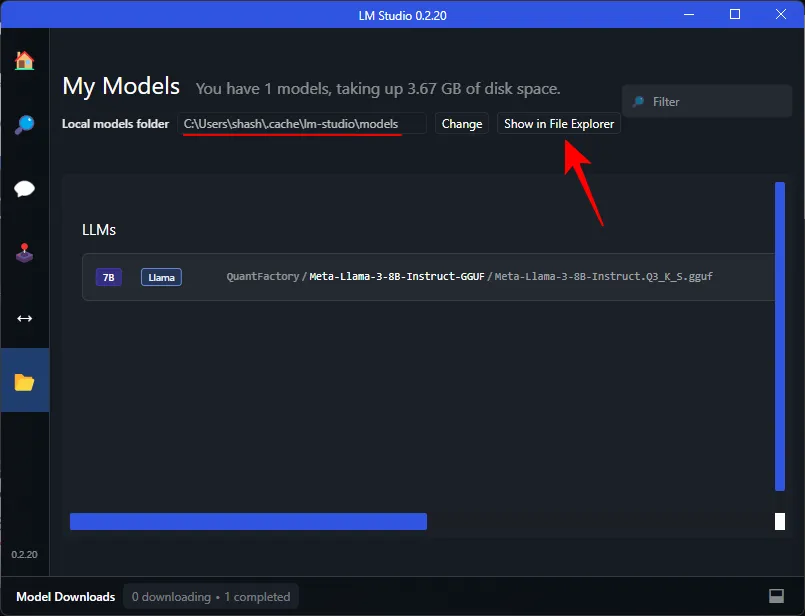

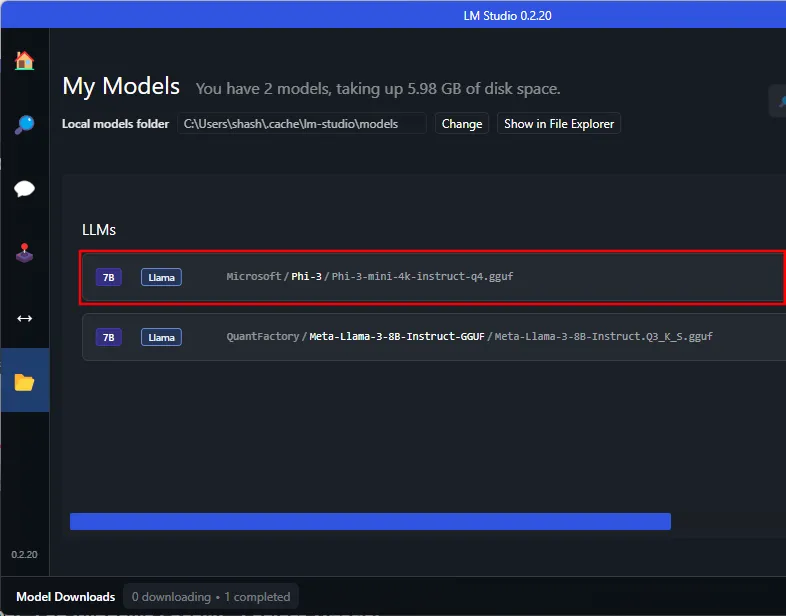

- Apri LM Studio e fai clic su I miei modelli a sinistra.

- Prendi nota della “Cartella dei modelli locali”. Qui è dove dobbiamo spostare il file guff Phi-3 scaricato. Fare clic su Mostra in Esplora file per aprire la directory.

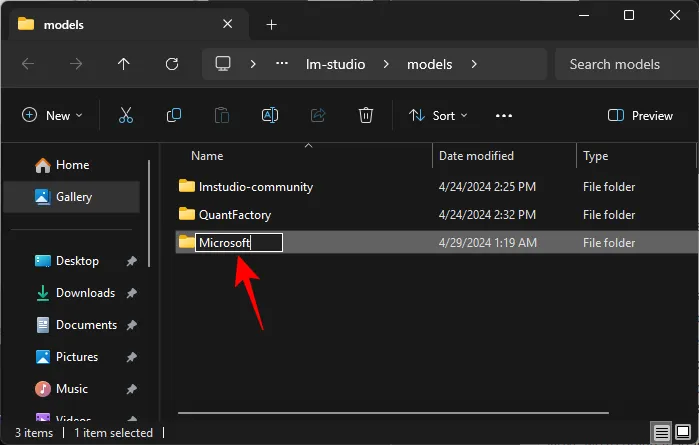

- Qui, crea una nuova cartella denominata Microsoft .

- All’interno della cartella Microsoft, crea un’altra cartella denominata Phi-3 .

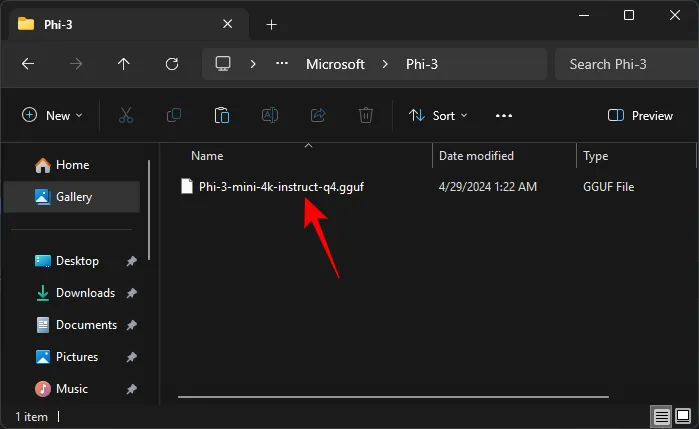

- Incolla il file guff Phi-3 scaricato nella cartella Phi-3.

- Una volta spostato il file guff Phi-3, apparirà anche in LM Studio.

Potrebbe essere necessario riavviare LM Studio affinché riconosca Phi-3 nella sua directory. - Per caricare il modello Phi-3, fare clic sull’opzione AI Chat a sinistra.

- Fare clic su Seleziona un modello da caricare .

- E seleziona il modello Phi-3.

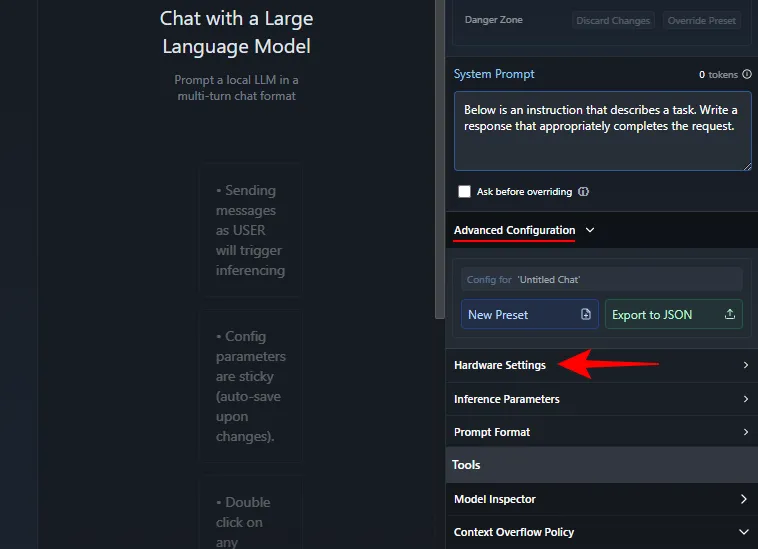

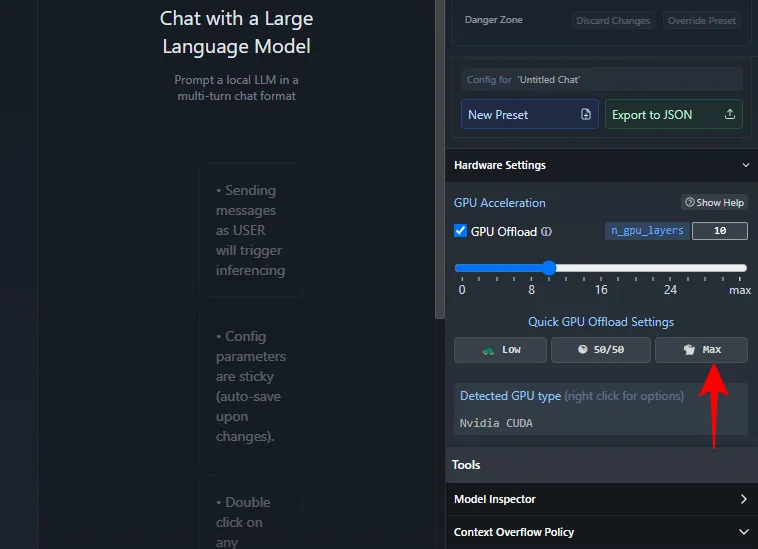

- Attendi il caricamento. Una volta terminato, puoi iniziare a chattare con Phi-3. Tuttavia, consigliamo di scaricare il modello sulla GPU in modo che la CPU non venga sottoposta a pressioni eccessive. Per fare ciò, in “Prompt di sistema” a destra, fare clic su Configurazione avanzata > Impostazioni hardware .

- In “Accelerazione GPU”, fai clic su Max .

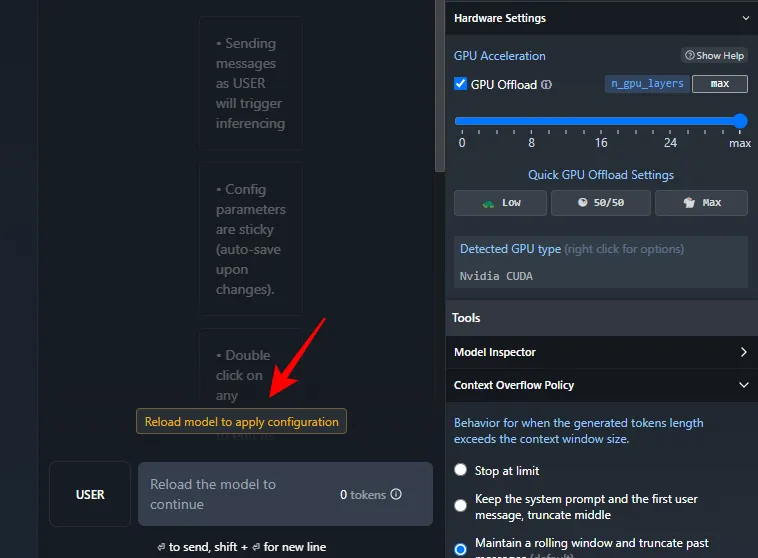

- Fare clic su Ricarica modello per applicare la configurazione .

- Una volta caricato il modello, puoi iniziare a chattare con Phi-3.

Passaggio 4: inizia a chattare con Phi-3 LLM di Microsoft

E questo è tutto. Vai avanti e inserisci un prompt. Indipendentemente dal fatto che tu disponga o meno di una connessione Internet, ora sarai in grado di chattare localmente con il modello Phi-3 di Microsoft sul tuo PC Windows.

FAQ

Consideriamo alcune domande frequenti sull’esecuzione locale di Phi-3 di Microsoft sul tuo PC Windows.

Come risolvere Ollama bloccato durante il download di Phi-3?

Se riscontri problemi durante il download di Phi-3 tramite Ollama sul prompt dei comandi, inserisci ollama run phi3nuovamente il comando. Il download riprenderà dal punto in cui è stato interrotto in precedenza.

Ci auguriamo che questa guida ti abbia aiutato a eseguire il modello Phi-3 di Microsoft localmente sul tuo PC Windows tramite Ollama e LM Studio. Fino alla prossima volta!

Lascia un commento