Android で LLM をローカルに実行する方法

知っておくべきこと

- Android デバイスに MLC Chat などのアプリをインストールして、LLM をローカルで試したりチャットしたりしてみましょう。

- 利用可能なモデルの 1 つをダウンロードし、「チャット」アイコンをタップして、選択した LLM とのチャットを開始します。

- MLC チャット アプリを使用すると、Gemma 2b、RedPajama、Llama3、Phi-2、Mistral、Llama2 をダウンロードできます。

PC 上でローカルに実行できるさまざまな LLM があります。ただし、スマートフォンの場合、選択肢は少し限られます。小さな言語モデルを実行するか、LLM に取り組むのに十分な処理能力を備えた高級デバイスを用意する必要があります。いずれにしても、ローカルでオフラインで言語モデルとチャットすることは可能です。

Android で LLM をローカルに実行する方法

大規模言語モデルは、その通り、規模が大きく、かなりの計算能力を必要とします。しかし、Android デバイスに SLM (小規模言語モデル) と LLM を実行するのに十分なリソースがある場合でも、ユーザー フレンドリーなインターフェースでそれらを試すことができるアプリが必要です。

ここで、MLC Chat のようなアプリが役立ちます。MLC Chat アプリを使用して Android 上でローカルに LLM を実行するには、以下の手順に従います。

ステップ1: MLCチャットアプリをインストールする

- MLC チャット アプリ | ダウンロード リンク

- まず、上記のリンクをクリックして、MLC チャット アプリの APK をダウンロードします。プロンプトが表示されたら、「とにかくダウンロード」をタップします。

- MLCChat アプリをインストールします。完了したら、それを開きます。

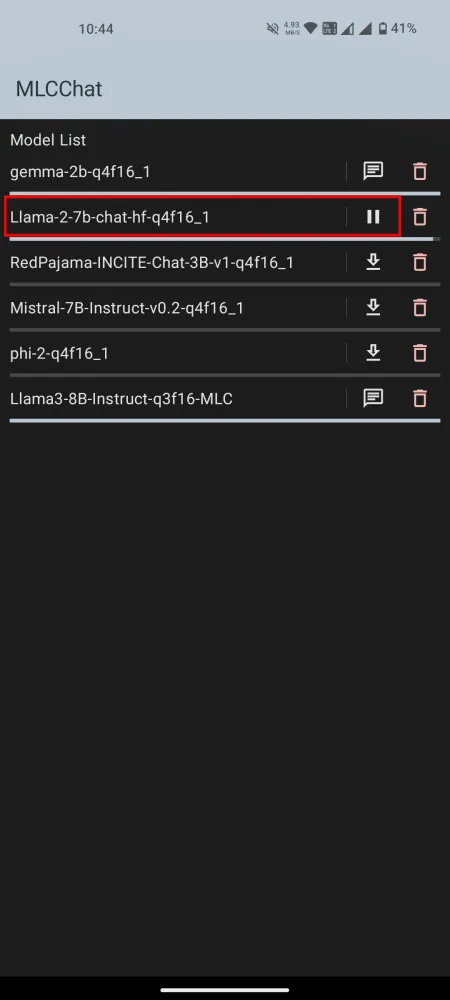

ステップ2: LLMをダウンロードする

MLCChat アプリには、ダウンロード可能なモデルのリストが表示されます。気に入ったモデルの横にあるダウンロード リンクをタップして、ダウンロードが完了するまで待ちます。

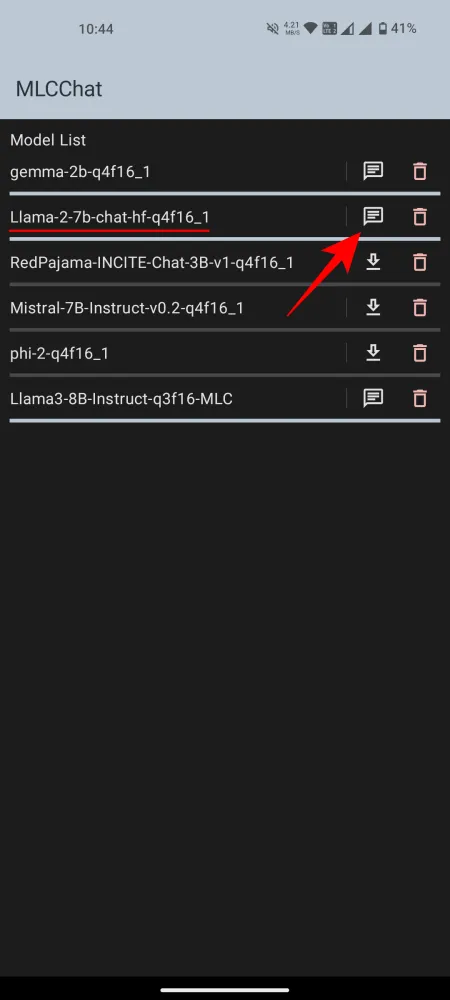

ステップ3: インストールしたLLMを実行する

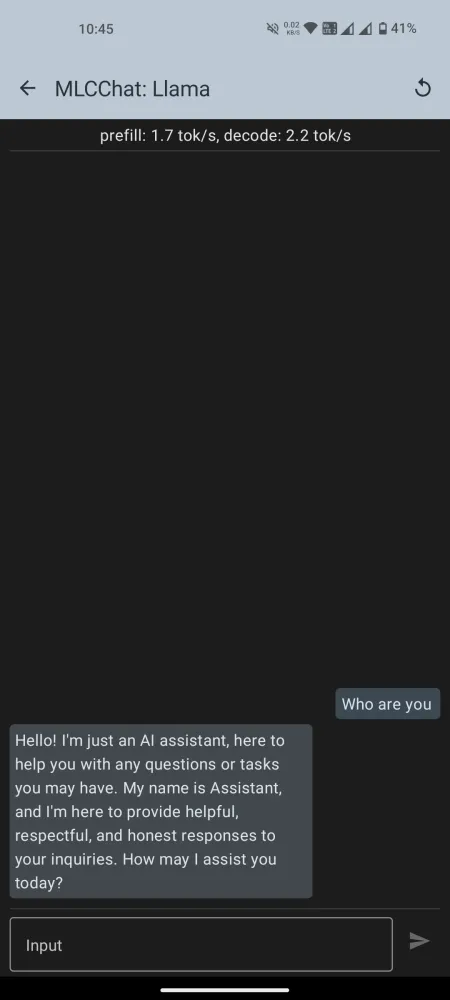

ダウンロードしたら、その横にあるチャット アイコンをタップしてチャットを開始します。モデルが初期化されるまで待ちます。準備ができたら、AI とのチャットを開始してください。

MLCChat アプリで利用可能なモデルのリストには、Llama3 のように多くの処理能力を必要とするモデルもいくつかあることに注意してください。ただし、いつでもモデルをインストールして、十分にスムーズに動作するかどうかをテストできます。そうでない場合は、より小さな言語モデルを試してください。

私たちのテスト (Nothing Phone 1 を使用) では、Gemma-2b はロードに失敗し、Llama3 はシステム UI を終了しました。うまく動作したのは Llama-2 と Phi-2 でした。LLM と他の小規模な言語モデルの主な違いは、トレーニングの対象となる情報の幅 (パラメーター) です。したがって、ニーズと Android デバイスの機能に応じてモデルを選択してください。

Android デバイスに LLM をローカルにインストールして実行できたことを願っています。それでは次回まで!

コメントを残す