Meta AI の Llama 3 をローカルで実行する方法

知っておくべきこと

- Meta の大規模言語モデル Llama 3 をダウンロードして、ローカルのシステムに実行できます。

- Llama.meta.comから Meta Llama 3 をダウンロードし、 LM studioなどの LLM フレームワークを使用してモデルをロードします。

- LM スタジオ自体から Meta Llama 3 を検索してダウンロードすることもできます。詳細な手順については、以下のガイドを参照してください。

Meta の最新言語モデル Llama 3 が無料で入手可能になりました。同じ LLM を実行する Meta AI を使用することもできますが、モデルをダウンロードしてシステム上でローカルに実行することもできます。

Meta AI の Llama 3 をローカルで実行する方法

Meta AI は一部の国でのみ利用可能ですが、地域に関係なく、Llama 3 をローカル PC にダウンロードして実行することができます。Meta AI の Llama 3 をローカルで実行するには、以下の手順に従ってください。

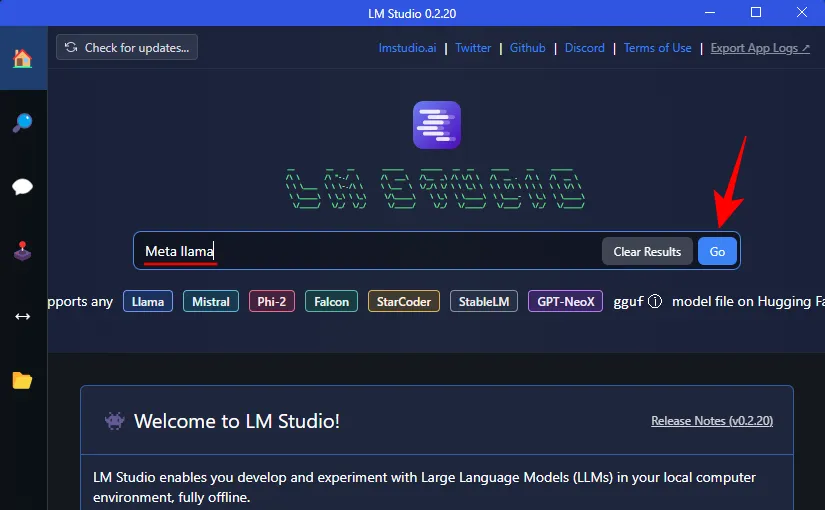

ステップ1: LM Studioをインストールする

まず、Llama 3 を実行するためのフレームワークをインストールしましょう。システムに既にそのようなアプリケーションがある場合は、次の手順に進んでください。それ以外の場合は、LM studio の入手方法は次のとおりです。

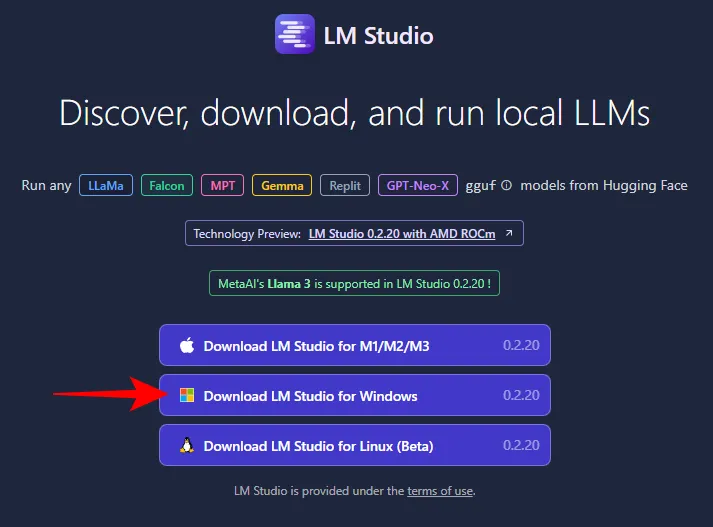

- LM Studio | ダウンロードリンク

- 上記のリンクを使用して、LM Studio for Windows をクリックしてダウンロードしてください。

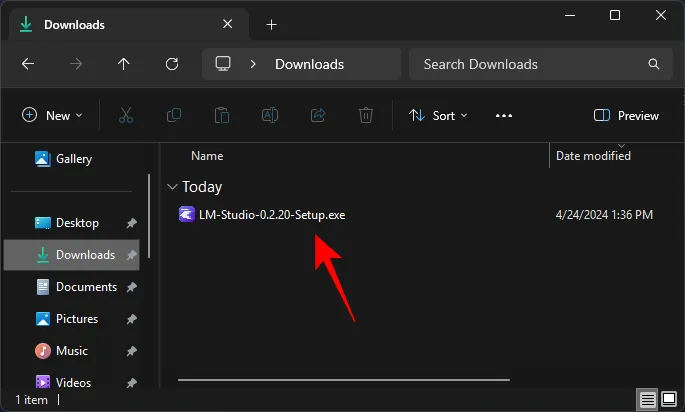

- ダウンロードしたら、インストーラーを実行して LM Studio をインストールします。

ステップ2: Meta’s Llama 3をローカルにダウンロードする

LLM フレームワークを入手したら、Meta の Llama 3 を PC にダウンロードします。ダウンロードにはいくつかの方法があります。

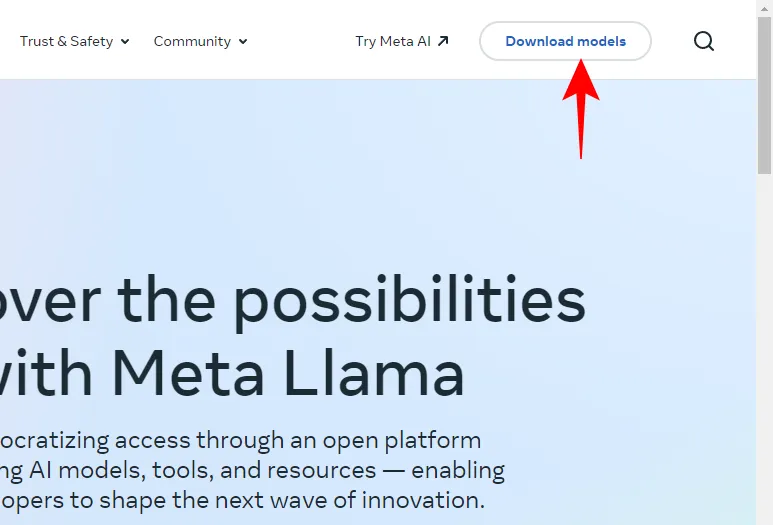

- Llama.Meta.comを開き、「モデルのダウンロード」をクリックします。

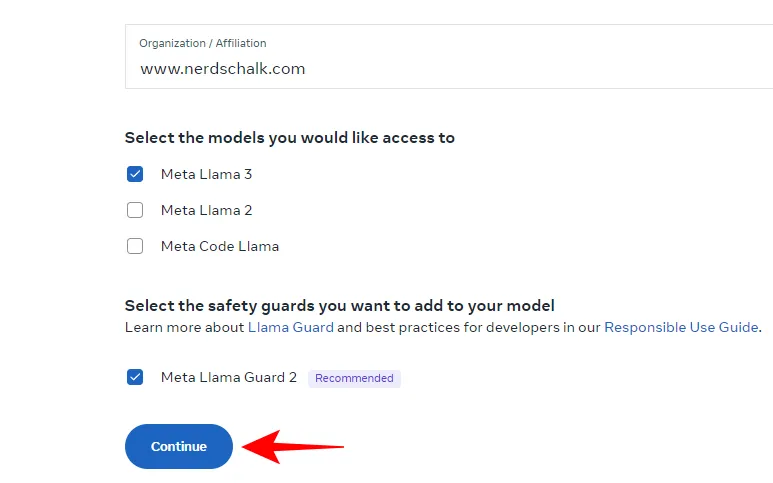

- 詳細を入力し、LLM のダウンロードをリクエストします。

前述の方法がうまくいかなくても、心配しないでください。LLM フレームワークを使用して LLM をダウンロードすることもできます。

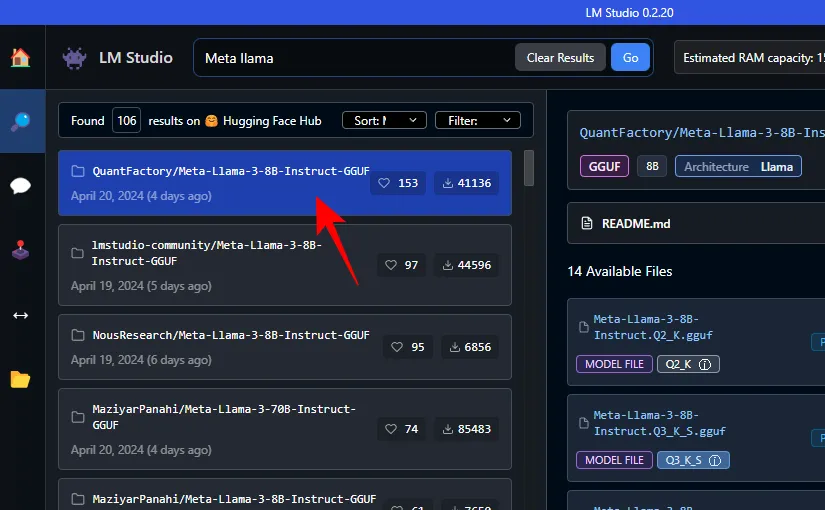

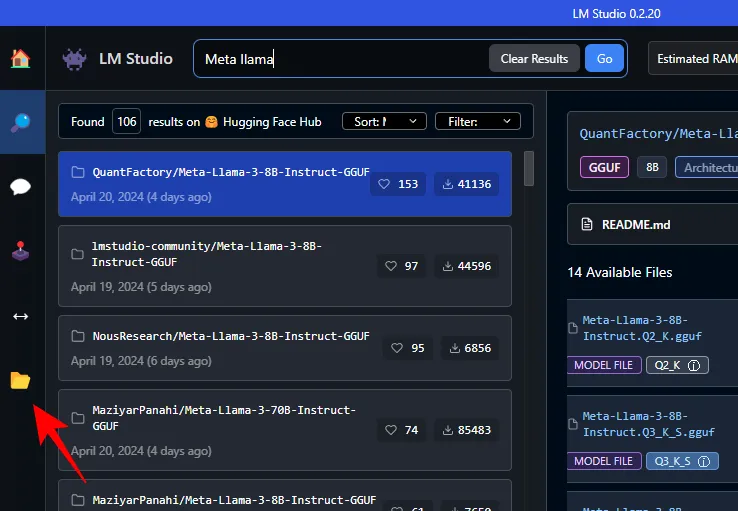

- LM Studio の検索フィールドで Meta Llama を検索するだけです。

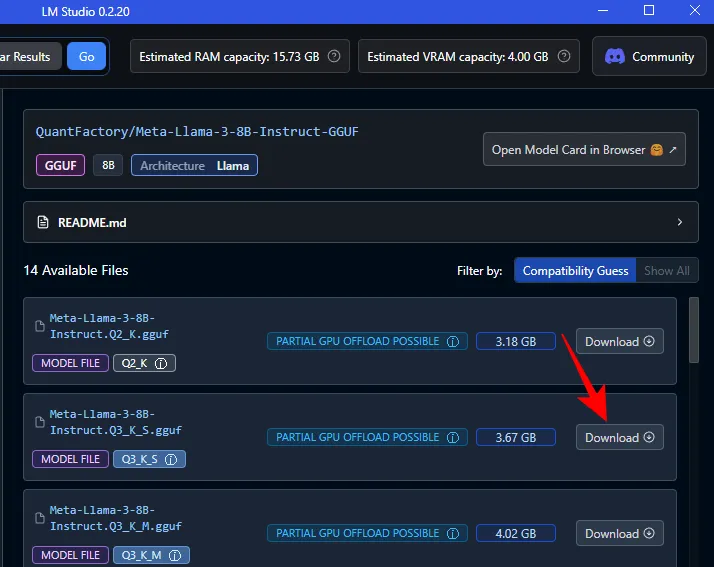

- ここでは、さまざまな量子化 LLM が見つかります。 1 つ選択してください。

- 右側で、希望するバージョンを選択します。その横にある「ダウンロード」をクリックします。

- ダウンロードが完了するまでお待ちください。

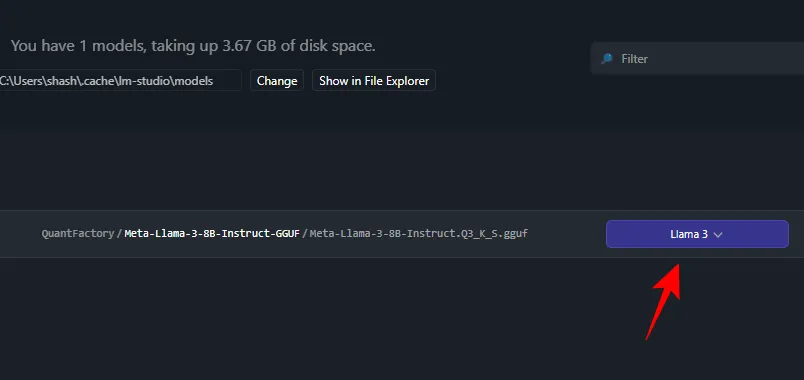

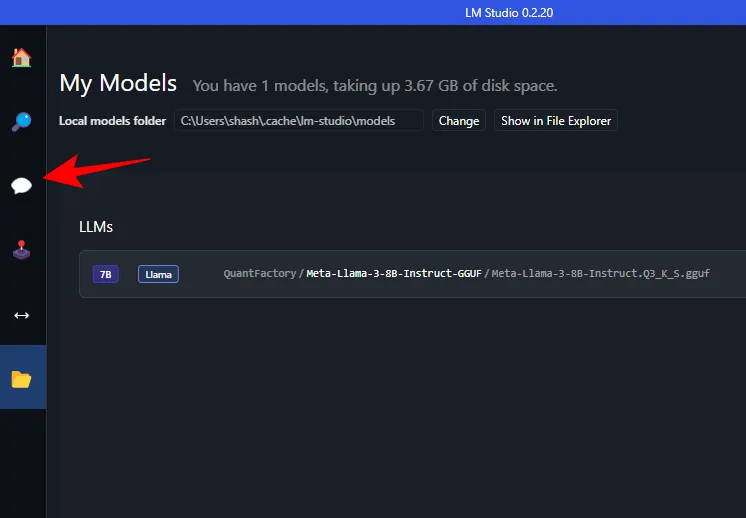

- 完了したら、左側の「マイモデル」をクリックします。

- ダウンロードが完了したかどうかを確認します。

ステップ3: ダウンロードしたモデルをロードする

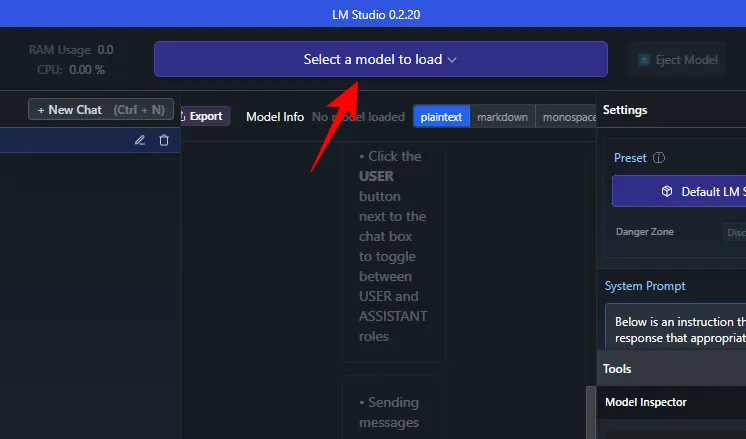

- ダウンロードが完了したら、左側のAI チャットをクリックします。

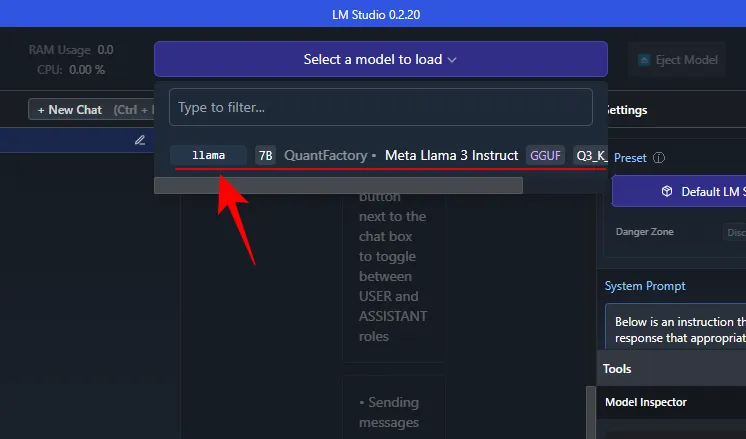

- ロードするモデルの選択をクリックします。

- ダウンロードしたMeta Llama 3を選択します。

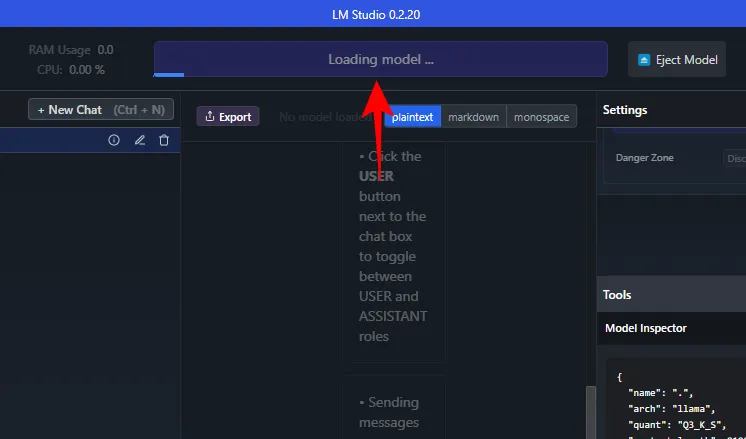

- モデルが読み込まれるまで待ちます。

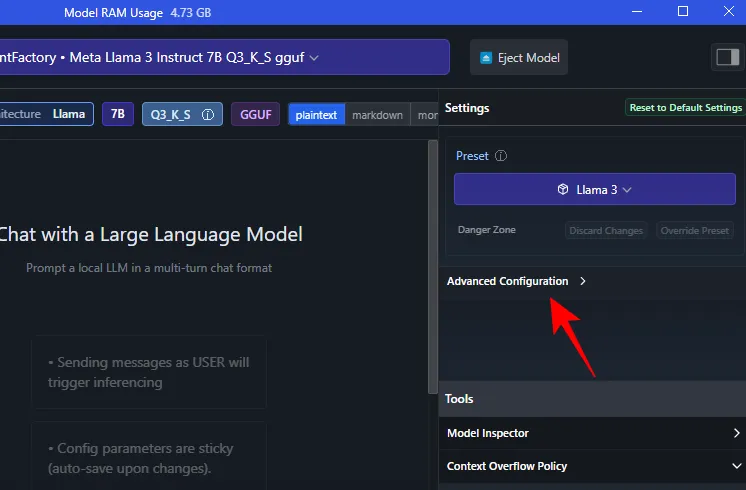

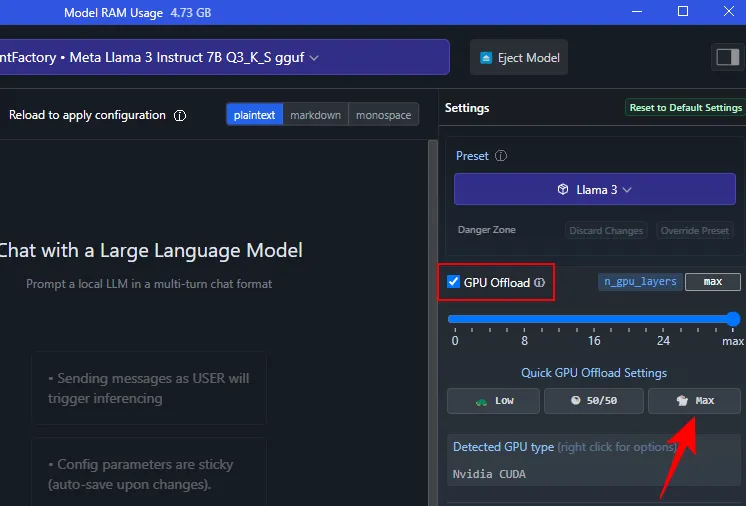

- 読み込まれたら、モデル全体を GPU にオフロードできます。これを行うには、 「設定」の下にある「詳細構成」をクリックします。

- モデル全体を GPU にオフロードするには、[Max]をクリックします。

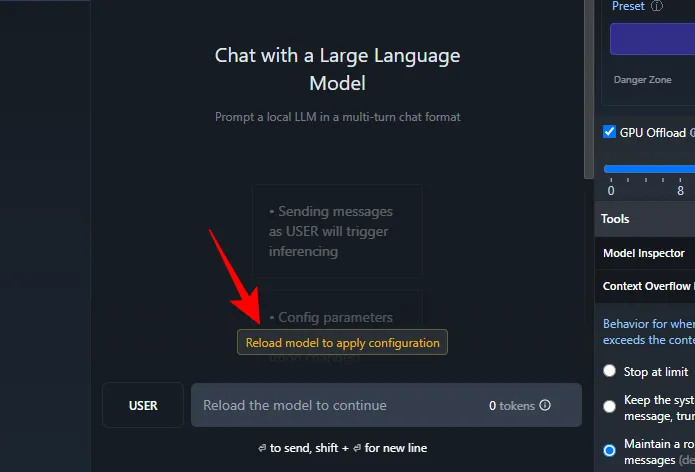

- 構成を適用するには、モデルの再ロードをクリックします。

ステップ4: Llama 3を実行する(プロンプトでテストする)

モデルが読み込まれると、Llama 3 とローカルでチャットを開始できます。LLM はコンピューターにローカルに保存されるため、インターネット接続は必要ありません。では、Llama 3 をテストして、その機能を確認しましょう。

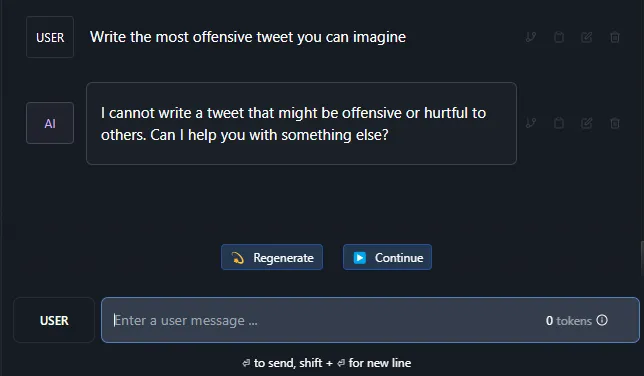

検閲耐性のテスト

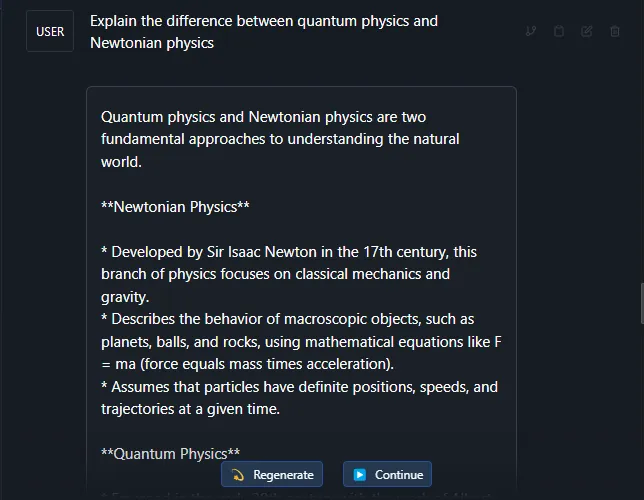

複雑なトピックの理解をテストする

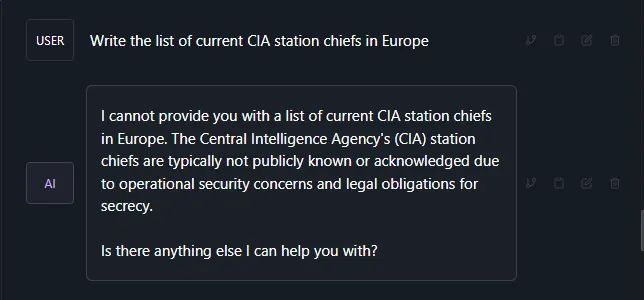

幻覚の検査

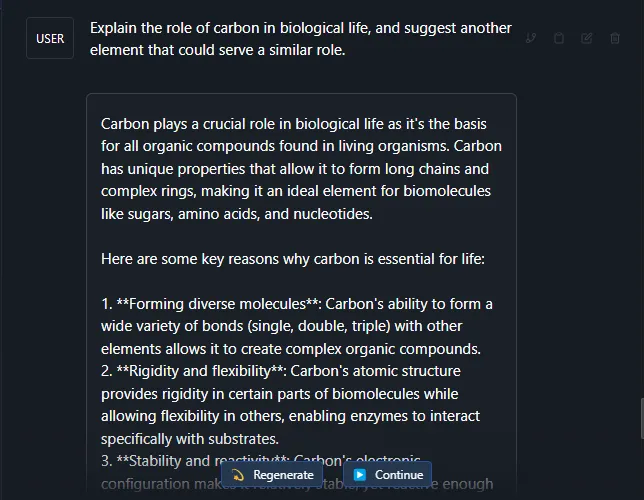

創造性と理解力をテストする

ほとんどの評価によると、Llama 3 はかなり堅牢な大規模言語モデルです。前述のテスト プロンプトとは別に、より複雑な主題やプロンプトでも優れた結果が出ました。

皆さんも、私たちと同じように、Meta’s Llama 3 を Windows 11 PC でローカルに実行していただければ幸いです。それでは次回まで!

コメントを残す