Cómo ejecutar su propio LLM local en una Raspberry Pi

Desde el alucinante lanzamiento de ChatGPT 3 por parte de OpenAI a finales de 2022, los modelos de lenguajes grandes (LLM) han capturado la imaginación del mundo al demostrar capacidades notables, desde escribir ensayos hasta responder preguntas complejas.

Sin embargo, no es necesario depender de empresas como OpenAI, Google o Anthropic y compartir datos potencialmente personales para aprovechar el poder de los LLM. Con solo una Raspberry Pi asequible, puedes configurar tu propio asistente local basado en chat de IA. Esta guía le muestra cómo.

Lo que necesitarás

Para configurar su propio LLM en una Raspberry Pi, necesitará algunos componentes esenciales:

- Raspberry Pi : dado que los LLM consumen muchos recursos, es mejor utilizar la Raspberry Pi más potente disponible para un rendimiento óptimo. Al momento de escribir este artículo, la Raspberry Pi 5 con 8 GB de RAM es la opción recomendada.

- Tarjeta microSD con sistema operativo Raspberry Pi: para obtener el máximo rendimiento, considere usar la versión lite del sistema operativo Raspberry Pi, ya que no es necesaria una interfaz gráfica de usuario para ejecutar un LLM (puede interactuar con él de forma remota mediante una terminal y SSH). Sin embargo, si usa su Raspberry Pi para otras tareas o como computadora principal, puede usar la versión normal del sistema operativo Raspberry Pi.

- Componentes adicionales : además de la Raspberry Pi y una tarjeta microSD rápida, necesitarás una fuente de alimentación confiable (se recomienda la oficial), un teclado, un mouse y un monitor para la configuración inicial (opcional si estás usando SSH). y una conexión a Internet para descargar el software y los modelos necesarios.

Con estos componentes en mano, estás listo para comenzar a configurar tu propio LLM en tu Raspberry Pi.

Instalar Ollama

El primer paso para configurar su propio LLM en una Raspberry Pi es instalar el software necesario. Actualmente, las dos opciones más populares para ejecutar LLM localmente son llama.cpp y Ollama.

- llama.cpp es una implementación ligera de C++ de LLaMA (Adaptador de modelo de lenguaje grande) de Meta que puede ejecutarse en una amplia gama de hardware, incluida Raspberry Pi. Fue desarrollado por Georgi Gerganov y lanzado en marzo de 2023.

- Ollama , por otro lado, se basa en llama.cpp y ofrece varias funciones fáciles de usar. Maneja automáticamente las solicitudes de chat de plantillas en el formato que espera cada modelo, y carga y descarga modelos a pedido según la solicitud del cliente. Ollama también gestiona la descarga y el almacenamiento en caché de modelos, incluidos los modelos cuantificados, para que puedas solicitarlos por nombre.

Para esta guía, usaremos Ollama debido a su facilidad de uso y funciones adicionales.

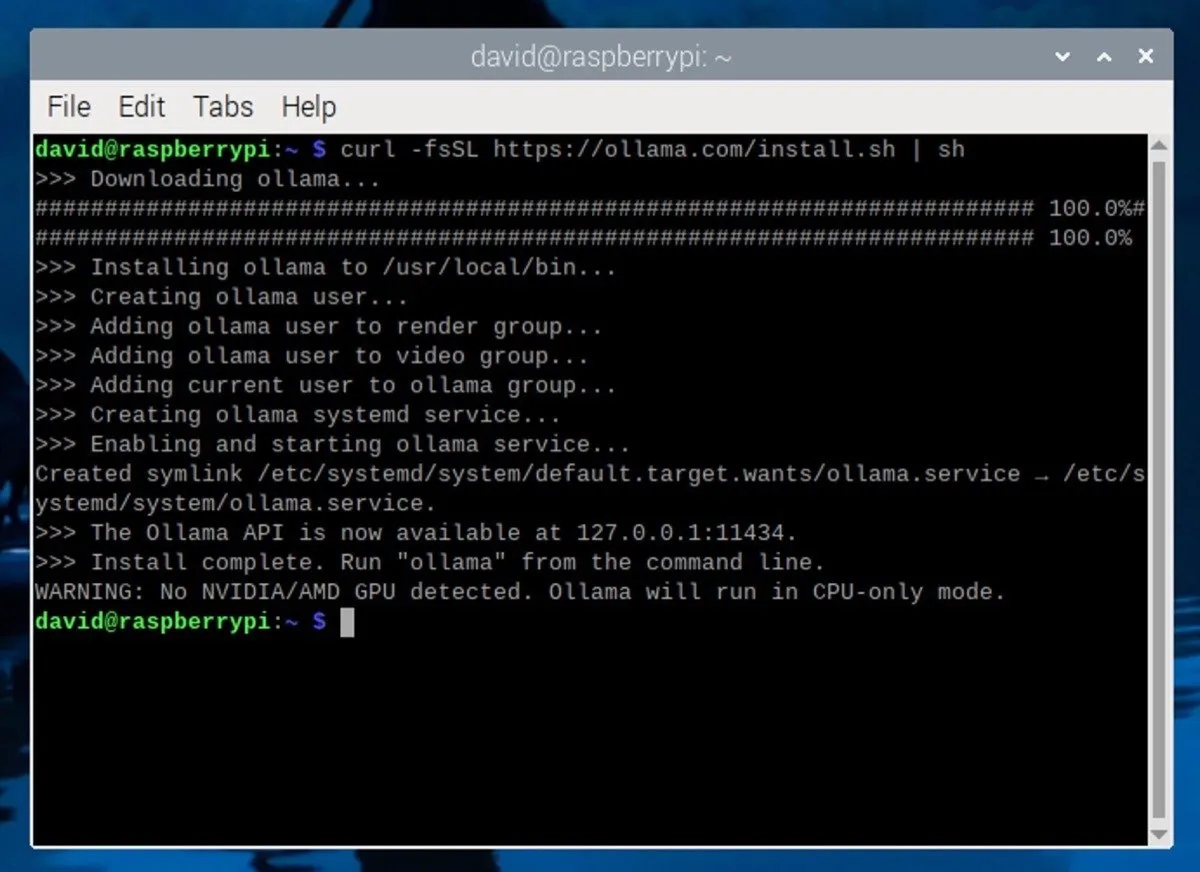

Para instalar Ollama en su Raspberry Pi, abra una ventana de terminal en su Raspberry Pi. Si está utilizando SSH, conéctese a su Raspberry Pi utilizando su cliente SSH preferido. Luego, ingrese el siguiente comando en la terminal:

Este comando descarga y ejecuta el script de instalación desde el sitio web oficial de Ollama. El script instalará automáticamente las dependencias requeridas y configurará Ollama en su Raspberry Pi.

Descargar y ejecutar un LLM

Con Ollama instalado, es hora de descargar un modelo de lenguaje grande. Si está utilizando una Raspberry Pi con 8 GB de RAM, puede ejecutar modelos con hasta 7 mil millones de parámetros (las configuraciones que usa la IA para determinar sus resultados).

Algunas opciones populares incluyen Mistral (7B), Gemma (7B o 2B), Llama 2 sin censura (7B) o Phi-3 de Microsoft (3.8B). Puede ver todos los modelos compatibles en la página de la biblioteca de Ollama .

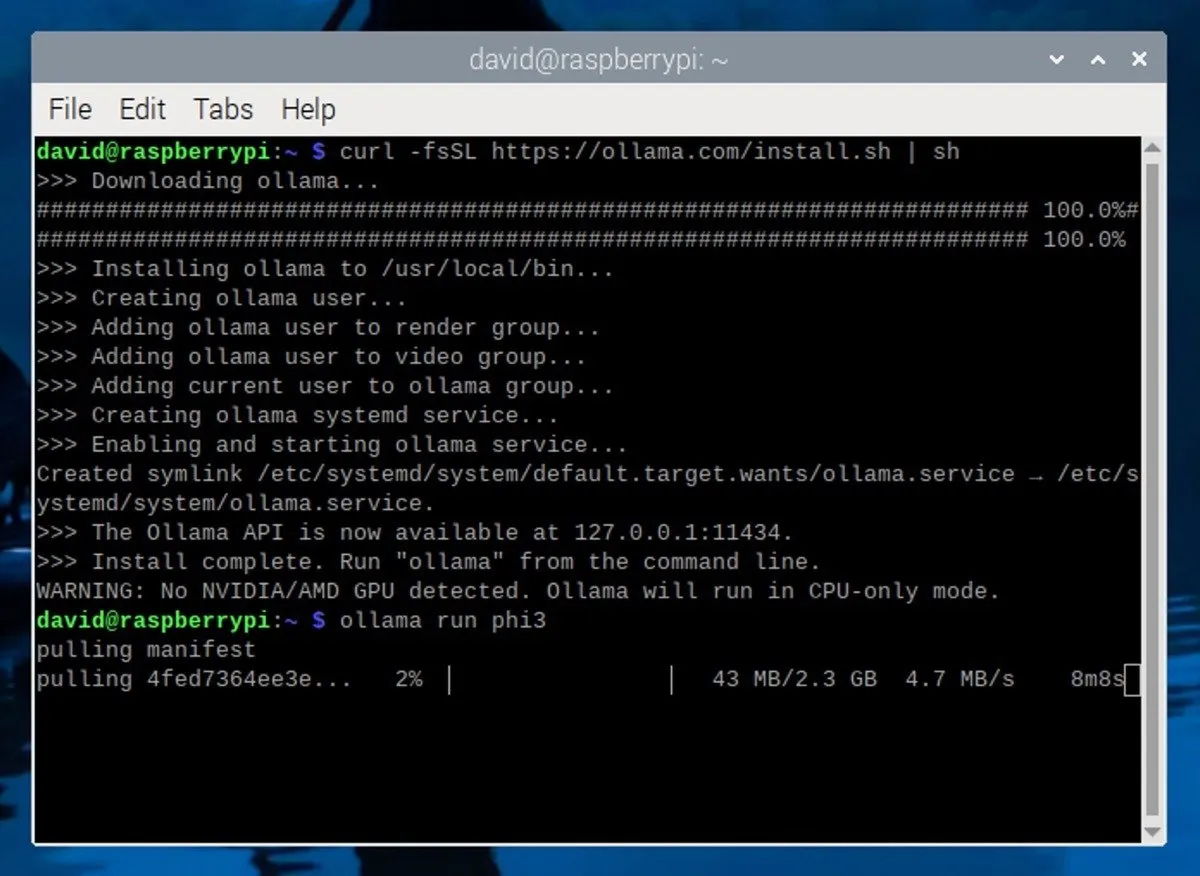

Para esta guía, usaremos el modelo Phi-3 de Microsoft . A pesar de su pequeño tamaño y eficiencia, Phi-3 es un modelo extremadamente capaz. Para instalarlo, simplemente ejecute el siguiente comando en la terminal:

Este comando descargará e instalará el modelo Phi-3 y también iniciará automáticamente una sesión de chat interactiva con el modelo.

Usando un LLM local en su Raspberry Pi

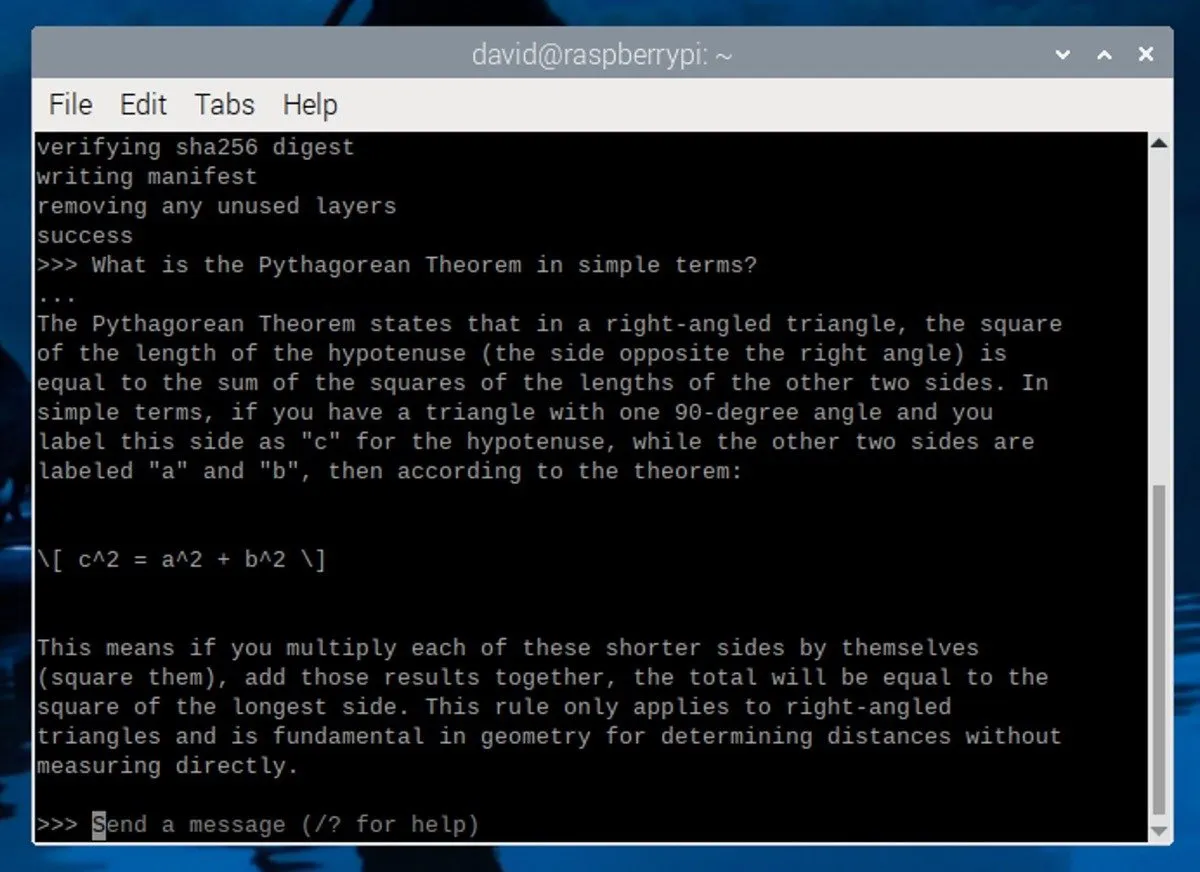

Después de descargar e instalar el modelo Phi-3, verá un mensaje en la terminal similar a este:

Esto significa que el LLM se está ejecutando y esperando su opinión. Para comenzar a interactuar con el modelo, escriba su mensaje y presione Entrar.

A continuación se ofrecen algunos consejos para elaborar indicaciones efectivas:

- Sea específico : proporcione instrucciones o preguntas claras y detalladas para ayudar al LLM a comprender lo que está buscando.

- Establezca el contexto : brinde al LLM información general o un escenario para ayudarlo a generar respuestas más relevantes.

- Definir roles : Especifique el rol que debe asumir el LLM en su respuesta, como un narrador, un maestro o un experto técnico.

Para finalizar la sesión de LLM, presione Ctrl+ do ingrese el /byecomando. Si desea iniciar otra sesión más tarde, simplemente abra una nueva terminal y ejecute el ollama run phi3comando. Como el modelo ya está descargado, se iniciará rápidamente sin necesidad de descargarlo nuevamente.

Tenga en cuenta que el rendimiento de la Raspberry Pi 5 tiene sus límites y solo puede generar unos pocos tokens por segundo. Para un mejor rendimiento, considere ejecutar Ollama en una computadora más potente con una tarjeta gráfica dedicada.

Crédito de la imagen: Unsplash . Capturas de pantalla de David Morelo.

Deja una respuesta