So führen Sie LLMs lokal auf Android aus

Was Sie wissen sollten

- Installieren Sie eine App wie MLC Chat auf Ihrem Android-Gerät, um lokal mit LLMs zu experimentieren und zu chatten.

- Laden Sie eines der verfügbaren Modelle herunter und tippen Sie auf das „Chat“-Symbol, um mit dem von Ihnen ausgewählten LLM zu chatten.

- Mit der MLC Chat-App können Sie Gemma 2b, RedPajama, Llama3, Phi-2, Mistral und Llama2 herunterladen.

Es gibt verschiedene LLMs, die Sie lokal auf Ihrem PC ausführen können. Bei Smartphones sind die Optionen jedoch etwas eingeschränkt. Sie müssen ein kleines Sprachmodell ausführen oder über ein Premium-Gerät mit ausreichender Rechenleistung verfügen, um LLMs zu bewältigen. In beiden Fällen ist es möglich, lokal und offline mit Sprachmodellen zu chatten.

So führen Sie LLMs lokal auf Android aus

Große Sprachmodelle sind, nun ja, groß und erfordern eine hohe Rechenleistung. Aber selbst wenn Ihr Android-Gerät über genügend Ressourcen verfügt, um SLMs (Small Language Models) sowie LLMs auszuführen, benötigen Sie dennoch eine App, mit der Sie mit ihnen über eine benutzerfreundliche Oberfläche experimentieren können.

Hier kommt eine App wie MLC Chat ins Spiel. Befolgen Sie die nachstehenden Schritte, um LLMs lokal auf Ihrem Android mithilfe der MLC Chat-App auszuführen.

Schritt 1: Installieren Sie die MLC Chat-App

- MLC Chat-App | Download-Link

- Klicken Sie zunächst auf den obigen Link und laden Sie die APK für die MLC Chat-App herunter. Tippen Sie bei der entsprechenden Aufforderung auf Trotzdem herunterladen .

- Installieren Sie die MLCChat-App. Öffnen Sie sie anschließend .

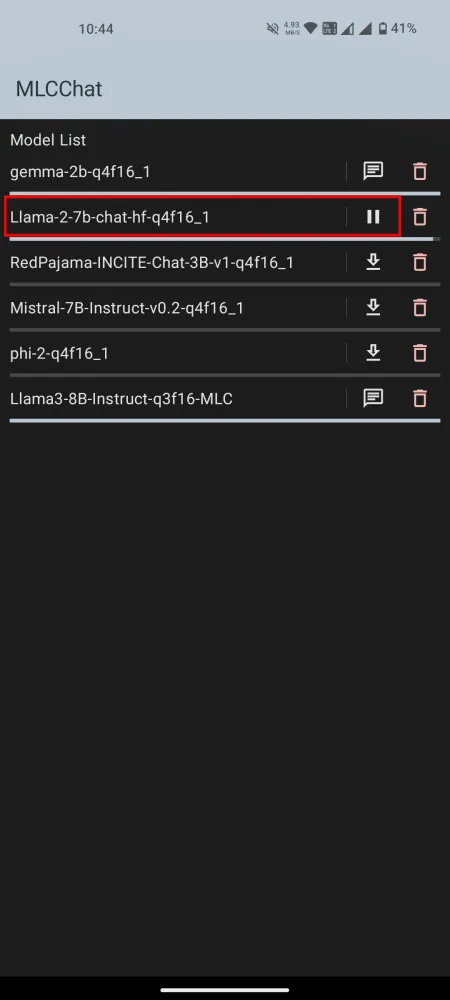

Schritt 2: Laden Sie ein LLM herunter

In der MLCChat-App finden Sie eine Liste verfügbarer Modelle, die Sie herunterladen können. Tippen Sie auf den Download-Link neben einem Modell, das Ihnen gefällt, und warten Sie, bis es heruntergeladen ist.

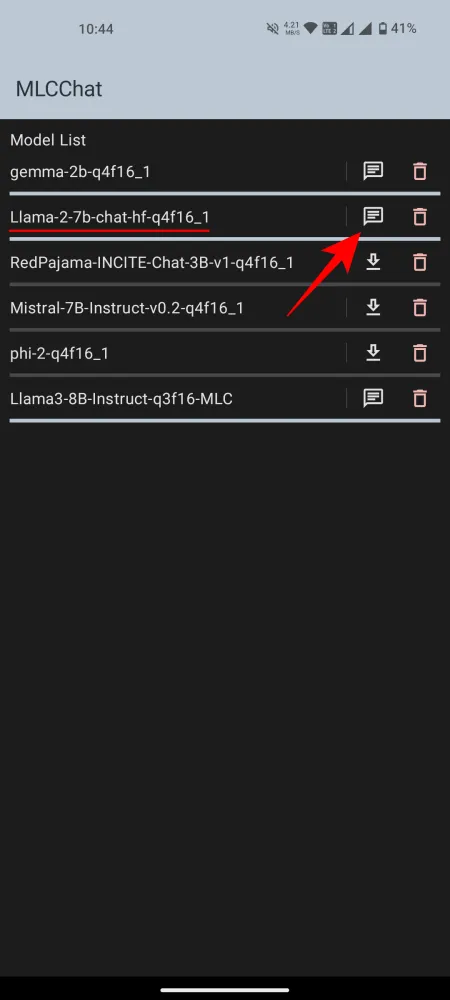

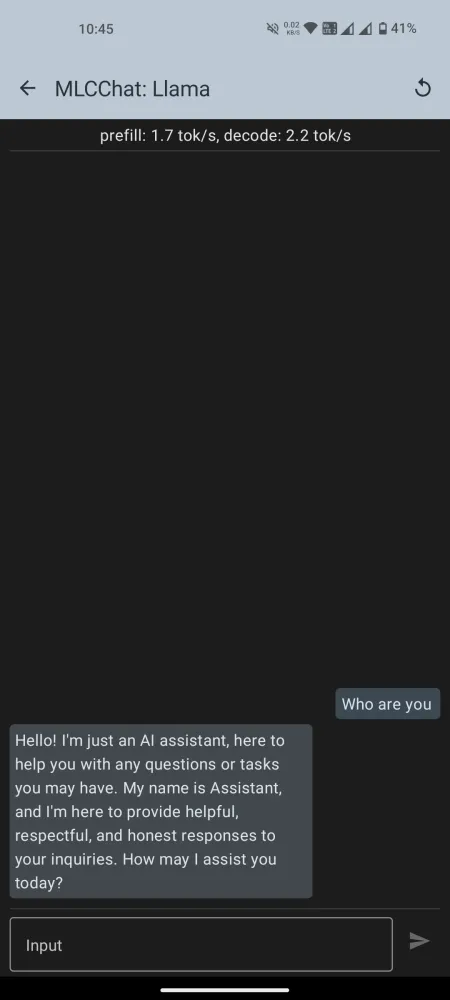

Schritt 3: Ausführen des installierten LLM

Tippen Sie nach dem Download auf das Chat-Symbol daneben, um den Chat zu starten. Warten Sie, bis das Modell initialisiert ist. Sobald es bereit ist, können Sie mit dem Chatten mit der KI beginnen.

Beachten Sie, dass es in der Liste der verfügbaren Modelle in der MLCChat-App einige gibt, wie z. B. Llama3, die viel Rechenleistung erfordern. Sie können die Modelle jedoch jederzeit installieren und testen, ob sie reibungslos genug laufen. Wenn nicht, versuchen Sie es mit einem kleineren Sprachmodell.

Bei unseren Tests (auf Nothing Phone 1) konnte Gemma-2b nicht geladen werden, während Llama3 die System-Benutzeroberfläche zerstörte. Llama-2 und Phi-2 funktionierten gut. Der Hauptunterschied zwischen LLMs und anderen kleineren Sprachmodellen ist die Breite der Informationen, mit denen sie trainiert werden (Parameter). Wählen Sie Ihre Modelle also entsprechend Ihren Anforderungen und den Funktionen Ihres Android-Geräts aus.

Wir hoffen, Sie konnten LLMs lokal auf Ihrem Android-Gerät installieren und ausführen. Bis zum nächsten Mal!

Schreibe einen Kommentar