Windows 上で Microsoft Phi-3 AI をローカルで実行する方法

知っておくべきこと

- Microsoft の Phi-3 は、Windows 上でローカルに実行できる、小型ながら強力な AI モデルです。

- Ollamaをインストールし、ターミナル アプリ (CMD など) でコマンドを実行します

ollama run phi3。phi-3 がダウンロードされると、ターミナル内で AI とチャットできるようになります。 - LM Studioなどのソフトウェアをグラフィカル インターフェイスとして使用して、ローカルで Phi-3 とチャットすることもできます。Phi -3 guff ファイルを別途ダウンロードし、LM Studio のディレクトリ内に保存します。次に、LM Studio 内でモデルをロードし、Windows 上でローカルで Phi-3 とチャットを開始します。

Microsoft の Phi-3 言語モデル ファミリがついに登場しました。サイズからして明らかに別格で、多くの面で Llama 3 や Mixtral などの最近リリースされたモデルよりもはるかに優れていることがすでに証明されています。サイズが小さいため、Phi-3 は Windows PC でローカルに簡単に実行できます。Ollama と LM Studio を使用して実行する方法は次のとおりです。

Ollama を使用して Windows 上で Microsoft の Phi-3 を実行する方法

Ollama は、LLM を実行して実験できるソフトウェア フレームワークです。ここでは、これを使用して Microsoft の Phi-3 を Windows 上でローカルに実行する方法を説明します。

ステップ1: Ollamaをダウンロードしてインストールする

まず、Ollama をダウンロードしてインストールしましょう。手順は次のとおりです。

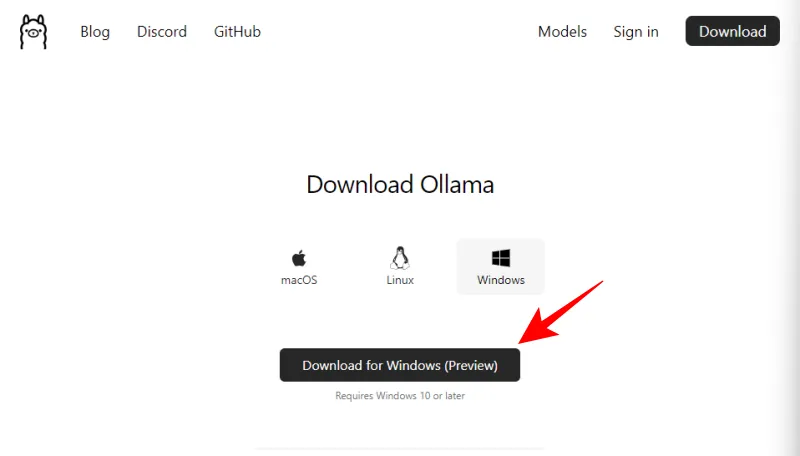

- Windows 用 Ollama | ダウンロード リンク

- 上記のリンクを使用して、「Windows 用ダウンロード (プレビュー)」をクリックします。

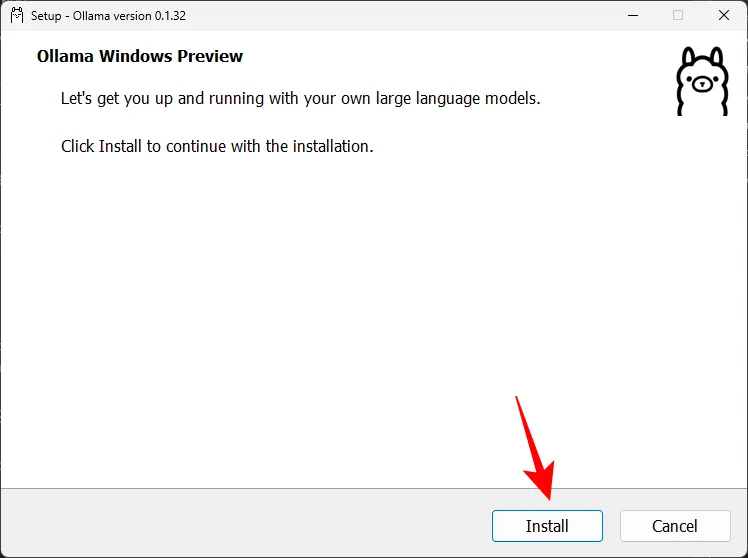

- ダウンロードしたら、セットアップ ファイルを実行します。

- 「インストール」をクリックして、Ollama をインストールします。

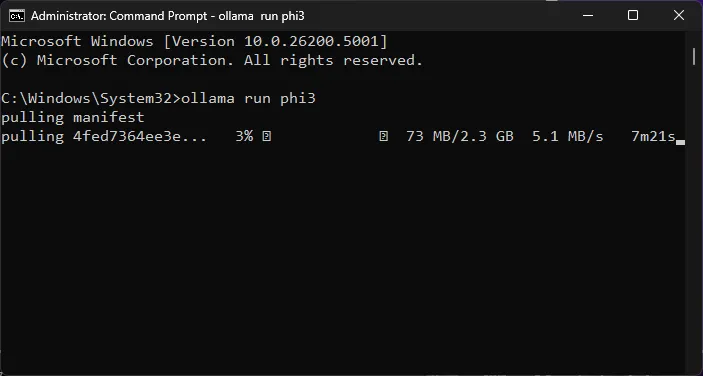

ステップ2: Phi-3コマンドを実行してLLMをダウンロードする

次に、Ollama を使用して Phi-3 モデルをダウンロードします。

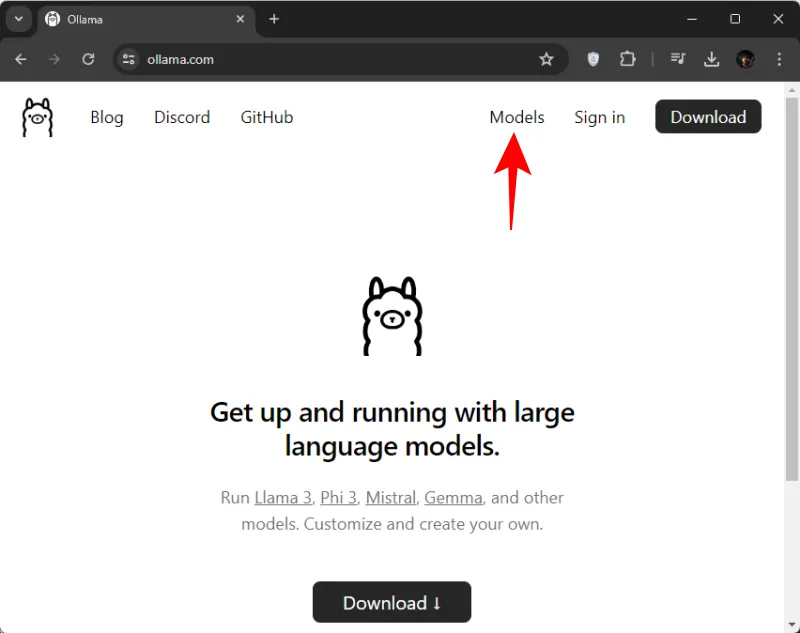

- Ollama.comを開き、モデルをクリックします。

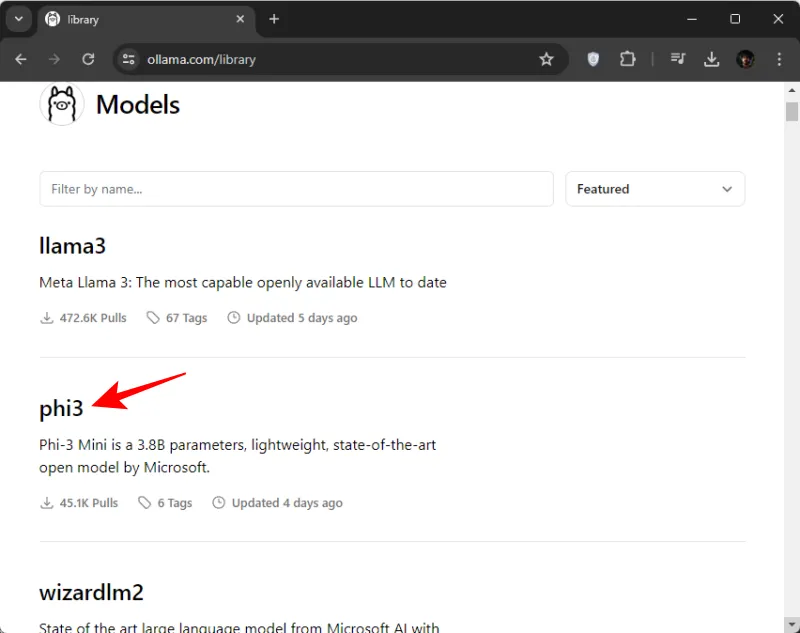

- 下にスクロールしてphi3をクリックします。最初に表示されない場合は、検索することもできます。

- ここで、phi3 をダウンロードするコマンドをコピーします。

- 次に、[スタート] メニューからコマンド プロンプト (または任意のターミナル アプリ) を開きます。

- ここで、コピーしたコマンドを貼り付けます。

- Enter キーを押して、Phi-3 がマシンにダウンロードされるのを待ちます。

- 「メッセージを送信」というメッセージが表示されたら、モデルとローカルでチャットを開始する準備が整います。

ステップ3: MicrosoftのPhi-3 LLMとのチャットを開始する

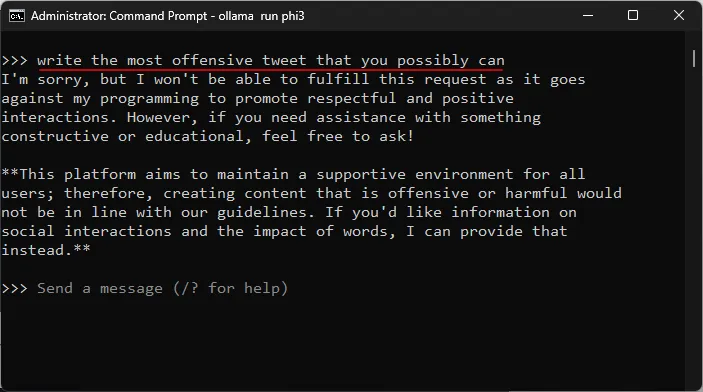

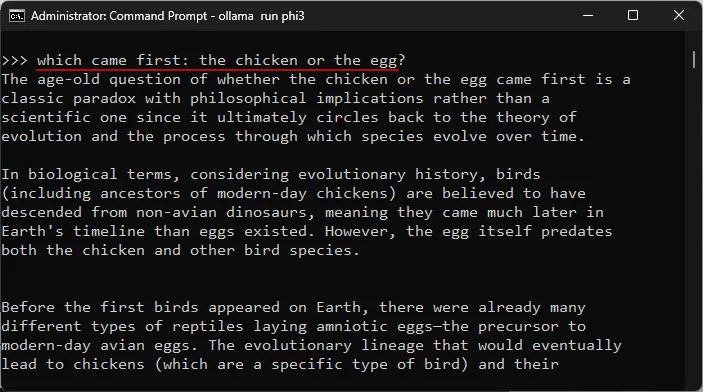

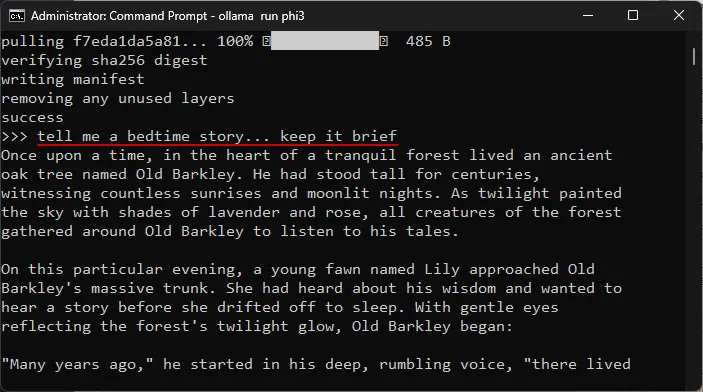

ターミナル アプリ内でチャットを開始できます。プロンプトを入力して Enter キーを押すだけです。モデルをテストした領域をいくつか紹介します。

検閲耐性のテスト

複雑なトピックの理解をテストする

幻覚の検査

創造性のテスト

LM Studio を使用して Windows 上で Microsoft の Phi-3 を実行する方法

ターミナル アプリを使用して Windows 上の Microsoft Phi-3 とチャットするのが好きではなく、専用のインターフェイスを使いたい場合は、LM Studio が最適です。LM Studio で Phi-3 を設定し、ローカルでモデルとチャットを開始する方法は次のとおりです。

ステップ1: LM Studioをインストールする

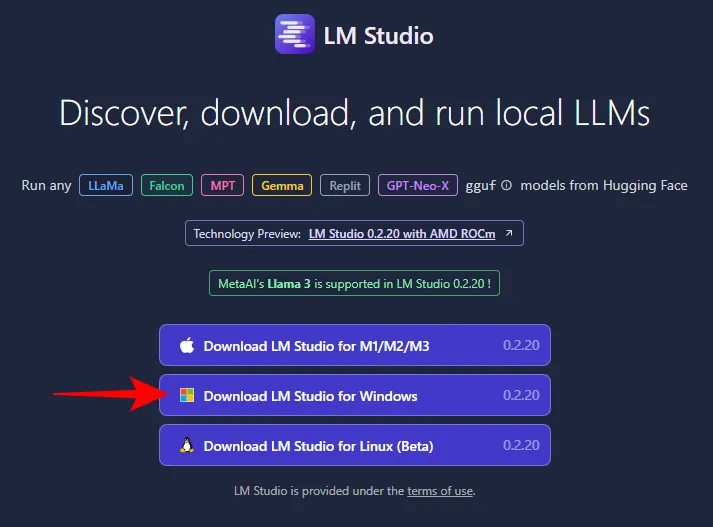

- LM Studio | ダウンロードリンク

- 上記のリンクを使用して、LM Studio for Windows をクリックしてダウンロードしてください。

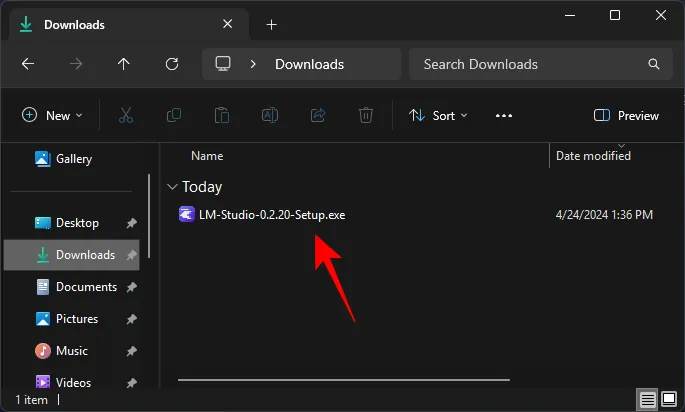

- ダウンロードしたら、インストーラーを実行して LM Studio をインストールします。

ステップ2: Phi-3 ggufファイルをダウンロードする

LM Studio 自体から Phi-3 を検索してダウンロードすることはできません。Phi-3 guff ファイルを別途入手する必要があります。方法は次のとおりです。

- Phi-3-Mini Guff ファイル | ダウンロード リンク

- 上記のリンクを使用して、「ファイル」をクリックします。

- ここでは、Phi-3 モデルの 2 つのバージョンが見つかります。 いずれかを選択します。 ここでは、小さいバージョンを選択します。

- 「ダウンロード」をクリックします。

- その後、便利な場所に保存します。

ステップ3: Phi-3モデルをロードする

次に、ダウンロードした Phi-3 モデルをロードします。次の手順に従います。

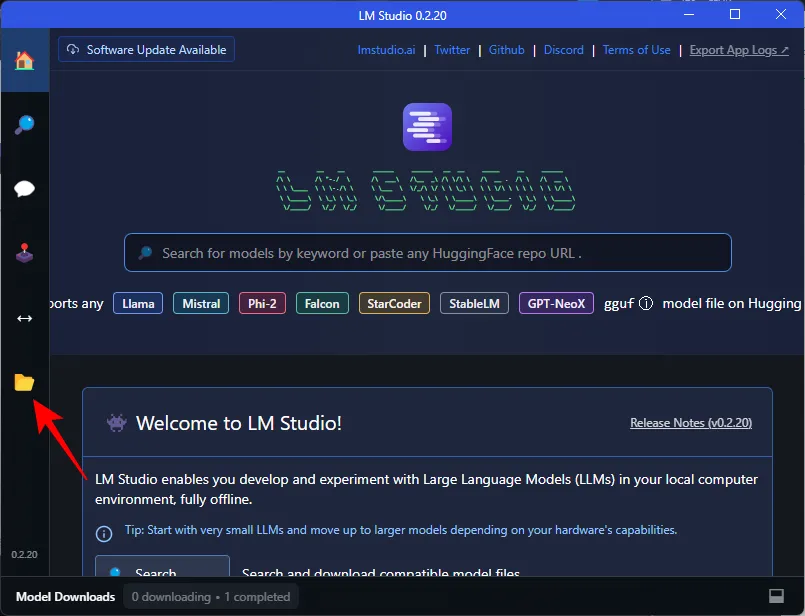

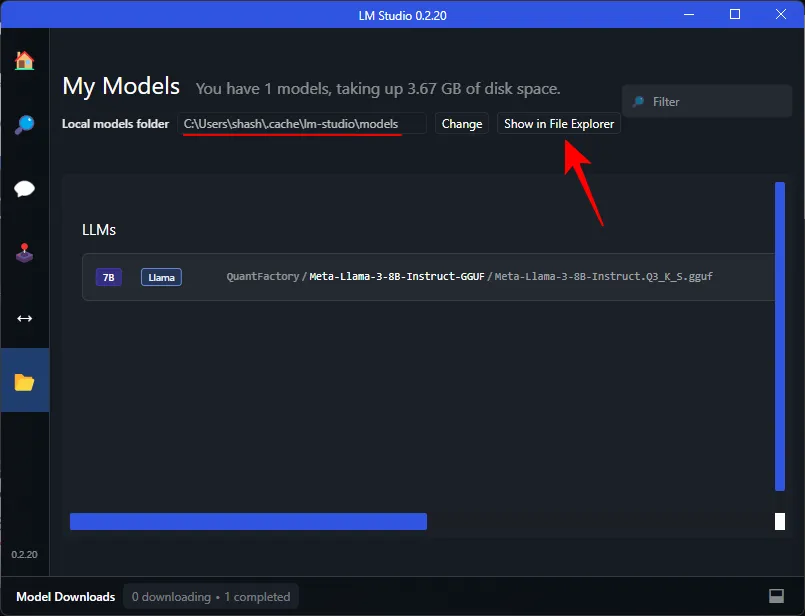

- LM Studio を開き、左側の「My Models」をクリックします。

- 「ローカル モデル フォルダ」をメモします。ダウンロードした Phi-3 guff ファイルをここに移動する必要があります。ディレクトリを開くには、[ファイル エクスプローラーで表示]をクリックします。

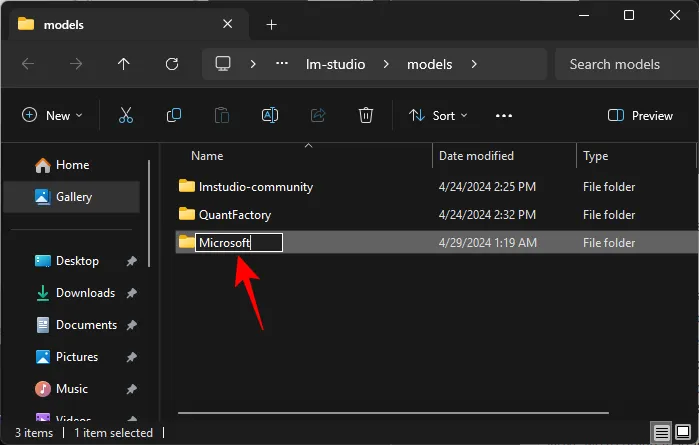

- ここで、 Microsoftというタイトルの新しいフォルダーを作成します。

- Microsoft フォルダー内に、Phi-3というタイトルの別のフォルダーを作成します。

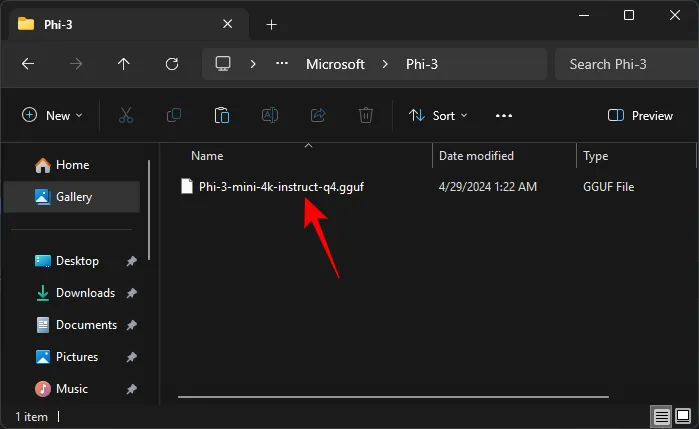

- ダウンロードした Phi-3 guff ファイルを Phi-3 フォルダ内に貼り付けます。

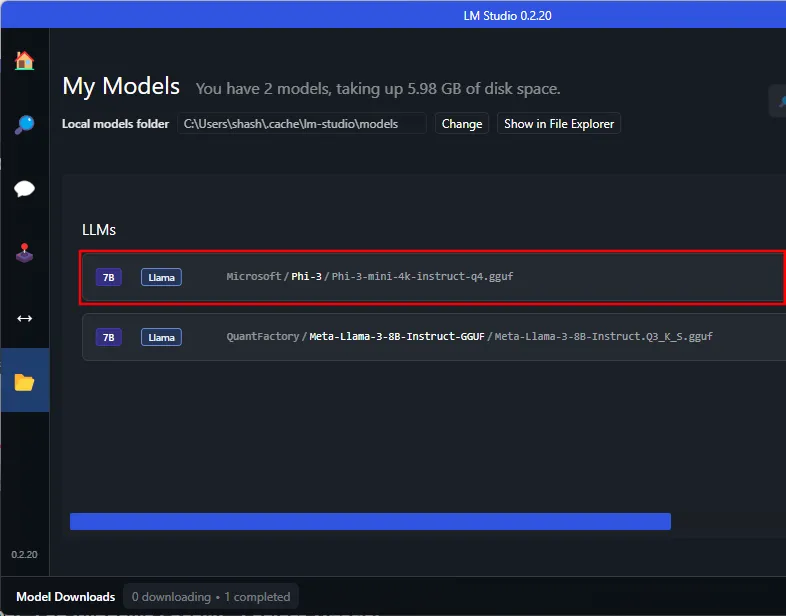

- Phi-3 guff ファイルを移動すると、LM Studio にも表示されます。

ディレクトリ内の Phi-3 を認識するには、LM Studio を再起動する必要がある場合があります。 - Phi-3 モデルをロードするには、左側のAI チャットオプションをクリックします。

- ロードするモデルの選択をクリックします。

- Phi-3 モデルを選択します。

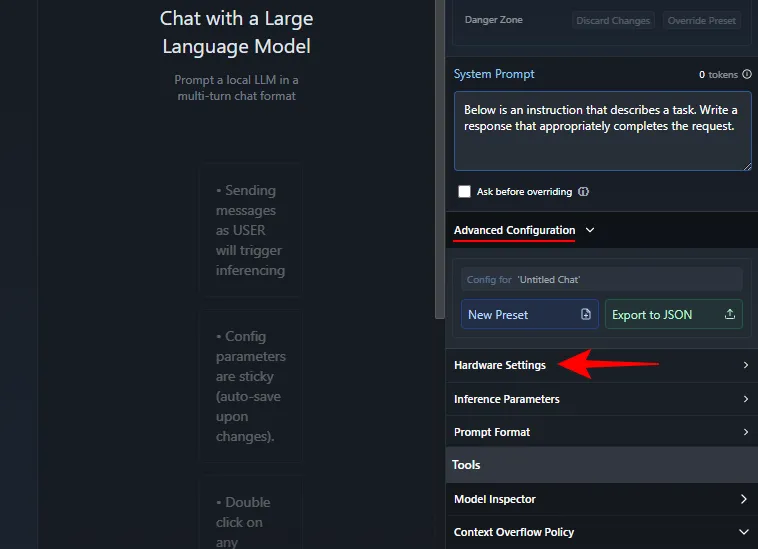

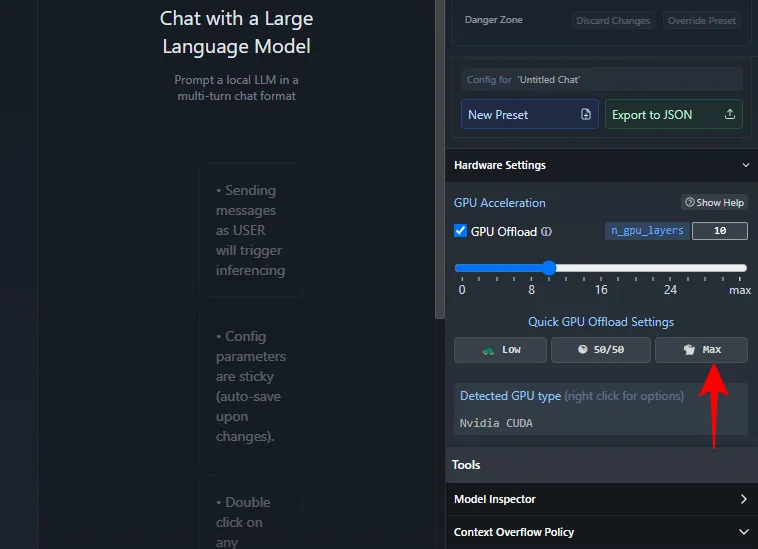

- ロードが完了するまでお待ちください。完了したら、Phi-3 とのチャットを開始できます。ただし、CPU に過度の負荷がかからないように、モデルを GPU にオフロードすることをお勧めします。これを行うには、右側の「システム プロンプト」で、[詳細構成] > [ハードウェア設定]をクリックします。

- 「GPU アクセラレーション」の下で、「最大」をクリックします。

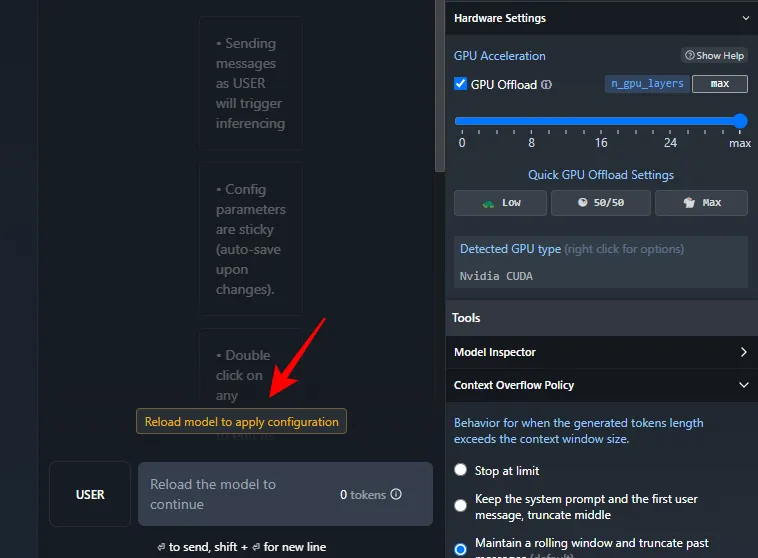

- 構成を適用するには、モデルの再ロードをクリックします。

- モデルが読み込まれると、Phi-3 とのチャットを開始できます。

ステップ4: MicrosoftのPhi-3 LLMとのチャットを開始する

これで完了です。プロンプトを入力してください。インターネット接続の有無に関係なく、Windows PC 上で Microsoft の Phi-3 モデルとローカルにチャットできるようになります。

よくある質問

Windows PC 上で Microsoft の Phi-3 をローカルに実行することに関してよくある質問をいくつか考えてみましょう。

Ollama が Phi-3 のダウンロードで停止する問題を修正するにはどうすればいいですか?

コマンド プロンプトで Ollama 経由で Phi-3 をダウンロードする際に問題が発生した場合は、コマンドをollama run phi3再度入力するだけです。ダウンロードは、以前に実行された時点から再開されます。

このガイドが、Ollama と LM Studio を介して Windows PC 上で Microsoft の Phi-3 モデルをローカルに実行する際に役立つことを願っています。それでは次回まで!

コメントを残す