Opera 成為第一個整合本地人工智慧模型的主要瀏覽器

要知道什麼

- Opera 是第一個為本地 LLM(大約有 150 個)添加內建支援的瀏覽器。

- 本地法學碩士非常適合增強隱私和安全性以及離線存取人工智慧模型。然而,它們的速度取決於您機器的功能。

- Opera One 的開發者流中提供了對本機 AI 模型的存取。

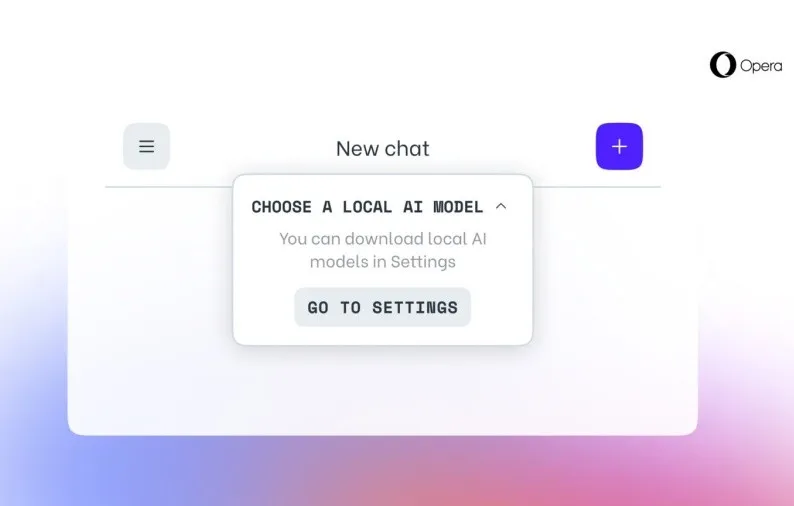

Opera 正在將對 150 種本地 LLM(大型語言模型)變體的支援整合到 Opera One(該公司的 AI 整合瀏覽器)的開發人員流中。新增對 AI 的實驗性本地支援是瀏覽器中的首次,並且允許直接從瀏覽器本身輕鬆存取 AI 模型。

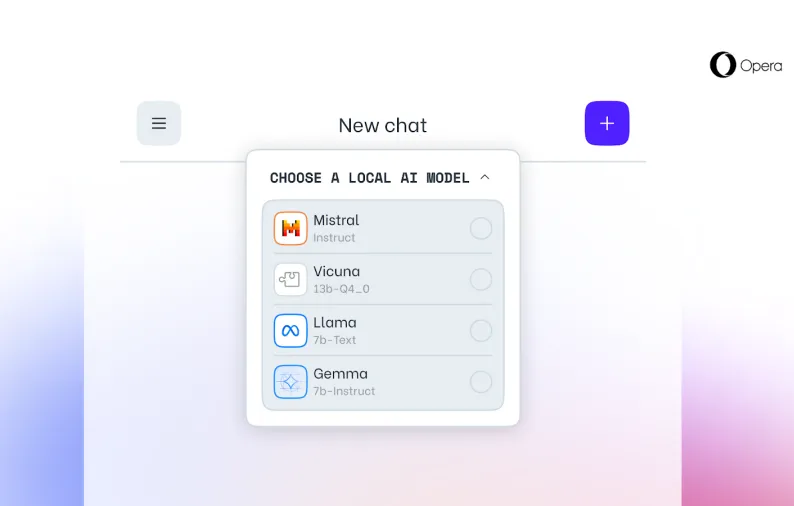

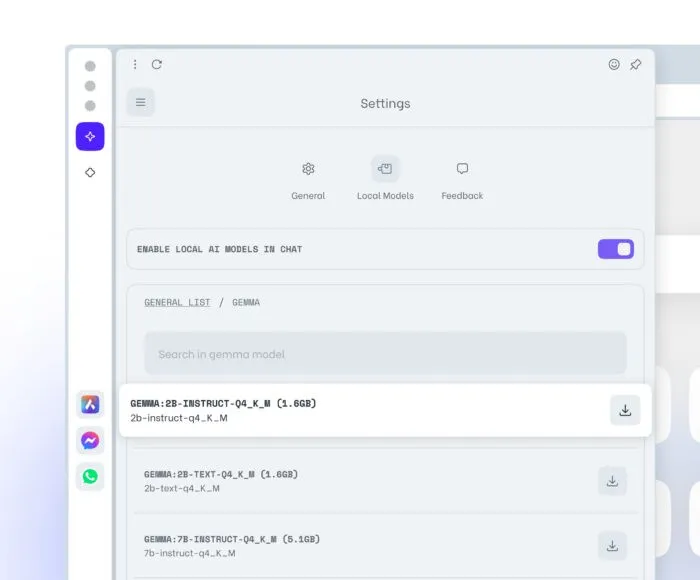

Opera One 中一些比較著名的本地法學碩士包括來自 Meta 的 Llama、來自 Google 的 Gemma、Vicuna 和來自 Mistral AI 的 Mixtral。這些都是 Opera 自己的 Aria 聊天機器人的補充。

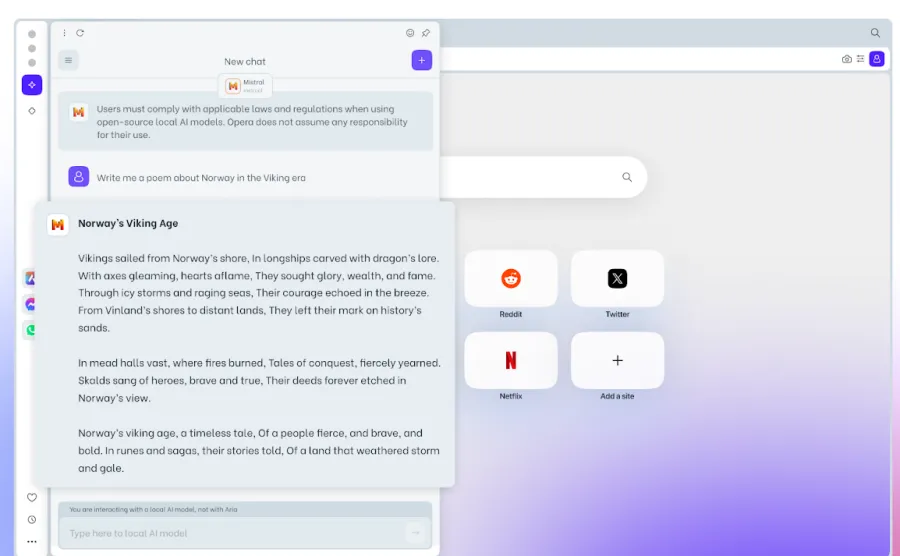

Opera One Developer 使用者可以先更新到最新的瀏覽器版本,然後選擇他們想要測試的模型,啟動新功能,並將本機 LLM 下載到他們的電腦上。典型的 LLM 需要 2 到 10 GB 的儲存空間。下載後,您將能夠切換到並使用本地 LLM 而不是 Aria。

本地法學碩士有很多好處,例如更好的隱私和安全性(因為資料不會離開您的電腦)、離線使用以及整體上增強的瀏覽器體驗。本地法學碩士可能存在的一個缺點是,與基於伺服器的法學碩士相比,它提供輸出的速度可能很慢,因為處理完全取決於電腦的硬體功能。因此,儘管它對於大多數現代機器來說都可以正常工作,但舊設備可能會感到資源緊張。

儘管如此,將本地人工智慧模型整合到瀏覽器本身對於 Opera 來說是一大進步,我們可能會看到這成為其他主要瀏覽器的趨勢。

發佈留言