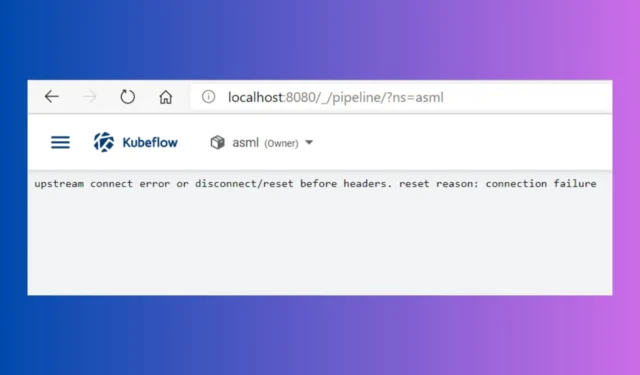

修復:上游連線錯誤或在標頭之前斷開/重置

在標頭問題之前處理上游連接錯誤或斷開/重置可能會非常令人沮喪。此訊息表示在伺服器發送回應之前客戶端和伺服器之間的連線已關閉。此問題可能發生在不同的場景中,但通常適用於程式設計情況。

如何修復上游連線錯誤或標頭之前斷開/重置?

1. 檢查您的防火牆設置

- 開啟雲端平台的防火牆設定:

- 對於 Azure,您可以在網路安全下找到它。

- 對於 GCP,它通常位於 VPC 網路 > 防火牆規則下。

- 對於 AWS,請前往安全群組設定。

- 找到容器或虛擬機器的防火牆規則:

- 尋找允許流量的入站規則。

- 確保正確的連接埠已開啟:

- 通常,您需要開啟 80 (HTTP)、443 (HTTPS) 等連接埠或您的應用程式所使用的任何自訂連接埠(例如,Kestrel 的 6001)。

- 如有必要,請新增規則:

- 新增規則以允許必要連接埠上的入站流量並將其指派給適當的網路介面。

此解決方案可確保您的應用程式可以透過設定正確的防火牆規則來接收來自外部來源的流量。

2. 更新 Istio Gateway 和 VirtualService 配置

- 檢查您的網關和 VirtualService 配置:

- 開啟 Istio 設定檔(gateway.yaml、virtualservice.yaml)。

- 驗證連接埠配置:

- 確保網關中定義的連接埠與您的服務公開的連接埠相符。

- 網關範例:

apiVersion: networking.istio.io/v1alpha3 kind: Gateway metadata: name: my-gateway namespace: istio-system spec: selector: istio: ingressgateway servers: - port: number: 443 name: https protocol: HTTPS tls: mode: SIMPLE credentialName: "my-credential"hosts: - "my-host.example.com"

- 檢查 VirtualService 路由:

- 確保您的 VirtualService 具有正確的路由配置。

- 虛擬服務範例:

apiVersion: networking.istio.io/v1alpha3 kind: VirtualService metadata: name: my-service spec: hosts: - "my-host.example.com"gateways: - my-gateway http: - route: - destination: host: my-service port: number: 443

透過確保您的網關和 VirtualService 配置正確並符合您的服務要求,您可以避免連線問題。另外,請確保您使用正確的 yaml 檔案。

3.檢查pod和服務命名以及連接埠配置

- 檢查您的 Kubernetes 服務設定:

- 確保服務中定義的連接埠與應用程式公開的連接埠相符。

- 例子:

apiVersion: v1 kind: Service metadata: name: my-service spec: selector: app: my-app ports: - protocol: TCP port: 443 targetPort: 8080 name: https

- 更新部署的容器連接埠:

- 確保部署 YAML 中的容器定義為公開正確的連接埠。

- 例子:

apiVersion: apps/v1 kind: Deployment metadata: name: my-app spec: replicas: 1 selector: matchLabels: app: my-app template: metadata: labels: app: my-app spec: containers: - name: my-container image: my-image ports: - containerPort: 8080

正確設定您的服務和部署可確保 Istio 可以正確地將流量路由到您的 Pod,從而避免連線錯誤。

4. 檢查資源分配與節點健康狀況

- 檢查節點資源分配:

- 確保您的 Kubernetes 節點分配了足夠的資源(CPU、記憶體)。

- 您可以使用kubectl topnodes和kubectldescribenode<node-name>檢查節點資源使用量。

- 如果負載較重,請新增更多節點或增加現有節點的資源。

- 重新啟動受影響的 Pod:

- 重新啟動應用程式 Pod 以清除任何潛在的記憶體洩漏或資源分配問題。

- 使用

kubectl rollout restart deployment <deployment-name>

- 透過雲端供應商的監控工具(適用於 AWS 的 CloudWatch、適用於 GCP 的雲端監控或 Azure Monitor)監控節點運作狀況。

確保您的節點擁有足夠的資源且運作狀況良好,有助於防止因資源限製而導致的停機和連線錯誤。

5. 使用正確的協定和安全性設置

- 檢查協議設定:

- 確保您在配置中使用正確的協定 (HTTP/HTTPS)。

- 更新 Dockerfile 或環境變數以公開正確的連接埠。

- 正確設定環境變數:

- Dockerfile 範例:

FROM mcr.microsoft.com/dotnet/aspnet:5.0 EXPOSE 80 ENV ASPNETCORE_URLS=http://+:80

- Dockerfile 範例:

- 調整 ASP.NET Core/Kestrel 設定:

- 確保 Kestrel 設定為偵聽正確的連接埠。

- 範例中

Program.cs:public class Program { public static void Main(string[] args) { CreateHostBuilder(args).Build().Run(); } public static IHostBuilder CreateHostBuilder(string[] args) => Host.CreateDefaultBuilder(args). ConfigureWebHostDefaults(webBuilder => { webBuilder.UseStartup<Startup>(). UseUrls("http://+:80"); }); }

正確的協定和連接埠配置可確保您的應用程式可按預期訪問,避免斷開/重置錯誤。

透過遵循這些解決方案,您可以排查並解決 Kubernetes 和 Istio 環境中的上游連線錯誤或在 headers 錯誤之前中斷/重設。請始終記住監控您的配置和資源分配,以防止將來出現問題。

對於任何其他問題或建議,請向下捲動至評論部分。

發佈留言