在 Windows 11 PC 上安裝 LLaMA 3 的逐步指南

Llama 3 代表了 Meta 在大型語言模型方面的最新進展,非常適合廣泛的應用,包括回答問題、協助完成學術作業等等。透過在 Windows 11 裝置上設定 Llama 3,即使沒有網路連接,您也可以隨時存取它。本指南將示範如何在 Windows 11 電腦上設定 Llama 3。

在 Windows 11 電腦上安裝 Llama 3

使用 Python 在 Windows 11 裝置上安裝 Llama 3 的過程需要一定程度的技術熟練度。儘管如此,還是有簡化 Llama 3 本地部署的替代方法。

要安裝 Llama 3,您需要在命令提示字元中執行特定命令。請注意,這只會授予對命令列版本的存取權限;使用其網路介面需要額外的步驟。這裡將介紹這兩個過程。

透過 CMD 在 Windows 11 上設定 Llama 3

首先,您必須在 Windows 電腦上安裝 Ollama 才能部署 Llama 3。

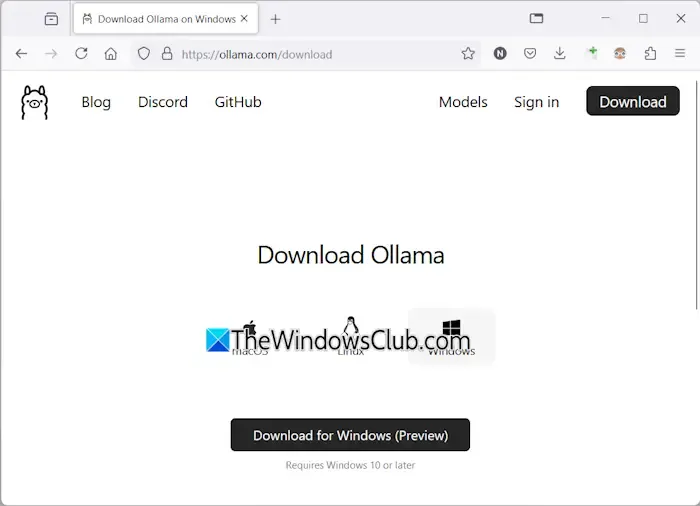

- 導航至Ollama 官方網站。

- 選擇“下載”選項,然後選擇“Windows”。

- 按一下「下載 Windows 版」將可執行檔儲存到您的電腦。

- 執行下載的 exe 檔案以在您的裝置上安裝 Ollama。

Ollama 成功安裝後,重新啟動電腦。它應該在背景運行,在系統托盤中可見。然後,請造訪 Ollama 網站上的模型部分以查看可用模型。

Llama 3.1 型號提供三種配置:

- 8B

- 70B

- 405B

405B 配置要求最高,可能無法在低階機器上運作。 Llama 3.2 提供了兩個選項:

- 1B

- 3B

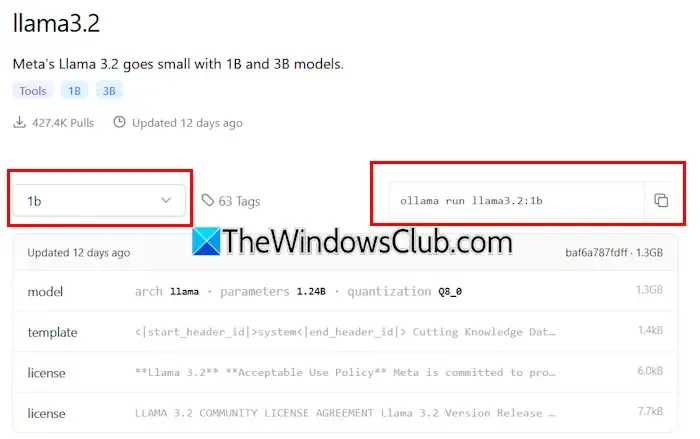

選擇 Llama 版本進行安裝 – 如果選擇 Llama 3.2,請按一下它。在隨後的下拉式選單中,選擇您所需的配置。接下來,複製旁邊顯示的命令並將其貼上到命令提示字元中。

以下是 Llama 3.2 模型的指令:

ollama run llama3.2:3b

若要安裝 Llama 3.2 1B 配置,請輸入:

ollama run llama3.2:1b

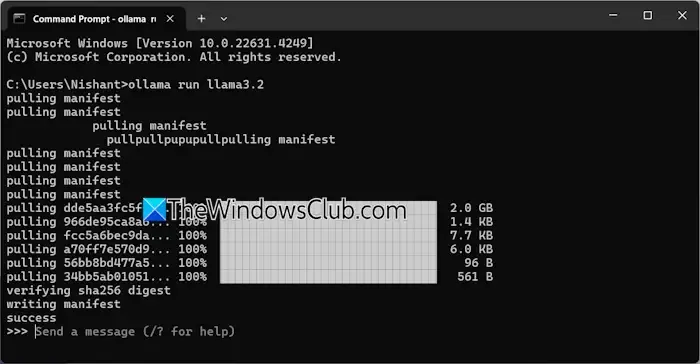

開啟命令提示符,根據需要鍵入上述命令之一,然後按Enter。下載過程將需要一些時間,具體取決於您的網路連線。完成後,命令提示字元中將出現一條成功訊息。

然後,您可以鍵入輸入以與 Llama 3.2 模型進行互動。若要安裝 Llama 3.1 模型,請使用 Ollama 網站上提供的指令。

下次開啟命令提示字元時,您可以使用相同的命令執行 Llama 3.1 或 3.2。

透過 CMD 安裝 Llama 3 的一個限制是缺少已儲存的聊天記錄。但是,透過本機主機部署它除了提供改進的使用者介面之外還可以保存您的聊天歷史記錄。以下部分介紹如何實現這一目標。

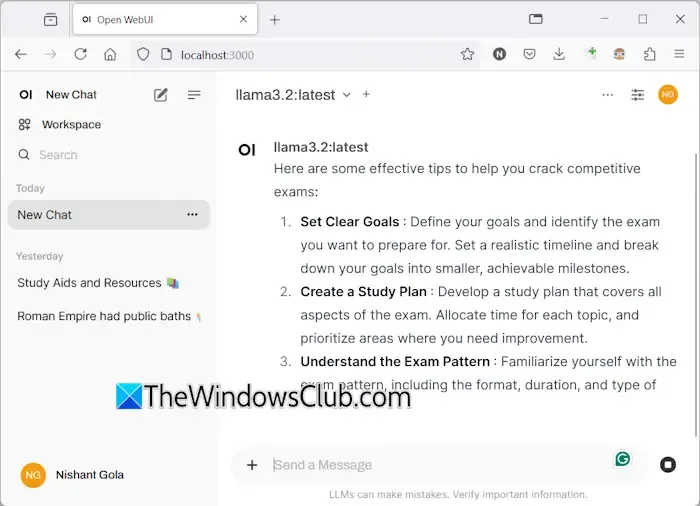

在 Windows 11 上使用 Web UI 部署 Llama 3

透過網頁瀏覽器使用 Llama 3 不僅可以增強使用者體驗,還可以保留聊天歷史記錄,這是使用 CMD 時所沒有的功能。以下是如何在網頁瀏覽器中執行 Llama 3。

若要透過 Web 瀏覽器存取 Llama 3,請確保您的系統上已透過 Ollama 和 Docker 設定了 Llama 3。如果您尚未安裝 Llama 3,請依照前面所述繼續安裝 Ollama。接下來,從其官方網站下載並安裝 Docker 。

安裝 Docker 後,打開它並完成註冊程序以建立帳戶,因為沒有它 Docker 將不會啟動。登入後,將 Docker 最小化到系統托盤;確保 Docker 和 Ollama 在背景處於活動狀態,以便透過 Web 瀏覽器使用 Llama 3。

開啟命令提示符,複製以下命令並貼上:

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

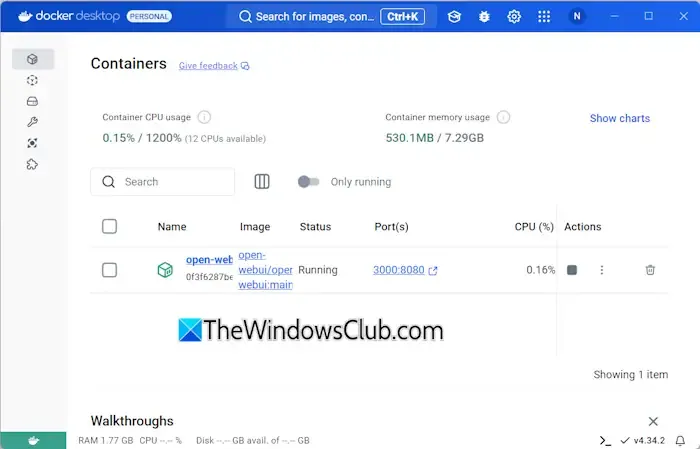

此命令將需要一些時間來下載必要的文件,因此請耐心等待。完成後,打開 Docker 並導航到左側的“容器”部分。您應該會看到自動為連接埠 3000:8080 建立的容器。

按一下連接埠 3000:8080,這將在您的預設 Web 瀏覽器中啟動一個新選項卡。您可能需要註冊並登入才能透過網頁瀏覽器使用 Llama 3。如果你檢查網址列,它將顯示 localhost:3000,表示 Llama 3 託管在本地,無需訪問互聯網即可使用。

從下拉式選單中選擇您喜歡的 Llama 聊天模型。若要合併其他 Llama 3 聊天模型,請使用相應的命令透過 Ollama 安裝它們;然後它們將在您的瀏覽器中可用。

您的聊天記錄將在左側儲存和檢索。完成後,在 Web 瀏覽器中登出會話,然後開啟 Docker 並按一下「停止」按鈕將其關閉,然後再關閉 Docker。

下次您希望在 Web 瀏覽器中存取 Llama 3 時,啟動 Ollama 和 Docker,等待幾分鐘,然後按一下 Docker 容器中的連接埠以啟動 localhost 伺服器。登入後,您可以開始使用 Llama 3。

我希望這些資訊對您有所幫助。

Llama 3 可以在 Windows 上運作嗎?

您在計算機上運行 Llama 3 的能力取決於其硬體規格。最輕的版本,即1B型號,可以透過命令提示字元安裝和操作。

Llama 3 需要多少 RAM?

要運行 Llama 3.2 1B 模型,您的系統應配備至少 16 GB RAM 以及強大的 GPU。 Llama 3 的更高版本將需要您的系統提供更多資源。

發佈留言