Crawl4AI に代わるオープンソースのトップ代替品: ベストな選択肢の比較

Crawl4AI は、Web クローリングとデータ抽出の補完ツールとして機能し、特に大規模言語モデル (LLM) と多数の AI ベースのアプリケーションの要件に対応します。ただし、この分野で唯一の競合相手というわけではありません。この記事では、Crawl4AI に代わるオープンソースの優れた代替手段を紹介します。

Crawl4AI に代わる主要なオープンソースの代替品

以下は、Crawl4AI の注目すべきオープンソースの代替品です。

- スクレイピー

- コリー

- パイスパイダー

- Xクロール

- ファイアクロール

1] くだらない

Scrapy は、Web スクレイピングとクロール用に設計された Python ベースのオープンソース フレームワークです。これにより、ユーザーは Web ページからデータを効率的に抽出できます。Scrapy は、非同期ネットワーク フレームワークである Twisted を使用しているため、パフォーマンスと処理速度が向上します。

このフレームワークは、ミドルウェアとパイプラインの追加をサポートしており、カスタマイズされたデータ処理を可能にします。Scrapy は、リクエストの管理、リンクのトレース、CSS セレクターと XPath を使用した情報の抽出に優れており、現在の環境にシームレスに溶け込みます。

さらに、Scrapy はユーザーフレンドリーなインターフェースを提供し、さまざまな Web サイトからデータを追跡および抽出するプロセスを簡素化します。このプラットフォームは、活気のあるコミュニティと包括的なドキュメントによってサポートされています。

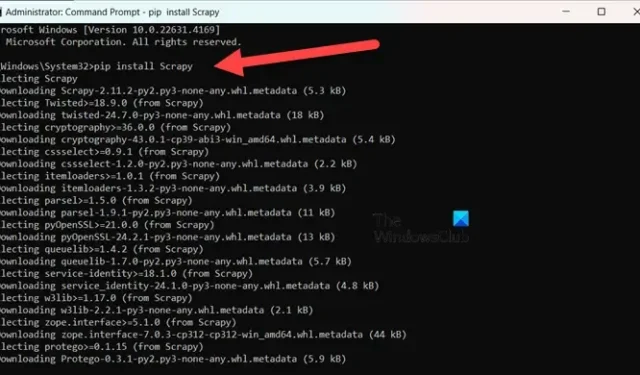

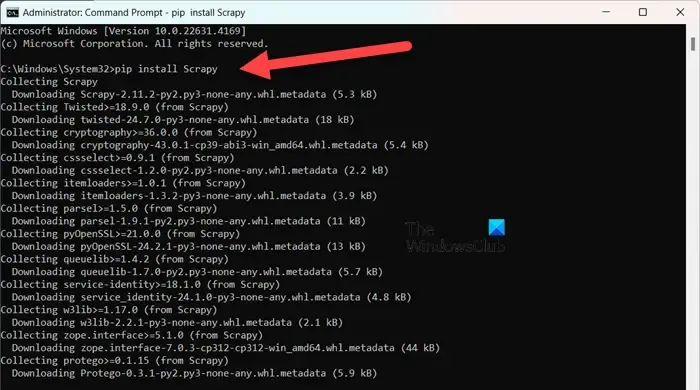

Scrapy をインストールするには、Python 3.8 以上を使用していることを確認してください (CPython がデフォルトですが、PyPy もサポートされています)。Anaconda または Miniconda を使用している場合は、次のコマンドを使用して conda-forge チャネル経由でパッケージをインストールします。

conda install -c conda-forge scrapy

あるいは、PyPI を好む場合は、管理者特権のコマンド プロンプトでコマンドを実行します。

pip install Scrapy

このツールについてさらに詳しく知りたい場合は、scrapy.orgにアクセスしてください。

2]コリー

Colly は、Golang 用に開発されたシンプルなスクレイピング ライブラリです。HTTP リクエストの送信、HTML 解析、Web サイトからのデータの取得のプロセスを簡素化します。Colly には、開発者が Web ページをナビゲートしたり、CSS セレクタを使用して要素をフィルター処理したり、さまざまなデータ抽出の課題に取り組んだりできる機能が備わっています。

Colly の際立った特徴は、1 つのコアで 1 秒あたり 1,000 件を超えるリクエストを処理できる優れたパフォーマンスです。この速度は、コアを追加するほど向上します。このような効率性は、組み込みのキャッシュと、同期および非同期スクレイピングのサポートによって実現されています。

ただし、Colly には JavaScript レンダリングが欠如していることやコミュニティが小さいことなどの制限があり、拡張機能やドキュメントが少なくなっています。

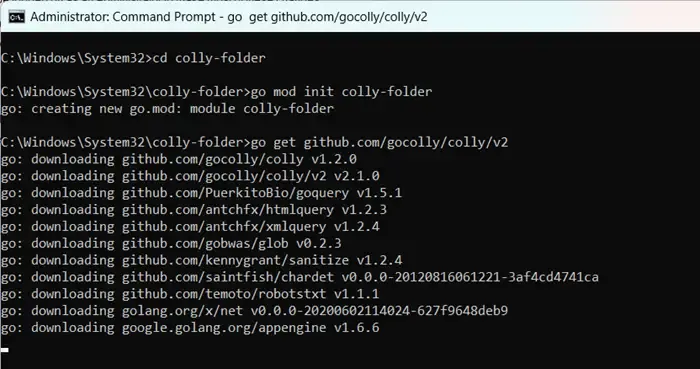

Colly を使い始めるには、まずgo.devにアクセスして Golang をインストールします。インストール後、コンピューターを再起動し、管理者としてコマンド プロンプトを開き、次のコマンドを入力します。

mkdir colly-folder cd colly-folder

go mod init colly-folder

go get github.com/gocolly/colly/v2

「colly-folder」の名前は好きな名前に変更できます。モジュールをビルドしたら、を使用して Web スクレイパーを実行できますgo run main.go。

3]パイスパイダー

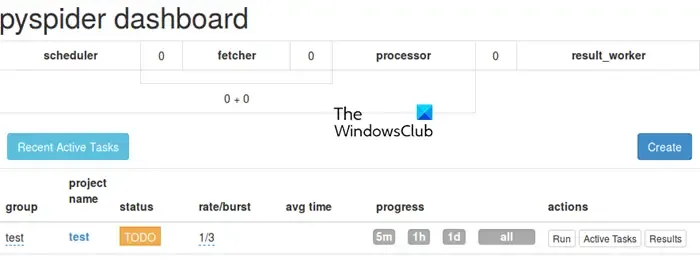

PySpider は、直感的な Web ベースのユーザー インターフェイスを備えた包括的な Web クロール システムとして動作し、クローラーの管理と監視を簡素化します。PhantomJS との統合により、JavaScript を多用した Web サイトを処理できます。

Colly とは異なり、PySpider はタスクのスケジュール設定や優先順位付けなどの広範なタスク管理機能を提供しており、この点では Crawl4AI より優れています。ただし、Crawl4AI の非同期アーキテクチャにより、Crawl4AI と比較するとパフォーマンスが遅れる可能性があることに注意してください。

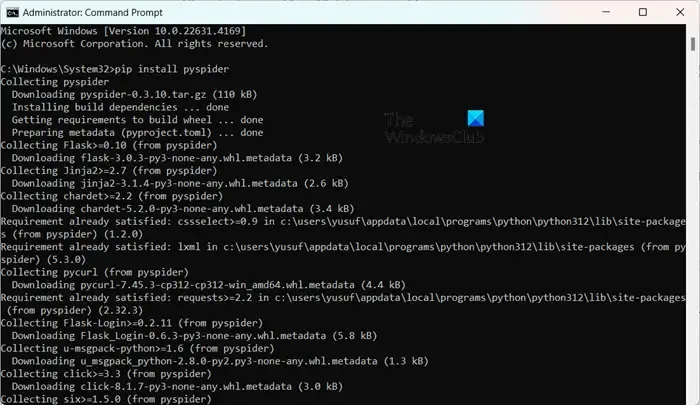

PySpider のインストールは、特に Python がすでにセットアップされている場合は簡単です。管理者pip install pyspider特権のコマンド プロンプトで実行するだけです。開始するには、コマンドを使用してpyspider、Web ブラウザーで http://localhost:5000/ のインターフェイスにアクセスするだけです。

4] Xクロール

X-Crawl は、AI テクノロジーを利用して Web クロール効率を高める、Node.js 用の柔軟なライブラリです。このライブラリは AI 機能を統合し、効果的な Web クローラーとスクレーパーの開発を容易にします。

X-Crawl は、多くの現代の Web サイトに不可欠な JavaScript によって生成される動的コンテンツの管理に優れています。また、ニーズに合わせてクロール エクスペリエンスを微調整できるように、多数のカスタマイズ オプションも用意されています。

Crawl4AI と X-Crawl には、主に好みのプログラミング言語に基づいたいくつかの違いがあることに注意することが重要です。Crawl4AI は Python を使用しますが、X-Crawl は Node.js に基づいています。

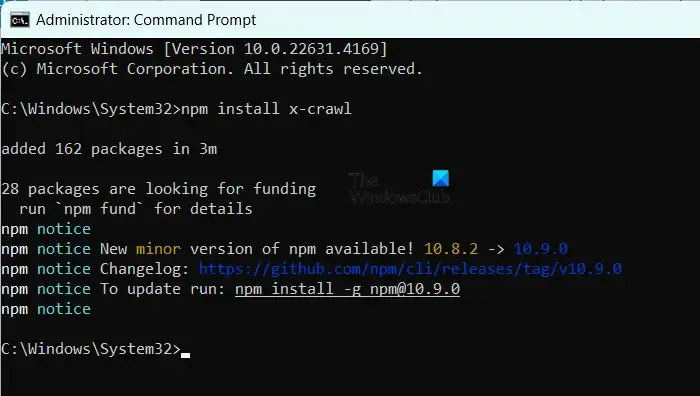

X-Crawl をインストールするには、マシンに Node.js がインストールされていることを確認し、コマンドを実行するだけですnpm install x-crawl。

5] ファイヤークロール

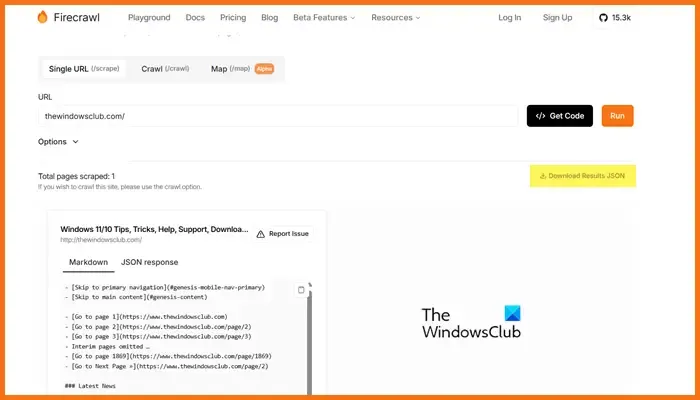

Mendable.ai が開発した Firecrawl は、Web データを整理されたマークダウンやその他の形式に変換し、大規模言語モデル (LLM) や AI アプリケーション向けに最適化された洗練された Web スクレイピング ツールです。LLM で使用できる出力を生成し、このコンテンツをさまざまな言語モデルや AI ソリューションに統合しやすくします。このツールには、クロール ジョブを送信して結果を取得するための使いやすい API が付属しています。Firecrawl の詳細については、firecrawl.devにアクセスし、スキャンする Web サイトの URL を入力して [実行] をクリックしてください。

Web 開発に最適なオープンソース ツールはどれですか?

利用できるオープンソースの Web 開発ツールは数多くあります。コード編集には Visual Studio Code または Atom を検討してください。フロントエンド フレームワークが必要な場合は、Bootstrap と Vue.js が最適な選択肢です。一方、バックエンド開発には Django と Express.js が適しています。さらに、Git、GitHub、Figma、GIMP、Slack、Trello などのプラットフォームも、Web 開発ワークフローを強化できるオープンソース オプションを提供しています。

オープンソースの GPT モデルはアクセス可能ですか?

はい、EleutherAI の GPT-Neo、Cerebras-GPT、BLOOM、OpenAI の GPT-2、NVIDIA/Microsoft の Megatron-Turing NLG など、さまざまなオープンソース GPT モデルが存在します。これらのモデルは、汎用言語処理から多言語機能や高性能タスク向けに作成されたモデルまで、さまざまな要件に合わせて幅広いソリューションを提供します。

コメントを残す