Principais ferramentas gratuitas para executar LLM localmente no PC com Windows 11

Você está procurando manter seus dados seguros e garantir que eles permaneçam em seu dispositivo? Muitos serviços LLM baseados em nuvem impõem taxas de assinatura contínuas vinculadas ao uso da API. Além disso, indivíduos em locais remotos ou aqueles com acesso inconsistente à Internet geralmente não favorecem essas soluções em nuvem. Então, quais alternativas estão disponíveis?

Felizmente, utilizar ferramentas LLM locais pode ajudar a eliminar essas despesas, permitindo que os usuários operem modelos diretamente em seu hardware pessoal. Essas ferramentas permitem o processamento de dados sem uma conexão com a internet, garantindo que suas informações permaneçam inacessíveis a servidores externos. Além disso, elas fornecem uma interface adaptada especificamente ao seu fluxo de trabalho.

Este guia apresenta uma lista selecionada de ferramentas LLM locais gratuitas que atendem às suas necessidades de privacidade, acessibilidade e desempenho.

Principais ferramentas LLM gratuitas para PCs com Windows 11

Abaixo estão algumas ferramentas LLM locais gratuitas e excepcionais que passaram por testes e avaliações completos.

- janeiro

- Estúdio LM

- GPT4ALL

- Qualquer coisaLLM

- Ser

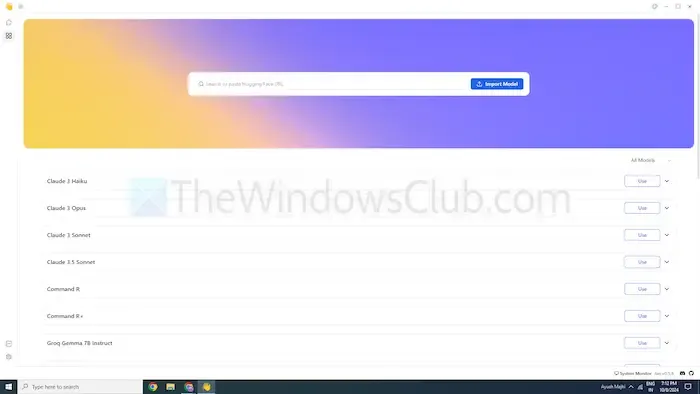

1] Janeiro

Se você conhece o ChatGPT, Jan é uma ferramenta similar projetada para funcionar offline. Ele opera somente no seu dispositivo, permitindo que você crie, analise e processe texto de forma privada na sua rede local.

Jan apresenta modelos de primeira linha como Mistral, Nvidia ou OpenAI, permitindo o uso sem enviar dados para servidores externos. Isso o torna uma excelente escolha para usuários que priorizam a segurança de dados em vez de opções baseadas em nuvem.

Características

- Modelos pré-configurados: equipados com modelos de IA prontos para uso que não exigem instalação adicional.

- Personalização: personalize as cores do painel e escolha um tema sólido ou translúcido.

- Verificação ortográfica: utilize esta função para corrigir erros de ortografia.

Prós

- Permite importações de modelos via fonte Hugging Face.

- Suporta extensões para maior personalização.

- Totalmente gratuito para uso.

Contras

- Suporte limitado da comunidade, resultando em menos tutoriais e recursos disponíveis.

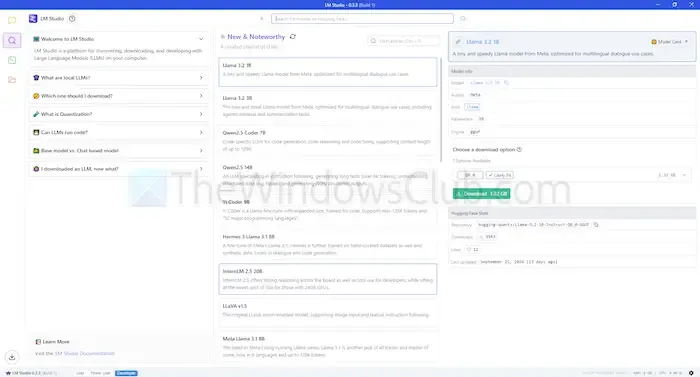

2] Estúdio LM

O LM Studio é outra ferramenta LLM local que permite que você utilize modelos de linguagem como o ChatGPT diretamente na sua máquina. Ele oferece modelos avançados que melhoram sua capacidade de compreender e responder a consultas, mantendo precisamente a localização para melhor privacidade e controle.

Esta ferramenta pode resumir documentos, gerar conteúdo, fornecer respostas e até mesmo auxiliar na programação — tudo isso enquanto roda localmente. Você pode avaliar a compatibilidade de vários modelos com seu sistema antes da implantação, garantindo o uso eficiente de tempo e recursos.

Características

- Upload de arquivos e integração RAG: carregue vários tipos de documentos, como PDF, DOCX, TXT e CSV, para obter respostas personalizadas.

- Amplas opções de personalização: escolha entre vários temas de cores e níveis de complexidade para a interface.

- Rico em recursos: fornece documentação e recursos de aprendizagem para usuários.

Prós

- Compatível com Linux, Mac e Windows.

- Configuração de servidor local disponível para desenvolvedores.

- Oferece uma seleção selecionada de modelos de linguagem.

Contras

- Pode apresentar desafios para iniciantes, principalmente durante a configuração inicial.

3] GPT4ALL

GPT4ALL é outra ferramenta LLM avançada projetada para operar sem exigir uma conexão de internet ou integração de API. Este aplicativo é capaz de rodar sem GPUs, embora possa utilizá-las se disponíveis, tornando-o acessível a uma ampla gama de usuários. Ele suporta várias arquiteturas LLM, garantindo compatibilidade com muitos modelos e frameworks de código aberto.

Esta ferramenta emprega llama.cpp para seu backend, melhorando o desempenho em CPUs e GPUs sem necessitar de recursos de computação de ponta. GPT4ALL funciona perfeitamente com processadores Intel e AMD, permitindo que ele utilize GPUs para velocidades de processamento otimizadas.

Características

- Integração de arquivos locais: os modelos podem consultar e interagir com documentos locais, como PDFs ou arquivos de texto, por meio do Local Docs.

- Memória eficiente: muitos modelos estão disponíveis em versões de 4 bits para reduzir os requisitos de memória e processamento.

- Vasto repositório de modelos: o GPT4ALL hospeda mais de 1.000 modelos de código aberto de repositórios como o Hugging Face.

Prós

- Código aberto e transparente nas operações.

- Oferece soluções específicas adaptadas para empresas utilizarem IA offline.

- Forte ênfase na privacidade do usuário.

Contras

- Suporte limitado para processadores ARM, como os usados em Chromebooks.

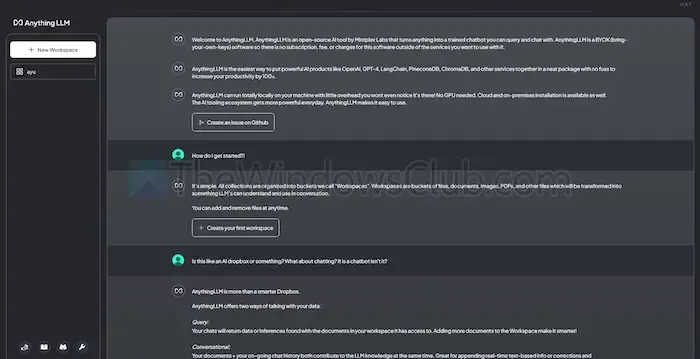

4] Qualquer coisaLLM

AnythingLLM é um LLM de código aberto que permite ampla personalização e garante uma experiência de IA privada. Ele permite que os usuários implementem e executem LLMs offline em seus dispositivos locais — estejam eles usando Windows, Mac ou Linux — garantindo total confidencialidade dos dados.

Esta ferramenta é particularmente adequada para usuários individuais que buscam uma instalação direta com configuração mínima necessária. Ela opera de forma semelhante a um sistema ChatGPT privado que indivíduos ou empresas podem implementar.

Características

- Fácil de usar para desenvolvedores: oferece uma API abrangente para integrações personalizadas.

- Integração de ferramentas: capacidade de incorporar ferramentas adicionais e gerar chaves de API.

- Instalação rápida: projetada para uma experiência de instalação com apenas um clique.

Prós

- Alta flexibilidade na utilização do LLM.

- Recursos centrados em documentos.

- Uma plataforma com agentes de IA para automatizar tarefas do usuário.

Contras

- Não há suporte para múltiplos usuários.

- Recursos avançados podem ser desafiadores de navegar.

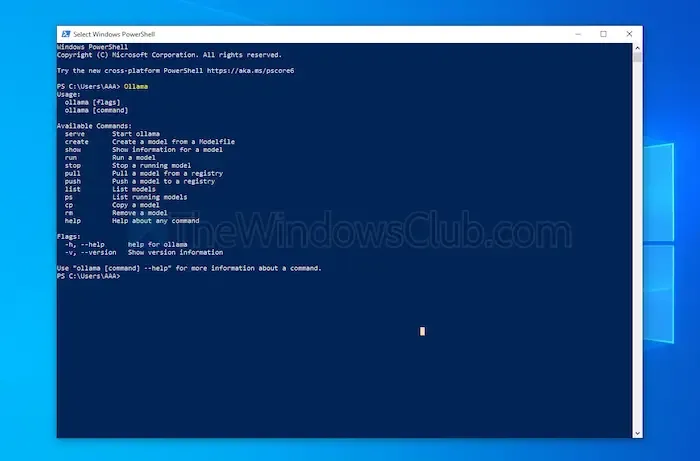

5] Ser

Ollama fornece aos usuários controle completo sobre a criação de chatbots locais sem depender de APIs. Esta ferramenta atualmente se beneficia de contribuições significativas de desenvolvedores, garantindo atualizações e aprimoramentos frequentes para funcionalidade aprimorada. Diferentemente de outras opções discutidas, o Ollama opera por meio de uma interface de terminal para instalações e lançamentos de modelos.

Cada modelo que você instalar pode ter configurações distintas e ajustes de peso, prevenindo quaisquer conflitos de software em sua máquina. Além disso, o Ollama apresenta uma API compatível com OpenAI, permitindo integração sem esforço com qualquer aplicativo que utilize modelos OpenAI.

Características

- Hospedagem de modelos locais: O Ollama permite que você execute grandes modelos de linguagem offline, como Llama e Mistral.

- Personalização do modelo: usuários avançados têm a opção de ajustar os comportamentos do modelo por meio de um Modefile.

- Integração com a API OpenAI: O Ollama inclui uma API REST que se alinha com as ofertas da OpenAI.

- Gerenciamento de recursos: garante o uso eficiente dos recursos da CPU e da GPU para evitar sobrecarga do sistema.

Prós

- Uma coleção robusta de diversos modelos disponíveis.

- Capacidade de importar modelos de bibliotecas como PyTorch.

- Integra-se bem com amplo suporte de biblioteca.

Contras

- Nenhuma interface gráfica de usuário fornecida.

- Requisitos de armazenamento relativamente altos.

Conclusão

Concluindo, as ferramentas LLM locais apresentam uma excelente alternativa aos modelos baseados em nuvem, garantindo privacidade aprimorada e controle total com custos zero envolvidos. Quer você busque usabilidade simples ou opções de personalização extensivas, as ferramentas destacadas atendem a vários níveis de especialização e requisitos.

A seleção da ferramenta certa depende de fatores como capacidades de processamento e compatibilidade, permitindo que você aproveite o poder da IA sem sacrificar a privacidade ou incorrer em taxas de assinatura.

Deixe um comentário