Guia passo a passo para instalar o LLaMA 3 no PC com Windows 11

O Llama 3 representa o mais recente avanço da Meta em grandes modelos de linguagem, ideal para uma ampla gama de aplicações, incluindo responder perguntas, auxiliar em tarefas acadêmicas e muito mais. Ao configurar o Llama 3 no seu dispositivo Windows 11, você pode acessá-lo a qualquer momento, mesmo sem conectividade com a Internet. Este guia demonstrará como configurar o Llama 3 no seu computador Windows 11 .

Instalando o Llama 3 em um computador Windows 11

O processo de instalação do Llama 3 no seu dispositivo Windows 11 usando Python exige um certo nível de proficiência técnica. No entanto, existem métodos alternativos que simplificam a implantação local do Llama 3. Vou descrever essas técnicas.

Para instalar o Llama 3, você precisará executar comandos específicos no Prompt de Comando. Observe que isso só concederá acesso à versão da linha de comando; etapas adicionais são necessárias para utilizar sua interface web. Ambos os processos serão abordados aqui.

Configurando o Llama 3 no Windows 11 via CMD

Primeiro, você deve instalar o Ollama no seu computador Windows para implantar o Llama 3. Siga estas etapas:

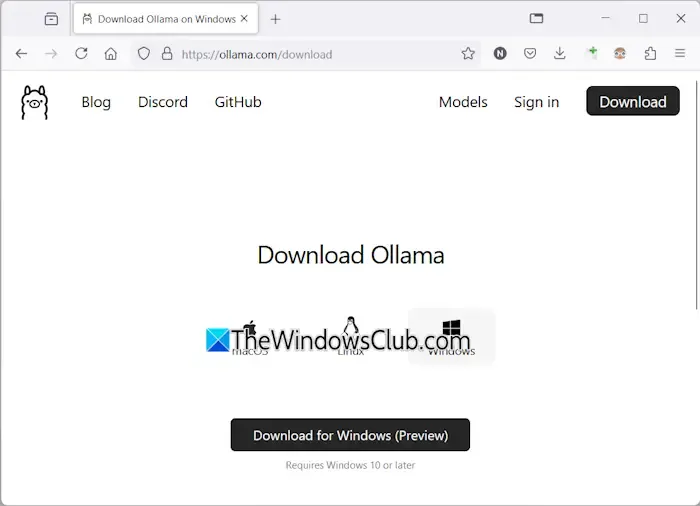

- Navegue até o site oficial do Ollama .

- Selecione a opção Download e escolha Windows .

- Clique em Download para Windows para salvar o arquivo executável no seu computador.

- Execute o arquivo exe baixado para instalar o Ollama no seu dispositivo.

Após o Ollama ser instalado com sucesso, reinicie seu computador. Ele deve estar rodando em segundo plano, visível na Bandeja do Sistema. Então, visite a seção Modelos no site do Ollama para visualizar os modelos disponíveis.

O modelo Llama 3.1 é oferecido em três configurações:

- 8B

- 70B

- 405B

A configuração 405B é a mais exigente e pode não funcionar em uma máquina de baixo custo. O Llama 3.2 fornece duas opções:

- 1B

- 3B

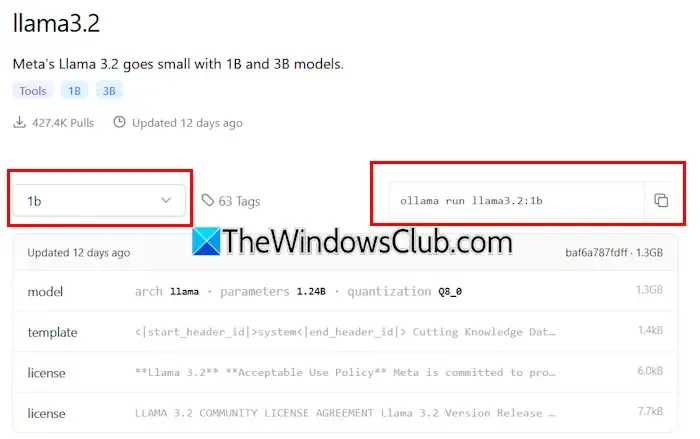

Escolha uma versão do Llama para instalação — se optar pelo Llama 3.2, clique nele. No menu suspenso que se segue, selecione a configuração desejada. Em seguida, copie o comando exibido ao lado dele e cole-o no Prompt de Comando.

Aqui estão os comandos para o modelo Llama 3.2:

ollama run llama3.2:3b

Para instalar a configuração do Llama 3.2 1B, digite:

ollama run llama3.2:1b

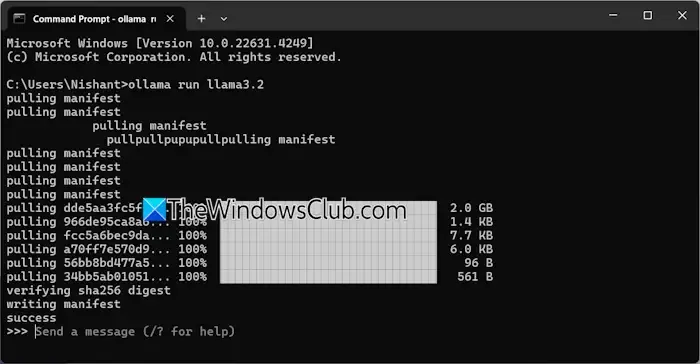

Abra o Prompt de Comando, digite um dos comandos acima de acordo com suas necessidades e pressione Enter . O processo de download levará um tempo, dependendo da sua conexão de internet. Após a conclusão, uma mensagem de sucesso aparecerá no Prompt de Comando.

Você pode então digitar sua entrada para interagir com o modelo Llama 3.2. Para instalar o modelo Llama 3.1, use os comandos disponíveis no site Ollama.

Na próxima vez que você abrir o Prompt de Comando, poderá utilizar o mesmo comando para executar o Llama 3.1 ou 3.2.

Uma limitação da instalação do Llama 3 via CMD é a falta de histórico de bate-papo salvo. No entanto, implantá-lo por meio de um host local permite que seu histórico de bate-papo seja salvo, além de fornecer uma Interface de Usuário aprimorada. A seção a seguir aborda como fazer isso.

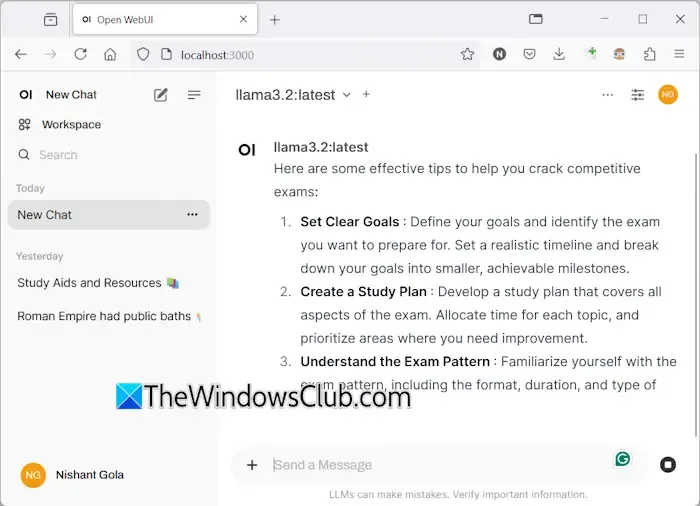

Implantando o Llama 3 com uma interface de usuário da Web no Windows 11

Utilizar o Llama 3 por meio de um navegador da web não só melhora a experiência do usuário, mas também preserva o histórico de bate-papo, um recurso ausente ao usar o CMD. Veja como fazer o Llama 3 rodar no seu navegador da web.

Para acessar o Llama 3 por meio de um navegador da web, certifique-se de que tanto o Llama 3 por meio do Ollama quanto o Docker estejam configurados no seu sistema. Se você não instalou o Llama 3, prossiga com a instalação do Ollama conforme detalhado anteriormente. Em seguida, baixe e instale o Docker do seu site oficial .

Após instalar o Docker, abra-o e conclua o processo de inscrição para criar uma conta, pois o Docker não será iniciado sem ele. Ao fazer login, minimize o Docker para a bandeja do sistema; certifique-se de que o Docker e o Ollama estejam ativos em segundo plano para usar o Llama 3 por meio do seu navegador da web.

Abra o Prompt de Comando, copie o seguinte comando e cole-o:

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

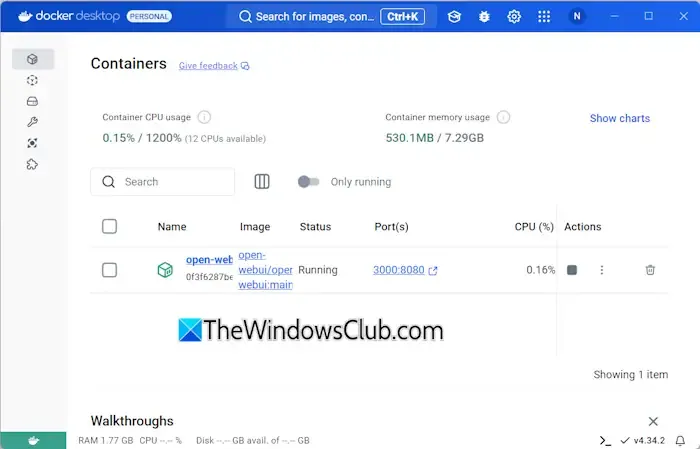

Este comando levará algum tempo para baixar os arquivos necessários, então seja paciente. Após a conclusão, abra o Docker e navegue até a seção Containers no lado esquerdo. Você deverá ver um container criado automaticamente para a porta 3000:8080.

Clique na porta 3000:8080, que iniciará uma nova aba no seu navegador padrão. Você pode precisar se inscrever e fazer login para usar o Llama 3 pelo navegador. Se você verificar a barra de endereço, ela mostrará localhost:3000, indicando que o Llama 3 está hospedado localmente, permitindo o uso sem acesso à internet.

Selecione seu modelo de chat Llama preferido no menu suspenso. Para incorporar modelos de chat Llama 3 adicionais, instale-os via Ollama usando os comandos correspondentes; eles estarão disponíveis no seu navegador.

Seu histórico de bate-papo será salvo e recuperável no lado esquerdo. Quando terminar, saia da sua sessão no navegador da web, abra o Docker e clique no botão Parar para desligá-lo antes de fechar o Docker.

Na próxima vez que você desejar acessar o Llama 3 no seu navegador da web, inicie o Ollama e o Docker, aguarde alguns minutos e clique na porta no contêiner do Docker para iniciar o servidor localhost. Após fazer login, você pode começar a usar o Llama 3.

Espero que esta informação seja útil.

O Llama 3 pode funcionar no Windows?

Sua capacidade de executar o Llama 3 na sua máquina depende das especificações de hardware. A versão mais leve, o modelo 1B, pode ser instalada e operada por meio do prompt de comando.

Qual quantidade de RAM é necessária para o Llama 3?

Para executar o modelo Llama 3.2 1B, seu sistema deve estar equipado com pelo menos 16 GB de RAM, junto com uma GPU robusta. Variantes mais altas do Llama 3 demandarão ainda mais recursos do seu sistema.

Deixe um comentário