Pesquisador ensina GPT-4 a jogar DOOM e matar tudo que estiver à vista

Todos nós conhecemos o jogo de tiro DOOM de 1993 e, naquela época, qualquer hardware era testado com a pergunta: Será que ele jogará DOOM? O Register identificou um projeto de estudante que prova a capacidade do GPT-4 de jogar o jogo antigo.

Adrian de Wynter, principal cientista aplicado da Microsoft e pesquisador da Universidade de York, na Inglaterra, desenvolveu um método para testar se as capacidades de raciocínio e planejamento do GPT-4 se estendem ao jogo de tiro em primeira pessoa Doom, de 1993. Acontece que sim, o bot pode executá-lo e reproduzi-lo, mas você pode vencê-lo facilmente.

Como o GPT-4 pode executar o DOOM?

Na verdade, é mais complicado porque o GPT-4 LLM não pode executar o código do DOOM diretamente, mas sua variante, GPT-4V, também pode trabalhar com imagens e jogar sem nenhum treinamento especial.

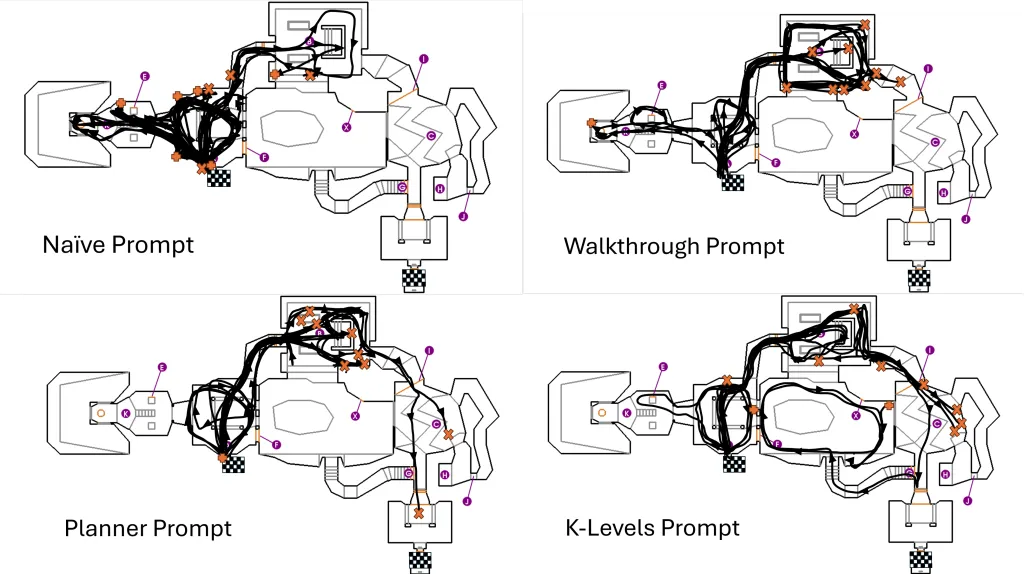

Então, de Winter usou o GPT-4V para obter as capturas de tela do jogo, junto com as descrições da estrutura. Então, um modelo de Agente pode tomar decisões com base na entrada visual e no histórico anterior. Os comandos do jogo são enviados de volta e traduzidos em teclas digitadas.

Isso torna o modelo bastante lento e lento para jogar, mas também tem outros problemas:

Assim, o GPT-4V simplesmente se esquece dos inimigos se eles saírem de vista, o que pode ser um problema hilário mesmo para o jogador humano mais inexperiente.

Mas o problema aqui não são as fracas habilidades do bot em matar monstros em um jogo, mas as ramificações éticas da programação:

Em outras palavras, a IA ficou mais do que feliz em seguir as instruções para atirar em alvos sem fazer perguntas. Embora possa ser divertido ver uma IA jogando um jogo e tomando suas próprias decisões para completar seus objetivos de programação, a conclusão do pesquisador é que o bot não tem ideia do que está fazendo.

Afinal, essa programação poderia ser usada em cenários reais para drones automatizados que poderiam produzir danos reais.

O que você acha do GPT-4 jogando DOOM? Vamos falar sobre isso na seção de comentários abaixo.

No departamento de ética, é bastante preocupante como foi fácil para (a) eu construir código para fazer o modelo fotografar algo; e (b) para o modelo fotografar algo com precisão, sem realmente questionar as instruções,

Adriano de Wynter

Por exemplo, seria muito comum o modelo ver um zumbi na tela, e começar a atirar nele até acertá-lo (ou morrer). Qual é o problema aqui? Bem, primeiro o zumbi sai de vista. Pior, ainda está vivo e irá bater em você em algum momento. Então você tem que ir atrás, certo? Afinal, em Doom, é bater ou ser derrotado. Acontece que o GPT-4 se esquece do zumbi e segue em frente. Nota: o prompt diz explicitamente ao modelo o que fazer se estiver sofrendo danos e não puder ver um inimigo. Melhor ainda, ele simplesmente segue seu caminho alegre, fica preso em um canto e morre. Ele girou algumas vezes, mas em quase 50-60 corridas, eu observei… duas vezes, quero dizer.

Adriano de Wynter

Deixe um comentário