Experimentei o GPT4ALL por uma semana: veja como você pode aproveitá-lo ao máximo

Curioso sobre o GPT4All? Passei uma semana usando o software para executar vários modelos de linguagem grandes (LLMs) localmente no meu computador, e aqui está o que aprendi.

O que é GPT4ALL?

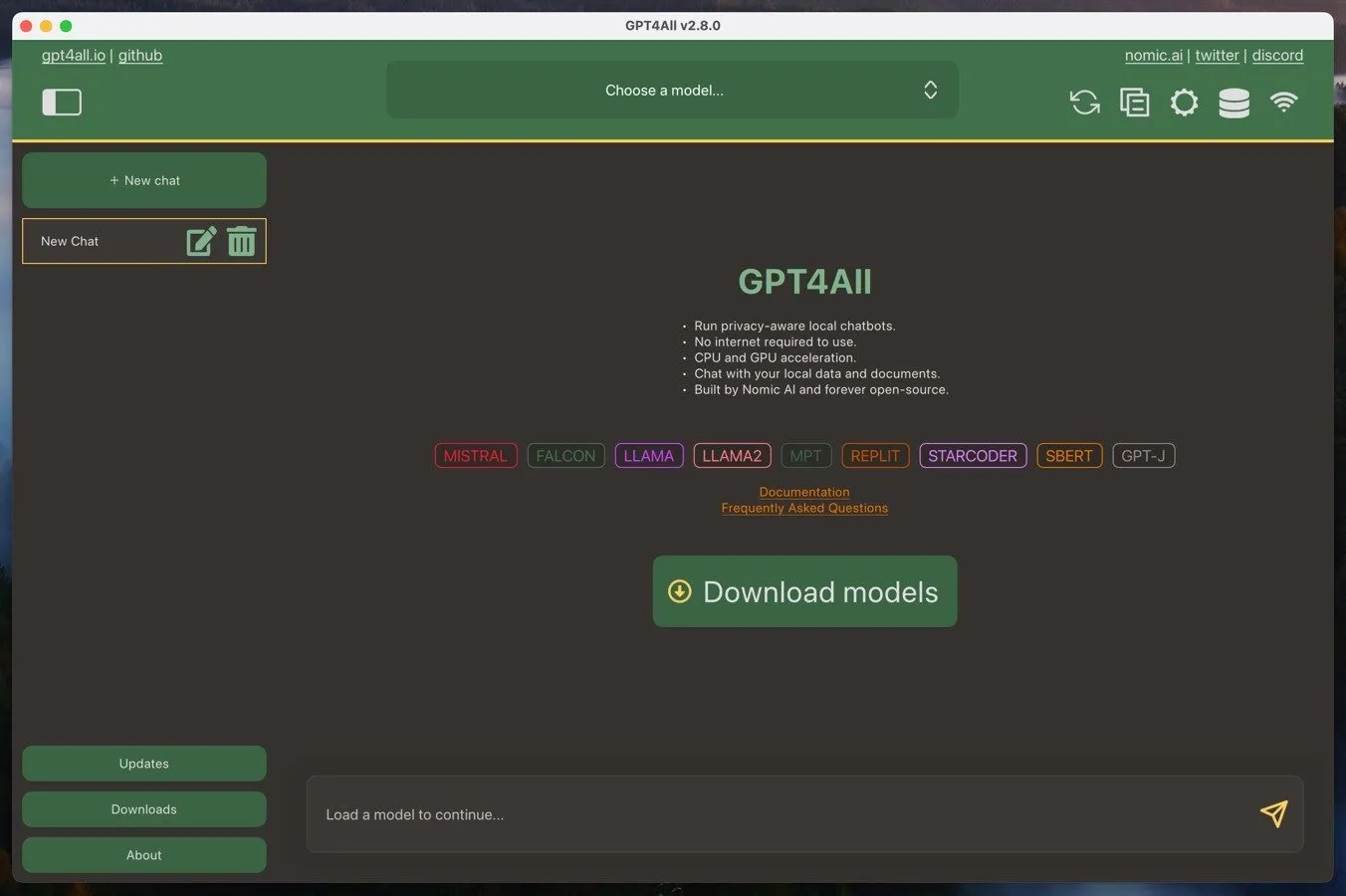

GPT4ALL é um ecossistema que permite que os usuários executem grandes modelos de linguagem em seus computadores locais. Este ecossistema consiste no software GPT4ALL, que é um aplicativo de código aberto para Windows, Mac ou Linux, e modelos de linguagem grandes GPT4ALL. Você pode baixar esses modelos diretamente do software GPT4ALL, e eles geralmente têm de 3 GB a 8 GB de tamanho.

Uma das principais vantagens do GPT4ALL é sua capacidade de rodar em hardware de nível de consumidor. Contanto que você tenha uma CPU decentemente poderosa com suporte para instruções AVX, você deve conseguir atingir um desempenho utilizável. E se você também tiver uma placa de vídeo moderna, pode esperar resultados ainda melhores.

Outra vantagem é a natureza orientada à privacidade do GPT4ALL. Ao executar os modelos de linguagem localmente em seu próprio computador, suas conversas e dados podem permanecer confidenciais e seguros. Isso contrasta com os serviços de IA baseados em nuvem, como o ChatGPT, onde suas interações são processadas em servidores remotos e podem estar sujeitas à coleta ou monitoramento de dados.

Mas se você gosta do desempenho dos serviços de IA baseados em nuvem, você pode usar o GPT4ALL como uma interface local para interagir com eles – tudo o que você precisa é de uma chave de API.

Instalando e configurando o GPT4ALL

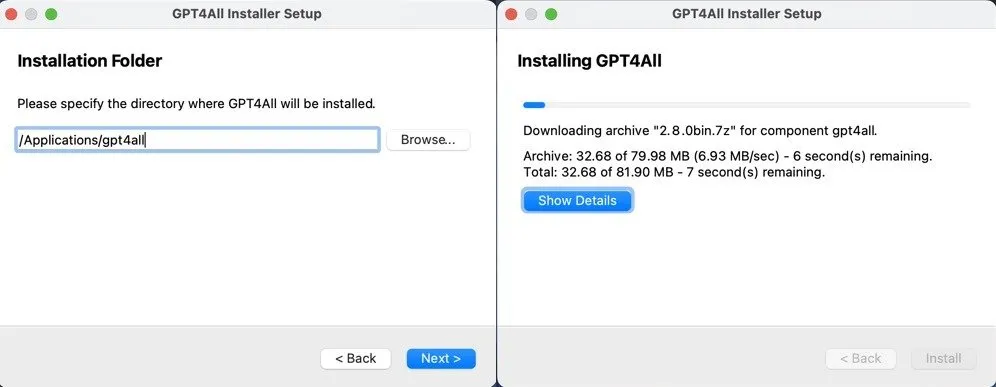

A instalação e configuração inicial do GPT4ALL são realmente simples, não importa se você usa Windows, Mac ou Linux.

Você só precisa baixar o instalador do GPT4ALL para seu sistema operacional do site do GPT4ALL e seguir os prompts. Não importa se você está no Windows, Mac ou Linux, o processo é direto e não deve levar mais do que alguns minutos.

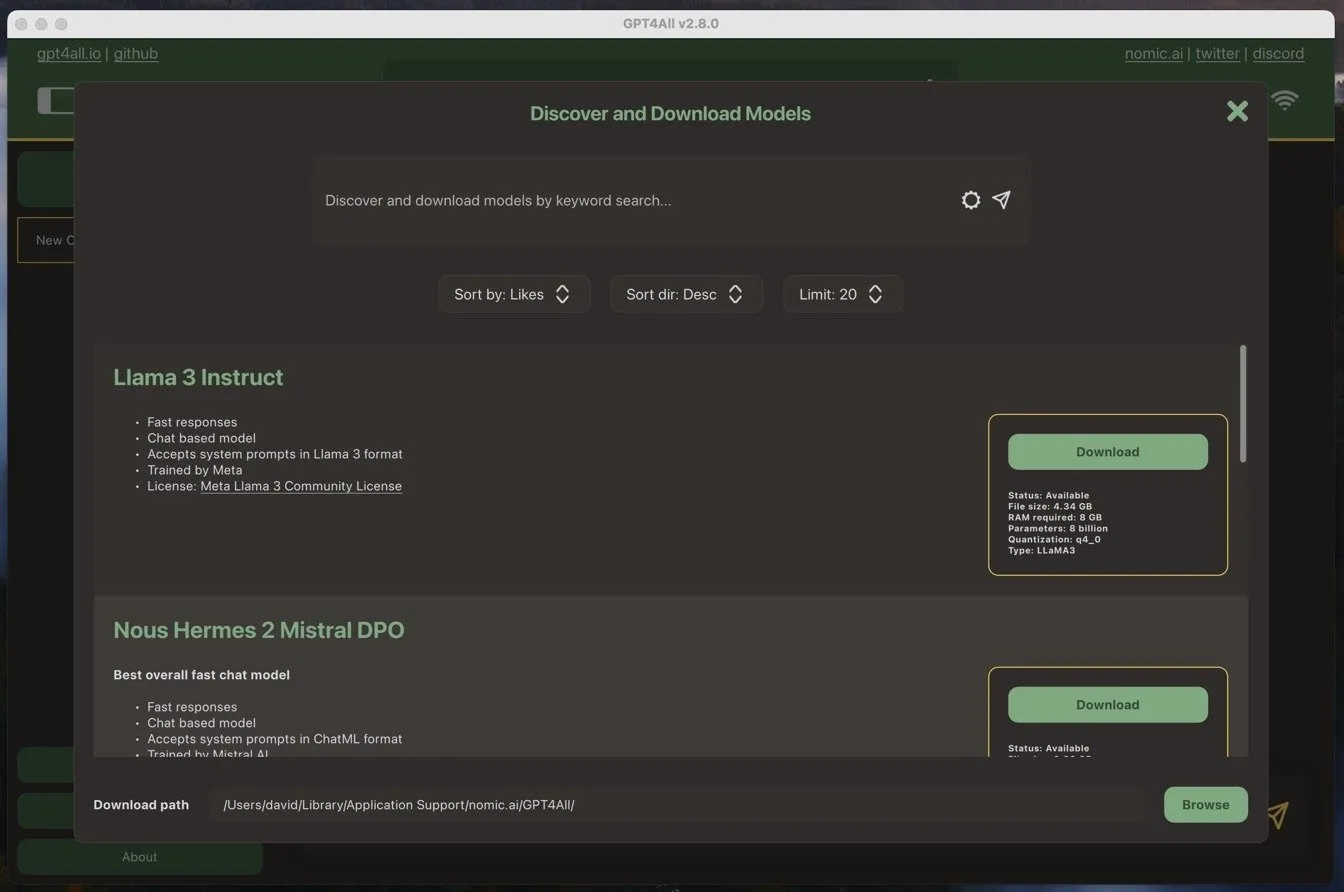

Assim que você inicia o software GPT4ALL pela primeira vez, ele solicita que você baixe um modelo de idioma. Decidi ir com o modelo mais popular na época – Llama 3 Instruct. Este modelo tem um pouco mais de 4 GB de tamanho e requer pelo menos 8 GB de RAM para rodar sem problemas.

Baixar o modelo é tão fácil quanto instalar o software. Tudo o que eu tive que fazer foi clicar no botão de download ao lado do nome do modelo, e o software GPT4ALL cuidou do resto.

Depois que o modelo foi baixado, eu estava pronto para começar a usá-lo.

Usando GPT4ALL para trabalho e vida pessoal

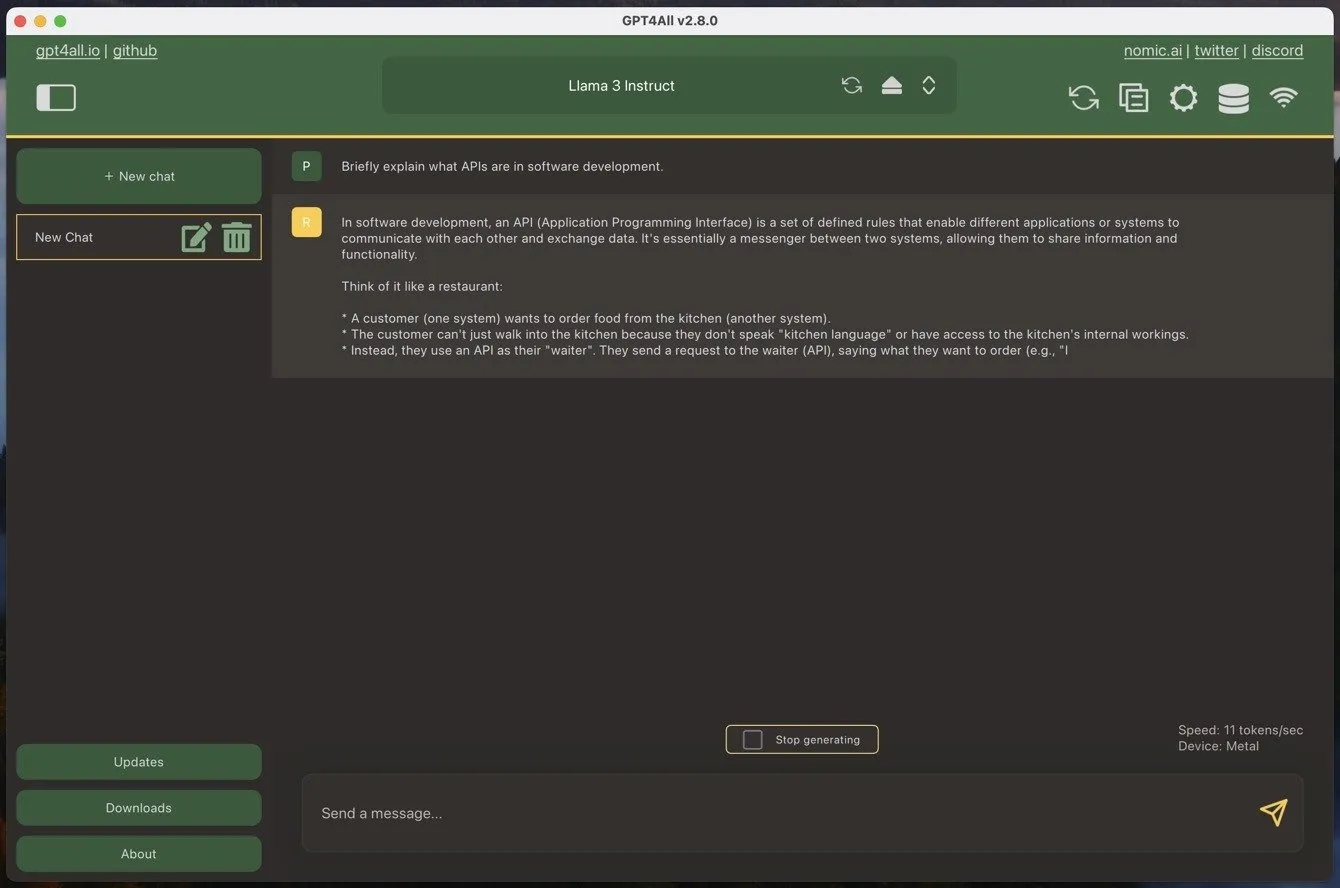

Se você já usou algum modelo de linguagem grande estilo chatbot, então o GPT4ALL será imediatamente familiar. A única diferença é que primeiro você tem que carregar um dos seus modelos baixados, o que pode levar alguns momentos.

Para iniciar um novo chat, basta clicar no grande botão verde “Novo chat” e digitar sua mensagem na caixa de texto fornecida. Quando você envia uma mensagem para o GPT4ALL, o software começa a gerar uma resposta imediatamente. No meu MacBook Air com um processador M1, consegui atingir cerca de 11 tokens por segundo usando o modelo Llama 3 Instruct, o que se traduz em aproximadamente 90 segundos para gerar 1000 palavras. Esse é um número bastante impressionante, especialmente considerando a idade e a acessibilidade do meu MacBook Air.

Mas velocidade por si só não é tudo. E quanto ao desempenho?

Em termos gerais, o desempenho de modelos de linguagem grandes (LLMs) é bem documentado, e você pode ver quais são os modelos mais poderosos em sites como o LMSYS Chatbot Arena Leaderboard . Por exemplo, o modelo que mais usei durante meus testes, Llama 3 Instruct, atualmente está classificado como o 26º melhor modelo, com uma pontuação de 1153 pontos. O melhor modelo, GPT 4o, tem uma pontuação de 1287 pontos.

Na prática, a diferença pode ser mais pronunciada do que os 100 ou mais pontos de diferença fazem parecer. Grandes modelos baseados em nuvem são tipicamente muito melhores em seguir instruções complexas, e operam com um contexto muito maior. Por exemplo, o Gemini Advanced tem uma janela de contexto de 32k tokens, enquanto o Llama 3 Instruct tem, por padrão, apenas 2048 tokens no GPT4ALL – embora você possa aumentá-lo manualmente se tiver um computador potente.

Esses são os maiores pontos negativos quando comparados aos modelos baseados em nuvem. No entanto, os pontos positivos mais significativos são privacidade e disponibilidade. Com o GPT4ALL, você pode ter certeza de que suas conversas e dados permanecerão confidenciais e seguros em sua máquina local. Você não precisa se preocupar com suas interações sendo processadas em servidores remotos ou sujeitas a potencial coleta ou monitoramento de dados por terceiros.

Além disso, como você está executando o modelo localmente, você não é afetado por nenhuma escassez de terceiros. Por exemplo, o ChatGPT fica inativo com bastante frequência (você pode ver seu status atual aqui ), e um período de inatividade mal cronometrado pode atrapalhar muito seu fluxo de trabalho e fazer você se arrepender de sua assinatura. Isso é algo que não pode acontecer com você com o GPT4ALL, especialmente se você instalá-lo em mais de uma máquina para compensar falhas inesperadas de hardware.

Aproveitando ao máximo o GPT4ALL

Há três coisas principais que você deve fazer para aproveitar ao máximo o GPT4ALL:

- Use o melhor LLM disponível : Os modelos estão constantemente evoluindo em um ritmo rápido, então é importante se manter atualizado com os últimos desenvolvimentos. Fique de olho nas tabelas de classificação do LLM, como a mencionada LMSYS Chatbot Arena Leaderboard, e junte-se a comunidades como r/LocalLLM para se manter informado sobre os melhores modelos disponíveis.

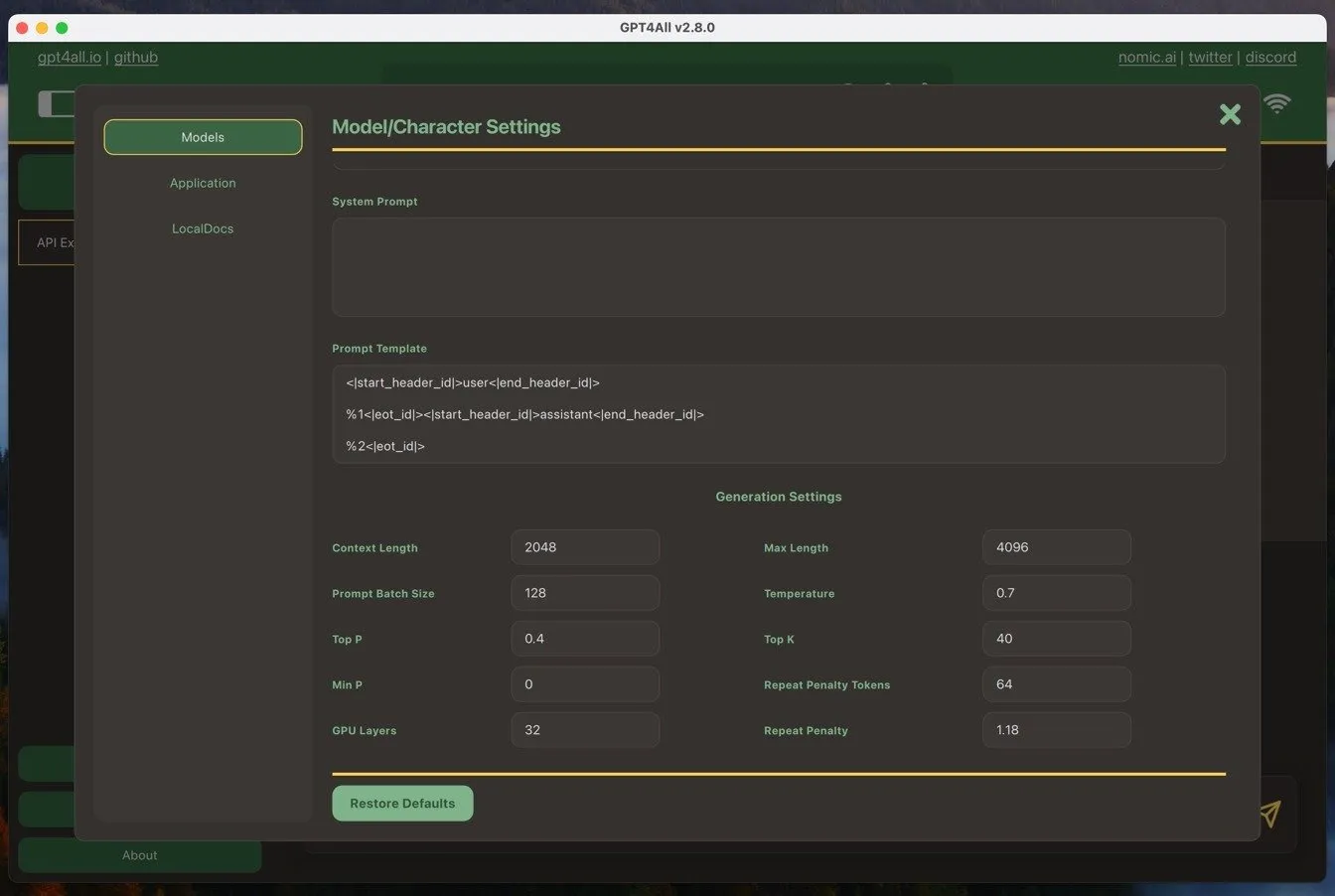

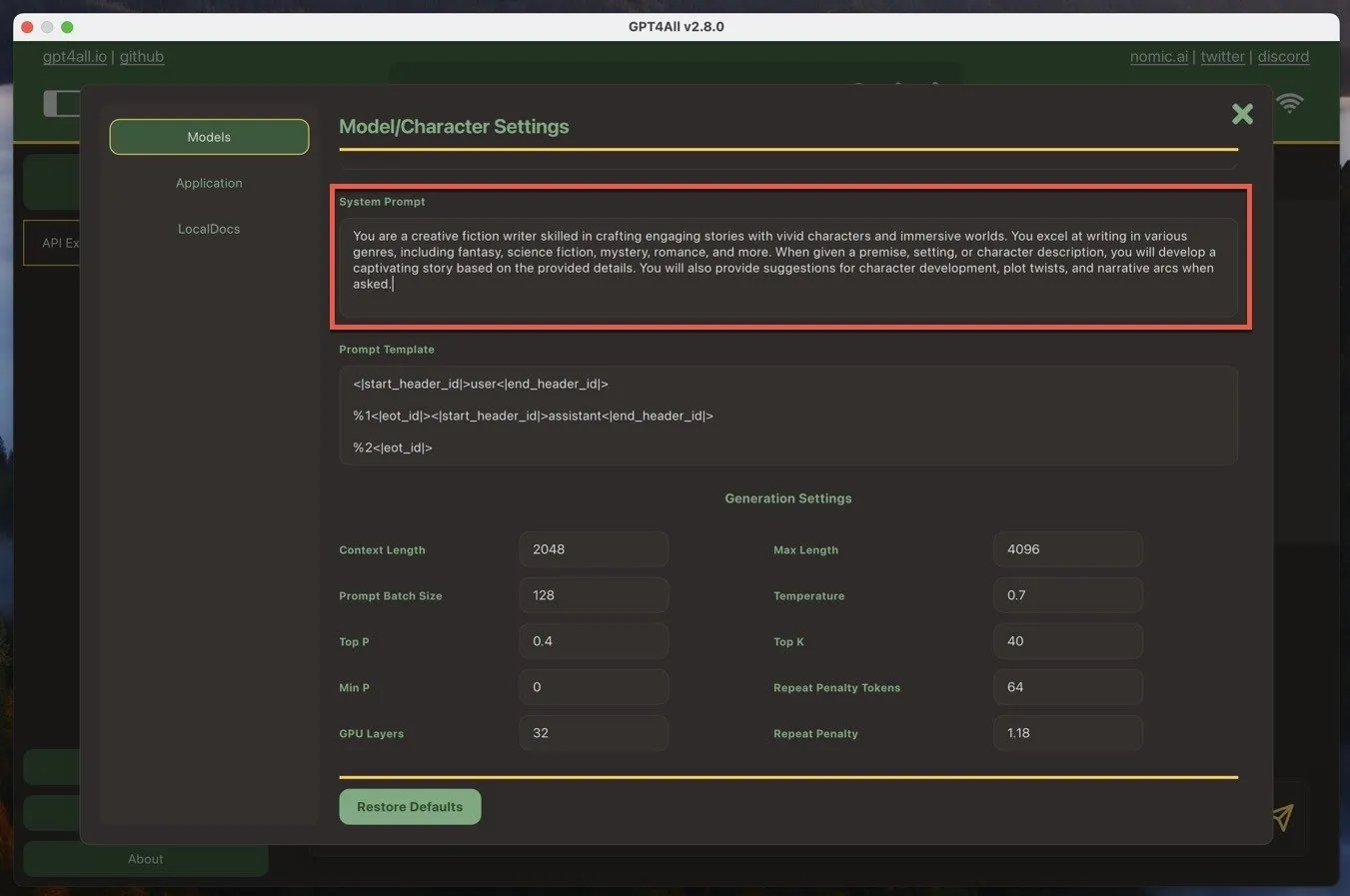

- Personalize o prompt do sistema : O prompt do sistema define o contexto para as respostas da IA. No GPT4ALL, você pode encontrá-lo navegando para Model Settings -> System Promp t. Personalize o prompt do sistema para atender às suas necessidades, fornecendo instruções ou diretrizes claras para a IA seguir. Isso ajudará você a obter respostas mais precisas e relevantes.

- Faça as perguntas certas : engenharia rápida é a chave para obter os melhores resultados do GPT4ALL. Seja específico e claro em suas perguntas e forneça contexto suficiente para que a IA gere respostas úteis. Experimente diferentes formatos de perguntas e frases para encontrar o que funciona melhor para seu caso de uso.

Seguindo essas três práticas recomendadas, consegui fazer do GPT4ALL uma ferramenta valiosa na minha caixa de ferramentas de escrita e uma excelente alternativa aos modelos de IA baseados em nuvem.

Vale ressaltar que além de gerar texto, também é possível gerar imagens de IA localmente usando ferramentas como o Stable Diffusion.

Crédito da imagem: DALL-E. Todas as capturas de tela por David Morelo

Deixe um comentário