Como executar seu próprio LLM local em um Raspberry Pi

Desde o lançamento alucinante do ChatGPT 3 pela OpenAI no final de 2022, os Large Language Models (LLMs) capturaram a imaginação do mundo ao demonstrar capacidades notáveis, desde escrever ensaios até responder a perguntas complexas.

No entanto, você não precisa depender de empresas como OpenAI, Google ou Anthropic e compartilhar dados potencialmente pessoais para aproveitar o poder dos LLMs. Com apenas um Raspberry Pi acessível, você pode configurar seu próprio assistente local baseado em bate-papo com IA. Este guia mostra como.

O que você precisará

Para configurar seu próprio LLM em um Raspberry Pi, você precisará de alguns componentes essenciais:

- Raspberry Pi : como os LLMs consomem muitos recursos, é melhor usar o Raspberry Pi mais poderoso disponível para obter o desempenho ideal. No momento em que este artigo foi escrito, o Raspberry Pi 5 com 8 GB de RAM era a escolha recomendada.

- Cartão microSD com Raspberry Pi OS: Para desempenho máximo, considere usar a versão lite do Raspberry Pi OS, pois uma interface gráfica de usuário não é necessária para executar um LLM (você pode interagir com ele remotamente usando um terminal e SSH). No entanto, se estiver usando o Raspberry Pi para outras tarefas ou como computador principal, você pode usar a versão normal do Raspberry Pi OS.

- Componentes adicionais : Além do Raspberry Pi e de um cartão microSD rápido, você precisará de uma fonte de alimentação confiável (recomenda-se a oficial), teclado, mouse e monitor para configuração inicial (opcional se estiver usando SSH), e uma conexão com a Internet para baixar software e modelos necessários.

Com esses componentes em mãos, você está pronto para começar a configurar seu próprio LLM no Raspberry Pi.

Instalar Ollama

O primeiro passo para configurar seu próprio LLM em um Raspberry Pi é instalar o software necessário. Atualmente, as duas opções mais populares para executar LLMs localmente são llama.cpp e Ollama.

- llama.cpp é uma implementação C++ leve do LLaMA (Large Language Model Adapter) da Meta que pode ser executada em uma ampla variedade de hardware, incluindo Raspberry Pi. Foi desenvolvido por Georgi Gerganov e lançado em março de 2023.

- Ollama , por outro lado, é construído em torno do llama.cpp, oferecendo vários recursos fáceis de usar. Ele lida automaticamente com solicitações de chat de modelo no formato que cada modelo espera e carrega e descarrega modelos sob demanda com base na solicitação do cliente. Ollama também gerencia modelos de download e armazenamento em cache, incluindo modelos quantizados, para que você possa solicitá-los por nome.

Para este guia, usaremos o Ollama devido à sua facilidade de uso e recursos extras.

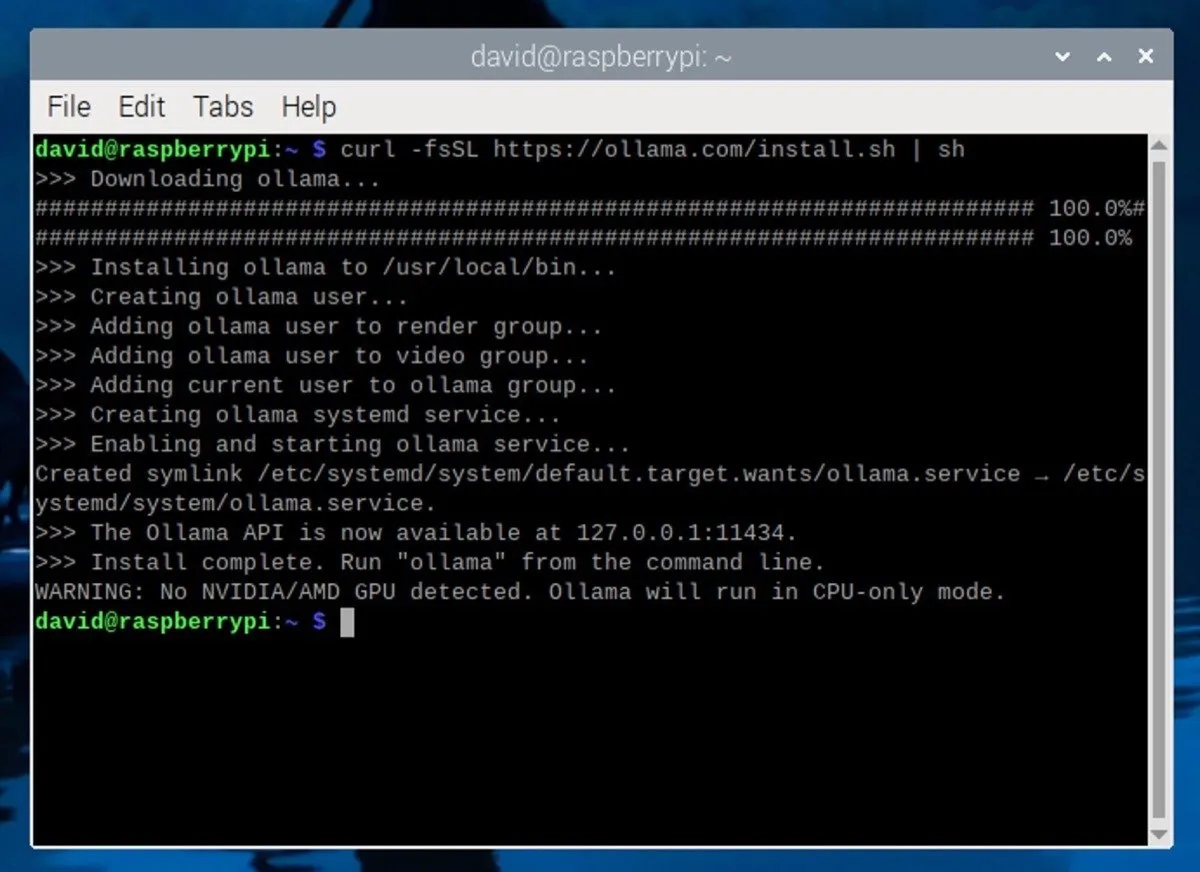

Para instalar o Ollama no seu Raspberry Pi, abra uma janela de terminal no seu Raspberry Pi. Se você estiver usando SSH, conecte-se ao Raspberry Pi usando o cliente SSH de sua preferência. Em seguida, digite o seguinte comando no terminal:

Este comando baixa e executa o script de instalação do site oficial do Ollama. O script instalará automaticamente as dependências necessárias e configurará o Ollama em seu Raspberry Pi.

Baixe e execute um LLM

Com o Ollama instalado, é hora de baixar um modelo de linguagem grande. Se você estiver usando um Raspberry Pi com 8 GB de RAM, poderá executar modelos com até 7 bilhões de parâmetros (as configurações que a IA usa para determinar suas saídas).

Algumas escolhas populares incluem Mistral (7B), Gemma (7B ou 2B), Llama 2 sem censura (7B) ou Phi-3 da Microsoft (3,8B). Você pode visualizar todos os modelos suportados na página da biblioteca Ollama .

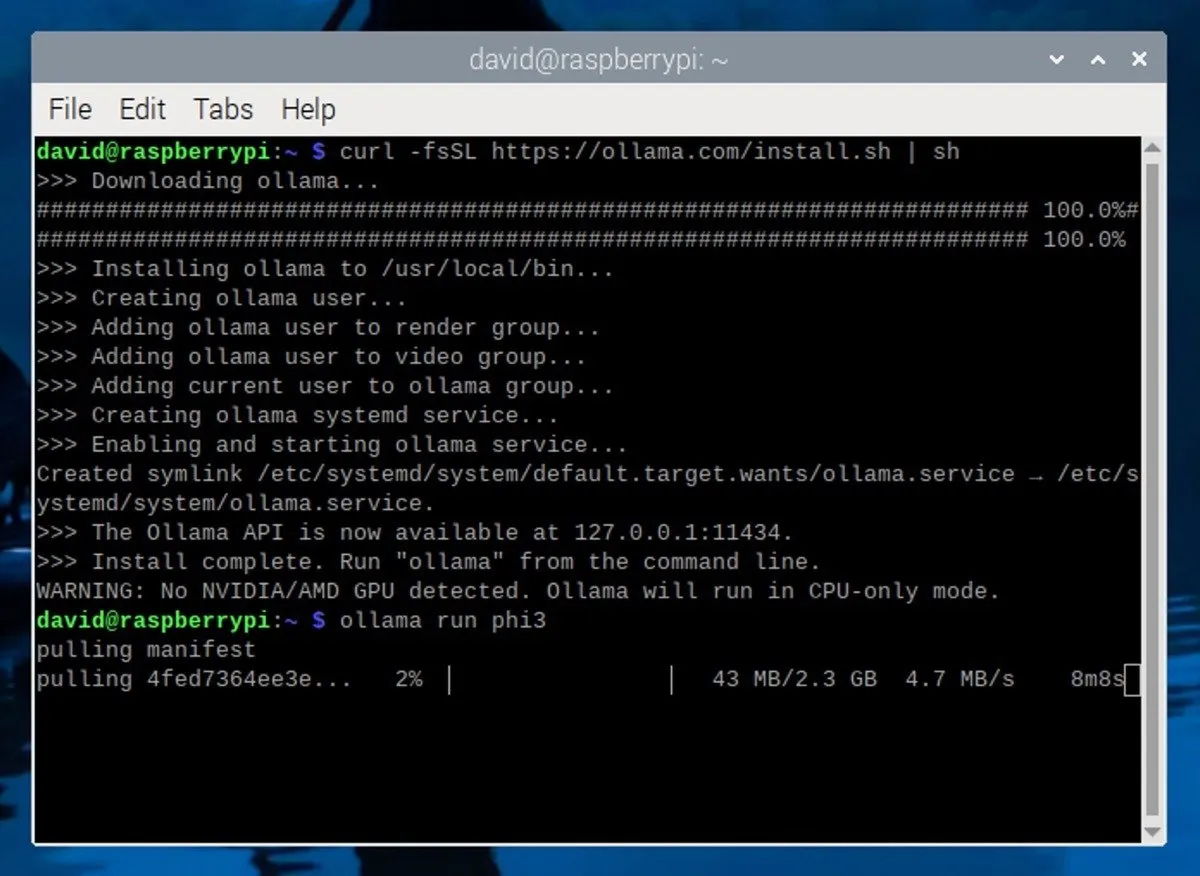

Para este guia, usaremos o modelo Phi-3 da Microsoft . Apesar do seu pequeno tamanho e eficiência, o Phi-3 é um modelo extremamente capaz. Para instalá-lo, basta executar o seguinte comando no terminal:

Este comando baixará e instalará o modelo Phi-3 e também iniciará automaticamente uma sessão de chat interativo com o modelo.

Usando um LLM local em seu Raspberry Pi

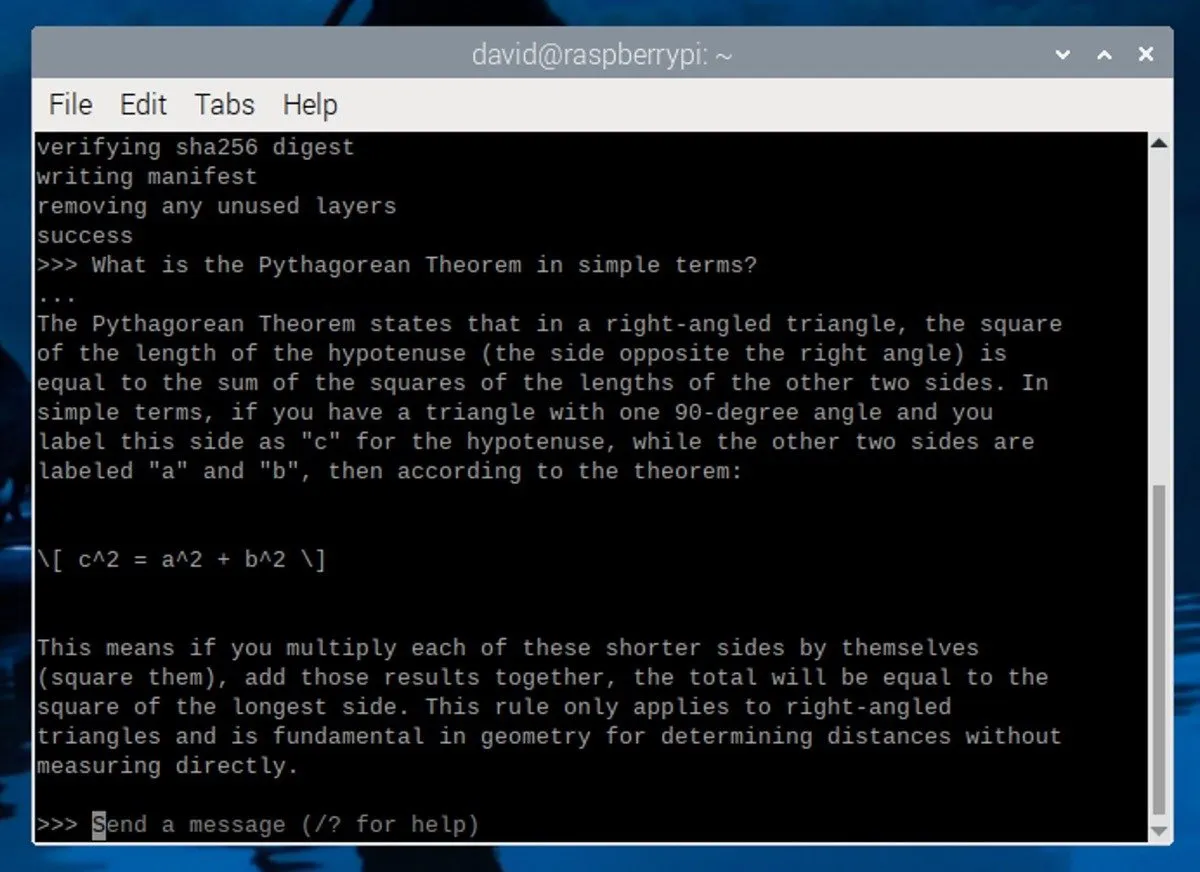

Depois de baixar e instalar o modelo Phi-3, você verá um prompt no terminal semelhante a este:

Isso significa que o LLM está em execução e aguardando sua entrada. Para começar a interagir com o modelo, digite sua mensagem e pressione Enter.

Aqui estão algumas dicas para criar prompts eficazes:

- Seja específico : forneça instruções ou perguntas claras e detalhadas para ajudar o LLM a entender o que você está procurando.

- Defina o contexto : forneça ao LLM algumas informações básicas ou um cenário para ajudá-lo a gerar respostas mais relevantes.

- Definir funções : Especifique a função que o LLM deve assumir em sua resposta, como contador de histórias, professor ou especialista técnico.

Para encerrar a sessão LLM, pressione Ctrl+ dou digite o /byecomando. Se desejar iniciar outra sessão posteriormente, basta abrir um novo terminal e executar o ollama run phi3comando. Como o modelo já foi baixado, ele será inicializado rapidamente sem a necessidade de download novamente.

Tenha em mente que o desempenho do Raspberry Pi 5 tem limites e ele só pode gerar alguns tokens por segundo. Para melhor desempenho, considere executar o Ollama em um computador mais potente com uma placa gráfica dedicada.

Crédito da imagem: Unsplash . Capturas de tela de David Morelo.

Deixe um comentário