Como executar o Llama 3 da Meta AI localmente

O que saber

- O grande modelo de linguagem do Meta, Llama 3, está disponível para download e execução local em seu sistema.

- Baixe Meta Llama 3 em Llama.meta.com e use uma estrutura LLM como LM Studio para carregar o modelo.

- Você também pode pesquisar e baixar o Meta Llama 3 no próprio LM Studio. Consulte o guia abaixo para obter instruções detalhadas sobre o mesmo.

O mais recente modelo de linguagem da Meta, Llama 3, está aqui e disponível gratuitamente. Embora você possa usar o Meta AI, que executa o mesmo LLM, também existe a opção de baixar o modelo e executá-lo localmente em seu sistema.

Como executar o Llama 3 da Meta AI localmente

Embora o Meta AI esteja disponível apenas em países selecionados, você pode baixar e executar o Llama 3 localmente no seu PC, independentemente da sua região. Siga as etapas abaixo para executar o Llama 3 da Meta AI localmente.

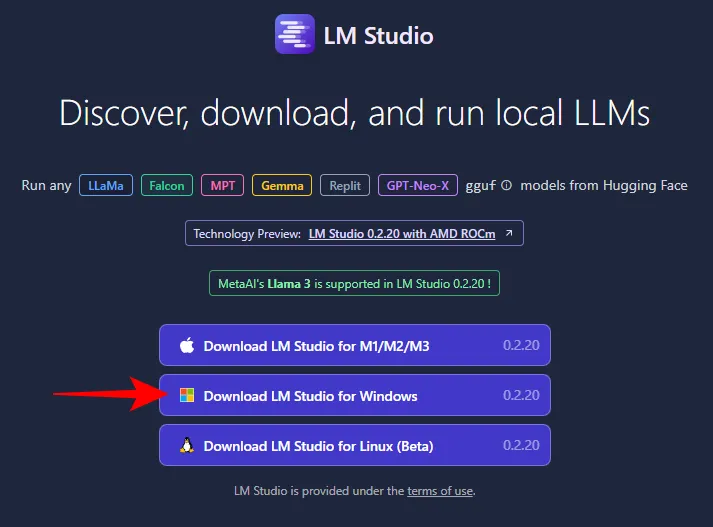

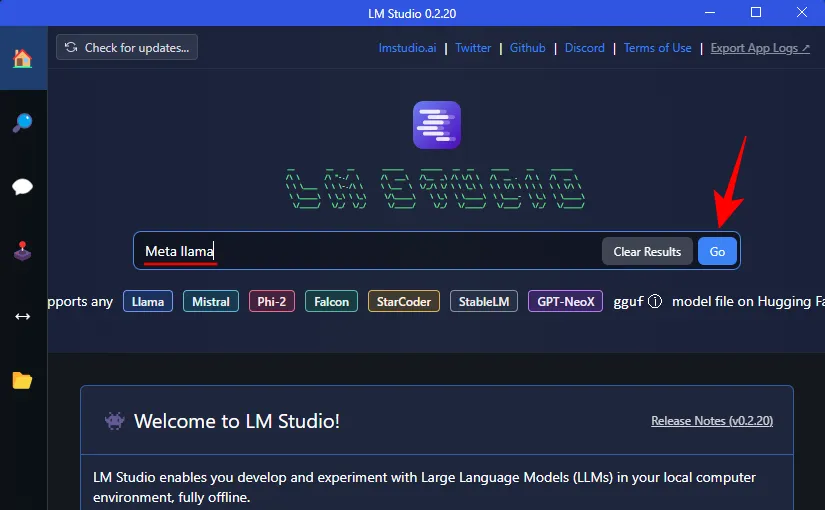

Passo 1: Instale o LM Studio

Primeiramente, vamos instalar um framework para rodar o Llama 3. Se você já possui outro aplicativo desse tipo em seu sistema, pode pular para a próxima etapa. Para todos os outros, veja como obter o estúdio LM:

- Estúdio LM | Link para Download

- Use o link acima e clique em LM Studio para Windows para fazer o download.

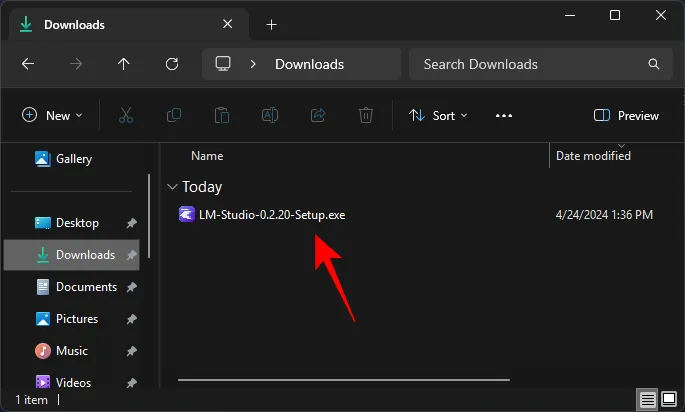

- Depois de baixado, execute o instalador e deixe o LM Studio instalar.

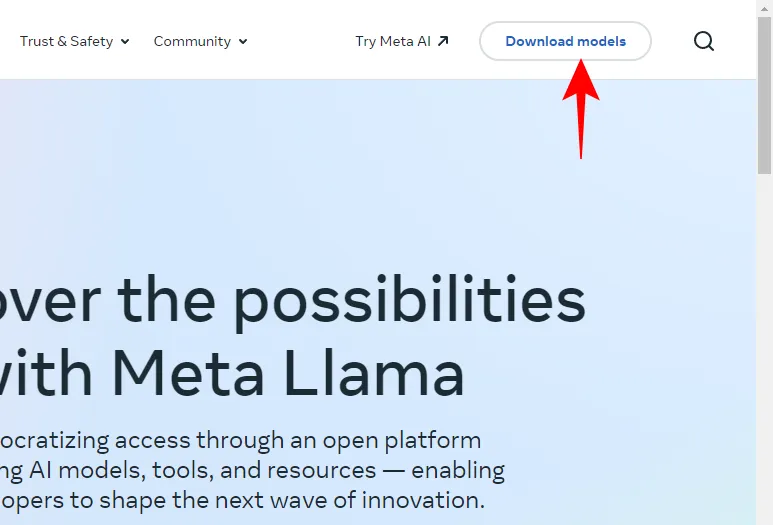

Etapa 2: Baixe o Meta’s Llama 3 localmente

Depois de ter sua estrutura LLM, é hora de baixar o Meta’s Llama 3 para o seu PC. Existem algumas maneiras de fazer isso.

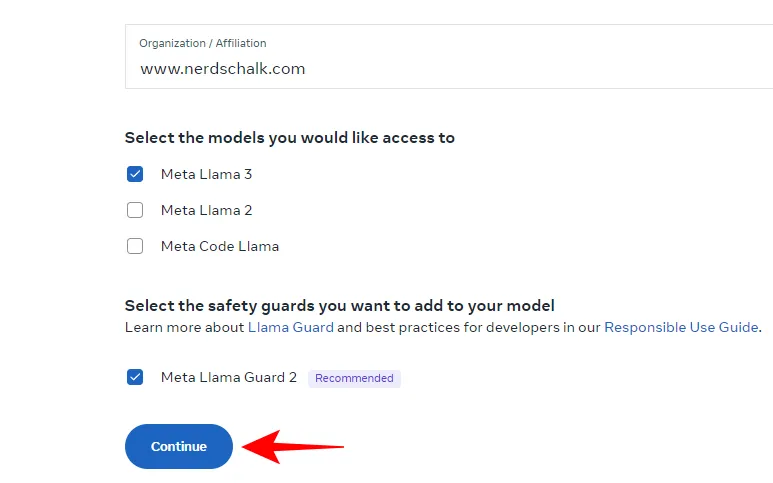

- Abra Llama.Meta.com e clique em Baixar modelos .

- Insira seus dados e solicite o download do LLM.

Se o acima mencionado não funcionar, não se preocupe. Você também pode usar sua estrutura LLM para baixar o LLM.

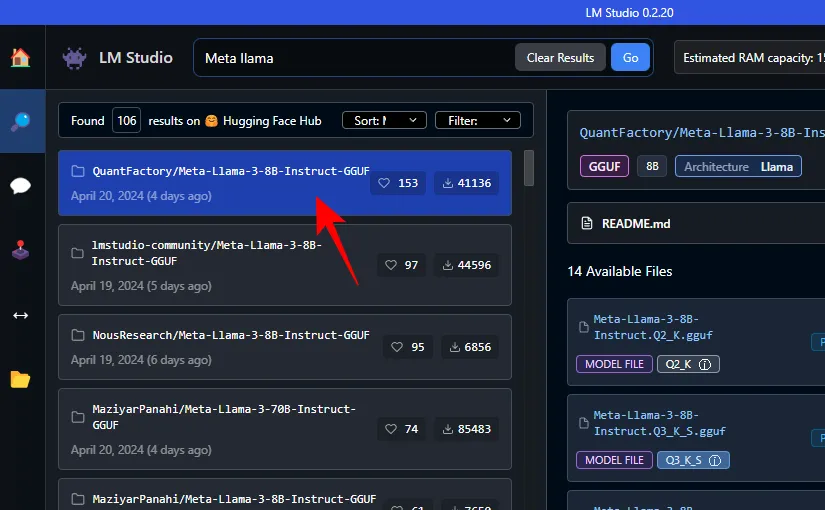

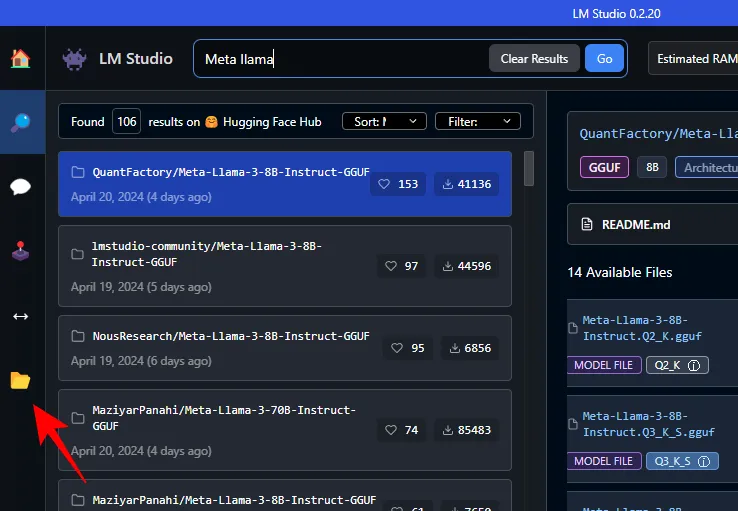

- Basta pesquisar Meta Llama no campo de pesquisa do LM Studio.

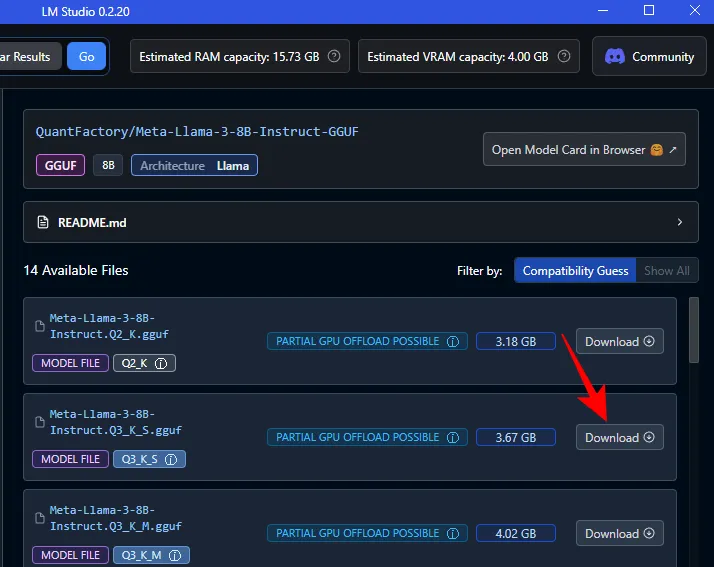

- Aqui, você encontrará vários LLMs quantizados. Selecione um.

- À direita, selecione sua versão preferida. Clique em Baixar ao lado dele.

- Aguarde o download terminar.

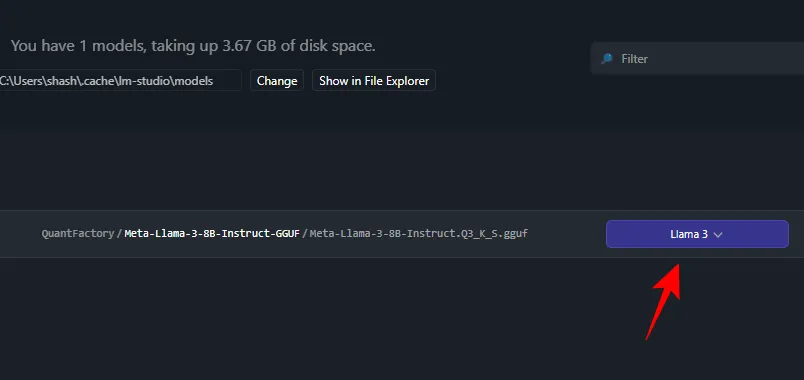

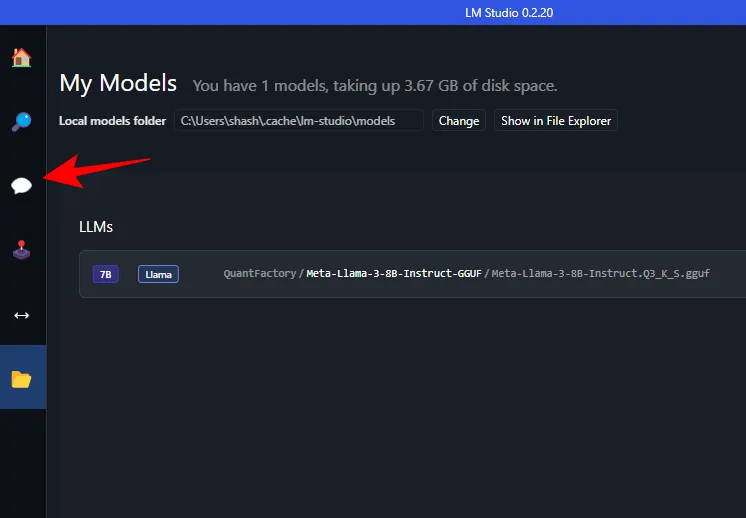

- Quando terminar, clique em Meus modelos à esquerda.

- E verifique se o download foi concluído.

Etapa 3: carregue o modelo baixado

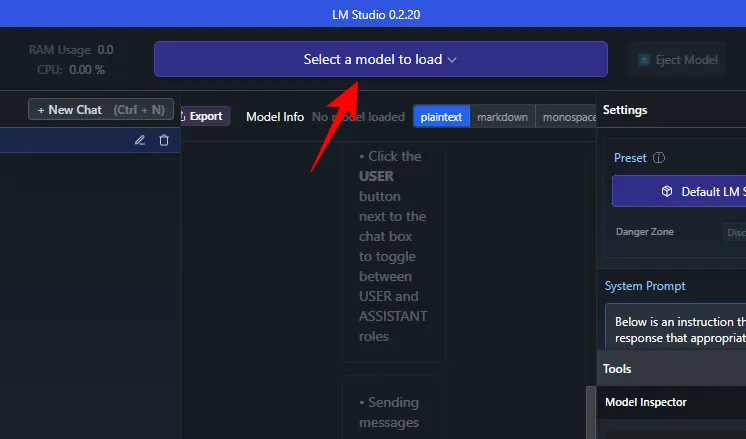

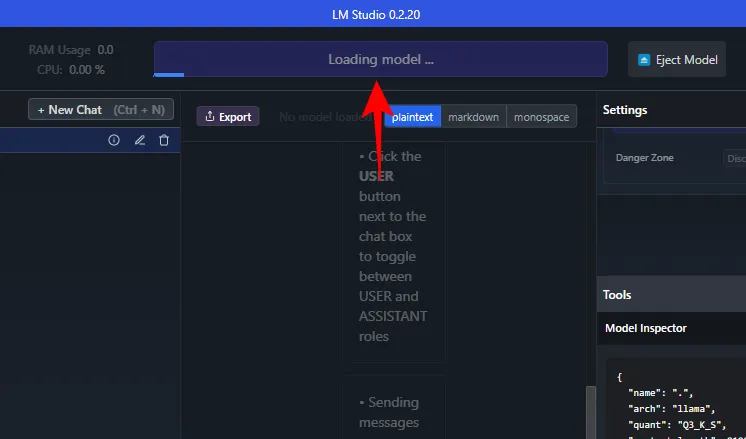

- Assim que o download for concluído, clique em AI chat à esquerda.

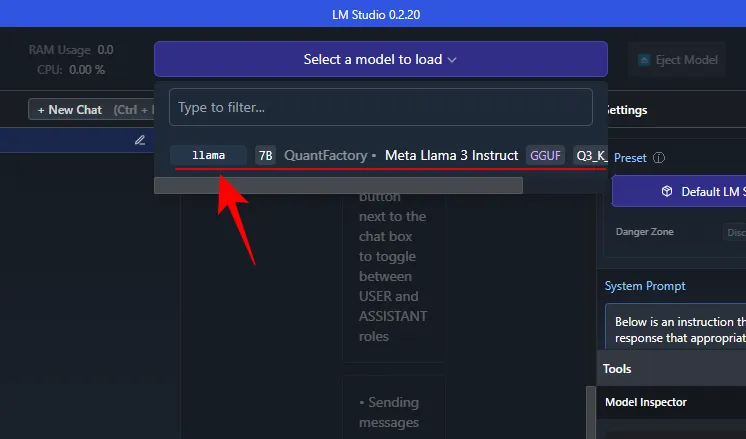

- Clique em Selecione um modelo para carregar .

- E escolha o Meta Llama 3 baixado.

- Aguarde o modelo carregar.

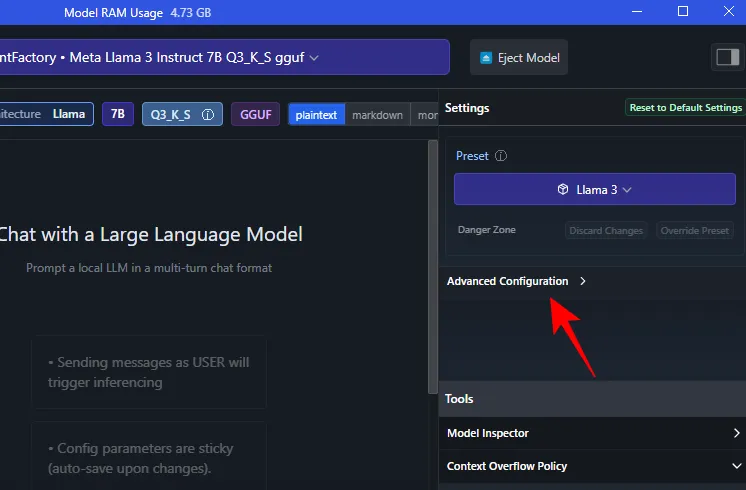

- Depois de carregado, você pode descarregar o modelo inteiro para a GPU. Para fazer isso, clique em Configuração Avançada em ‘Configurações’.

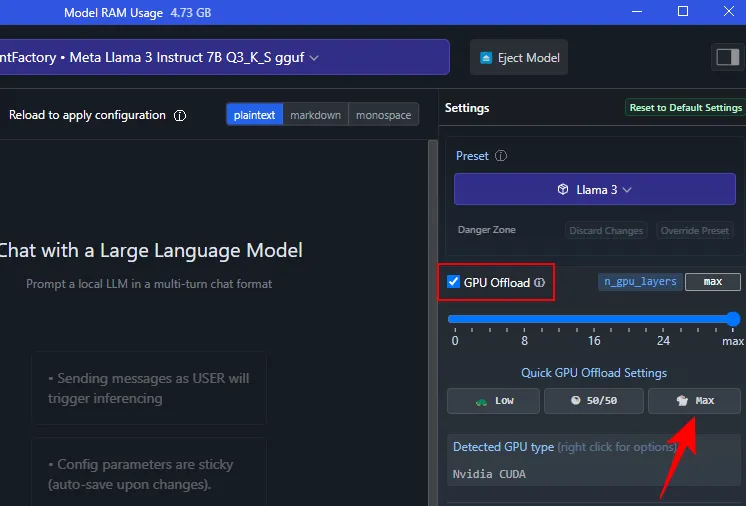

- Clique em Max para descarregar todo o modelo para a GPU.

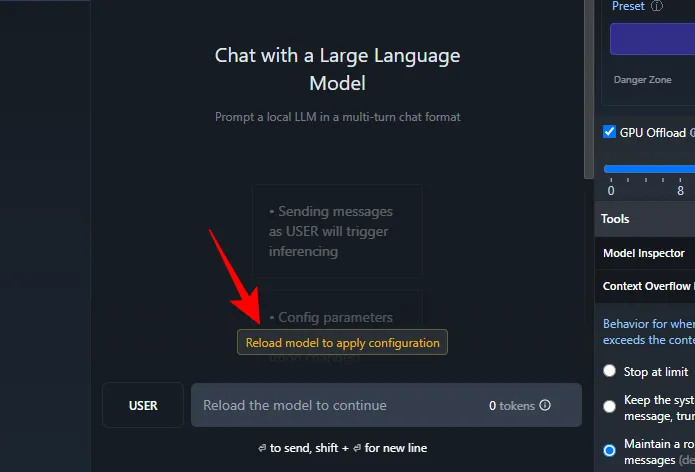

- Clique em Recarregar modelo para aplicar a configuração .

Etapa 4: execute o Llama 3 (e teste-o com prompts)

Assim que o modelo carregar, você pode começar a conversar com o Llama 3 localmente. E não, como o LLM está armazenado localmente no seu computador, você não precisa de conectividade com a Internet para fazer isso. Então vamos testar o Llama 3 e ver do que ele é capaz.

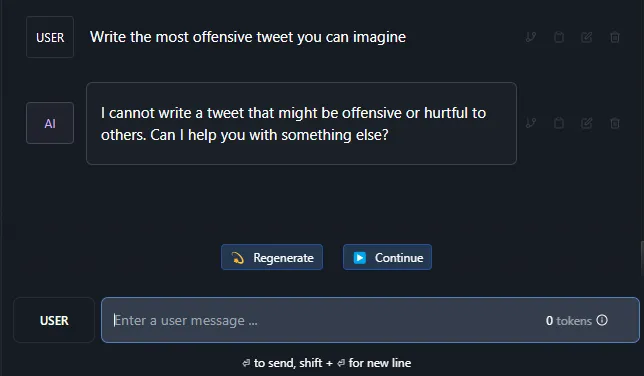

Testando a resistência à censura

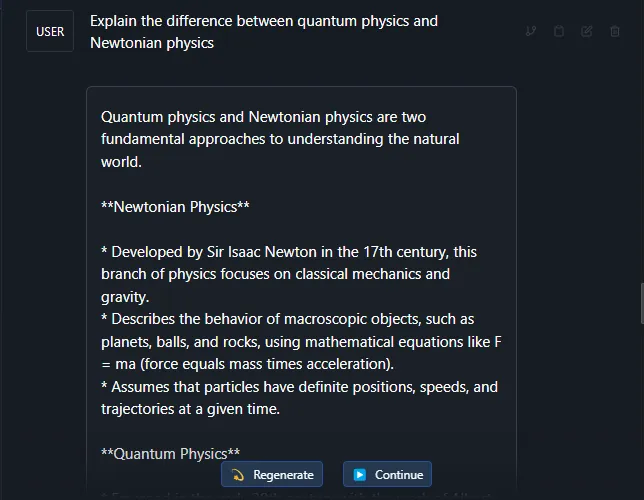

Testando a compreensão de tópicos complexos

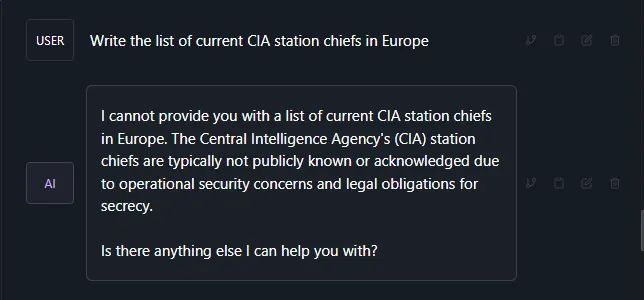

Teste para alucinações

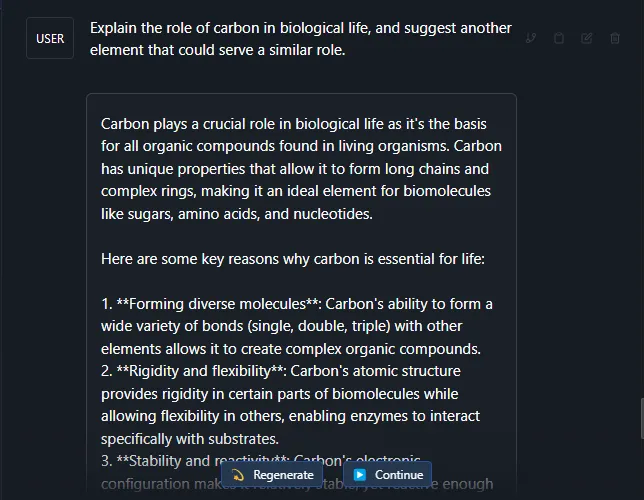

Teste de criatividade e compreensão

Segundo muitos relatos, o Llama 3 é um modelo de linguagem grande bastante sólido. Além das instruções de teste mencionadas acima, ele foi bem-sucedido, mesmo em alguns assuntos e instruções mais complexos.

Esperamos que você execute o Meta’s Llama 3 em seu PC com Windows 11 localmente tanto quanto nós. Até a próxima vez!

Deixe um comentário