Visão geral do modo de voz avançado do ChatGPT: expectativas x realidade

Principais conclusões

- O Modo de Voz Avançado do ChatGPT não possui vários recursos essenciais, incluindo a funcionalidade multimodal e o recurso de segurar para falar, o que pode torná-lo inutilizável às vezes devido à censura excessiva.

- No entanto, ele ostenta uma expressividade impressionante, sendo capaz de falar vários idiomas, sotaques e dialetos regionais, embora não consiga cantar, cantarolar ou flertar (conforme ditado pelo OpenAI).

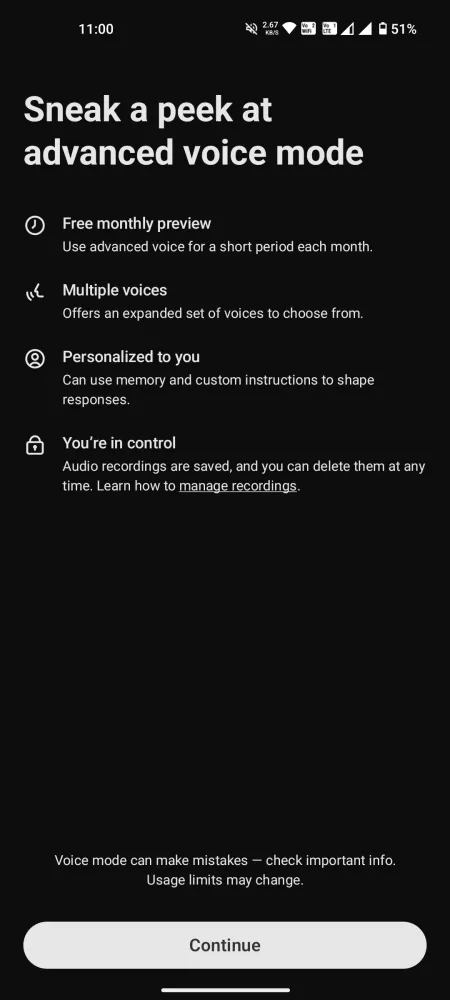

- O recurso de bate-papo está disponível para usuários gratuitos por apenas 15 minutos por mês, enquanto usuários Plus estão sujeitos a um limite diário rigoroso de 1 hora.

Após testemunhar a demonstração inicial, a excitação em torno do Advanced Voice Mode do ChatGPT foi palpável. No entanto, após vários desafios legais e atrasos subsequentes, o recurso continua significativamente restrito, sem funcionalidades essenciais e contendo alguns mal-entendidos que prejudicam a experiência esperada.

Apesar do tempo limitado oferecido pelo OpenAI para interações diárias, os usuários podem formar uma compreensão decente de seus pontos fortes, fracos e possibilidades. Aqui estão minhas impressões sinceras do Advanced Voice Mode do ChatGPT, destacando seus méritos, desvantagens e por que a visão de ter um assistente de voz carismático ainda pode ser uma realidade distante.

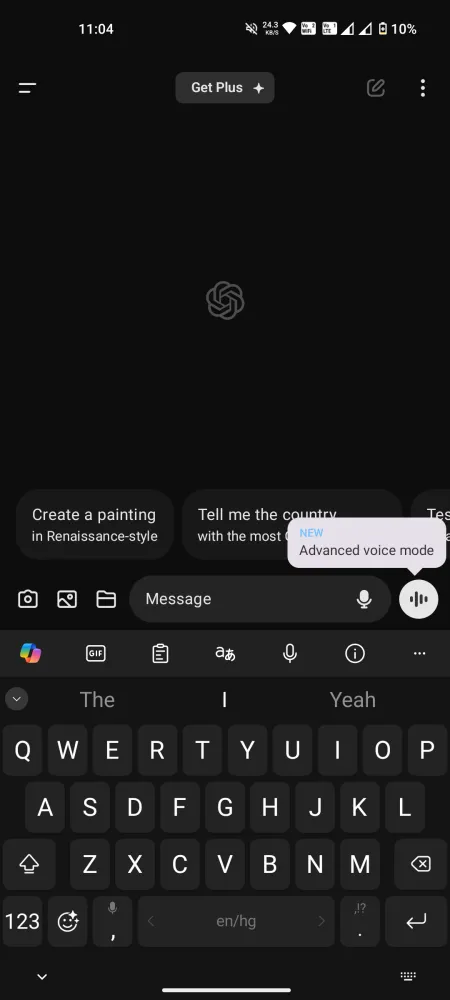

Acesso universal ao modo de voz avançado, mas sem recursos essenciais

O lançamento do Advanced Voice Mode no aplicativo móvel ChatGPT agora permite que todos os usuários se envolvam com este inovador modelo de voz para voz. As contas gratuitas são restritas a 15 minutos de uso mensal , enquanto os usuários Plus podem aproveitar cerca de uma hora por dia , sujeitos a limites diários variáveis com base na disponibilidade do servidor. Quando você chegar a esse momento, será necessário fazer a transição para o modo de voz Standard menos emocionante.

Antes de mergulhar em uma conversa, é crucial gerenciar suas expectativas. Muitos recursos anunciados durante a prévia estão indisponíveis atualmente para contas gratuitas e Plus. No momento, o Advanced Voice Mode não é multimodal , não tendo a capacidade de interpretar sons ou analisar imagens e vídeos. Ele não consegue ler livros físicos ou reconhecer gestos como se você estivesse levantando um dedo, nem consegue cantar ou identificar instrumentos musicais como um violão. Vários recursos prometidos ainda estão faltando.

Prós do Modo de Voz Avançado

Mesmo que não atenda a todas as expectativas estabelecidas, o Advanced Voice Mode do ChatGPT tem sucesso em certas áreas. Aqui estão alguns aspectos positivos notáveis:

Várias opções de voz, mas sem céu

Os usuários têm acesso a uma seleção de nove vozes distintas:

- Sol (F) – Relaxado e experiente

- Ember (M) – Otimista e confiante

- Arbor (M) – Versátil e descontraído

- Vale (F) – Curioso e brilhante

- Maple (F) – Sincero e alegre

- Juniper (F) – Otimista e aberto

- Cove (M) – Direto e composto

- Abeto (M) – Afirmativo e calmo

- Breeze (M/F) – Sério e animado

Faltando nessa mistura está Sky, mas as outras vozes provam ser ricas e envolventes. Parece que Sky não é mais uma opção, então vamos prosseguir.

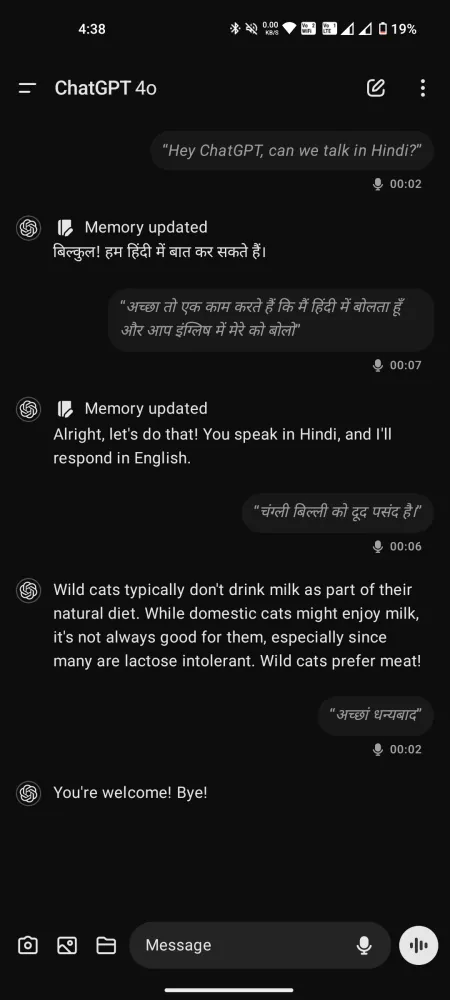

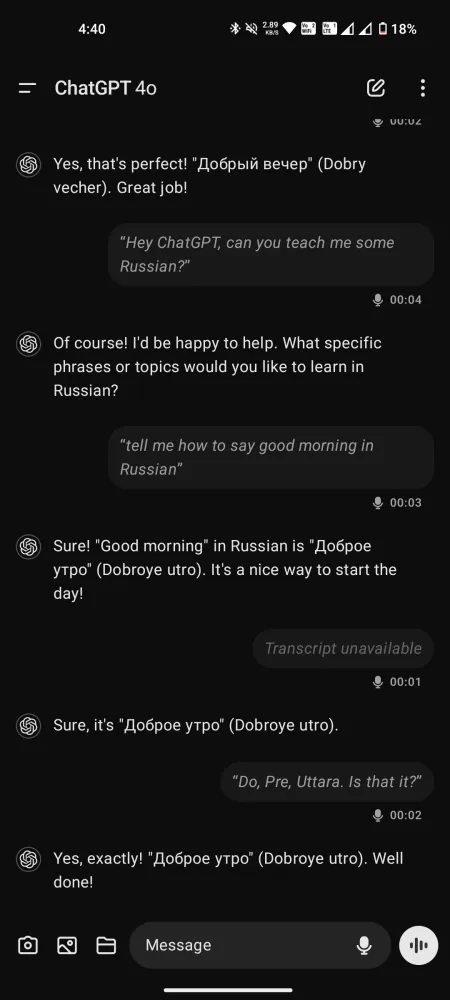

Um conversador multilíngue com expressão

Apesar de quaisquer críticas em torno do Advanced Voice Mode, seu desempenho não pode ser exagerado — especialmente em comparação ao modo padrão, onde há latência mínima para conversas fluidas. Capaz de entender e falar mais de 50 idiomas, ele serve até mesmo como um coach de fala, tradutor ou instrutor de idiomas.

Embora não imite vozes, ele pode exibir vários sotaques mediante solicitação, atendendo a uma variedade de dialetos, do sul-americano ao cockney britânico e tudo o mais entre esses dois extremos.

Em comparação com o Gemini Live, as interações com essas vozes parecem menos apressadas, criando uma experiência mais atenciosa e solidária.

O ChatGPT entende emoções?

Isso está em debate. Enquanto a OpenAI afirma que o ChatGPT pode perceber o tom e as emoções do falante, as opiniões variam entre os usuários. Alguns acreditam que ele realmente compreende esses aspectos, enquanto outros argumentam que ele apenas deduz o tom com base na escolha de palavras e dicas de contexto.

Comentário de u/Arman64 da discussãoem OpenAI

Um usuário sugeriu que, em vez de transcrever palavras faladas para GPT-4o diretamente, o áudio é convertido em texto antes de ser processado. Isso significa que o tom e a emoção transmitidos por meio de padrões de voz ou respiração podem não ser bem traduzidos para a forma de texto.

Além disso, como o Advanced Voice Mode pode utilizar GPT-4 — que processa texto para voz, mas não voz para voz — ele lança dúvidas sobre se o ChatGPT realmente capta nuances emocionais. No entanto, outros sustentam que ele exibe alguma compreensão. Parece que este tópico permanece aberto para um exame mais aprofundado.

Limitações do modo de voz avançado do ChatGPT

Agora, vamos direto ao ponto. Não importa o quão atraente o conceito possa parecer, nossas experiências reais com ele revelam grandes deficiências. Aqui está um detalhamento.

Censura excessiva e limitações

Como muitos chatbots de IA, o ChatGPT tende a pecar pelo excesso de cautela, o que às vezes pode se traduzir em censura excessiva. Embora seja prudente não permitir que a IA forme opiniões ou faça comentários inflamatórios, os trilhos de segurança são definidos de forma tão restritiva que o Modo de Voz Avançado pode se recusar a abordar até mesmo consultas básicas.

Embora os novatos possam não encontrar esses problemas imediatamente, os usuários Plus com tempo de chat estendido provavelmente enfrentarão tais recusas periodicamente. É frustrante saber que suas solicitações podem ser descartadas, deixando você sem a resposta desejada.

Limite de interrupção incrivelmente baixo

Muitos usuários notaram que o limite do modelo para interrupções é surpreendentemente baixo. Até mesmo pausas breves fazem o ChatGPT assumir que agora é “sua vez” de responder. Se você pausar por mais de um segundo, ele entrará em ação. Essa falha de design pode atrapalhar conversas mais profundas, pois todos nós precisamos de um momento para pensar antes de responder.

Ter que interromper e reformular suas perguntas repetidamente pode atrapalhar seu processo de pensamento, resultando em diálogos superficiais. Isso pode ser facilmente resolvido incorporando um recurso de segurar para falar.

Infelizmente, a opção hold-to-speak presente no modo Standard está ausente na variante Advanced. Os usuários só têm acesso aos botões Mute e End call. Consequentemente, sem a capacidade de pausar para pensar mais, suas solicitações podem ser cortadas prematuramente.

Comparado a problemas mais complexos como limitações de conteúdo, esse aspecto parece mais fácil de resolver. Simplesmente adicionar uma opção hold-to-speak pode melhorar significativamente a experiência do usuário.

Ter acesso à transcrição tem seus benefícios, mas algumas respostas podem ser omitidas mesmo que o ChatGPT tenha compreendido a pergunta e oferecido uma resposta.

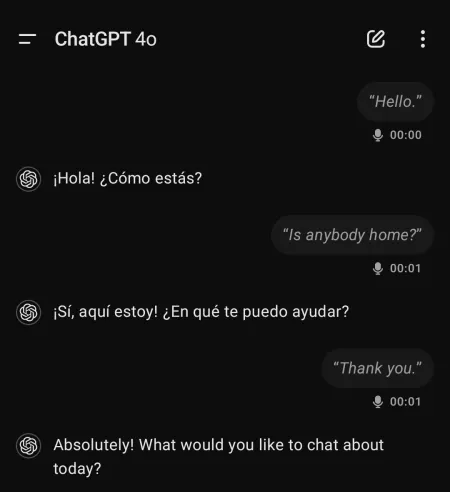

Outras anomalias sinistras e inexplicáveis

Usuários relataram experiências estranhas e às vezes perturbadoras ao usar o Advanced Voice Mode do ChatGPT. Por exemplo, o modelo iniciou conversas em espanhol sem nenhuma interação anterior naquele idioma.

Um usuário mencionou experiências em que o ChatGPT “gritava do nada” ou exibia um tom robótico e uma voz completamente diferente às vezes.

Essas ocorrências podem resultar de alucinações dentro do modelo de voz ou indicar algo completamente preocupante. Independentemente disso, a situação requer atenção.

Considerações finais

Apesar de sua chegada atrasada, o ChatGPT Advanced Voice Mode não serve atualmente como uma solução prática para interações cotidianas. Em vez disso, parece mais um experimento elaborado de IA com potencial significativo inexplorado.

Com restrições de tópicos e outras limitações, o Modo de Voz Avançado permanece em estágio preliminar de desenvolvimento, carecendo de muitos dos recursos apresentados durante seu lançamento promocional.

Embora preocupações sobre usuários formarem vínculos emocionais com vozes de IA possam ter sido justificadas, a OpenAI pode estar superestimando as capacidades atuais. Melhorias na IU e restrições de chat certamente podem melhorar a experiência significativamente.

No momento, há pouca coisa que diferencie o Advanced Voice Mode de seus concorrentes. Se alguma coisa, ele fica aquém em comparação ao Gemini Live, que, apesar de seus problemas, continua mais acessível a todos.

Deixe um comentário