Principais alternativas de código aberto para Crawl4AI: melhores opções comparadas

O Crawl4AI serve como uma ferramenta complementar para rastreamento da web e extração de dados, atendendo particularmente aos requisitos de modelos de linguagem grandes (LLMs) e vários aplicativos baseados em IA. No entanto, ele não é o único concorrente neste espaço. Neste artigo, exploraremos as principais alternativas de código aberto ao Crawl4AI .

Principais alternativas de código aberto para Crawl4AI

Abaixo estão algumas alternativas de código aberto notáveis ao Crawl4AI.

- Rasgado

- Collie

- PySpider

- X-Rastreamento

- Fogos de artifício

1] Fraco

Scrapy se destaca como um framework de código aberto baseado em Python, projetado para web scraping e crawling. Ele permite que os usuários extraiam dados de páginas da web de forma eficiente. Graças ao uso do Twisted, um framework de rede assíncrona, o Scrapy melhora o desempenho e a velocidade de processamento.

Este framework suporta a adição de middleware e pipelines, permitindo processamento de dados personalizado. O Scrapy é adepto de gerenciar solicitações, rastrear links e extrair informações usando seletores CSS e XPath, combinando perfeitamente com seu ambiente atual.

Além disso, o Scrapy oferece uma interface amigável, simplificando o processo de rastreamento e extração de dados de vários sites. A plataforma é suportada por uma comunidade vibrante e documentação abrangente.

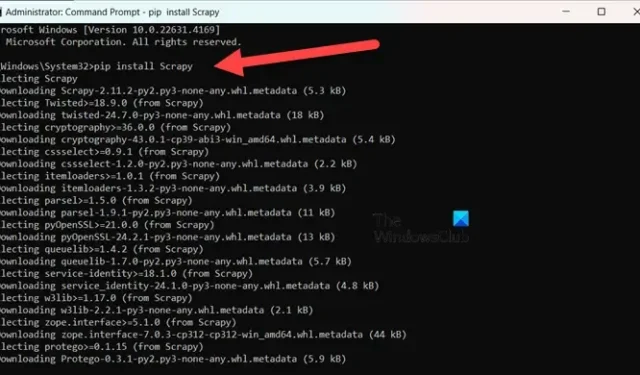

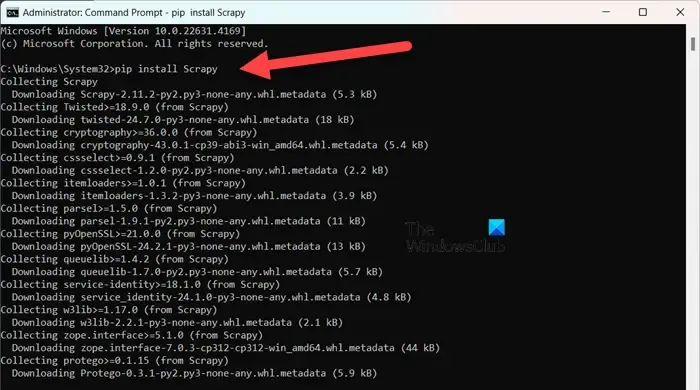

Para instalar o Scrapy , certifique-se de que você está usando o Python 3.8 ou superior (CPython é o padrão, mas PyPy também é suportado). Se você estiver utilizando Anaconda ou Miniconda, instale o pacote através do canal conda-forge com o seguinte comando:

conda install -c conda-forge scrapy

Como alternativa, para aqueles que preferem PyPI, execute o comando em um prompt de comando elevado:

pip install Scrapy

Para se aprofundar mais nesta ferramenta, visite scrapy.org .

2] Collie

Colly é uma biblioteca de scraping simples desenvolvida para Golang. Ela simplifica o processo de envio de solicitações HTTP, análise de HTML e recuperação de dados de sites. Colly apresenta funções que permitem que os desenvolvedores naveguem em páginas da web, filtrem elementos usando seletores CSS e enfrentem vários desafios de extração de dados.

O recurso de destaque do Colly é seu desempenho notável, capaz de processar mais de 1000 solicitações por segundo em um único núcleo; essa taxa aumenta com núcleos adicionais. Ele atinge tal eficiência devido ao seu cache integrado e suporte para scraping síncrono e assíncrono.

No entanto, o Colly tem limitações, como a falta de renderização de JavaScript e uma comunidade menor, o que leva a menos extensões e menos documentação.

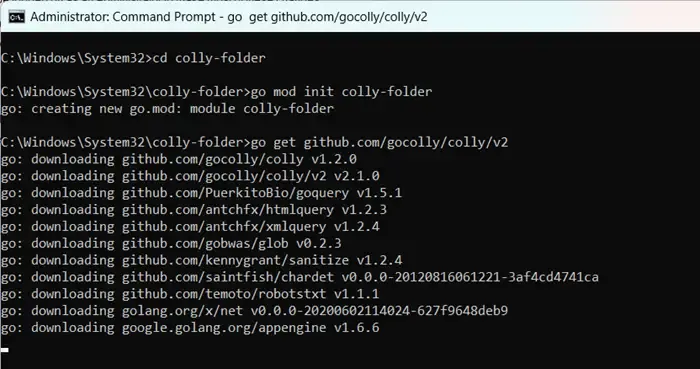

Para começar a usar o Colly, primeiro instale o Golang visitando go.dev . Após a instalação, reinicie seu computador, abra o Prompt de Comando como administrador e insira os comandos:

mkdir colly-folder cd colly-folder

go mod init colly-folder

go get github.com/gocolly/colly/v2

Você pode renomear “colly-folder” para qualquer coisa que preferir. Após construir o módulo, você pode executar seu web scraper usando go run main.go.

3] PySpider

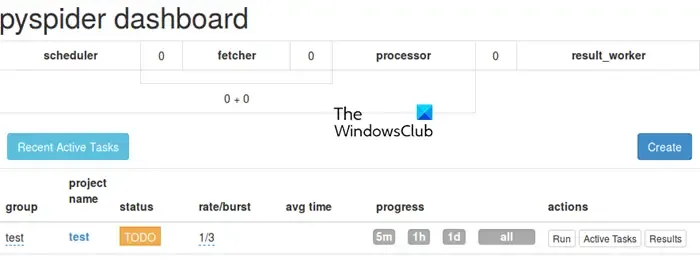

O PySpider opera como um sistema abrangente de rastreamento da web, apresentando uma interface de usuário intuitiva baseada na web, simplificando o gerenciamento e o monitoramento de seus rastreadores. Ele é equipado para lidar com sites ricos em JavaScript por meio de sua integração com o PhantomJS.

Ao contrário do Colly, o PySpider oferece amplos recursos de gerenciamento de tarefas, incluindo agendamento e priorização de tarefas, superando o Crawl4AI nesse aspecto. No entanto, vale a pena notar que ele pode ter um desempenho inferior ao do Crawl4AI devido à arquitetura assíncrona deste último.

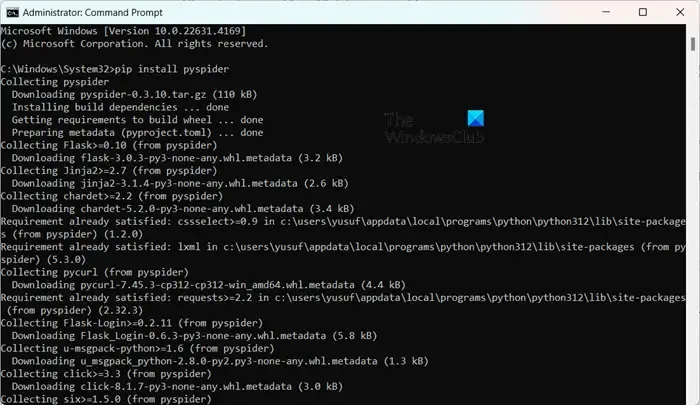

Instalar o PySpider é descomplicado, especialmente se você já tiver o Python configurado. Você pode simplesmente executar pip install pyspiderem um Prompt de Comando elevado. Para começar, basta usar o comando pyspidere acessar a interface em http://localhost:5000/ no seu navegador da web.

4] X-Rastreamento

X-Crawl é uma biblioteca flexível para Node.js que utiliza tecnologias de IA para aprimorar a eficiência do web crawling. Esta biblioteca integra recursos de IA para facilitar o desenvolvimento de web crawlers e scrapers eficazes.

O X-Crawl se destaca no gerenciamento de conteúdo dinâmico gerado por JavaScript, uma necessidade para muitos sites modernos. Ele também fornece inúmeras opções de personalização, adaptadas para ajustar a experiência de rastreamento às suas necessidades.

É importante observar algumas distinções entre Crawl4AI e X-Crawl, predominantemente baseadas na sua linguagem de programação preferida: o Crawl4AI usa Python, enquanto o X-Crawl é baseado em Node.js.

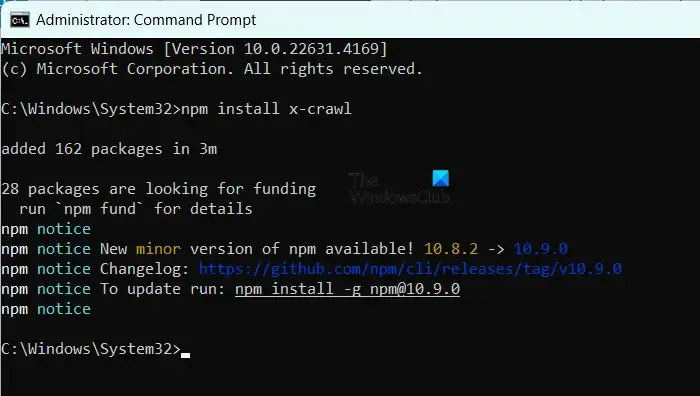

Para instalar o X-Crawl, certifique-se de ter o Node.js em sua máquina e, em seguida, execute o comando npm install x-crawl.

5] Fogo de artifício

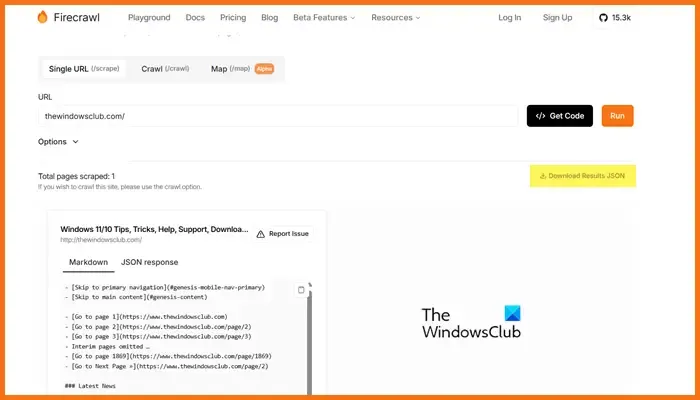

Firecrawl, desenvolvido pela Mendable.ai, é uma ferramenta sofisticada de web scraping que transforma dados da web em markdowns organizados de forma organizada ou outros formatos, otimizados para modelos de linguagem grandes (LLMs) e aplicativos de IA. Ele gera saídas prontas para uso em LLM, facilitando a integração desse conteúdo em diversos modelos de linguagem e soluções de IA. A ferramenta vem com uma API fácil de usar para enviar trabalhos de crawling e obter resultados. Para mais detalhes sobre o Firecrawl, visite firecrawl.dev , insira a URL do site que deseja escanear e clique em Executar.

Qual ferramenta de código aberto é ideal para desenvolvimento web?

Uma infinidade de ferramentas de desenvolvimento web de código aberto estão disponíveis para você utilizar. Para edição de código, considere Visual Studio Code ou Atom. Se você precisa de frameworks frontend, Bootstrap e Vue.js são excelentes escolhas, enquanto Django e Express.js atendem bem para desenvolvimento backend. Além disso, plataformas como Git, GitHub, Figma, GIMP, Slack e Trello também oferecem opções de código aberto que podem aprimorar seu fluxo de trabalho de desenvolvimento web.

Os modelos GPT de código aberto são acessíveis?

Sim, existem vários modelos GPT de código aberto, incluindo GPT-Neo da EleutherAI, Cerebras-GPT, BLOOM, GPT-2 da OpenAI e Megatron-Turing NLG da NVIDIA/Microsoft. Esses modelos fornecem uma gama de soluções para atender a diferentes requisitos, desde processamento de linguagem de propósito geral até modelos criados para capacidades multilíngues ou tarefas de alto desempenho.

Deixe um comentário