O novo Phi-3 LLM da Microsoft é pequeno e treinado com histórias para dormir, mas ainda assim é impressionante

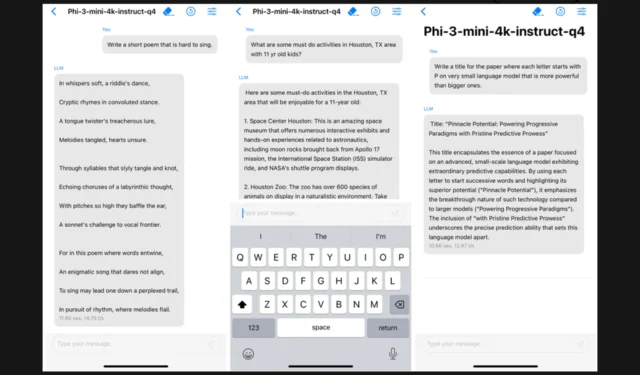

A Microsoft lançou seu mais recente modelo de inteligência artificial, Phi-3 Mini e se você é um conhecedor de tecnologia, pode ir direto para o relatório técnico . Phi-3 Mini é o menor modelo de IA da Microsoft até agora, mas não se deixe enganar pelo tamanho. Ele possui 3,8 bilhões de parâmetros, tornando-o uma potência capaz de executar tarefas próximas a modelos dez vezes maiores. O que é ainda mais fascinante é como esse modelo foi treinado. Inspirados pela simplicidade e eficácia das histórias infantis para dormir, os desenvolvedores criaram um currículo único que simplifica conceitos complexos, tornando o Phi-3 não apenas inteligente, mas também incrivelmente fácil de usar.

Por que a Microsoft investiria em um pequeno LLM?

Bem, acontece que modelos menores de IA, como o Phi-3 Mini, não são apenas mais baratos de operar; eles também são mais eficientes em dispositivos pessoais, como telefones e laptops, que podem ser executados localmente. Isso é uma virada de jogo para organizações menores ou indivíduos que anteriormente consideravam proibitivo o custo do uso de grandes modelos de linguagem. A decisão da Microsoft de desenvolver o Phi-3 Mini e seus próximos irmãos, Phi-3 Small e Phi-3 Medium, é um passo estratégico para democratizar a tecnologia de IA.

Em termos de competição, o Phi-3 Mini está em uma categoria à parte. Enquanto outros LLMs se concentram em tarefas específicas, como resumo de documentos ou assistência de codificação, o Phi-3 Mini brilha com sua versatilidade e desempenho, rivalizando com modelos maiores em tarefas que vão de matemática a programação e testes acadêmicos. E a melhor parte? Ele pode fazer tudo isso diretamente no seu smartphone, sem precisar de conexão com a internet.

A abordagem da Microsoft para treinar o Phi-3 Mini é inovadora. Ao pedir a outro LLM que criasse livros infantis com mais de 3.000 palavras, eles conseguiram ensinar o modelo de uma forma eficaz e cativante. Este método não apenas aprimora as habilidades de codificação e raciocínio do modelo, mas também o torna mais identificável e fácil de interagir.

Phi-3 Mini agora está disponível em plataformas como Azure, Hugging Face e Ollama, tornando-o acessível a uma ampla gama de usuários ansiosos para explorar seus recursos. Estamos ansiosos pelo lançamento do Phi-3 Small e do Phi-3 Medium, porque é isso que vem a seguir. Executar um LLM localmente em um smartphone parece muito interessante.

O que você acha do Phi-3 da Microsoft? Compartilhe suas idéias em um comentário abaixo.

Deixe um comentário