Czym jest AI Web Scraping? Nowy sposób przechwytywania danych

Czy kiedykolwiek musiałeś wyodrębnić publicznie dostępne dane, takie jak ceny, opinie klientów lub oferty nieruchomości, ze strony internetowej, ale miałeś z tym problem? Coraz częściej ludzie korzystają ze scrapowania sieci za pomocą AI: łączą sztuczną inteligencję (AI) z tradycyjnymi metodami scrapowania, aby wyodrębnić dane z całej sieci.

Czym jest AI Web Scraping?

Scrapowanie sieci za pomocą AI to nowatorskie podejście do ekstrakcji danych, które łączy moc sztucznej inteligencji z tradycyjnymi technikami scrapowania sieci. To tak, jakby dać zwykłemu skrobakowi sieci ulepszenie mózgu: pozwolić mu myśleć, uczyć się i dostosowywać się samodzielnie.

Ponieważ AI web scraping może mieć tak wiele form, jedna aplikacja może wyglądać zupełnie inaczej niż druga. Co więcej, technologia AI wciąż rozwija się w błyskawicznym tempie, więc to, co nie jest możliwe teraz, może być możliwe za kilka miesięcy.

Czy web scraping przy użyciu sztucznej inteligencji jest legalny?

Nie udzielamy porad prawnych, a przepisy dotyczące web scrapingu mogą się znacznie różnić w zależności od kraju i jurysdykcji, dlatego zawsze skonsultuj się z prawnikiem, aby uzyskać poradę dotyczącą Twojej sytuacji.

Web scraping, niezależnie od tego, czy jest wspomagany przez sztuczną inteligencję, czy nie, jest ogólnie legalny, jeśli zbierasz publicznie dostępne dane z Internetu. Kluczowym słowem jest tutaj „publicznie”. Jeśli informacje są swobodnie dostępne bez konieczności podawania danych logowania lub omijania środków bezpieczeństwa, jest to zazwyczaj uczciwa gra.

Aby być dodatkowo bezpiecznym, zawsze powinieneś rozważyć warunki korzystania z witryny, którą chcesz zeskrobać. Wiele witryn wyraźnie zabrania zeskrobania w swoich warunkach korzystania z usługi. Chociaż naruszenie tych warunków nie jest koniecznie nielegalne, może potencjalnie prowadzić do pozwów cywilnych.

Uważaj również, aby nigdy nie tworzyć nadmiernego obciążenia dla usługi sieciowej poprzez scrapowanie. Agresywne scrapowanie, które przeciąża serwery witryny, może być uznane za formę ataku typu DoS (odmowa usługi) i mieć konsekwencje prawne.

Czym różni się scrapowanie stron internetowych przy użyciu sztucznej inteligencji od scrapowania ręcznego?

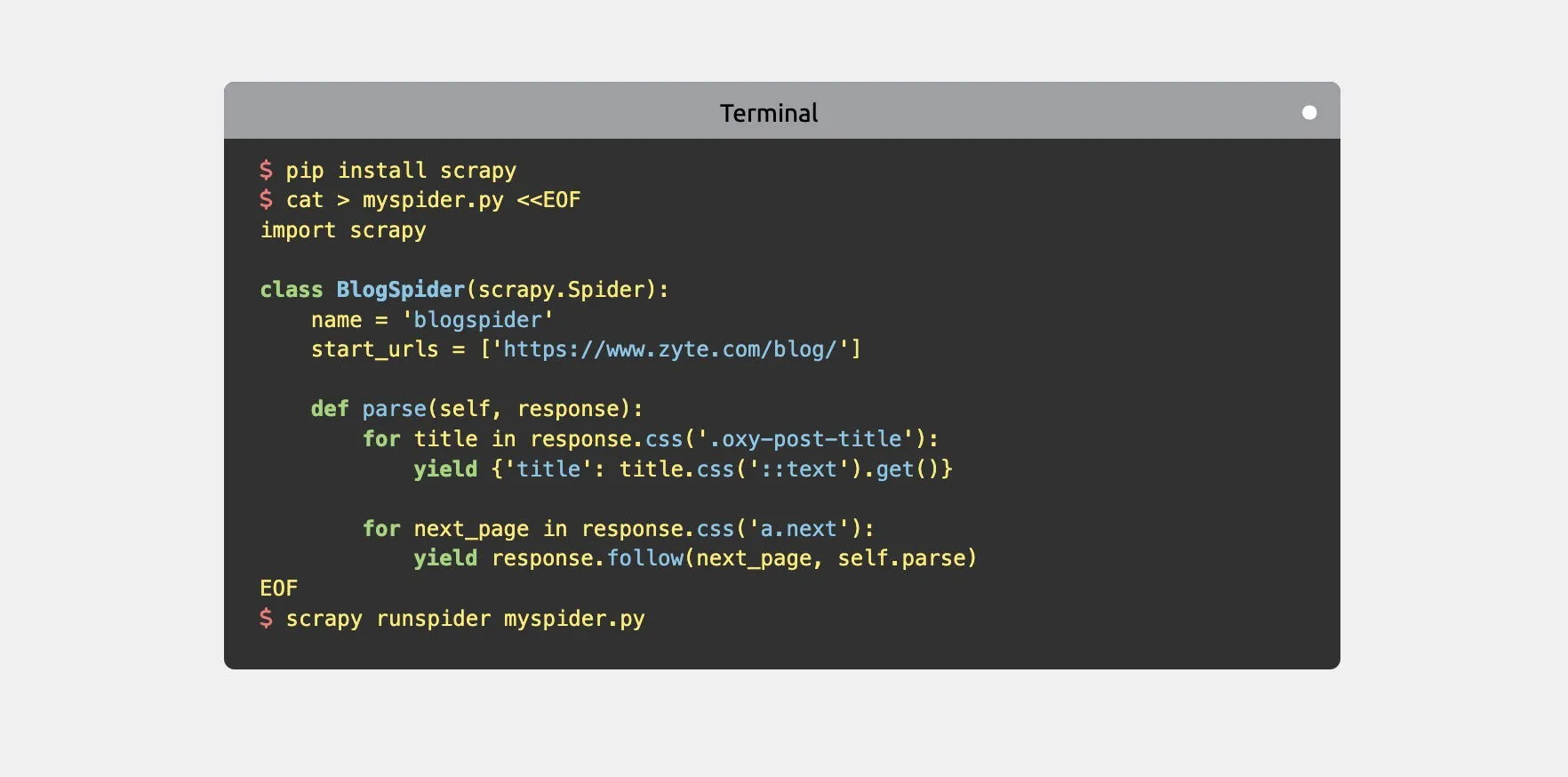

Tradycyjne web scraping zazwyczaj polega na pisaniu niestandardowych skryptów lub używaniu narzędzi takich jak Beautiful Soup , Scrapy lub Puppeteer do wyodrębniania danych ze stron internetowych. Metody te polegają na wstępnie zdefiniowanych regułach i wzorcach w celu zlokalizowania i wyodrębnienia określonych elementów ze stron internetowych.

Po zebraniu danych często konieczna jest ich dalsza obróbka i analiza, co może wiązać się z wykorzystaniem arkuszy kalkulacyjnych lub narzędzi do analizy danych, np. biblioteki Pandas języka Python .

Gdy te tradycyjne techniki web scrapingu połączymy z AI, mówimy o web scrapingu AI. Poniżej przedstawiono kilka przykładów, jak połączenie to może wyglądać w praktyce:

- Modele uczenia maszynowego można wykorzystać do nawigacji po złożonych stronach internetowych oraz łatwego zarządzania dynamiczną zawartością i stronami renderowanymi za pomocą JavaScript.

- Możliwości wizyjne sztucznej inteligencji umożliwiają scraperom wyodrębnianie danych z treści wizualnych, a nie tylko z tekstu.

- Sztuczna inteligencja potrafi wykrywać i dostosowywać się do zmian w strukturze stron internetowych, a także ograniczać potrzebę ciągłej konserwacji skryptów zbierających dane.

- Istotne informacje można wyodrębnić z tekstu w oparciu o złożone zrozumienie kontekstu i semantyki pozyskanego tekstu.

- Recenzje produktów i komentarze w mediach społecznościowych można wprowadzić do sztucznej inteligencji, która przeprowadzi analizę nastrojów, mierząc emocjonalny ton danych tekstowych.

Jak widać, AI może wkroczyć do akcji zarówno na etapie gromadzenia danych, jak i analizy danych w procesie web scrapingu. Na etapie gromadzenia danych AI zwiększa zdolność scrapera do poruszania się po stronach internetowych, identyfikowania odpowiednich danych i dostosowywania się do zmian w czasie rzeczywistym. Na etapie analizy danych AI może przetwarzać i interpretować zebrane dane w sposób wykraczający poza prostą ekstrakcję.

Jakie są główne korzyści ze scrapowania za pomocą sztucznej inteligencji?

Web scraping wspomagany przez AI przynosi mnóstwo korzyści. Przyjrzyjmy się bliżej niektórym z najważniejszych.

Możliwość dostosowania do zmian na stronie internetowej

Witryny internetowe nieustannie ewoluują, co może zaburzyć działanie tradycyjnych scraperów. Narzędzia oparte na sztucznej inteligencji mogą dostosowywać się do tych zmian w locie, rozpoznając nowe wzorce i odpowiednio dostosowując swoje strategie scrapowania. Oznacza to mniej przestojów i konserwacji w przypadku działań związanych ze zbieraniem danych.

Analiza danych oparta na wizji

Tradycyjne scrapery są ograniczone do informacji tekstowych, ale AI może wyodrębnić cenne spostrzeżenia z obrazów, wykresów i infografik. Otwiera to zupełnie nowy wymiar danych, który wcześniej był niedostępny. Na przykład AI może analizować zdjęcia produktów, aby identyfikować cechy, kolory i style, co jest niezwykle przydatne dla konkurentów e-commerce śledzących trendy.

Przetwarzanie języka naturalnego

AI potrafi zrozumieć kontekst i znaczenie zebranych danych tekstowych. Jak wspomniano wcześniej, firmy mogą używać analizy sentymentu do oceny zadowolenia klientów z zebranych recenzji lub może podsumowywać duże ilości tekstu, tłumaczyć treści z rynków zagranicznych i wiele więcej.

Jakie są wyzwania i pułapki związane ze scrapowaniem stron internetowych przy użyciu sztucznej inteligencji?

Chociaż web scraping AI oferuje liczne korzyści, nie jest pozbawiony wyzwań. Głównym zmartwieniem jest nieprzewidywalna natura wyników AI. Modele AI mogą czasami dawać nieoczekiwane lub nieprawidłowe wyniki. Zjawisko to, często określane jako „halucynacja” w kręgach AI, występuje, gdy AI generuje informacje brzmiące wiarygodnie, którym brakuje dokładności. W kontekście web scrapingu może to oznaczać zeskrobane dane, które wydają się poprawne, ale w rzeczywistości są tworzone przez AI.

Innym potencjalnym wyzwaniem jest poleganie na zewnętrznej usłudze AI, takiej jak ChatGPT lub Claude. Możesz napotkać problemy z dostępnością usługi, zmiany w modelach cenowych lub modyfikacje możliwości AI, które mogą zakłócić Twoje operacje scrapowania.

Scraping sieci AI to nowy sposób przechwytywania publicznie dostępnych danych z sieci. Łączy tradycyjne techniki scrapingu sieci z najnowocześniejszymi botami sztucznej inteligencji, aby obsługiwać złożone witryny, wydobywać spostrzeżenia z treści wizualnych, dostosowywać się do zmian w strukturach sieci i nie tylko.

Zdjęcie autorstwa Davida Morelo.

Dodaj komentarz