Najlepsze alternatywy Open Source dla Crawl4AI: porównanie najlepszych opcji

Crawl4AI służy jako uzupełniające narzędzie do indeksowania sieci i ekstrakcji danych, szczególnie dostosowane do wymagań dużych modeli językowych (LLM) i licznych aplikacji opartych na AI. Niemniej jednak nie jest jedynym konkurentem w tej przestrzeni. W tym artykule przyjrzymy się najlepszym alternatywom open-source dla Crawl4AI .

Wiodące alternatywy Open Source dla Crawl4AI

Poniżej znajdziesz kilka godnych uwagi alternatyw typu open source dla Crawl4AI.

- Scrapy

- Kollia

- PySpider

- X-pełzanie

- Ognisty pełzacz

1] Złom

Scrapy wyróżnia się jako oparta na Pythonie struktura open-source zaprojektowana do scrapowania i indeksowania stron internetowych. Umożliwia użytkownikom wydajne wyodrębnianie danych ze stron internetowych. Dzięki wykorzystaniu Twisted, asynchronicznej struktury sieciowej, Scrapy zwiększa wydajność i szybkość przetwarzania.

Ta struktura obsługuje dodawanie middleware i pipelines, umożliwiając niestandardowe przetwarzanie danych. Scrapy jest biegły w zarządzaniu żądaniami, śledzeniu linków i wyodrębnianiu informacji za pomocą selektorów CSS i XPath, płynnie wtapiając się w Twoje obecne środowisko.

Ponadto Scrapy oferuje przyjazny użytkownikowi interfejs, upraszczając proces śledzenia i wyodrębniania danych z różnych stron internetowych. Platforma jest wspierana przez aktywną społeczność i kompleksową dokumentację.

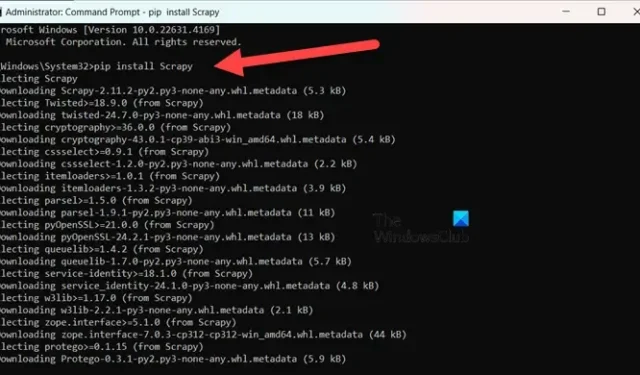

Aby zainstalować Scrapy , upewnij się, że używasz Pythona 3.8 lub nowszego (CPython jest domyślny, ale PyPy jest również obsługiwany). Jeśli używasz Anacondy lub Minicondy, zainstaluj pakiet za pomocą kanału conda-forge za pomocą następującego polecenia:

conda install -c conda-forge scrapy

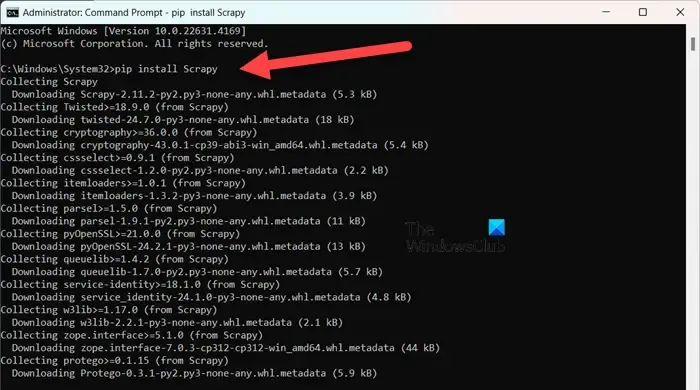

Alternatywnie, dla tych, którzy wolą PyPI, wykonaj polecenie w wierszu poleceń z podwyższonym poziomem uprawnień:

pip install Scrapy

Aby dowiedzieć się więcej na temat tego narzędzia, odwiedź stronę scrapy.org .

2] Collie

Colly to prosta biblioteka do scrapowania opracowana dla Golang. Upraszcza proces wysyłania żądań HTTP, parsowania HTML i pobierania danych ze stron internetowych. Colly zawiera funkcje, które umożliwiają programistom nawigację po stronach internetowych, filtrowanie elementów za pomocą selektorów CSS i rozwiązywanie różnych problemów z ekstrakcją danych.

Cechą wyróżniającą Colly jest jego niezwykła wydajność, zdolna do przetwarzania ponad 1000 żądań na sekundę na jednym rdzeniu; ta szybkość wzrasta wraz z dodatkowymi rdzeniami. Osiąga taką wydajność dzięki wbudowanemu buforowaniu i obsłudze zarówno synchronicznego, jak i asynchronicznego scrapowania.

Colly ma jednak pewne ograniczenia, takie jak brak renderowania JavaScript i mniejsza społeczność, co skutkuje mniejszą liczbą rozszerzeń i uboższą dokumentacją.

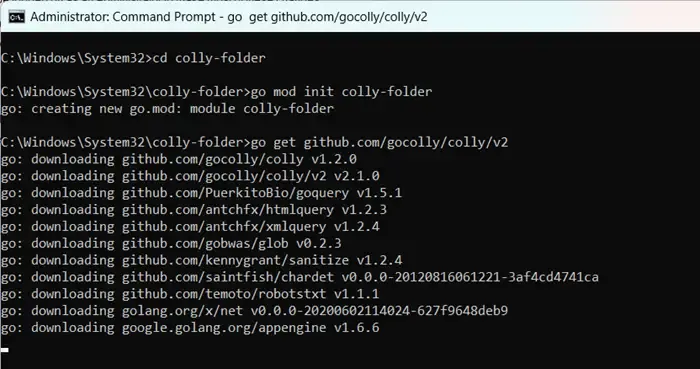

Aby rozpocząć pracę z Colly, najpierw zainstaluj Golang, odwiedzając go.dev . Po instalacji uruchom ponownie komputer, otwórz wiersz poleceń jako administrator i wprowadź polecenia:

mkdir colly-folder cd colly-folder

go mod init colly-folder

go get github.com/gocolly/colly/v2

Możesz zmienić nazwę „colly-folder” na dowolną inną. Po zbudowaniu modułu możesz uruchomić swój web scraper za pomocą go run main.go.

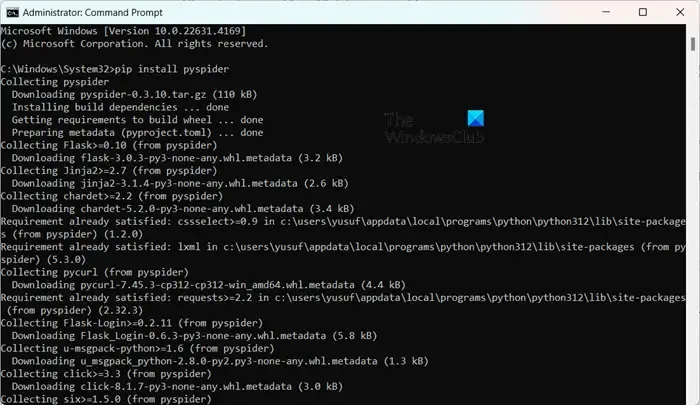

3] PySpider

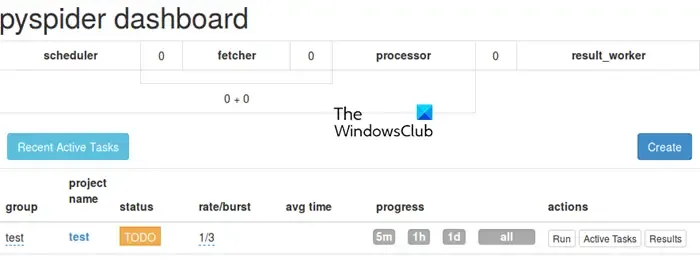

PySpider działa jako kompleksowy system indeksowania sieci, oferujący intuicyjny interfejs użytkownika oparty na sieci, upraszczając zarządzanie i monitorowanie Twoich robotów indeksujących. Jest wyposażony w obsługę witryn bogatych w JavaScript poprzez integrację z PhantomJS.

W przeciwieństwie do Colly, PySpider oferuje rozbudowane możliwości zarządzania zadaniami, w tym planowanie i priorytetyzowanie zadań, przewyższając w tym względzie Crawl4AI. Warto jednak zauważyć, że może pozostawać w tyle pod względem wydajności w porównaniu z Crawl4AI ze względu na jego asynchroniczną architekturę.

Instalacja PySpider jest nieskomplikowana, zwłaszcza jeśli masz już skonfigurowanego Pythona. Możesz po prostu wykonać pip install pyspiderpolecenie w podwyższonym wierszu poleceń. Aby rozpocząć, po prostu użyj polecenia pyspideri uzyskaj dostęp do interfejsu pod adresem http://localhost:5000/ w przeglądarce internetowej.

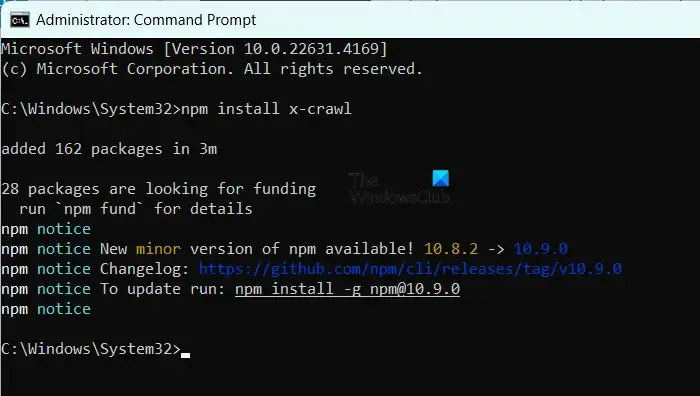

4] X-pełzanie

X-Crawl to elastyczna biblioteka dla Node.js, która wykorzystuje technologie AI w celu zwiększenia wydajności indeksowania sieci. Ta biblioteka integruje możliwości AI w celu ułatwienia rozwoju skutecznych robotów indeksujących i scraperów sieci.

X-Crawl doskonale radzi sobie z zarządzaniem dynamiczną zawartością generowaną przez JavaScript, co jest koniecznością dla wielu nowoczesnych witryn. Oferuje również liczne opcje dostosowywania, dostosowane do precyzyjnego dostrojenia doświadczenia indeksowania do Twoich potrzeb.

Ważne jest, aby zwrócić uwagę na pewne różnice między Crawl4AI i X-Crawl, wynikające głównie z preferowanego języka programowania — Crawl4AI wykorzystuje Python, natomiast X-Crawl opiera się na Node.js.

Aby zainstalować X-Crawl, upewnij się, że na swoim komputerze masz Node.js, a następnie po prostu uruchom polecenie npm install x-crawl.

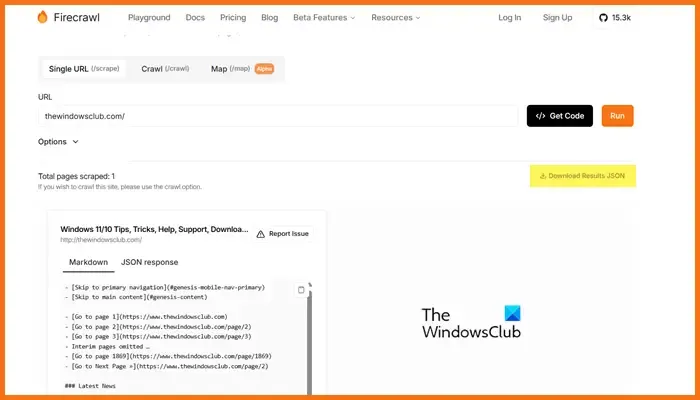

5] Ognisty pełzacz

Firecrawl, opracowany przez Mendable.ai, to wyrafinowane narzędzie do scrapowania stron internetowych, które przekształca dane internetowe w uporządkowane znaczniki lub inne formaty, zoptymalizowane pod kątem dużych modeli językowych (LLM) i aplikacji AI. Generuje dane wyjściowe gotowe do użycia w LLM, ułatwiając integrację tej treści z różnymi modelami językowymi i rozwiązaniami AI. Narzędzie jest wyposażone w łatwy w użyciu interfejs API do przesyłania zadań indeksowania i uzyskiwania wyników. Aby uzyskać więcej informacji na temat Firecrawl, odwiedź firecrawl.dev , wprowadź adres URL witryny, którą chcesz przeskanować, i kliknij Uruchom.

Które narzędzie Open Source jest optymalne dla tworzenia stron internetowych?

Dostępnych jest mnóstwo narzędzi open-source do tworzenia stron internetowych. Do edycji kodu rozważ Visual Studio Code lub Atom. Jeśli potrzebujesz frameworków front-end, Bootstrap i Vue.js to doskonałe wybory, podczas gdy Django i Express.js dobrze sprawdzają się w tworzeniu back-end. Ponadto platformy takie jak Git, GitHub, Figma, GIMP, Slack i Trello również oferują opcje open-source, które mogą usprawnić Twój przepływ pracy w tworzeniu stron internetowych.

Czy modele GPT typu Open Source są dostępne?

Tak, istnieją różne modele GPT typu open source, w tym GPT-Neo firmy EleutherAI, Cerebras-GPT, BLOOM, OpenAI’s GPT-2 i NVIDIA/Microsoft’s Megatron-Turing NLG. Modele te zapewniają szereg rozwiązań, które spełniają różne wymagania, od przetwarzania języka ogólnego przeznaczenia po modele opracowane pod kątem możliwości wielojęzycznych lub zadań o wysokiej wydajności.

Dodaj komentarz