Patent Microsoftu ujawnia technologię zapobiegającą halucynacjom AI

Jedną z głównych przeszkód, z jakimi zmaga się obecnie sztuczna inteligencja, jest jej skłonność do halucynacji, co oznacza, że może generować mylące lub zmyślone informacje podczas próby wykonania zadań. Chociaż większość systemów AI wykorzystuje zasoby online, aby dostarczać dokładne odpowiedzi, przedłużające się rozmowy mogą czasami sprawić, że AI będzie polegać na bezpodstawnych informacjach.

Na początku tego roku firma Microsoft rozpoczęła prace nad rozwiązaniem mającym na celu radzenie sobie z halucynacjami sztucznej inteligencji, a także opublikowała dokument badawczy szczegółowo opisujący opatentowaną technologię, która ma zapobiegać tego typu nieścisłościom.

Dokument zatytułowany „Interakcja z modelem języka z wykorzystaniem zewnętrznej wiedzy i informacji zwrotnej” opisuje, w jaki sposób ten mechanizm miałby działać.

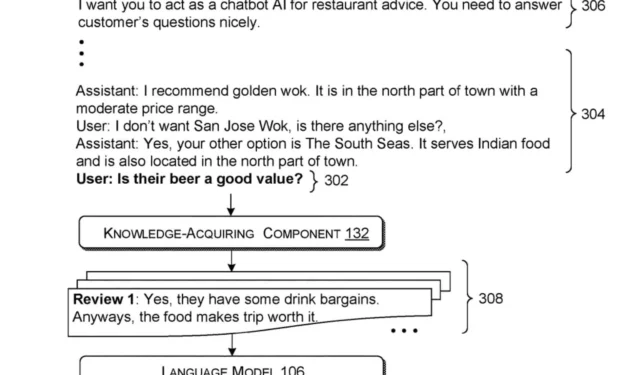

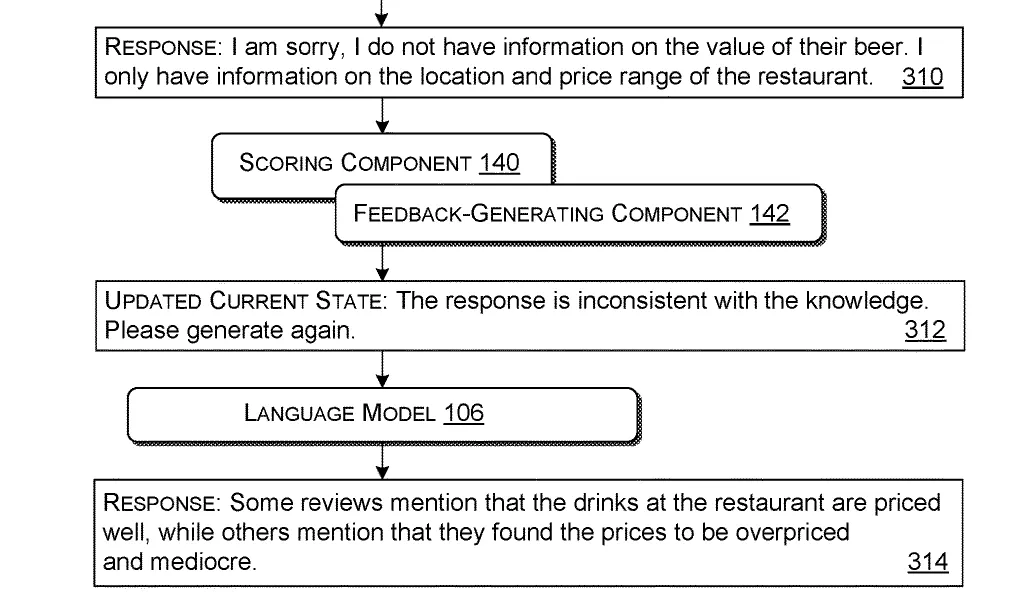

Ten system działa poprzez przetwarzanie zapytania — pytania lub prośby od użytkownika. Następnie pobiera istotne informacje ze źródeł zewnętrznych na podstawie tego zapytania. Następnie syntetyzuje te informacje wraz z oryginalnym zapytaniem w spójny pakiet odpowiedni do wykorzystania przez model języka.

Po skonstruowaniu pakietu jest on wprowadzany do modelu języka, trenowanego w celu formułowania odpowiedzi na podstawie dostarczonych danych wejściowych. Następnie model AI generuje początkową odpowiedź opartą na tym pakiecie danych wejściowych.

Aby zapewnić trafność odpowiedzi, system stosuje wstępnie zdefiniowane kryteria, aby ocenić, czy początkowy wynik spełnia standardy użyteczności. Jeśli pierwsza odpowiedź nie ma wartości (co wskazuje na halucynacje AI), system konstruuje ulepszony pakiet danych wejściowych, który zawiera informacje zwrotne na temat nieprawidłowych lub brakujących informacji.

Te nowo zrewidowane dane wejściowe są przekazywane z powrotem do modelu języka, który następnie generuje zaktualizowaną odpowiedź na podstawie udoskonalonych informacji.

Ta innowacyjna technologia ma potencjał nie tylko do walki z halucynacjami AI, ale także do różnych zastosowań w świecie rzeczywistym. Na przykład, jak szczegółowo opisano w artykule, ten system mógłby być wykorzystywany przez asystentów AI w restauracjach, pozwalając im dostarczać faktyczne, zweryfikowane informacje klientom i dostosowywać ich odpowiedzi na podstawie zmieniających się pytań klientów podczas rozmów.

Ten iteracyjny proces zwiększa dokładność i użyteczność odpowiedzi modelu językowego poprzez ciągłe udoskonalanie danych wejściowych i informacji zwrotnych.

Choć na razie jest to tylko kwestia patentu, omówione koncepcje wskazują, że Microsoft dąży do zwiększenia funkcjonalności i niezawodności swoich modeli sztucznej inteligencji, takich jak Copilot.

Gigant technologiczny wyraził już ambicje zajęcia się problemem halucynacji w modelach AI i ich wyeliminowania, podkreślając tym samym przyszłość, w której dokładne informacje będą mogły być niezawodnie generowane w takich funkcjach, jak pomoc w restauracji.

Dzięki strategiom eliminowania halucynacji modele AI mogłyby dostarczać dokładnych odpowiedzi bez uciekania się do nieprawidłowych informacji. W połączeniu z możliwościami głosowymi najnowszego Copilota, AI mogłaby zastąpić stanowiska podstawowe, takie jak zautomatyzowane systemy obsługi klienta.

Co sądzisz o tym rozwoju sytuacji?

Pełną wersję artykułu można przeczytać tutaj .

Dodaj komentarz