Przegląd zaawansowanego trybu głosowego ChatGPT: oczekiwania kontra rzeczywistość

Najważniejsze wnioski

- W trybie ChatGPT Advanced Voice Mode brakuje kilku istotnych funkcji, w tym obsługi wielu trybów i funkcji hold-to-speak, co czasami może sprawiać, że tryb ten nie nadaje się do użytku z powodu nadmiernej cenzury.

- Jednakże może pochwalić się imponującą ekspresją, potrafi mówić wieloma językami, akcentami i dialektami regionalnymi, chociaż nie potrafi śpiewać, nucić ani flirtować (jak nakazuje OpenAI).

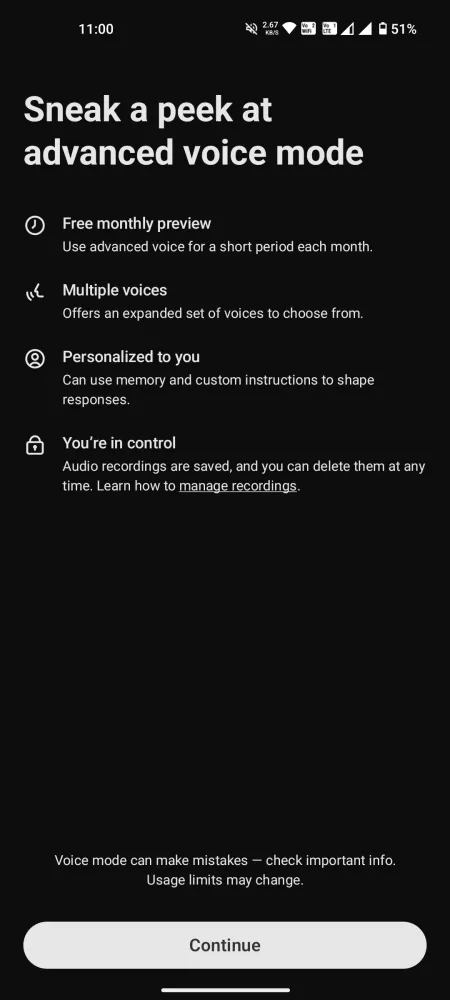

- Funkcja czatu jest dostępna dla użytkowników bezpłatnych przez zaledwie 15 minut miesięcznie, natomiast użytkownicy konta Plus podlegają ścisłemu limitowi 1 godziny dziennie.

Po obejrzeniu wstępnej demonstracji, ekscytacja wokół trybu ChatGPT Advanced Voice Mode była namacalna. Jednak po różnych wyzwaniach prawnych i późniejszych opóźnieniach funkcja ta pozostaje znacznie ograniczona, brakuje jej podstawowych funkcjonalności i zawiera pewne nieporozumienia, które odciągają uwagę od oczekiwanego doświadczenia.

Pomimo ograniczonego czasu oferowanego przez OpenAI na codzienne interakcje, użytkownicy mogą wyrobić sobie przyzwoite zrozumienie jego mocnych i słabych stron oraz możliwości. Oto moje szczere wrażenia na temat trybu Advanced Voice Mode ChatGPT, podkreślające jego zalety, wady i powody, dla których wizja posiadania charyzmatycznego asystenta głosowego może być wciąż odległą rzeczywistością.

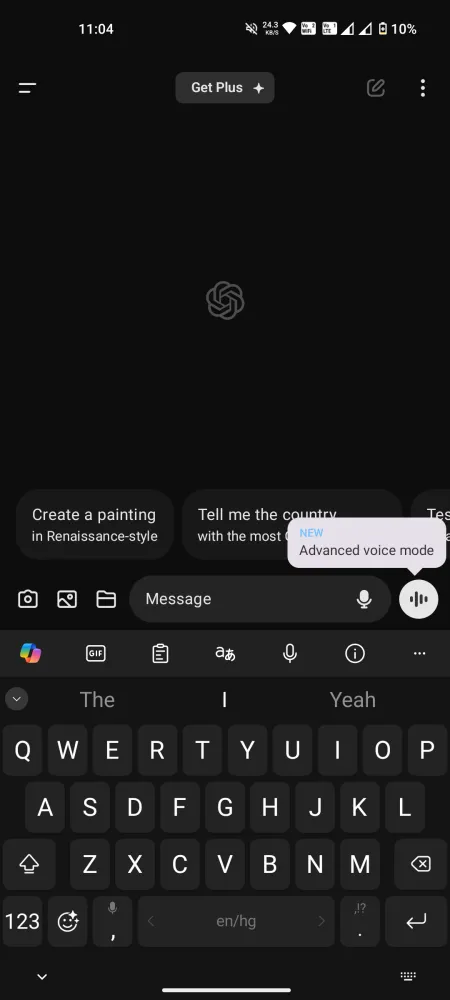

Uniwersalny dostęp do zaawansowanego trybu głosowego, ale brak kluczowych funkcji

Wprowadzenie Advanced Voice Mode w aplikacji mobilnej ChatGPT pozwala teraz wszystkim użytkownikom korzystać z tego innowacyjnego modelu głos-głos. Darmowe konta są ograniczone do 15 minut użytkowania miesięcznie , podczas gdy użytkownicy Plus mogą korzystać z około godziny dziennie , podlegając różnym dziennym limitom w zależności od dostępności serwera. Po osiągnięciu tego czasu konieczne jest przejście na mniej ekscytujący tryb głosowy Standard.

Zanim zaczniesz rozmowę, ważne jest, aby zarządzać swoimi oczekiwaniami. Wiele funkcji reklamowanych podczas wersji zapoznawczej jest obecnie niedostępnych zarówno dla kont bezpłatnych, jak i Plus. Obecnie tryb Advanced Voice Mode nie jest multimodalny , nie ma możliwości interpretowania dźwięków ani analizowania obrazów i filmów. Nie potrafi czytać z fizycznych książek ani rozpoznawać gestów, takich jak podnoszenie palca, ani śpiewać ani identyfikować instrumentów muzycznych, takich jak gitara. Liczne obiecane możliwości nadal nie są dostępne.

Zalety trybu Advanced Voice

Mimo że nie spełnia wszystkich oczekiwań, Advanced Voice Mode ChatGPT odnosi sukces w niektórych obszarach. Oto kilka godnych uwagi pozytywnych aspektów:

Różne opcje głosowe, ale brak nieba

Użytkownicy mają dostęp do wyboru dziewięciu różnych głosów:

- Sol (F) – Zrelaksowany i zorientowany

- Ember (M) – Optymistyczna i pewna siebie

- Arbor (M) – wszechstronny i łatwy w obsłudze

- Vale (F) – Ciekawa i jasna

- Klon (F) – szczery i wesoły

- Jałowiec (F) – optymistyczny i otwarty

- Cove (M) – Bezpośredni i opanowany

- Świerk (M) – potwierdzający i uspokajający

- Breeze (M/K) – poważny i ożywiony

W tym miksie brakuje Sky, ale pozostałe głosy okazują się bogate i angażujące. Wygląda na to, że Sky nie jest już opcją, więc kontynuujmy.

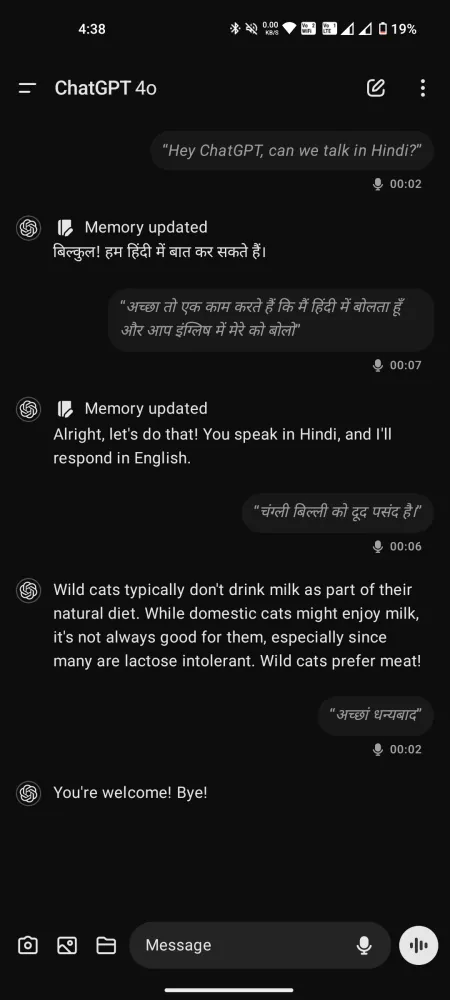

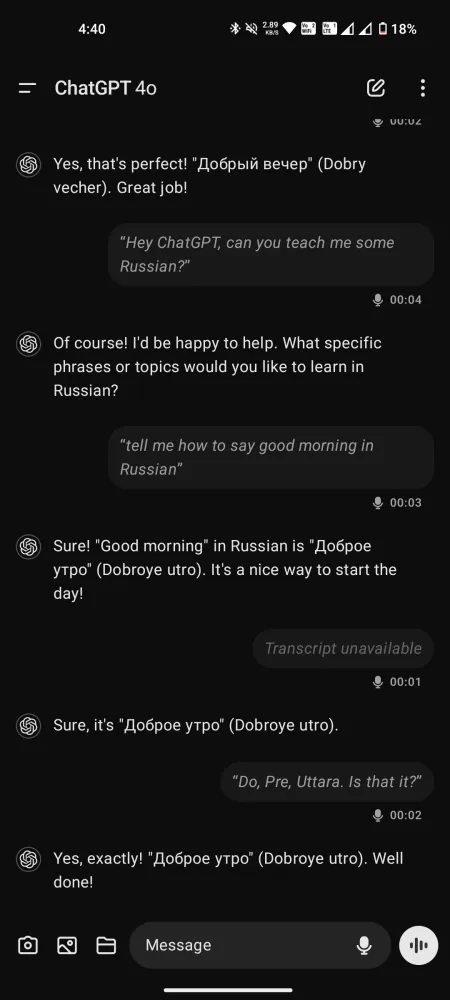

Wielojęzyczny konwersacjonalista z ekspresją

Pomimo wszelkich krytyk dotyczących trybu Advanced Voice Mode, jego wydajność nie może być przeceniona — szczególnie w porównaniu do trybu standardowego, w którym występuje minimalne opóźnienie dla płynnych rozmów. Potrafi zrozumieć i mówić w ponad 50 językach, a nawet dobrze sprawdza się jako trener mowy, tłumacz lub instruktor języka.

Choć może nie naśladować głosów, na życzenie może pokazywać różne akcenty, dostosowując się do szeregu dialektów, od południowoamerykańskiego do brytyjskiego cockney, i wszystkiego pomiędzy.

W porównaniu do Gemini Live interakcje z tymi głosami wydają się mniej pospieszne, dzięki czemu doświadczenie staje się bardziej uważne i wspierające.

Czy ChatGPT rozumie emocje?

To jest przedmiotem debaty. Podczas gdy OpenAI twierdzi, że ChatGPT może postrzegać ton i emocje mówcy, opinie użytkowników są różne. Niektórzy uważają, że ChatGPT naprawdę rozumie te aspekty, podczas gdy inni twierdzą, że po prostu wywnioskowuje ton na podstawie wyboru słów i wskazówek kontekstowych.

Jeden z użytkowników zasugerował, że zamiast transkrybować słowa mówione bezpośrednio dla GPT-4o, dźwięk jest konwertowany na tekst przed przetworzeniem. Oznacza to, że ton i emocje przekazywane za pomocą głosu lub wzorców oddechu mogą nie przekładać się dobrze na formę tekstową.

Ponadto, ponieważ Advanced Voice Mode może wykorzystywać GPT-4 — który przetwarza tekst na głos, ale nie głos na głos — rzuca to cień wątpliwości na to, czy ChatGPT naprawdę rozumie emocjonalne niuanse. Inni jednak twierdzą, że wykazuje pewne zrozumienie. Wydaje się, że temat ten pozostaje otwarty na dalsze badania.

Ograniczenia trybu głosowego ChatGPT Advanced Voice Mode

Przejdźmy teraz do sedna. Niezależnie od tego, jak atrakcyjna może być ta koncepcja, nasze rzeczywiste doświadczenia z nią ujawniają poważne niedociągnięcia. Oto ich analiza.

Nadmierna cenzura i ograniczenia

Podobnie jak wiele chatbotów AI, ChatGPT ma tendencję do błądzenia po stronie ostrożności, co czasami może oznaczać nadmierną cenzurę. Chociaż rozsądnie jest nie pozwalać AI na formułowanie opinii lub wygłaszanie prowokacyjnych komentarzy, bariery bezpieczeństwa są ustawione tak restrykcyjnie, że Advanced Voice Mode może odmówić odpowiedzi nawet na podstawowe pytania.

Podczas gdy nowi użytkownicy mogą nie napotkać tych problemów od razu, użytkownicy Plus z wydłużonym czasem czatu prawdopodobnie będą okresowo spotykać się z takimi odmowami. Frustrujące jest wiedzieć, że Twoje prośby mogą zostać odrzucone, pozostawiając Cię bez pożądanej odpowiedzi.

Niesamowicie niski próg przerwania

Wielu użytkowników zauważyło, że próg przerwania w modelu jest zaskakująco niski. Nawet krótkie przerwy powodują, że ChatGPT zakłada, że teraz „nadszedł czas” na odpowiedź. Jeśli zatrzymasz się na dłużej niż sekundę, ChatGPT włączy się. Ta wada konstrukcyjna może utrudniać głębsze konwersacje, ponieważ wszyscy potrzebujemy chwili na zastanowienie się, zanim odpowiemy.

Wielokrotne przerywanie i przeformułowywanie pytań może zaburzyć proces myślenia, co prowadzi do powierzchownych dialogów. Można to łatwo rozwiązać, włączając funkcję hold-to-speak.

Niestety, opcja hold-to-speak dostępna w trybie Standard jest nieobecna w wersji Advanced. Użytkownicy mają dostęp tylko do przycisków Mute i End call. W rezultacie, bez możliwości zatrzymania się na dłużej, Twoje prośby mogą zostać przedwcześnie przerwane.

W porównaniu do bardziej złożonych problemów, takich jak ograniczenia treści, ten aspekt wydaje się łatwiejszy do rozwiązania. Samo dodanie opcji hold-to-speak mogłoby znacznie poprawić doświadczenie użytkownika.

Dostęp do transkryptu ma swoje zalety, ale niektóre odpowiedzi mogą zostać pominięte, nawet jeśli ChatGPT zrozumiał pytanie i udzielił odpowiedzi.

Inne dziwne i niewyjaśnione anomalie

Użytkownicy zgłaszali dziwne i czasami niepokojące doświadczenia podczas korzystania z trybu Advanced Voice Mode w ChatGPT. Na przykład model inicjował rozmowy w języku hiszpańskim bez wcześniejszych interakcji w tym języku.

Jeden z użytkowników wspomniał, że ChatGPT czasami „wrzeszczał znikąd” lub mówił tonem robota i zupełnie innym głosem.

Te zdarzenia mogą wynikać z halucynacji w modelu głosu lub wskazywać na coś zupełnie niepokojącego. Niezależnie od tego, sytuacja wymaga uwagi.

Ostatnie przemyślenia

Pomimo opóźnionego pojawienia się, ChatGPT Advanced Voice Mode nie służy obecnie jako praktyczne rozwiązanie do codziennych interakcji. Raczej wydaje się bardziej rozbudowanym eksperymentem AI o znacznym niewykorzystanym potencjale.

Ze względu na ograniczenia co do tematyki i inne ograniczenia, tryb Advanced Voice Mode nadal znajduje się w początkowej fazie rozwoju i brakuje mu wielu funkcji zaprezentowanych podczas premiery promocyjnej.

Choć obawy dotyczące tworzenia przez użytkowników emocjonalnych więzi z głosami AI mogą być uzasadnione, OpenAI może przeceniać obecne możliwości. Ulepszenia w UI i ograniczeniach czatu z pewnością mogą znacznie poprawić doświadczenie.

W tej chwili niewiele wyróżnia Advanced Voice Mode na tle konkurencji. Jeśli już, to wypada słabo w porównaniu do Gemini Live, który mimo swoich problemów pozostaje bardziej dostępny dla każdego.

Dodaj komentarz