Instrukcja krok po kroku instalacji LLaMA 3 na komputerze z systemem Windows 11

Llama 3 to najnowszy postęp Meta w zakresie dużych modeli językowych, idealny do szerokiej gamy zastosowań, w tym odpowiadania na pytania, pomocy w zadaniach akademickich i wielu innych. Po skonfigurowaniu Llama 3 na urządzeniu z systemem Windows 11 możesz uzyskać do niego dostęp w dowolnym momencie, nawet bez połączenia z Internetem. Ten przewodnik pokaże, jak skonfigurować Llama 3 na komputerze z systemem Windows 11 .

Instalowanie Llama 3 na komputerze z systemem Windows 11

Proces instalacji Llama 3 na urządzeniu z systemem Windows 11 przy użyciu Pythona wymaga pewnego poziomu biegłości technicznej. Niemniej jednak istnieją alternatywne metody, które upraszczają lokalne wdrażanie Llama 3. Przedstawię te techniki.

Aby zainstalować Llama 3, musisz uruchomić określone polecenia w wierszu poleceń. Należy pamiętać, że to przyzna dostęp tylko do wersji wiersza poleceń; do korzystania z interfejsu internetowego wymagane są dodatkowe kroki. Oba procesy zostaną omówione tutaj.

Konfigurowanie Llama 3 w systemie Windows 11 za pomocą CMD

Najpierw musisz zainstalować Ollamę na komputerze z systemem Windows, aby wdrożyć Llamę 3. Wykonaj następujące kroki:

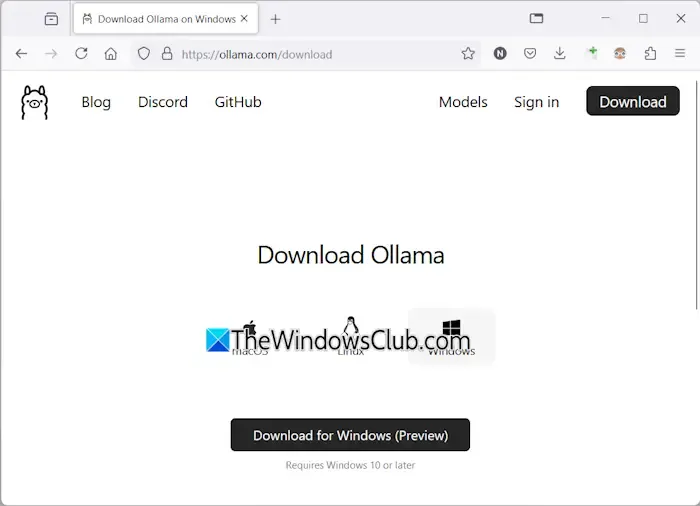

- Przejdź do oficjalnej strony Ollama .

- Wybierz opcję Pobierz , a następnie wybierz Windows .

- Kliknij Pobierz dla systemu Windows, aby zapisać plik wykonywalny na swoim komputerze.

- Uruchom pobrany plik exe, aby zainstalować Ollamę na swoim urządzeniu.

Po pomyślnym zainstalowaniu Ollama, uruchom ponownie komputer. Powinien działać w tle, widoczny w zasobniku systemowym. Następnie odwiedź sekcję Modele na stronie Ollama, aby wyświetlić dostępne modele.

Model Llama 3.1 oferowany jest w trzech konfiguracjach:

- 8B

- 70B

- 405B

Konfiguracja 405B jest najbardziej wymagająca i może nie działać na maszynie niższej klasy. Llama 3.2 oferuje dwie opcje:

- 1B

- 3B

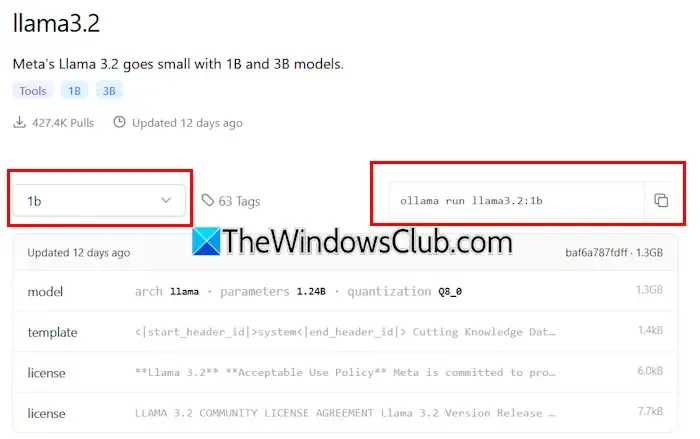

Wybierz wersję Llama do instalacji — jeśli zdecydujesz się na Llama 3.2, kliknij ją. W rozwijanym menu wybierz żądaną konfigurację. Następnie skopiuj polecenie wyświetlane obok niego i wklej je do wiersza poleceń.

Oto polecenia dla modelu Llama 3.2:

ollama run llama3.2:3b

Aby zainstalować konfigurację Llama 3.2 1B, wprowadź:

ollama run llama3.2:1b

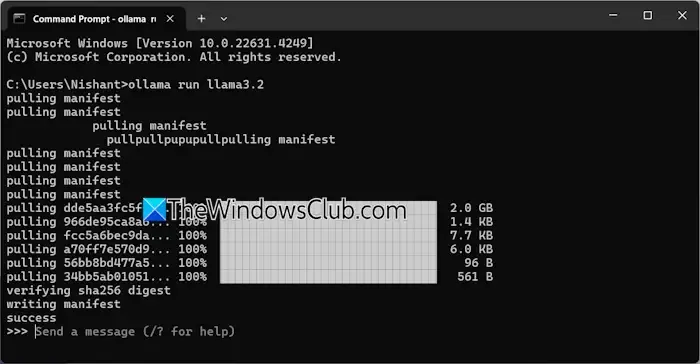

Otwórz wiersz poleceń, wpisz jedno z powyższych poleceń zgodnie ze swoimi potrzebami i naciśnij Enter . Proces pobierania potrwa chwilę, w zależności od połączenia internetowego. Po zakończeniu w wierszu poleceń pojawi się komunikat o powodzeniu .

Następnie możesz wpisać swoje dane wejściowe, aby wejść w interakcję z modelem Llama 3.2. Aby zainstalować model Llama 3.1, użyj poleceń dostępnych na stronie internetowej Ollama.

Następnym razem, gdy otworzysz wiersz polecenia, możesz użyć tego samego polecenia, aby uruchomić Lamę 3.1 lub 3.2.

Jednym z ograniczeń instalacji Llama 3 za pośrednictwem CMD jest brak zapisanej historii czatu. Jednak wdrożenie jej za pośrednictwem lokalnego hosta umożliwia zapisanie historii czatu, a także zapewnia ulepszony interfejs użytkownika. Poniższa sekcja opisuje, jak to osiągnąć.

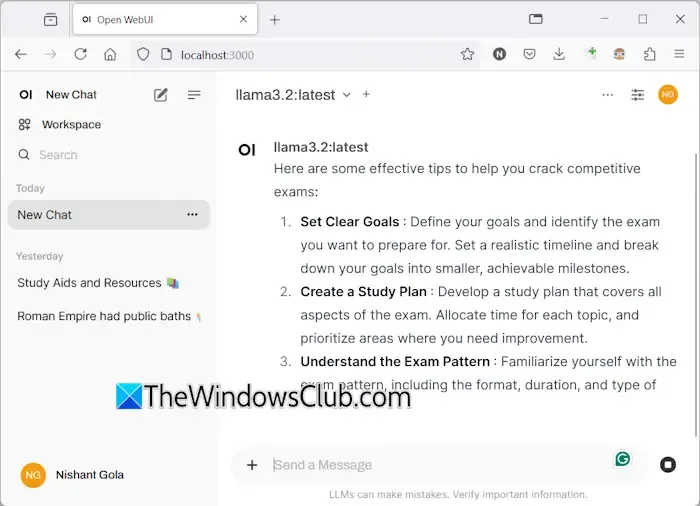

Wdrażanie Llama 3 z interfejsem użytkownika sieci Web w systemie Windows 11

Korzystanie z Llama 3 za pośrednictwem przeglądarki internetowej nie tylko poprawia wrażenia użytkownika, ale także zachowuje historię czatu, funkcję niedostępną podczas korzystania z CMD. Oto jak uruchomić Llama 3 w przeglądarce internetowej.

Aby uzyskać dostęp do Llama 3 za pośrednictwem przeglądarki internetowej, upewnij się, że zarówno Llama 3 przez Ollama, jak i Docker są skonfigurowane w Twoim systemie. Jeśli nie zainstalowałeś Llama 3, kontynuuj instalację Ollama, jak opisano wcześniej. Następnie pobierz i zainstaluj Docker z jego oficjalnej strony internetowej .

Po zainstalowaniu Dockera otwórz go i zakończ proces rejestracji, aby utworzyć konto, ponieważ Docker nie zostanie uruchomiony bez niego. Po zalogowaniu zminimalizuj Dockera do zasobnika systemowego; upewnij się, że Docker i Ollama są aktywne w tle, aby korzystać z Llama 3 za pośrednictwem przeglądarki internetowej.

Otwórz wiersz poleceń, skopiuj poniższe polecenie i wklej je:

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

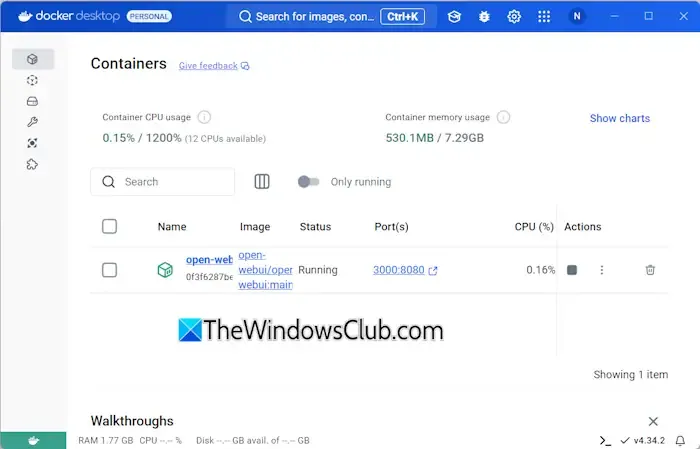

To polecenie zajmie trochę czasu, aby pobrać niezbędne pliki, więc bądź cierpliwy. Po zakończeniu otwórz Docker i przejdź do sekcji Kontenery po lewej stronie. Powinieneś zobaczyć kontener utworzony automatycznie dla portu 3000:8080.

Kliknij na port 3000:8080, co spowoduje otwarcie nowej karty w domyślnej przeglądarce internetowej. Może być konieczne zarejestrowanie się i zalogowanie, aby korzystać z Llama 3 za pośrednictwem przeglądarki internetowej. Jeśli sprawdzisz pasek adresu, pokaże on localhost:3000, co oznacza, że Llama 3 jest hostowana lokalnie, co pozwala na korzystanie bez dostępu do Internetu.

Wybierz preferowany model czatu Llama z menu rozwijanego. Aby włączyć dodatkowe modele czatu Llama 3, zainstaluj je za pomocą Ollama, używając odpowiednich poleceń; będą one dostępne w Twojej przeglądarce.

Historia czatu zostanie zapisana i będzie dostępna po lewej stronie. Po zakończeniu wyloguj się z sesji w przeglądarce internetowej, a następnie otwórz Docker i naciśnij przycisk Stop , aby go wyłączyć przed zamknięciem Dockera.

Następnym razem, gdy będziesz chciał uzyskać dostęp do Llama 3 w przeglądarce internetowej, uruchom zarówno Ollama, jak i Docker, odczekaj kilka minut, a następnie kliknij port w kontenerze Docker, aby uruchomić serwer localhost. Po zalogowaniu możesz rozpocząć korzystanie z Llama 3.

Mam nadzieję, że te informacje okażą się pomocne.

Czy Llama 3 działa w systemie Windows?

Możliwość uruchomienia Llama 3 na Twoim komputerze zależy od jego specyfikacji sprzętowych. Najlżejsza wersja, model 1B, może zostać zainstalowana i obsługiwana za pomocą wiersza poleceń.

Jaka ilość pamięci RAM jest wymagana dla Llama 3?

Aby uruchomić model Llama 3.2 1B, Twój system powinien być wyposażony w co najmniej 16 GB pamięci RAM i solidny procesor graficzny. Wyższe wersje Llama 3 będą wymagały jeszcze więcej zasobów od Twojego systemu.

Dodaj komentarz