6 narzędzi AI do web scrapingu, z których każdy może korzystać

Sztuczna inteligencja znacznie ułatwiła wiele zadań w ciągu ostatnich kilku lat, a web scraping jest jednym z nich. Ta lista przedstawia najlepsze narzędzia web scraping AI, których każdy może użyć, aby szybko i łatwo zbierać przydatne dane z niemal każdej publicznej witryny.

1. Chodź

Cena : Bezpłatna z opcjami premium

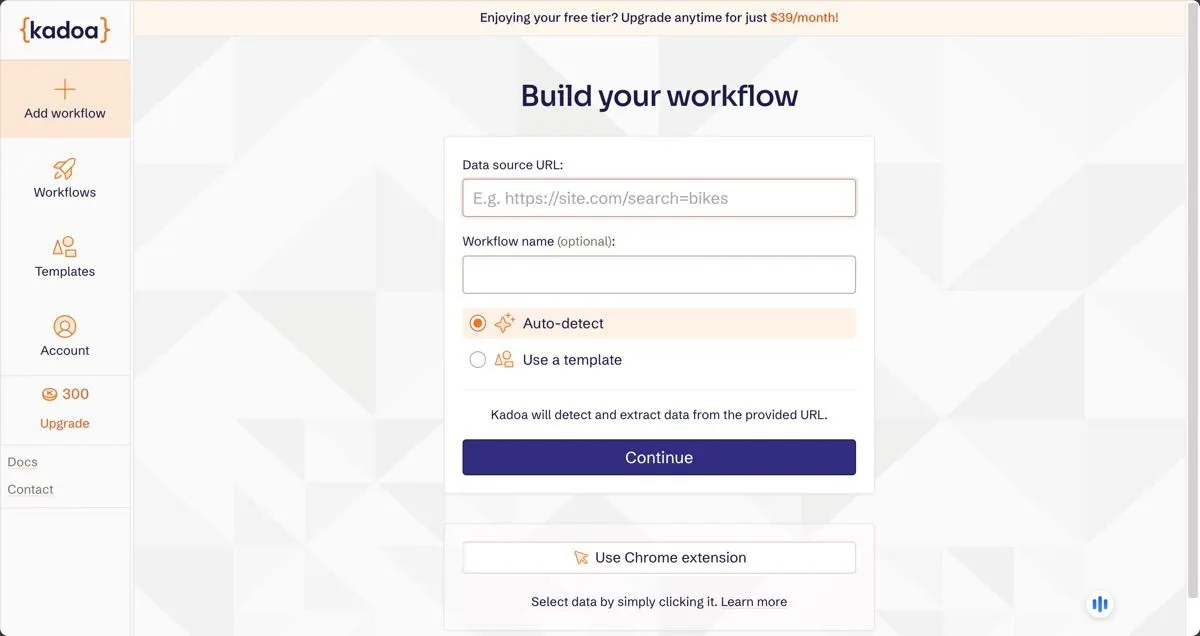

Jako ktoś, kto spędził sporo godzin na kodowaniu niestandardowych scraperów, byłem pod wrażeniem zdolności Kadoa do rozumienia i wyodrębniania danych z niestrukturyzowanych witryn przy minimalnej konfiguracji. To samo w sobie sprawia, że scrapowanie stron internetowych AI jest tak wspaniałym ulepszeniem w porównaniu do tradycyjnego scrapowania.

Intuicyjny interfejs pozwolił mi skonfigurować złożone zadania scrapowania bez pisania ani jednej linijki kodu, co czyni go doskonałym wyborem zarówno dla początkujących, jak i doświadczonych programistów, którzy chcą zaoszczędzić czas. Istnieje również rozszerzenie Chrome, które umożliwia wybieranie danych poprzez proste kliknięcie.

Podczas testów celowo wprowadziłem zmiany w niektórych docelowych witrynach, a sztuczna inteligencja Kadoa automatycznie je wykryła i dostosowała do nich. Sama ta funkcja może zaoszczędzić wiele godzin pracy konserwacyjnej, zwłaszcza w przypadku projektów scrapingu na dużą skalę.

2. Bardowie

Cena : Bezpłatna z opcjami premium

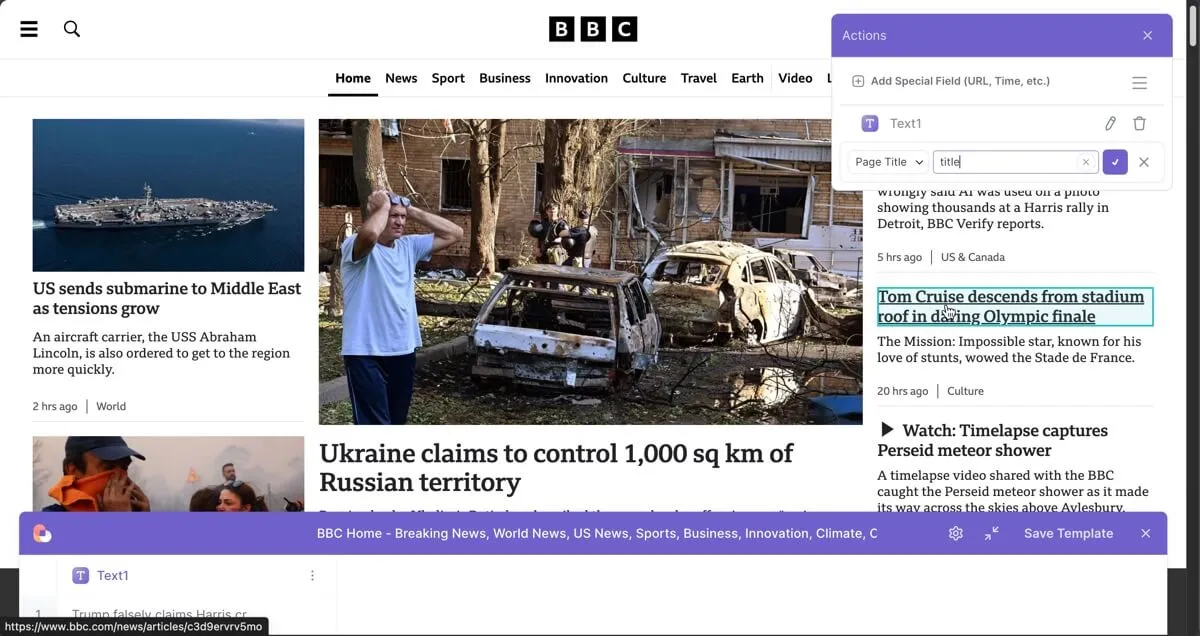

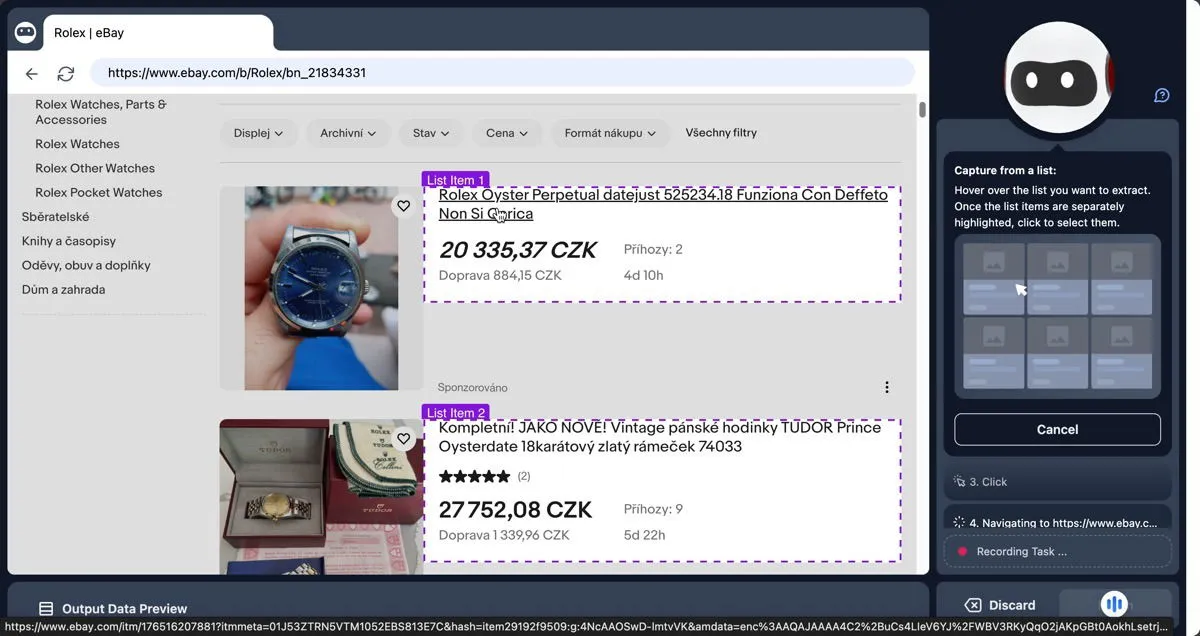

Bardeen zapewnił sobie miejsce na tej liście najlepszych narzędzi AI do scrapowania stron internetowych dzięki swoim agentom AI Browser. Ta funkcja pozwala wyodrębniać informacje ze stron internetowych za pomocą poleceń języka naturalnego, tak jak zrobiłby to człowiek.

Użyłem AI Browser Agent do zeskanowania lokalnej witryny informacyjnej i udało mi się z łatwością skonfigurować automatyzację, która zeskanowała dane z wyników wyszukiwania Google i automatycznie wypełniła dokument Arkuszy Google.

Choć Bardeen jest obecnie dostępny wyłącznie jako rozszerzenie do przeglądarki Chrome, co dla niektórych może być ograniczeniem, jego prostota i możliwości z nawiązką rekompensują to ograniczenie.

3. Przeglądaj AI

Cena : Bezpłatna z opcjami premium

Browse AI pozwala tworzyć niestandardowe web scrapery po prostu wchodząc w interakcję ze stronami internetowymi tak, jak zwykle. Rozszerzenie przeglądarki obserwuje Twoje działania i automatycznie generuje robota, który może powtarzać te kroki, co sprawia, że niezwykle łatwo jest wyodrębniać dane nawet z najbardziej wymagających stron internetowych.

Po zebraniu potrzebnych danych możesz liczyć na algorytmy uczenia maszynowego Browse AI, które automatycznie wykryją i poprawią nieścisłości w zebranych danych.

Rozpoczęcie korzystania z Browse AI jest niezwykle proste — proces jest tak zaprojektowany, że użytkownicy mogą rozpocząć pracę w ciągu około pięciu minut.

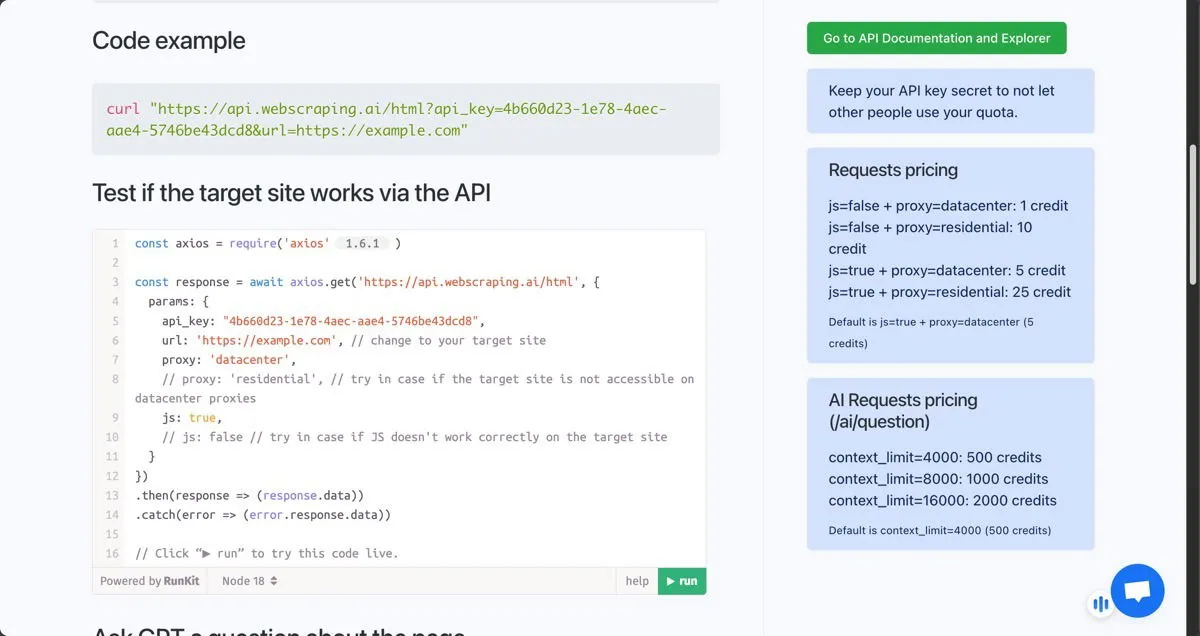

4. WebScraping.AI

Cena : Plan osobisty za 42 USD/miesiąc, plan Plus za 99 USD/miesiąc, plan startowy za 249 USD/miesiąc

WebScraping AI oferuje wydajną usługę scrapowania opartą na interfejsie API, dlatego lepiej nadaje się dla deweloperów i użytkowników obeznanych z technologią, którzy chcą mieć większą kontrolę nad procesami scrapowania, bez konieczności zajmowania się skomplikowanymi zagadnieniami zarządzania serwerami proxy i rozwiązywania testów CAPTCHA.

Ponieważ usługa ta korzysta z prawdziwych przeglądarek do renderowania stron, nawet wiele tradycyjnych środków zapobiegających scrapowaniu nie jest w stanie jej zatrzymać, a zeskrobana zawartość zawsze odzwierciedla to, co zobaczyłby użytkownik.

Byłem pod wrażeniem możliwości zadawania pytań WebScraping.AI na temat zeskrobanej strony i otrzymywania odpowiedzi generowanych przez AI. Należy pamiętać, że koszt tego narzędzia AI do zeskrobania stron internetowych jest mierzony w kredytach. Użytkownicy powinni jednak pamiętać, że chociaż ta integracja AI jest wydajna, zużywa więcej kredytów API niż standardowe żądania zeskrobania.

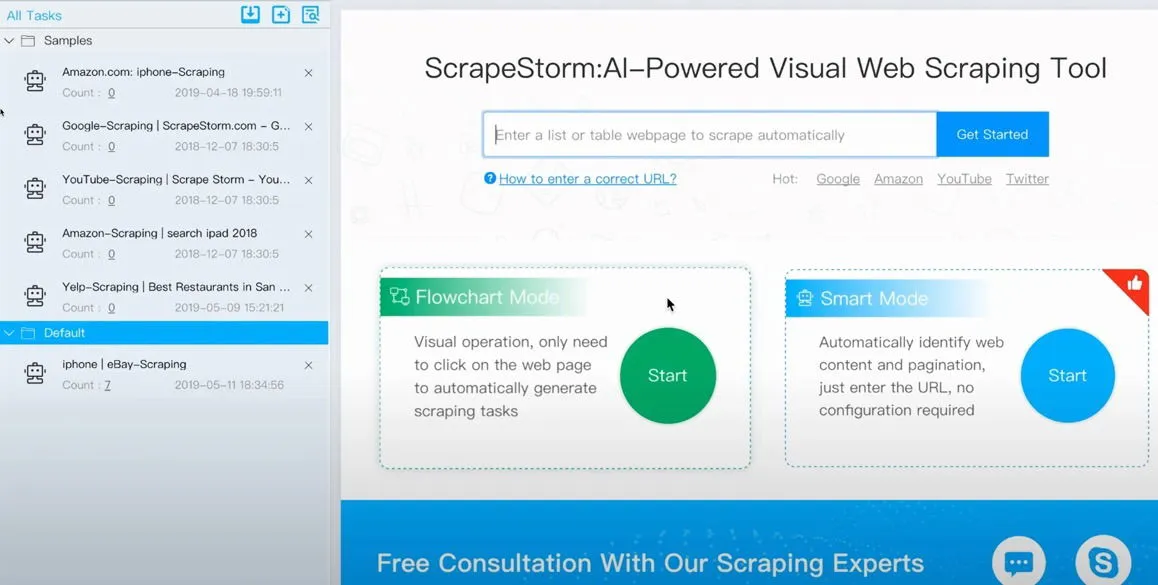

5. Zdrapywanie

Cena : Bezpłatna z opcjami premium

ScrapeStorm wyróżnia się na tle innych narzędzi, oferując aplikację na komputery stacjonarne dla systemów Windows, Mac i Linux. Stworzone przez byłych członków zespołu Google crawler, to narzędzie do wizualnego scrapowania stron internetowych oparte na sztucznej inteligencji łączy łatwość użytkowania Browse AI z mocą i elastycznością WebScraping AI.

Tryb Smart Mode w ScrapeStorm wykorzystuje algorytmy sztucznej inteligencji do automatycznego identyfikowania danych listy, danych tabelarycznych i przycisków paginacji bez ręcznej konfiguracji. Jest też tryb Flowchart Mode, który pozwala użytkownikom tworzyć reguły scrapowania poprzez wizualne operacje klikania.

ScrapeStorm umożliwia użytkownikom eksportowanie zeskrobanych danych do różnych formatów, w tym Excel, CSV, TXT i HTML, a także baz danych, takich jak MySQL, MongoDB i SQL Server. Ta elastyczność sprawia, że jest to doskonały wybór dla użytkowników, którzy muszą zintegrować zeskrobane dane z istniejącymi przepływami pracy lub bazami danych.

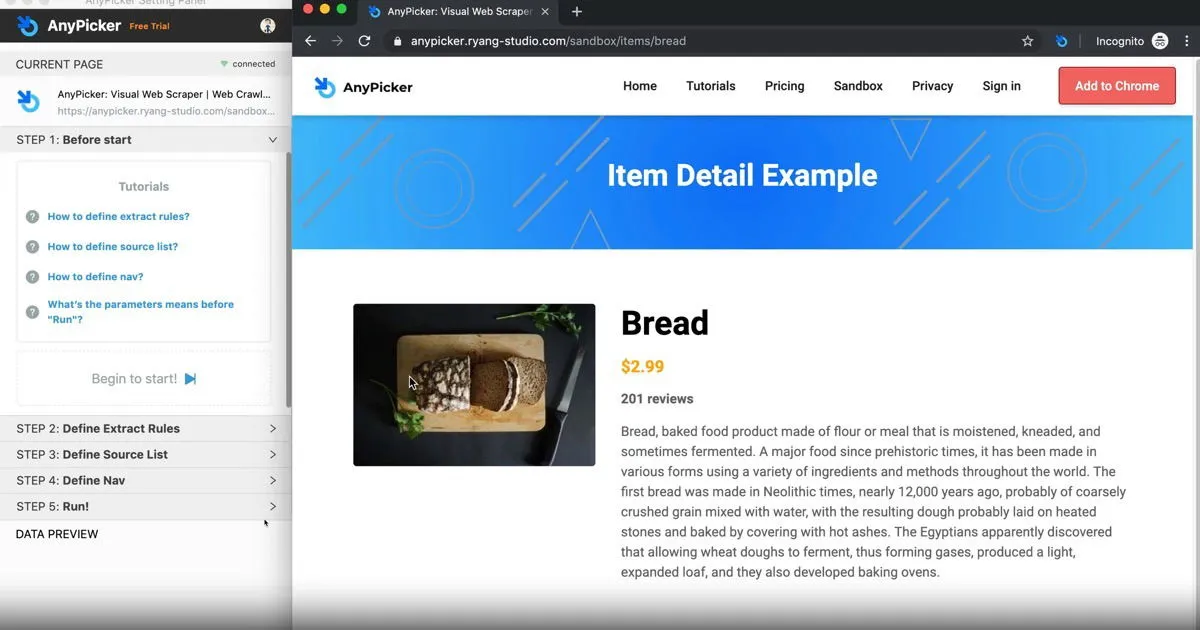

6. Dowolny selektor

Cena : Bezpłatna z opcjami premium

AnyPicker to rozszerzenie do przeglądarki Chrome, dzięki któremu możesz korzystać z funkcji web scrapingu wspomaganego sztuczną inteligencją bezpośrednio w swojej przeglądarce – zawsze wystarczy jedno kliknięcie.

Funkcja inteligentnego wykrywania oparta na sztucznej inteligencji automatycznie identyfikuje wzorce danych na stronach internetowych, dzięki czemu możesz łatwo wybrać i wyodrębnić potrzebne informacje. Witryny wymagające danych logowania nie stanowią problemu dla AnyPicker. Po prostu zaloguj się do witryny, którą chcesz zeskrobać, aktywuj AnyPicker i zacznij wyodrębniać dane.

Nie miałem żadnych problemów z tym oprogramowaniem, ale warto przetestować narzędzie, korzystając z bezpłatnego planu, zanim kupisz plan premium.

Zbuduj własne niestandardowe narzędzie AI do scrapowania stron internetowych

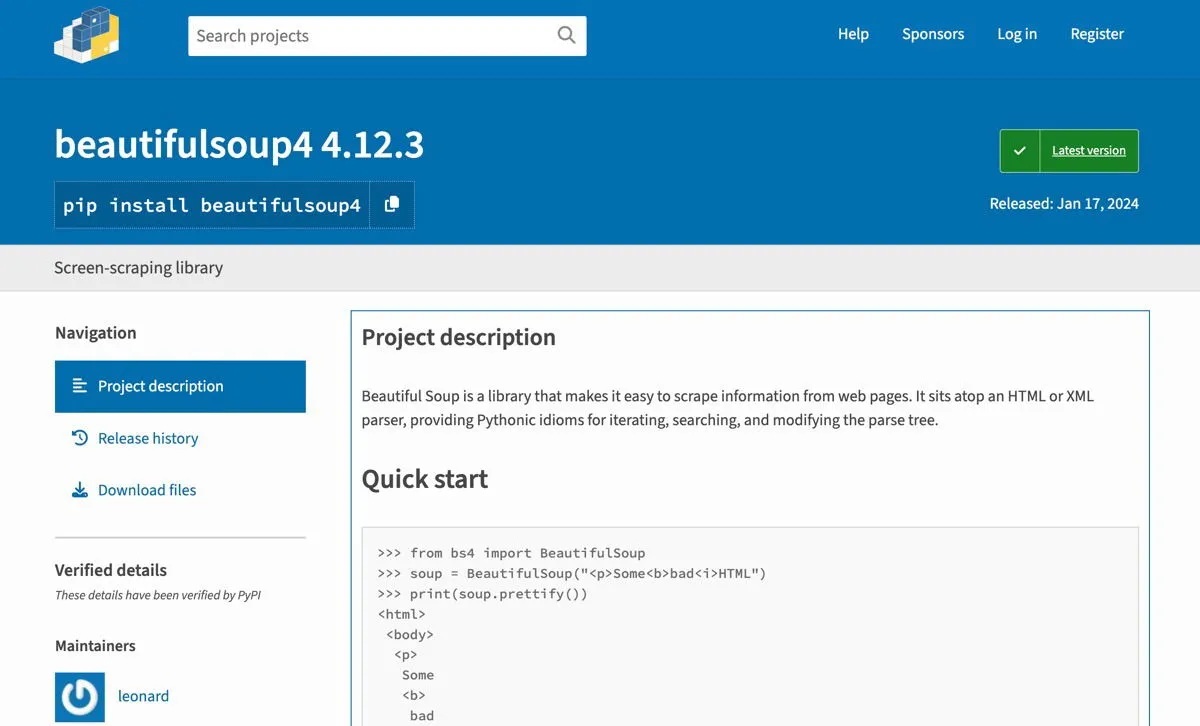

Osoby z doświadczeniem w programowaniu, które chcą mieć większą kontrolę nad procesem web scrapingu, mogą zbudować własne narzędzie do web scrapingu oparte na sztucznej inteligencji, łącząc tradycyjne biblioteki web scrapingu, takie jak Beautiful Soup , z nowoczesnymi sztuczkami inteligencji za pomocą interfejsów API, takich jak te od OpenAI lub Anthropic .

Podstawowy proces polega na użyciu Beautiful Soup do zeskrobania surowych danych ze stron internetowych, a następnie przesłaniu tych danych do API AI w celu przetworzenia. AI może pomóc w takich zadaniach, jak czyszczenie danych, rozpoznawanie jednostek, analiza sentymentów, a nawet generowanie podsumowań zeskrobanej zawartości.

Jeśli czytasz ten tekst, ponieważ jesteś właścicielem witryny internetowej i chcesz zabezpieczyć ją przed web scrapingiem, w tym przewodniku opisano kilka rozwiązań, które pomogą Ci zabezpieczyć witrynę przed web scrapingiem przy użyciu sztucznej inteligencji.

Źródło obrazu: DALL-E. Wszystkie zrzuty ekranu autorstwa Davida Morelo.

Dodaj komentarz