Stapsgewijze handleiding voor het installeren van LLaMA 3 op een Windows 11-pc

Llama 3 vertegenwoordigt Meta’s meest recente vooruitgang in grote taalmodellen, ideaal voor een breed scala aan toepassingen, waaronder het beantwoorden van vragen, het assisteren bij academische opdrachten en nog veel meer. Door Llama 3 op uw Windows 11-apparaat in te stellen, kunt u er altijd bij, zelfs zonder internetverbinding. Deze handleiding laat zien hoe u Llama 3 op uw Windows 11-computer instelt .

Llama 3 installeren op een Windows 11-computer

Het proces van het installeren van Llama 3 op uw Windows 11-apparaat met behulp van Python vereist een bepaald niveau van technische bekwaamheid. Niettemin bestaan er alternatieve methoden die de lokale implementatie van Llama 3 vereenvoudigen. Ik zal deze technieken schetsen.

Om Llama 3 te installeren, moet u specifieke opdrachten uitvoeren in de opdrachtprompt. Let op: dit geeft alleen toegang tot de opdrachtregelversie; er zijn aanvullende stappen vereist om de webinterface te gebruiken. Beide processen worden hier behandeld.

Llama 3 instellen op Windows 11 via CMD

Eerst moet u Ollama op uw Windows-computer installeren om Llama 3 te kunnen implementeren. Volg deze stappen:

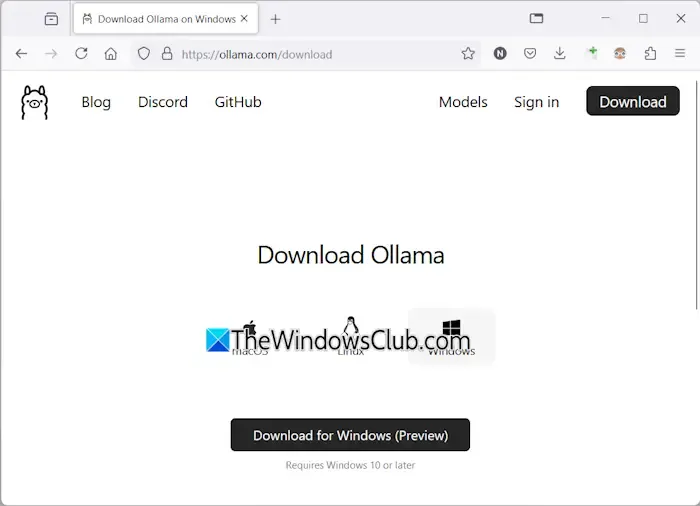

- Ga naar de officiële Ollama-website .

- Selecteer de optie Downloaden en kies vervolgens Windows .

- Klik op Downloaden voor Windows om het uitvoerbare bestand op uw computer op te slaan.

- Voer het gedownloade exe-bestand uit om Ollama op uw apparaat te installeren.

Nadat Ollama succesvol is geïnstalleerd, start u uw computer opnieuw op. Het zou op de achtergrond moeten draaien, zichtbaar in de System Tray. Ga vervolgens naar de sectie Models op de Ollama-website om beschikbare modellen te bekijken.

Het Llama 3.1-model is verkrijgbaar in drie configuraties:

- 8B

- 70B

- 405B

De 405B-configuratie is het meest veeleisend en werkt mogelijk niet op een low-end machine. Llama 3.2 biedt twee opties:

- 1B

- 3B

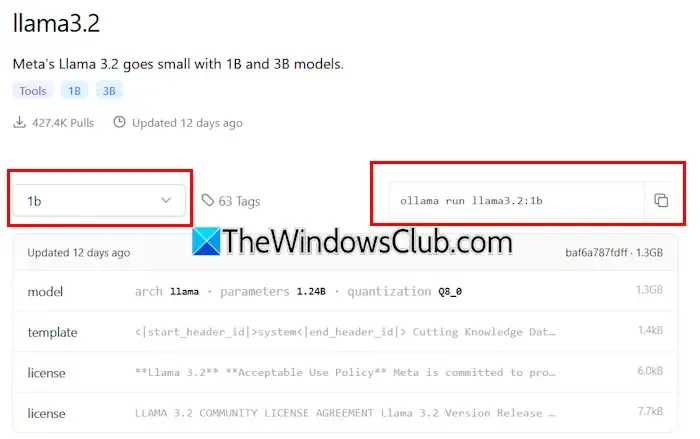

Kies een Llama-versie voor installatie: als u kiest voor Llama 3.2, klikt u erop. Selecteer in het vervolgkeuzemenu de gewenste configuratie. Kopieer vervolgens de opdracht die ernaast wordt weergegeven en plak deze in de opdrachtprompt.

Hier zijn de opdrachten voor het Llama 3.2-model:

ollama run llama3.2:3b

Om de Llama 3.2 1B-configuratie te installeren, voert u het volgende in:

ollama run llama3.2:1b

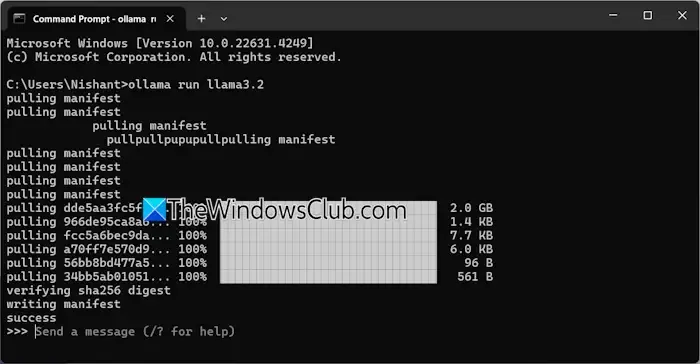

Open de opdrachtprompt, typ een van de bovenstaande opdrachten naar wens en druk op Enter . Het downloadproces duurt even, afhankelijk van uw internetverbinding. Na voltooiing verschijnt er een succesbericht in de opdrachtprompt.

U kunt vervolgens uw invoer typen om te communiceren met het Llama 3.2-model. Voor het installeren van het Llama 3.1-model gebruikt u de opdrachten die beschikbaar zijn op de Ollama-website.

De volgende keer dat u de Opdrachtprompt opent, kunt u dezelfde opdracht gebruiken om Llama 3.1 of 3.2 uit te voeren.

Eén beperking van het installeren van Llama 3 via CMD is het gebrek aan opgeslagen chatgeschiedenis. Echter, het implementeren via een lokale host zorgt ervoor dat uw chatgeschiedenis wordt opgeslagen, naast het bieden van een verbeterde gebruikersinterface. De volgende sectie beschrijft hoe u dit kunt bereiken.

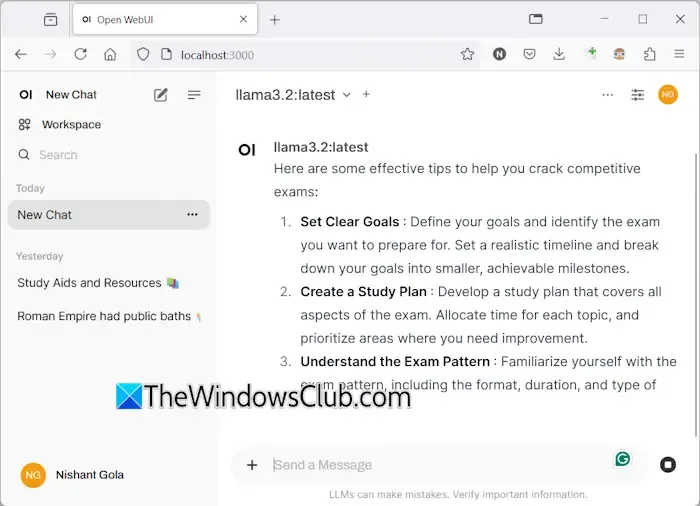

Llama 3 implementeren met een web-UI op Windows 11

Het gebruiken van Llama 3 via een webbrowser verbetert niet alleen de gebruikerservaring, maar bewaart ook de chatgeschiedenis, een functie die ontbreekt bij het gebruik van CMD. Hier leest u hoe u Llama 3 in uw webbrowser kunt laten draaien.

Om toegang te krijgen tot Llama 3 via een webbrowser, moet u ervoor zorgen dat zowel Llama 3 via Ollama als Docker op uw systeem zijn ingesteld. Als u Llama 3 niet hebt geïnstalleerd, gaat u verder met de installatie van Ollama zoals eerder beschreven. Download en installeer vervolgens Docker van de officiële website .

Nadat u Docker hebt geïnstalleerd, opent u het en voltooit u het registratieproces om een account aan te maken, aangezien Docker niet zonder Docker wordt gestart. Minimaliseer Docker na het aanmelden naar de systeemlade; zorg ervoor dat zowel Docker als Ollama op de achtergrond actief zijn om Llama 3 via uw webbrowser te gebruiken.

Open de opdrachtprompt, kopieer de volgende opdracht en plak deze:

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

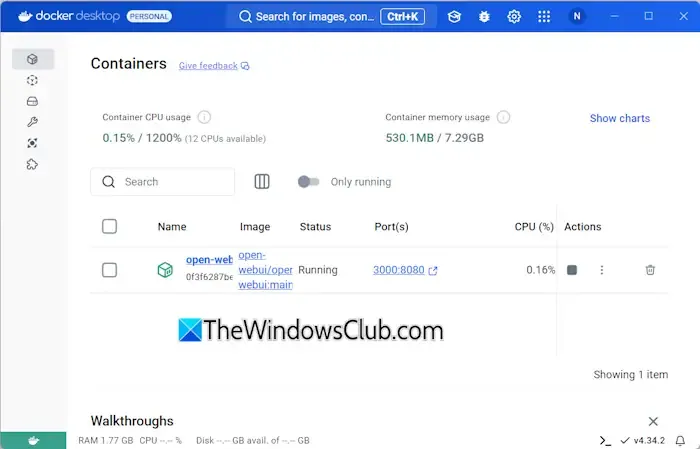

Het downloaden van de benodigde bestanden duurt even voor deze opdracht, dus wees geduldig. Zodra het is voltooid, opent u Docker en navigeert u naar de sectie Containers aan de linkerkant. U zou een container moeten zien die automatisch is gemaakt voor poort 3000:8080.

Klik op de poort 3000:8080, waarmee een nieuw tabblad in uw standaardwebbrowser wordt geopend. Mogelijk moet u zich registreren en inloggen om Llama 3 via de webbrowser te gebruiken. Als u de adresbalk controleert, ziet u localhost:3000, wat aangeeft dat Llama 3 lokaal wordt gehost, waardoor u het kunt gebruiken zonder internettoegang.

Selecteer uw favoriete Llama chatmodel uit het dropdownmenu. Om extra Llama 3 chatmodellen te integreren, installeert u ze via Ollama met de bijbehorende commando’s; ze zijn dan beschikbaar in uw browser.

Je chatgeschiedenis wordt opgeslagen en is aan de linkerkant op te halen. Wanneer je klaar bent, log je uit je sessie in de webbrowser, open je Docker en klik je op de knop Stop om het af te sluiten voordat je Docker sluit.

De volgende keer dat u Llama 3 in uw webbrowser wilt openen, start u zowel Ollama als Docker, wacht u een paar minuten en klikt u vervolgens op de poort in de Docker-container om de localhost-server te starten. Nadat u bent aangemeld, kunt u Llama 3 gaan gebruiken.

Ik hoop dat deze informatie nuttig is.

Kan Llama 3 op Windows draaien?

Of u Llama 3 op uw machine kunt draaien, hangt af van de hardwarespecificaties. De lichtste versie, het 1B-model, kan worden geïnstalleerd en bediend via de opdrachtprompt.

Hoeveel RAM is vereist voor Llama 3?

Om het Llama 3.2 1B-model te kunnen gebruiken, moet uw systeem zijn uitgerust met ten minste 16 GB RAM, samen met een robuuste GPU. Hogere varianten van Llama 3 zullen nog meer bronnen van uw systeem vergen.

Geef een reactie