Microsoft Patent onthult technologie om AI-hallucinaties te voorkomen

Een van de grootste obstakels waarmee kunstmatige intelligentie vandaag de dag te maken heeft, is de neiging om te hallucineren, wat betekent dat het misleidende of gefabriceerde informatie kan genereren tijdens het proberen om taken uit te voeren. Hoewel de meeste AI-systemen online bronnen gebruiken om nauwkeurige antwoorden te geven, kunnen langdurige gesprekken er soms toe leiden dat de AI vertrouwt op ongefundeerde informatie.

Eerder dit jaar begon Microsoft met de ontwikkeling van een oplossing om AI-hallucinaties aan te pakken. Ook heeft het bedrijf een onderzoekspaper gepubliceerd waarin een gepatenteerde technologie wordt beschreven die deze onnauwkeurigheden preventief moet voorkomen.

In het document met de titel ‘Interactie met een taalmodel met behulp van externe kennis en feedback’ wordt beschreven hoe dit mechanisme zou functioneren.

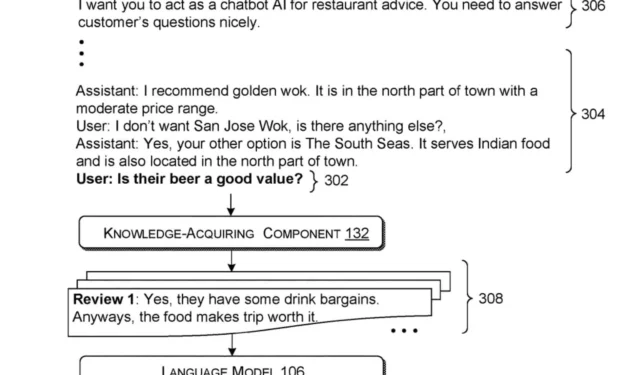

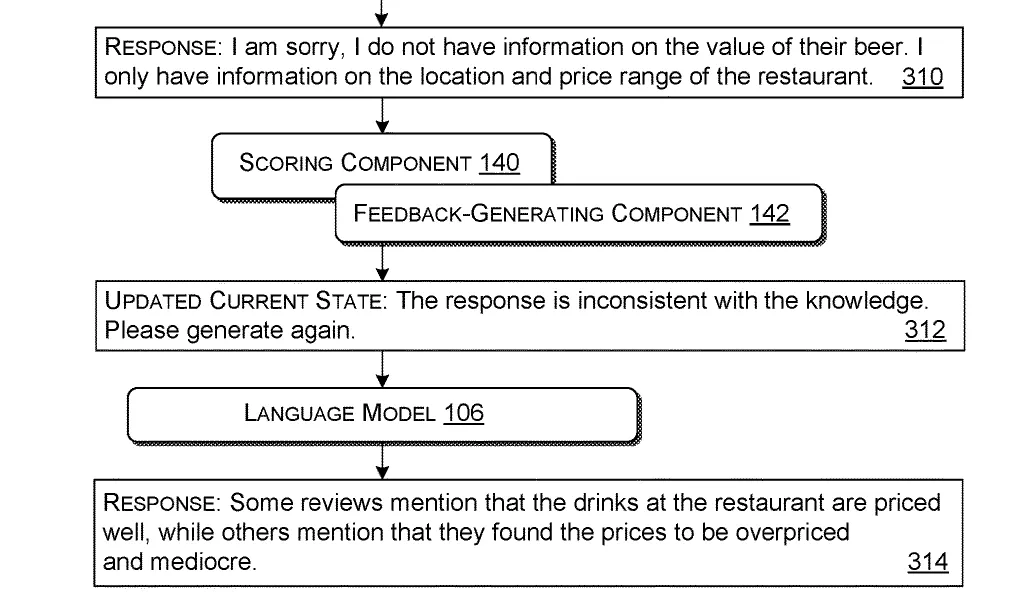

Dit systeem werkt door een query te verwerken: een vraag of verzoek van een gebruiker. Het haalt vervolgens relevante informatie op uit externe bronnen op basis van die query. Vervolgens synthetiseert het deze informatie samen met de originele query tot een samenhangend pakket dat geschikt is voor het taalmodel om te gebruiken.

Zodra het pakket is samengesteld, wordt het geïntroduceerd in het taalmodel, getraind om antwoorden te formuleren op basis van de verstrekte invoer. Het AI-model genereert vervolgens een eerste antwoord op basis van dit invoerpakket.

Om de relevantie van het antwoord te garanderen, gebruikt het systeem vooraf gedefinieerde criteria om te beoordelen of de initiële output voldoet aan de bruikbaarheidsnormen. Mocht het eerste antwoord waardeloos zijn (wat wijst op AI-hallucinaties), dan construeert het systeem een verbeterd pakket van input dat feedback bevat over de onjuiste of ontbrekende informatie.

Deze nieuw herziene invoer wordt teruggevoerd naar het taalmodel, dat vervolgens een bijgewerkt antwoord produceert op basis van deze verfijnde informatie.

Deze innovatieve technologie heeft niet alleen potentieel voor het bestrijden van AI-hallucinaties, maar ook voor verschillende toepassingen in de echte wereld. Zoals in het artikel wordt beschreven, kan dit systeem bijvoorbeeld worden gebruikt door AI-assistenten in restaurants, waardoor ze feitelijke, geverifieerde informatie aan klanten kunnen verstrekken en hun antwoorden kunnen aanpassen op basis van veranderende klantvragen tijdens gesprekken.

Dit iteratieve proces verbetert de nauwkeurigheid en bruikbaarheid van de reacties van het taalmodel door de invoer en feedback voortdurend te verfijnen.

Hoewel het momenteel nog om een patent gaat, suggereren de besproken concepten dat Microsoft zich inzet om de functionaliteit en betrouwbaarheid van zijn AI-modellen, zoals Copilot, te verbeteren.

De techgigant heeft al de ambitie uitgesproken om hallucinaties in AI-modellen aan te pakken en te elimineren. Daarmee wil het bedrijf de nadruk leggen op een toekomst waarin betrouwbare, nauwkeurige informatie kan worden gegenereerd in functies zoals assistentie in restaurants.

Met strategieën om hallucinaties te elimineren, zouden AI-modellen nauwkeurige antwoorden kunnen geven zonder terug te vallen op onjuiste informatie. Wanneer gecombineerd met de spraakmogelijkheden van de nieuwste Copilot, zou AI instapfuncties kunnen vervangen, zoals geautomatiseerde systemen voor klantenondersteuning.

Wat vindt u van deze ontwikkeling?

Het volledige artikel kunt u hier bekijken .

Geef een reactie