Microsoft Edge kan het Phi3 Mini AI-model lokaal uitvoeren op Windows 11 en Windows 10

Microsoft lijkt een nieuwe functie te testen waarmee Edge browser lokaal een kleine taal genaamd “Phi3 Mini” kan draaien. Dit betekent dat u Microsoft Edge kunt gebruiken om met een van Microsoft’s kleine taalmodellen direct op Windows 11 (en Windows 10) PC te spelen. Dit is volgens nieuwe experimentele vlaggen die zijn gespot in Edge Canary.

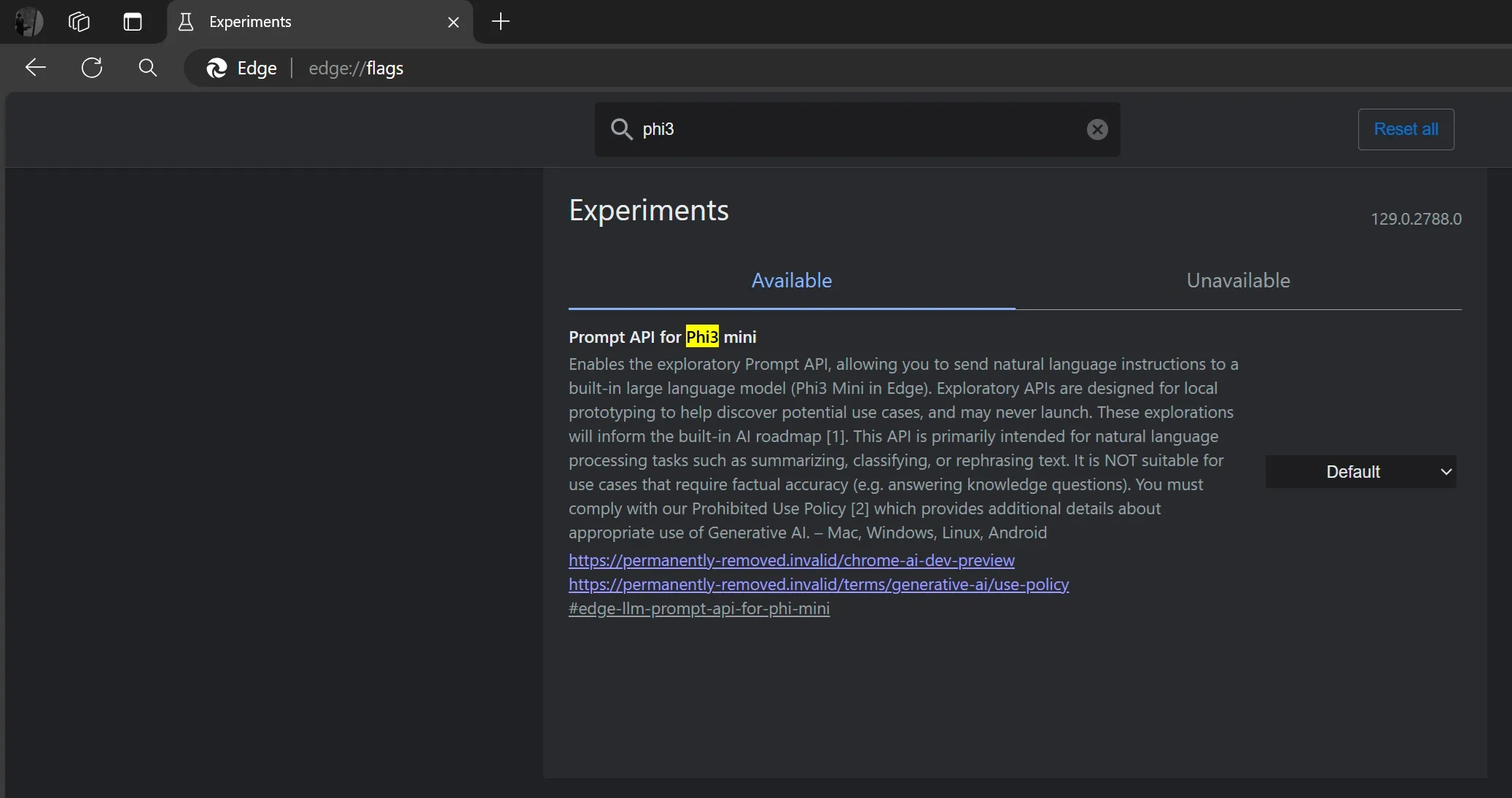

Zoals opgemerkt door onze lezer Leo op X en bevestigd door Windows Latest, is er een nieuwe vlag genaamd “Prompt API voor Phi3 min”. Microsoft beschrijft het als een manier om “exploratory Prompt API” in te schakelen, waarmee u kunt communiceren met een “ingebouwd groot taalmodel” (Phi3 Mini in Edge).

“Hiermee wordt de verkennende Prompt API ingeschakeld, waarmee u natuurlijke taalinstructies naar een ingebouwd groot taalmodel (Phi3 Mini in Edge) kunt sturen. Verkennende API’s zijn ontworpen voor lokale prototyping om potentiële use cases te ontdekken en worden mogelijk nooit gelanceerd. Deze verkenningen zullen de ingebouwde AI-routekaart informeren”, bevestigde Microsoft het experiment via het Edge flags-menu.

Gaat Edge echt lokaal een AI-model hosten?

Waarom denken wij dat het model lokaal gehost zou kunnen worden?

Het gebruik van de term ‘verkennend’ suggereert dat Edge’s idee voor een klein taalmodel nog in ontwikkeling is en zich waarschijnlijk nog in de beginfase van de ontwikkeling bevindt.

Microsoft lijkt het volwaardige grote taalmodel duidelijk niet lokaal binnen Edge te hosten, wat praktisch niet mogelijk is. Het is mogelijk dat het bedrijf probeert om delen van het kleine taalmodel te gebruiken om nieuwe functies in de browser aan te sturen.

“Het is NIET geschikt voor use cases die feitelijke nauwkeurigheid vereisen (bijvoorbeeld het beantwoorden van kennisvragen)”, merkte Microsoft op in de beschrijving van de experimentele vlag.

Microsoft ziet hoe het werkt direct via de Edge-browser. De API is ontworpen voor heel simpele taken zoals het samenvatten of herformuleren van tekst. Het bedrijf waarschuwt ook dat de API niet nauwkeurig hoeft te zijn voor kennisvragen.

Maar hoe kan Microsoft lokale AI integreren in Edge? U kunt bijvoorbeeld een paar honderd woorden tekst selecteren, rechtsklikken en vervolgens het ingebouwde Edge AI-proces gebruiken om tekst lokaal ‘samen te vatten of te herformuleren’.

Dat kan al via Copilot, maar als de gegevens lokaal worden verwerkt, zijn de reacties doorgaans sneller en vertrouwelijker.

Microsoft noemt daarnaast “local prototyping”, wat een ander duidelijk teken is dat het bedrijf experimenteert met het lokaal hosten van de API. De term “built-in large language model” bevestigt ook dat dit model is geïntegreerd in de Edge-browser zelf.

Waarom zou Microsoft de term “ingebouwd” gebruiken als dat niet het geval was?

Er zijn ook manieren om Google Gemini Nano (een klein taalmodel) rechtstreeks in Google Chrome te draaien. U zult versteld staan hoe ongelooflijk snel het werkt als u de bovenstaande video bekijkt die gedeeld is door Morten Just op X.

Wat vooral interessant is, is dat deze lokaal gehoste modellen volledig offline werken. U hoeft zich dus geen zorgen te maken over het delen van uw data of traag internet.

Het idee om AI-modellen lokaal in Edge uit te voeren is natuurlijk een werkbaar idee, en je kunt hopen dat de integratie niet te veel systeembronnen in beslag neemt.

Naast lokale AI wil Edge ook de rommel opruimen en de energiebesparende functie van Windows 11 integreren om het stroomverbruik te verminderen.

Geef een reactie