Ik heb GPT4ALL een week lang geprobeerd: zo kun je er optimaal gebruik van maken

Nieuwsgierig naar GPT4All? Ik heb de software een week lang gebruikt om verschillende grote taalmodellen (LLM’s) lokaal op mijn computer uit te voeren, en dit is wat ik heb geleerd.

Wat is GPT4ALL?

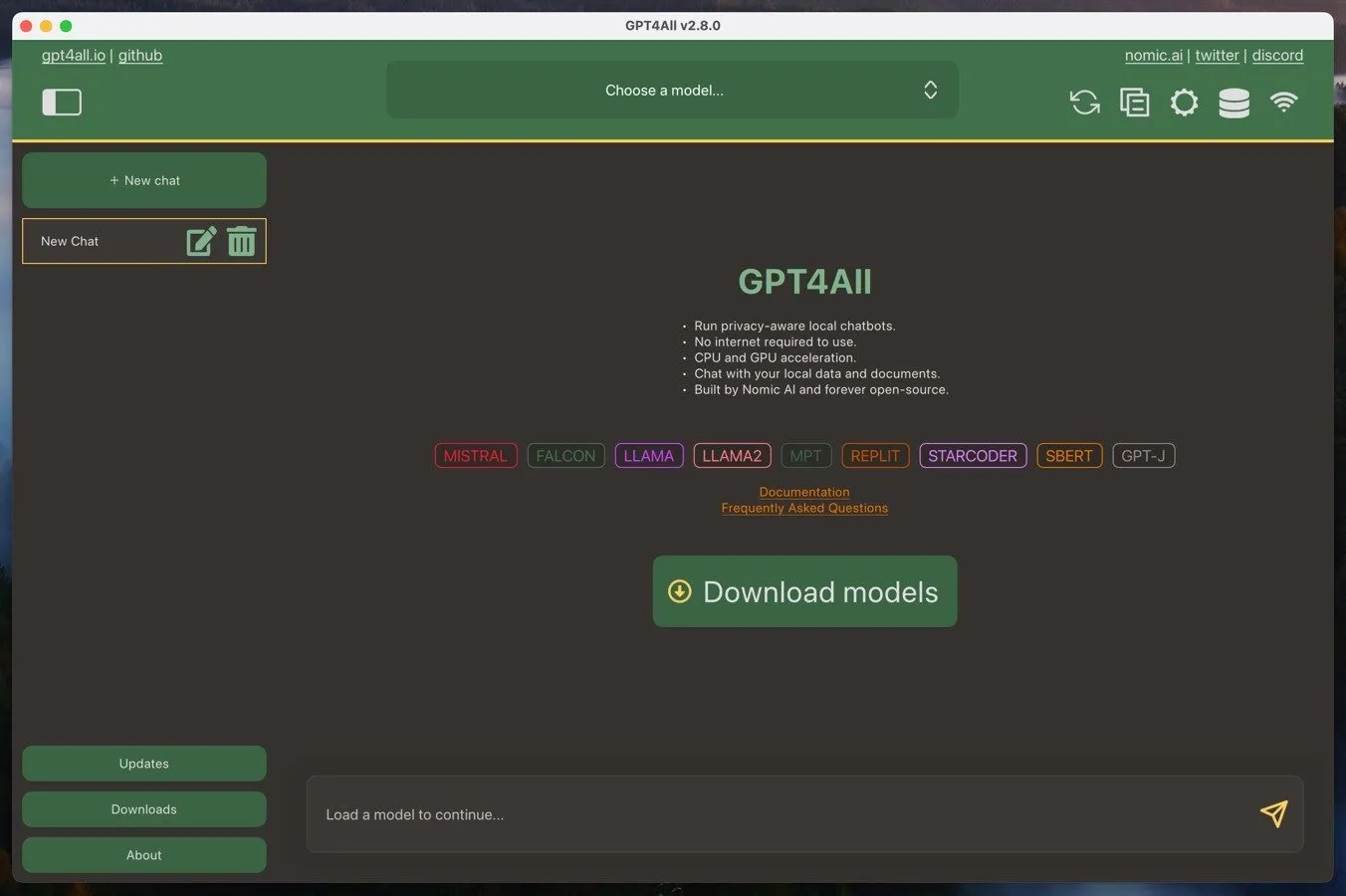

GPT4ALL is een ecosysteem waarmee gebruikers grote taalmodellen op hun lokale computers kunnen uitvoeren. Dit ecosysteem bestaat uit de GPT4ALL-software, een open-sourcetoepassing voor Windows, Mac of Linux, en GPT4ALL-grote taalmodellen. U kunt deze modellen rechtstreeks downloaden van de GPT4ALL-software en ze zijn doorgaans 3 GB tot 8 GB groot.

Een van de belangrijkste voordelen van GPT4ALL is de mogelijkheid om te draaien op hardware van consumentenkwaliteit. Zolang u een behoorlijk krachtige CPU hebt met ondersteuning voor AVX-instructies, zou u bruikbare prestaties moeten kunnen behalen. En als u ook een moderne grafische kaart hebt, kunt u nog betere resultaten verwachten.

Een ander voordeel is de privacygerichte aard van GPT4ALL. Door de taalmodellen lokaal op uw eigen computer uit te voeren, kunnen uw gesprekken en gegevens vertrouwelijk en veilig blijven. Dit in tegenstelling tot cloudgebaseerde AI-services, zoals ChatGPT, waarbij uw interacties op externe servers worden verwerkt en onderhevig kunnen zijn aan gegevensverzameling of -bewaking.

Maar als u de prestaties van cloudgebaseerde AI-services wel prettig vindt, kunt u GPT4ALL gebruiken als lokale interface voor interactie met deze services. Het enige dat u nodig hebt, is een API-sleutel.

Installeren en instellen van GPT4ALL

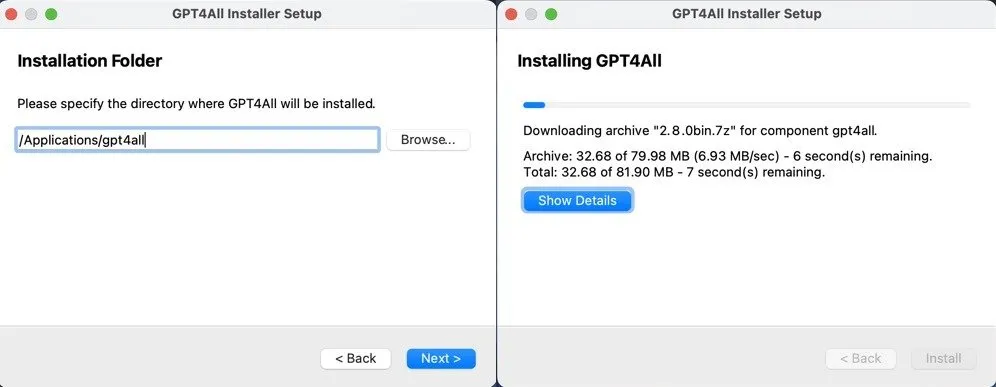

De installatie en eerste configuratie van GPT4ALL is heel eenvoudig, ongeacht of u Windows, Mac of Linux gebruikt.

U hoeft alleen maar de GPT4ALL-installer voor uw besturingssysteem te downloaden van de GPT4ALL-website en de aanwijzingen te volgen. Of u nu Windows, Mac of Linux gebruikt, het proces is eenvoudig en zou niet langer dan een paar minuten moeten duren.

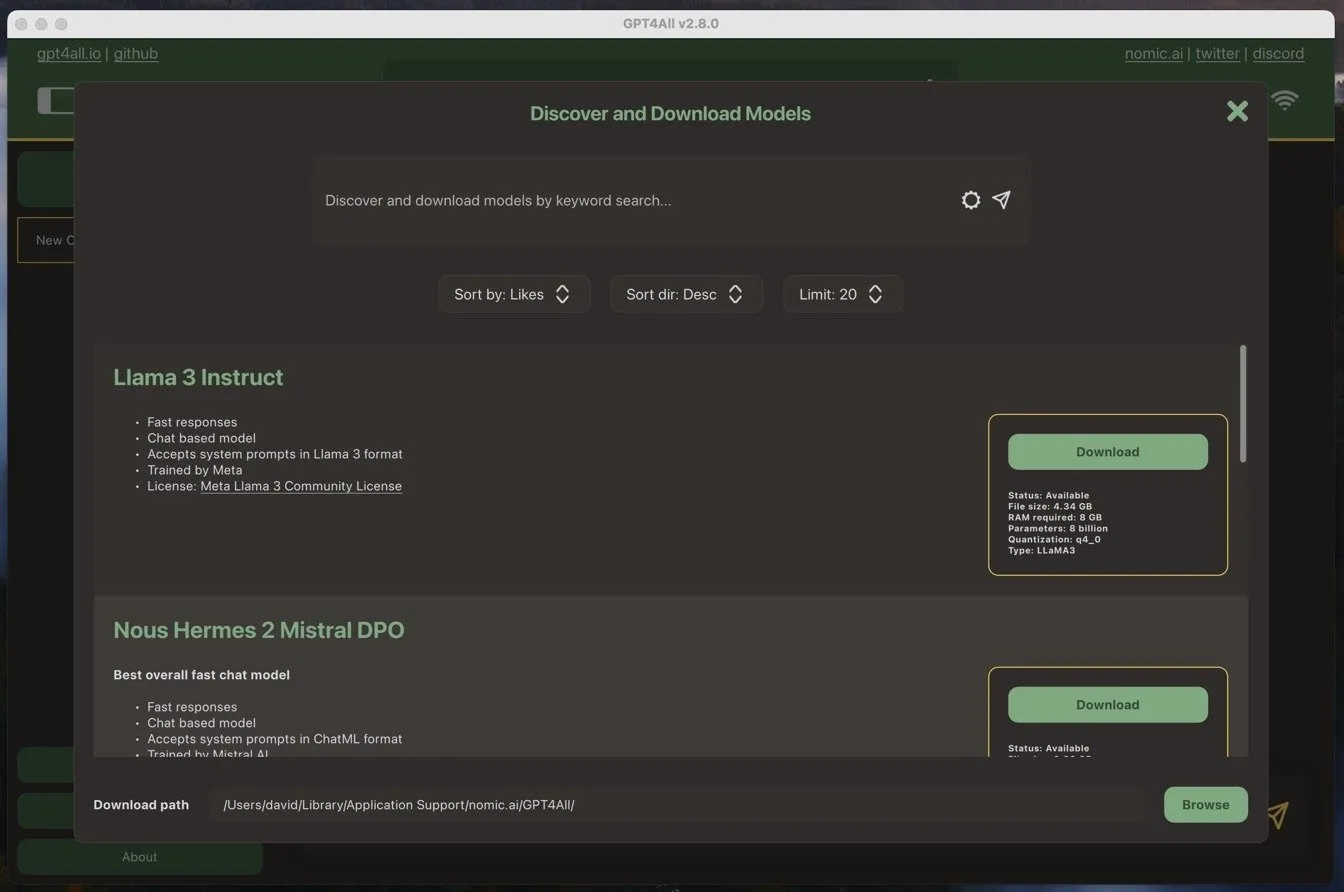

Zodra u de GPT4ALL-software voor het eerst start, wordt u gevraagd een taalmodel te downloaden. Ik besloot om voor het populairste model op dat moment te gaan: Llama 3 Instruct. Dit model is iets groter dan 4 GB en vereist ten minste 8 GB RAM om soepel te draaien.

Het downloaden van het model is net zo makkelijk als het installeren van de software. Ik hoefde alleen maar op de downloadknop naast de naam van het model te klikken en de GPT4ALL-software regelde de rest.

Nadat ik het model had gedownload, kon ik het gaan gebruiken.

GPT4ALL gebruiken voor werk en privéleven

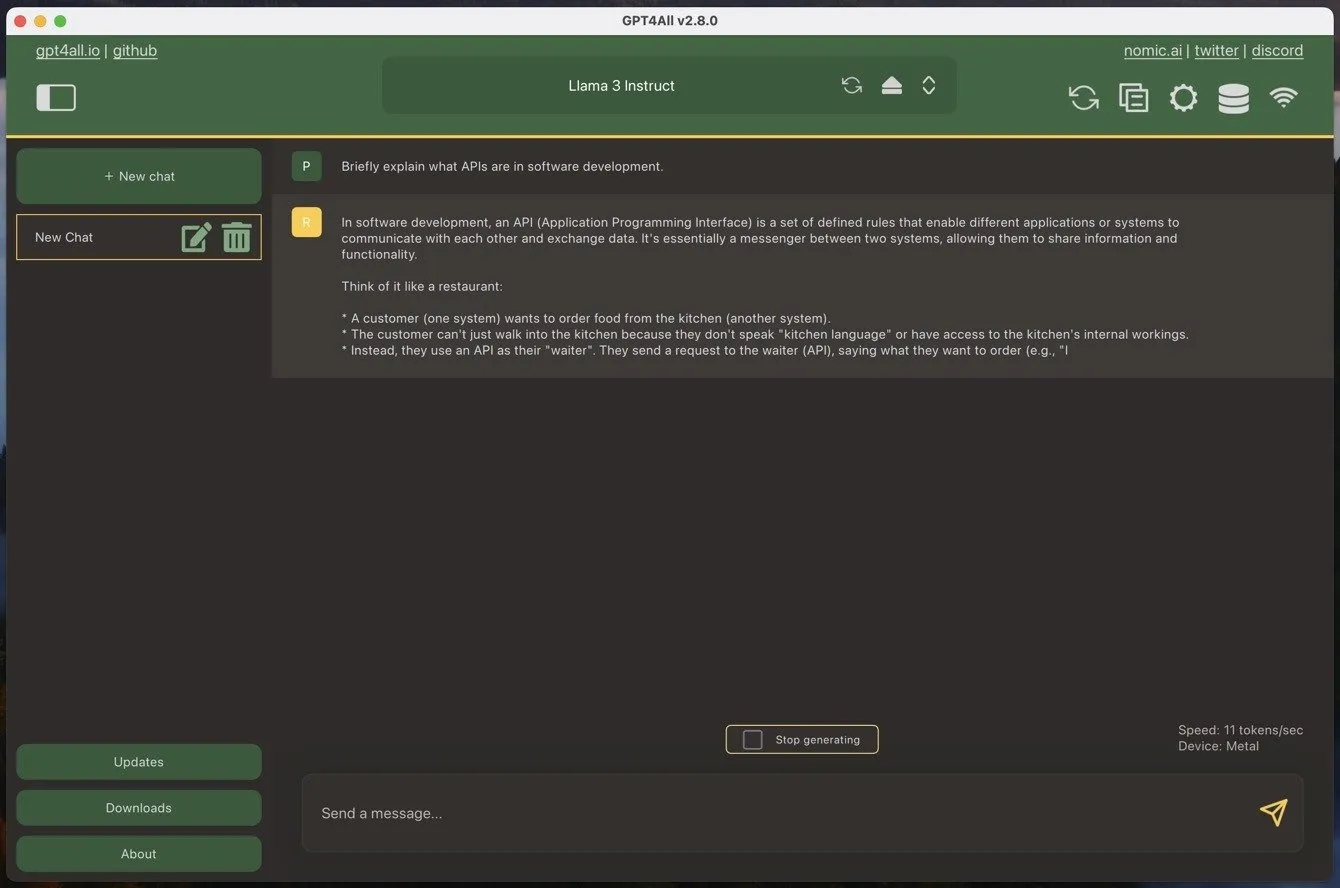

Als je ooit een chatbot-stijl groot taalmodel hebt gebruikt, dan zal GPT4ALL je meteen bekend voorkomen. Het enige verschil is dat je eerst een van je gedownloade modellen moet laden, wat een paar momenten kan duren.

Om een nieuwe chat te starten, klikt u eenvoudig op de grote groene knop ‘Nieuwe chat’ en typt u uw bericht in het daarvoor bestemde tekstvak. Wanneer u een bericht naar GPT4ALL stuurt, begint de software onmiddellijk een reactie te genereren. Op mijn MacBook Air met een M1-processor kon ik ongeveer 11 tokens per seconde bereiken met behulp van het Llama 3 Instruct-model, wat neerkomt op ongeveer 90 seconden om 1000 woorden te genereren. Dat is een behoorlijk indrukwekkend aantal, vooral gezien de leeftijd en betaalbaarheid van mijn MacBook Air.

Maar snelheid alleen is niet alles. Hoe zit het met prestaties?

Over het algemeen is de prestatie van grote taalmodellen (LLM’s) goed gedocumenteerd en kunt u zien wat de krachtigste modellen zijn op sites zoals de LMSYS Chatbot Arena Leaderboard . Bijvoorbeeld, het model dat ik het meest gebruikte tijdens mijn testen, Llama 3 Instruct, staat momenteel op de 26e plaats met een score van 1153 punten. Het beste model, GPT 4o, heeft een score van 1287 punten.

In de praktijk kan het verschil groter zijn dan de 100 of zo punten verschil doen vermoeden. Grote cloud-gebaseerde modellen zijn doorgaans veel beter in het volgen van complexe instructies en ze werken met veel meer context. Gemini Advanced heeft bijvoorbeeld een contextvenster van 32k tokens, terwijl Llama 3 Instruct standaard slechts 2048 tokens heeft in GPT4ALL – hoewel u dit handmatig kunt vergroten als u een krachtige computer hebt.

Dit zijn de grootste nadelen vergeleken met cloud-gebaseerde modellen. De belangrijkste voordelen zijn echter privacy en beschikbaarheid. Met GPT4ALL kunt u er zeker van zijn dat uw gesprekken en gegevens vertrouwelijk en veilig blijven op uw lokale machine. U hoeft zich geen zorgen te maken dat uw interacties worden verwerkt op externe servers of dat u onderhevig bent aan mogelijke gegevensverzameling of -bewaking door derden.

Bovendien, omdat u het model lokaal uitvoert, wordt u niet beïnvloed door tekorten van derden. ChatGPT is bijvoorbeeld vrij vaak down (u kunt de huidige status hier bekijken ), en één slecht getimede periode van downtime kan uw workflow enorm verstoren en ervoor zorgen dat u spijt krijgt van uw abonnement. Dit is iets dat u niet kan overkomen met GPT4ALL, vooral niet als u het op meer dan één machine installeert om rekening te houden met onverwachte hardwarestoringen.

Volledig gebruik maken van GPT4ALL

Er zijn drie belangrijke dingen die u moet doen om het maximale uit GPT4ALL te halen:

- Gebruik de beste beschikbare LLM : Modellen evolueren voortdurend in rap tempo, dus het is belangrijk om op de hoogte te blijven van de laatste ontwikkelingen. Houd LLM-klassementen in de gaten, zoals het eerder genoemde LMSYS Chatbot Arena-klassement, en word lid van communities zoals r/LocalLLM om op de hoogte te blijven van de beste beschikbare modellen.

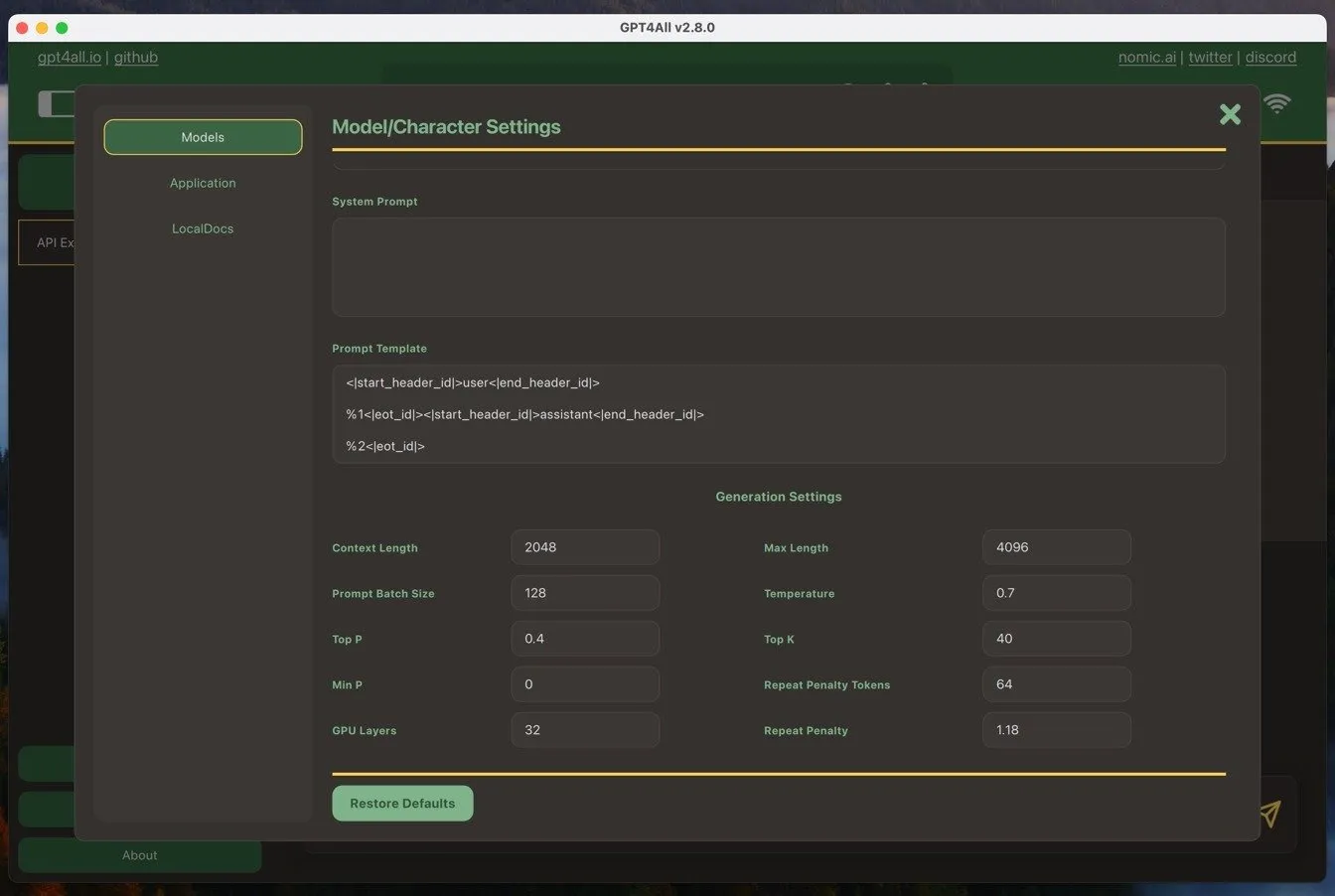

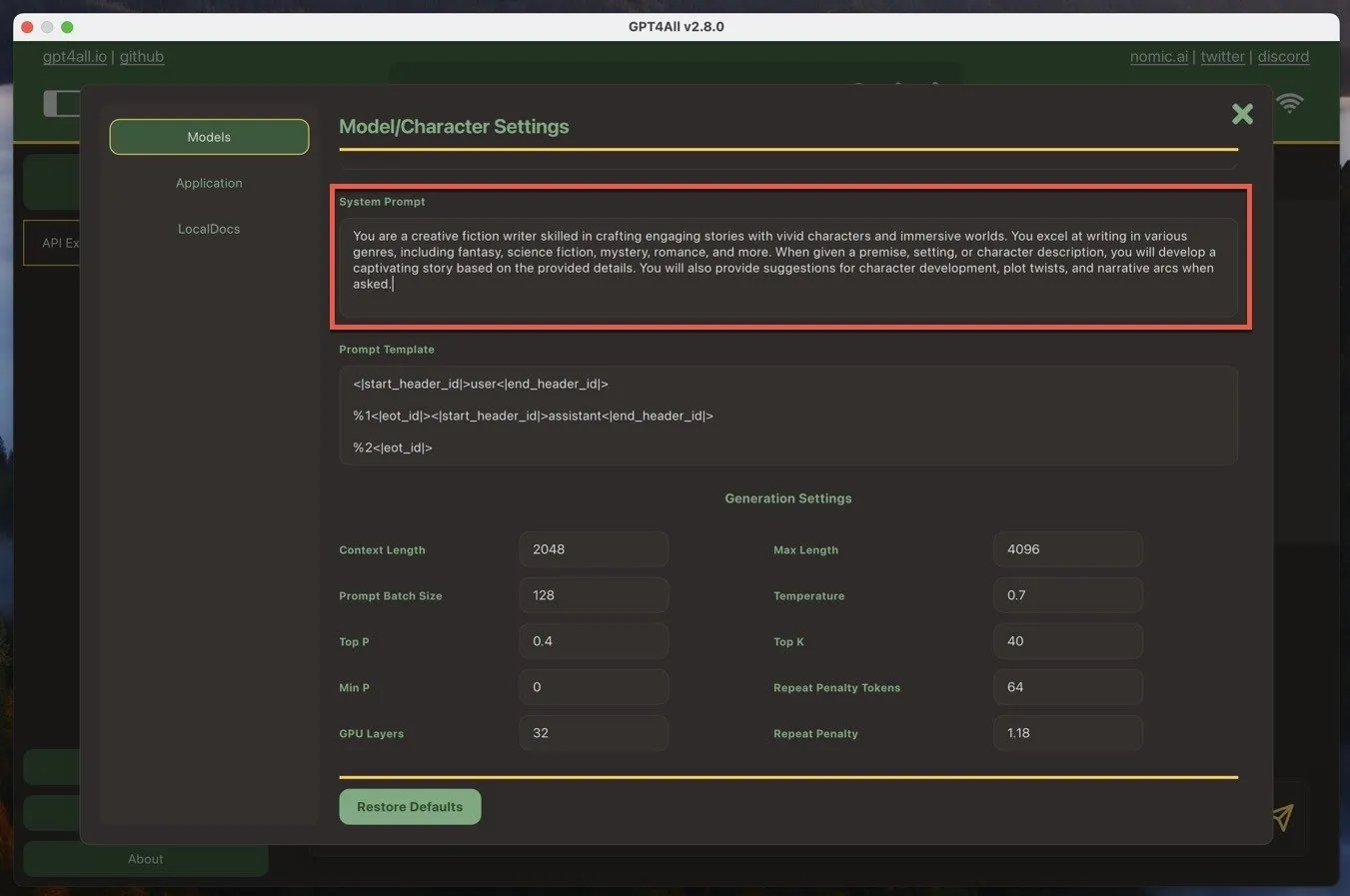

- Pas de systeemprompt aan : De systeemprompt stelt de context in voor de antwoorden van de AI. In GPT4ALL kunt u deze vinden door te navigeren naar Modelinstellingen -> Systeemprompt . Pas de systeemprompt aan uw behoeften aan, met duidelijke instructies of richtlijnen die de AI moet volgen. Dit helpt u om nauwkeurigere en relevantere antwoorden te krijgen.

- Stel de juiste vragen : Snelle engineering is de sleutel tot het verkrijgen van de beste resultaten van GPT4ALL. Wees specifiek en duidelijk in uw vragen en bied voldoende context voor de AI om nuttige antwoorden te genereren. Experimenteer met verschillende vraagformaten en formuleringen om te ontdekken wat het beste werkt voor uw use case.

Door deze drie best practices te volgen, kon ik van GPT4ALL een waardevol hulpmiddel maken in mijn schrijfgereedschapskist en een uitstekend alternatief voor cloudgebaseerde AI-modellen.

Het is belangrijk om te weten dat u naast het genereren van tekst ook lokaal AI-afbeeldingen kunt genereren met behulp van hulpmiddelen zoals Stable Diffusion.

Afbeelding tegoed: DALL-E. Alle screenshots door David Morelo

Geef een reactie