Hoe u uw eigen lokale LLM op een Raspberry Pi kunt uitvoeren

Sinds OpenAI’s verbluffende release van ChatGPT 3 eind 2022 hebben Large Language Models (LLM’s) de verbeelding van de wereld veroverd door opmerkelijke capaciteiten te demonstreren, van het schrijven van essays tot het beantwoorden van complexe vragen.

U hoeft echter niet afhankelijk te zijn van bedrijven als OpenAI, Google of Anthropic en mogelijk persoonlijke gegevens te delen om te profiteren van de kracht van LLM’s. Met slechts een betaalbare Raspberry Pi kunt u uw eigen lokale AI-chatgebaseerde assistent opzetten. Deze gids laat zien hoe.

Wat je nodig hebt

Om je eigen LLM op een Raspberry Pi in te stellen, zijn er een paar essentiële componenten die je nodig hebt:

- Raspberry Pi : Omdat LLM’s veel hulpbronnen vereisen, kunt u het beste de krachtigste Raspberry Pi gebruiken die beschikbaar is voor optimale prestaties. Op het moment dat dit artikel wordt geschreven, is de Raspberry Pi 5 met 8 GB RAM de aanbevolen keuze.

- microSD-kaart met Raspberry Pi OS: Voor maximale prestaties kunt u overwegen de Lite-versie van Raspberry Pi OS te gebruiken, aangezien een grafische gebruikersinterface niet nodig is om een LLM uit te voeren (u kunt er op afstand mee communiceren via een terminal en SSH). Als u uw Raspberry Pi echter voor andere taken of als uw primaire computer gebruikt, kunt u de reguliere versie van Raspberry Pi OS gebruiken.

- Extra componenten : Naast de Raspberry Pi en een snelle microSD-kaart heb je een betrouwbare voeding nodig (de officiële wordt aanbevolen), een toetsenbord, muis en monitor voor de eerste installatie (optioneel als je SSH gebruikt), en een internetverbinding voor het downloaden van de benodigde software en modellen.

Met deze componenten in de hand bent u klaar om te beginnen met het opzetten van uw eigen LLM op uw Raspberry Pi.

Installeer Ollama

De eerste stap bij het opzetten van uw eigen LLM op een Raspberry Pi is het installeren van de benodigde software. Momenteel zijn de twee populairste keuzes voor het lokaal uitvoeren van LLM’s llama.cpp en Ollama.

- llama.cpp is een lichtgewicht C++-implementatie van Meta’s LLaMA (Large Language Model Adapter) die op een breed scala aan hardware kan draaien, waaronder Raspberry Pi. Het is ontwikkeld door Georgi Gerganov en uitgebracht in maart 2023.

- Ollama daarentegen is gebouwd rond llama.cpp en biedt verschillende gebruiksvriendelijke functies. Het verwerkt automatisch template-chatverzoeken in het formaat dat elk model verwacht, en het laadt en ontlaadt modellen op aanvraag op basis van het verzoek van de klant. Ollama beheert ook het downloaden en cachen van modellen, inclusief gekwantiseerde modellen, zodat u ze op naam kunt opvragen.

Voor deze handleiding gebruiken we Ollama vanwege het gebruiksgemak en de extra functies.

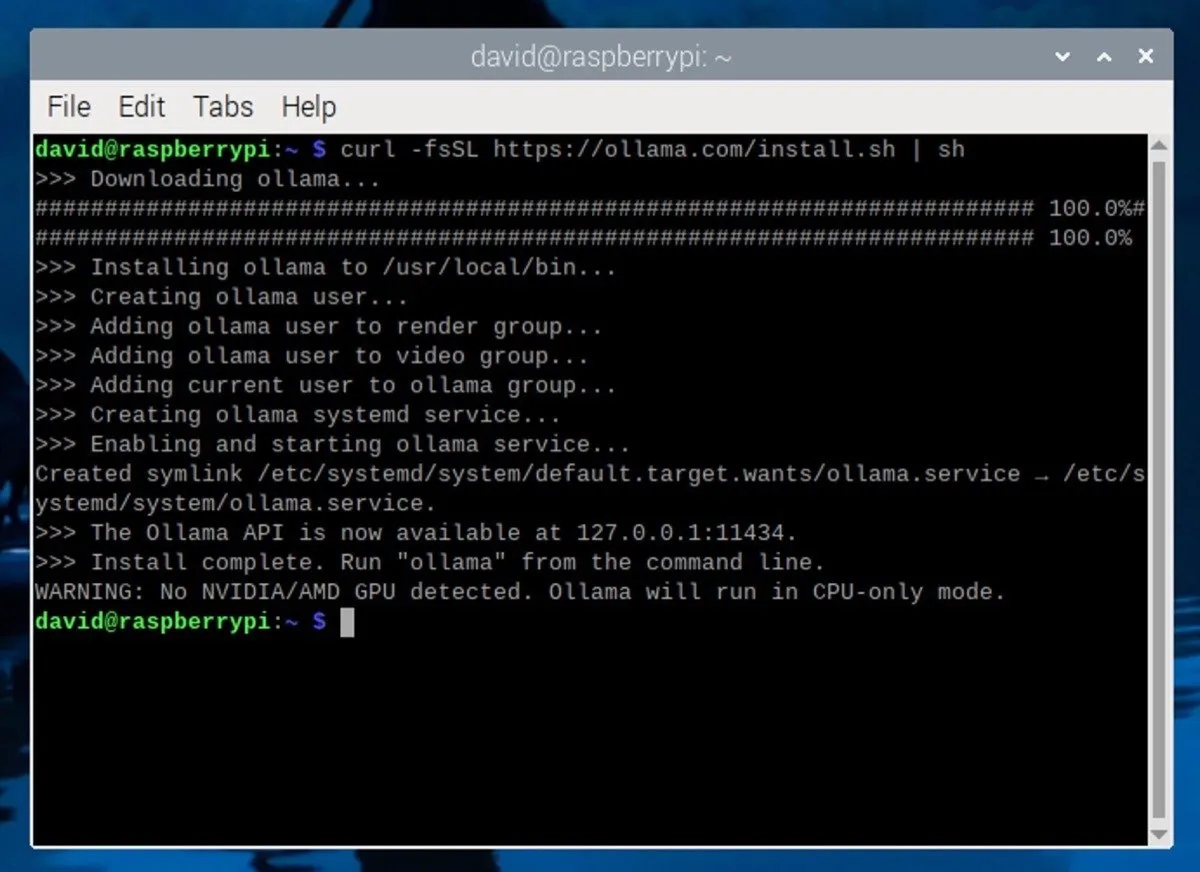

Om Ollama op uw Raspberry Pi te installeren, opent u een terminalvenster op uw Raspberry Pi. Als je SSH gebruikt, maak dan verbinding met je Raspberry Pi via de SSH-client van je voorkeur. Voer vervolgens de volgende opdracht in de terminal in:

Met deze opdracht wordt het installatiescript van de officiële Ollama-website gedownload en uitgevoerd. Het script installeert automatisch de vereiste afhankelijkheden en stelt Ollama in op uw Raspberry Pi.

Download en voer een LLM uit

Nu Ollama is geïnstalleerd, is het tijd om een groot taalmodel te downloaden. Als u een Raspberry Pi met 8 GB RAM gebruikt, kunt u modellen uitvoeren met maximaal 7 miljard parameters (de instellingen die de AI gebruikt om de uitvoer te bepalen).

Enkele populaire keuzes zijn Mistral (7B), Gemma (7B of 2B), Llama 2 ongecensureerd (7B) of Microsoft’s Phi-3 (3.8B). Je kunt alle ondersteunde modellen bekijken op de Ollama-bibliotheekpagina .

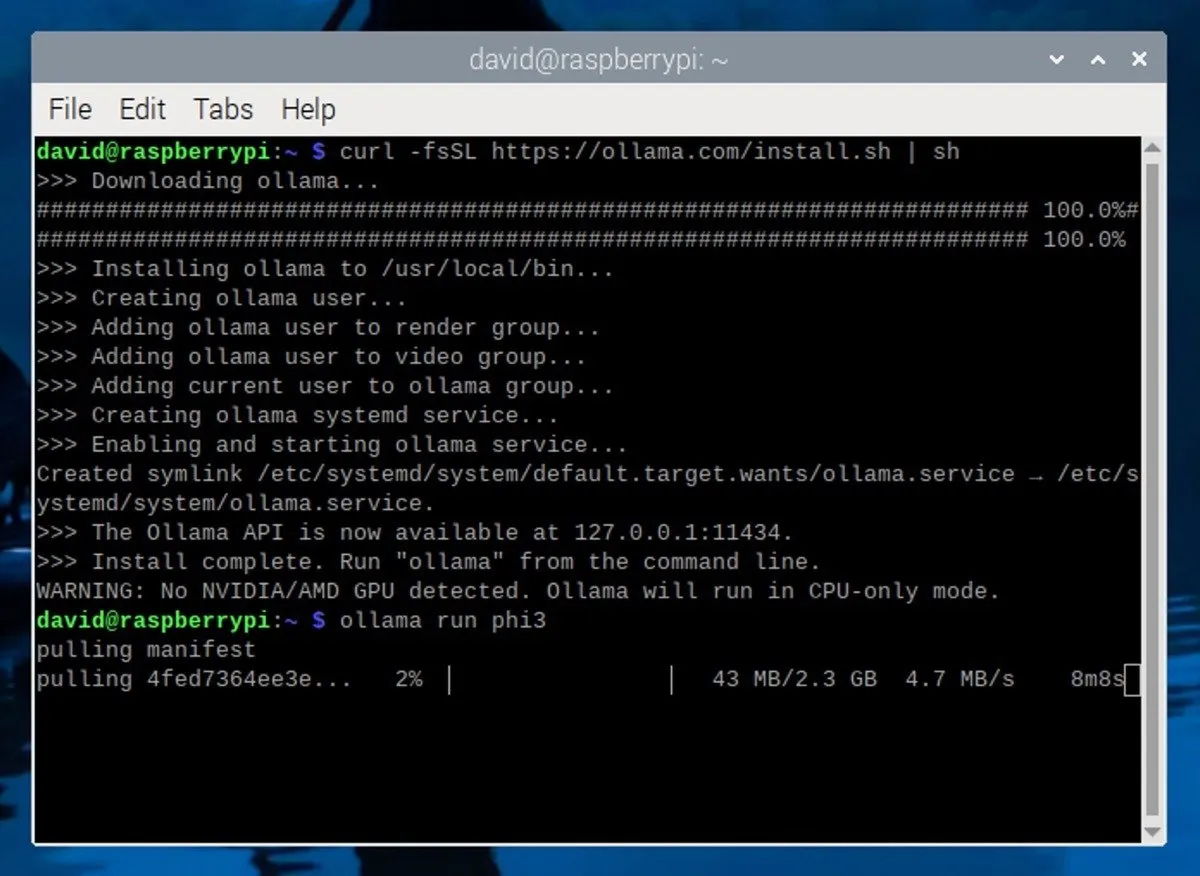

Voor deze handleiding gebruiken we het Phi-3-model van Microsoft . Ondanks zijn kleine formaat en efficiëntie is de Phi-3 een uiterst capabel model. Om het te installeren, voert u eenvoudig de volgende opdracht uit in de terminal:

Met deze opdracht wordt het Phi-3-model gedownload en geïnstalleerd, en wordt ook automatisch een interactieve chatsessie met het model gestart.

Een lokale LLM gebruiken op uw Raspberry Pi

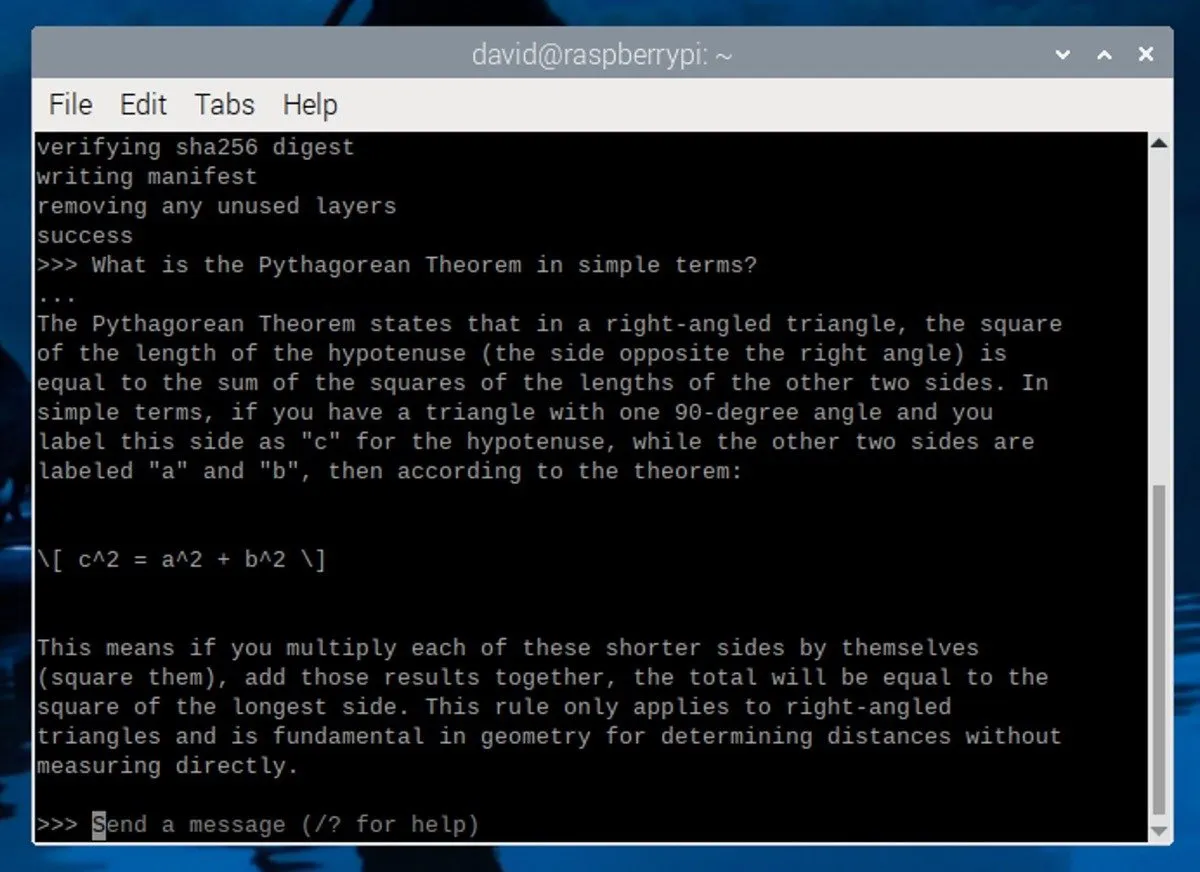

Na het downloaden en installeren van het Phi-3-model ziet u een prompt in de terminal die er als volgt uitziet:

Dit betekent dat de LLM actief is en wacht op uw invoer. Om de interactie met het model te starten, typt u uw bericht en drukt u op Enter.

Hier volgen enkele tips voor het maken van effectieve aanwijzingen:

- Wees specifiek : geef duidelijke en gedetailleerde instructies of vragen zodat de LLM begrijpt waarnaar u op zoek bent.

- Stel de context in : Geef de LLM wat achtergrondinformatie of een scenario om relevantere reacties te genereren.

- Definieer rollen : specificeer de rol die de LLM moet spelen in zijn reactie, zoals een verhalenverteller, een leraar of een technisch expert.

Om de LLM-sessie te beëindigen, drukt u op Ctrl+ dof voert u de /byeopdracht in. Als u later een nieuwe sessie wilt starten, opent u gewoon een nieuwe terminal en voert u de ollama run phi3opdracht uit. Omdat het model al is gedownload, zal het snel opstarten zonder dat het opnieuw hoeft te worden gedownload.

Houd er rekening mee dat de prestaties van de Raspberry Pi 5 hun limieten hebben en dat deze slechts een paar tokens per seconde kan uitvoeren. Voor betere prestaties kunt u overwegen om Ollama op een krachtigere computer met een speciale grafische kaart te gebruiken.

Afbeelding tegoed: Unsplash . Schermafbeeldingen door David Morelo.

Geef een reactie