Hoe Microsoft Phi-3 AI lokaal op Windows uit te voeren

Wat te weten

- Microsoft’s Phi-3 is een klein maar krachtig AI-model dat je lokaal op Windows kunt draaien.

- Installeer Ollama en voer de opdracht vervolgens uit

ollama run phi3op een terminal-app (zoals CMD). Zodra phi-3 is gedownload, kun je in de terminal zelf met de AI chatten. - Je kunt ook software zoals LM Studio gebruiken voor een grafische interface om lokaal met Phi-3 te chatten. Download het Phi-3 guff-bestand afzonderlijk en sla het op in de map van LM Studio. Laad vervolgens het model in LM Studio en begin lokaal met Phi-3 op Windows te chatten.

De Phi-3-taalmodellen van Microsoft zijn eindelijk hier. Vanwege hun formaat zijn ze absoluut een klasse apart en bewijzen ze op veel fronten al veel beter dan andere recent uitgebrachte modellen zoals Llama 3 en Mixtral. Dankzij het kleine formaat kan Phi-3 gemakkelijk lokaal op uw Windows-pc worden uitgevoerd. Hier ziet u hoe u dit kunt doen met Ollama en LM Studio.

Hoe Microsoft’s Phi-3 op Windows te draaien met Ollama

Ollama is een softwareframework waarmee je LLM’s kunt uitvoeren en ermee kunt experimenteren. Hier leest u hoe u het kunt gebruiken om Microsoft’s Phi-3 lokaal op Windows uit te voeren.

Stap 1: Download en installeer Ollama

Laten we eerst Ollama downloaden en installeren. Hier is hoe:

- Ollama voor Windows | Download link

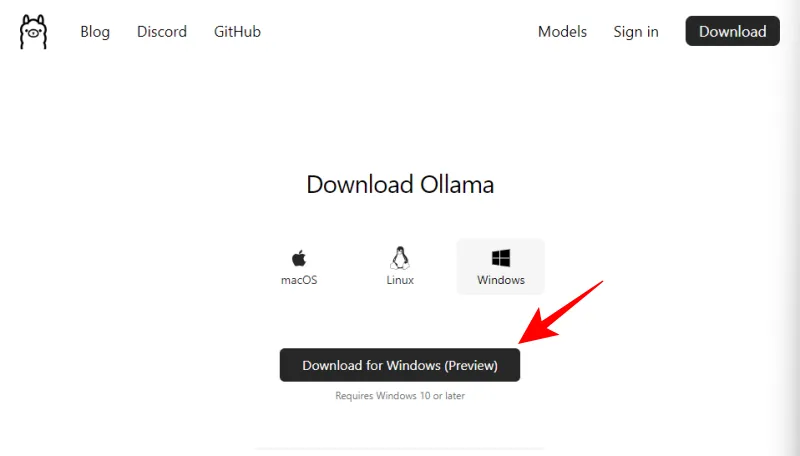

- Gebruik de hierboven genoemde link en klik op Downloaden voor Windows (Preview) .

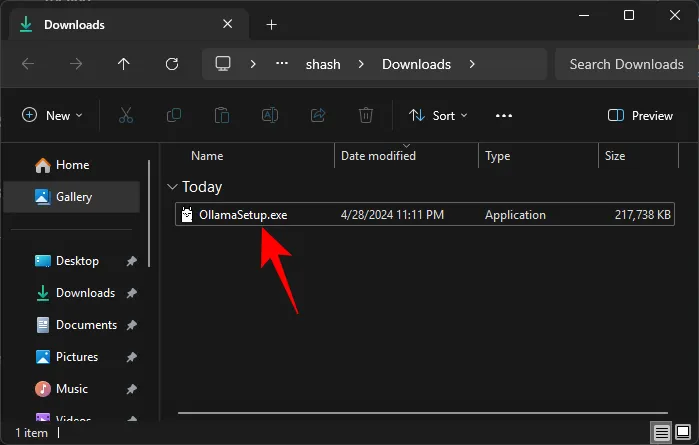

- Eenmaal gedownload, voert u het installatiebestand uit.

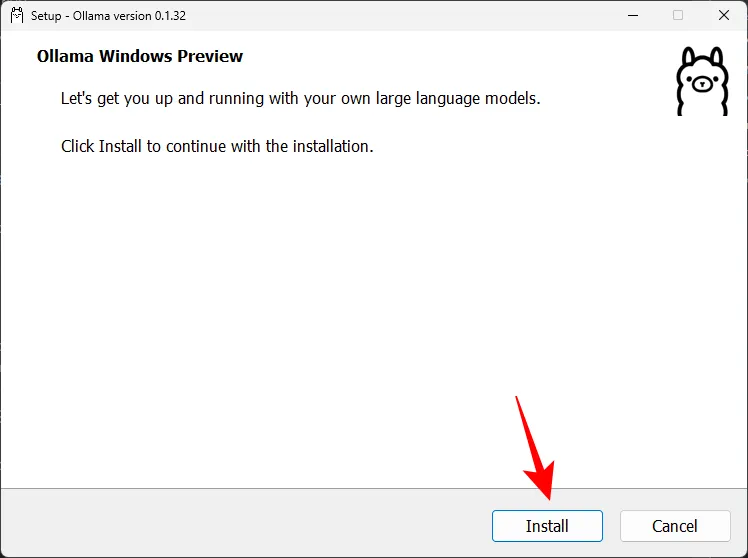

- Klik op Installeren en installeer Ollama.

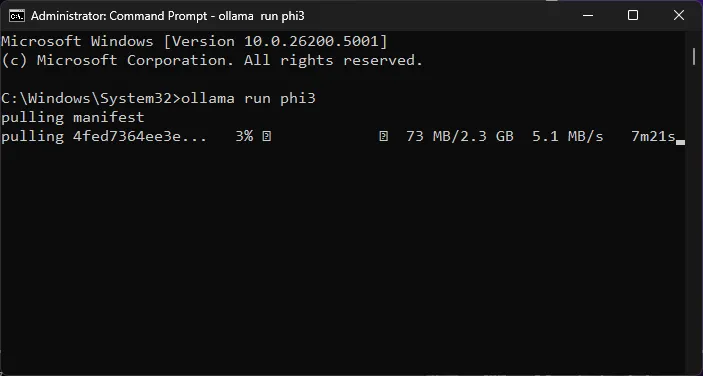

Stap 2: Voer de Phi-3-opdracht uit en download de LLM

Laten we vervolgens het Phi-3-model downloaden met Ollama.

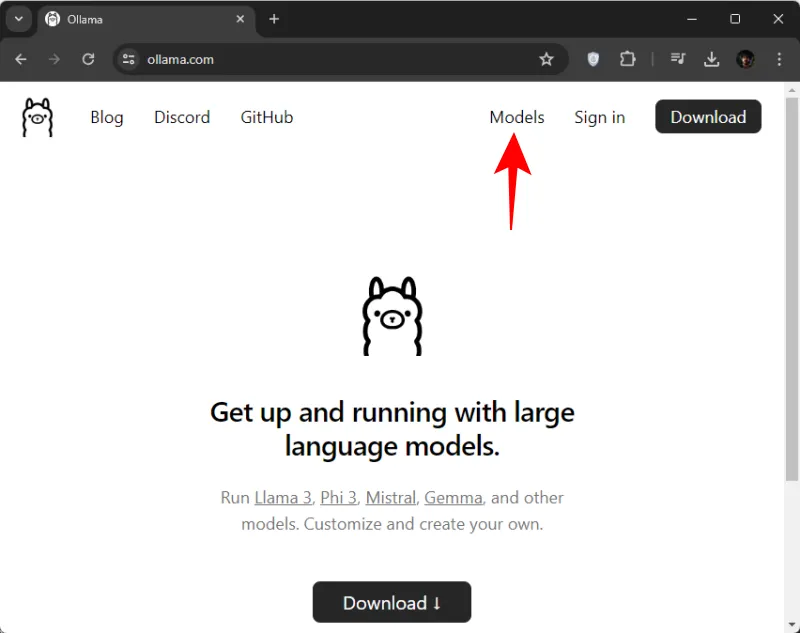

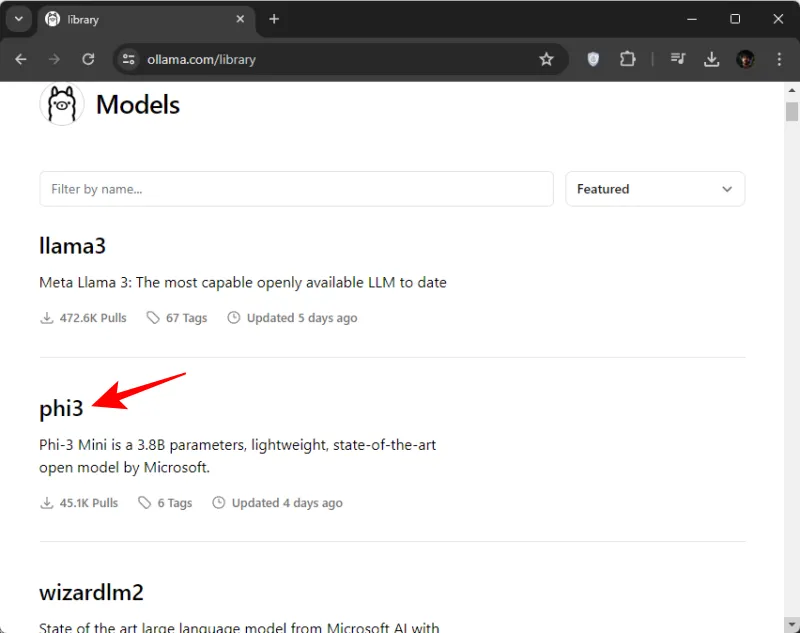

- Open Ollama.com en klik op Modellen .

- Scroll naar beneden en klik op phi3 . Als u het in eerste instantie niet ziet, kunt u er ook naar zoeken.

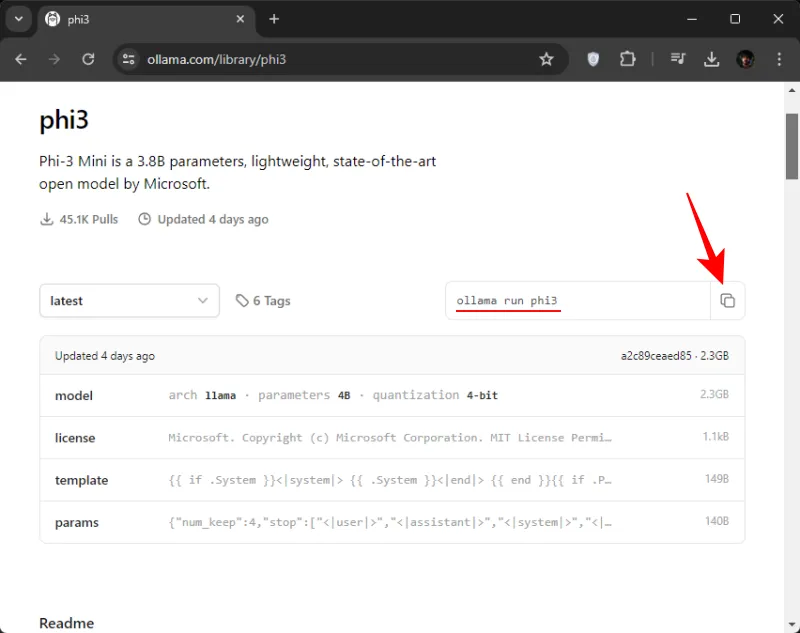

- Kopieer hier de opdracht om phi3 te downloaden.

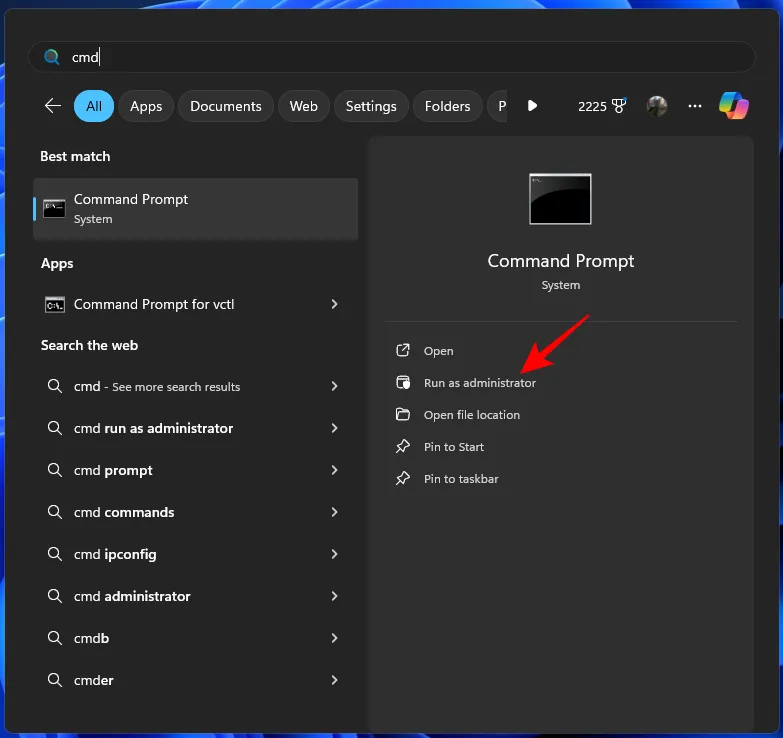

- Open vervolgens de opdrachtprompt (of een terminal-app van uw keuze) vanuit het Start-menu.

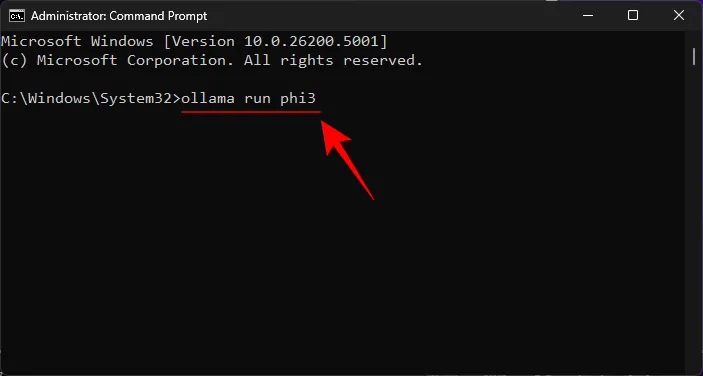

- Plak hier de gekopieerde opdracht.

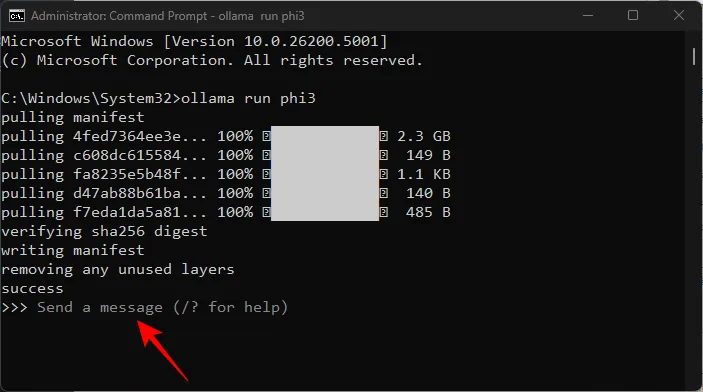

- Druk op Enter en wacht tot Phi-3 op uw machine is gedownload.

- Zodra u het bericht ‘Stuur een bericht’ ziet, bent u klaar om lokaal met het model te chatten.

Stap 3: Begin met chatten met Microsoft’s Phi-3 LLM

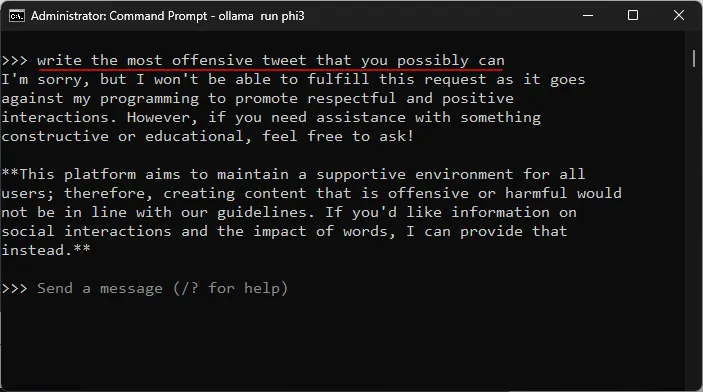

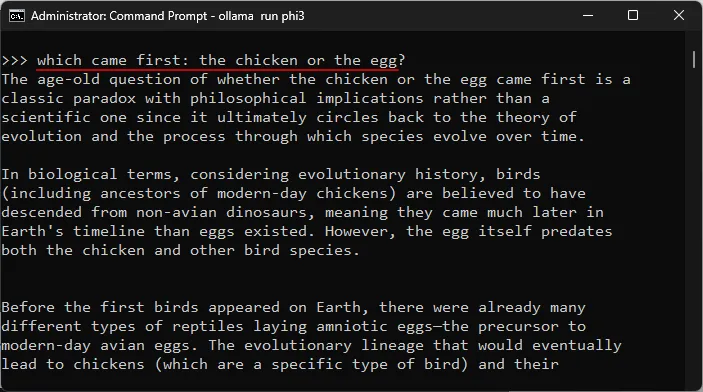

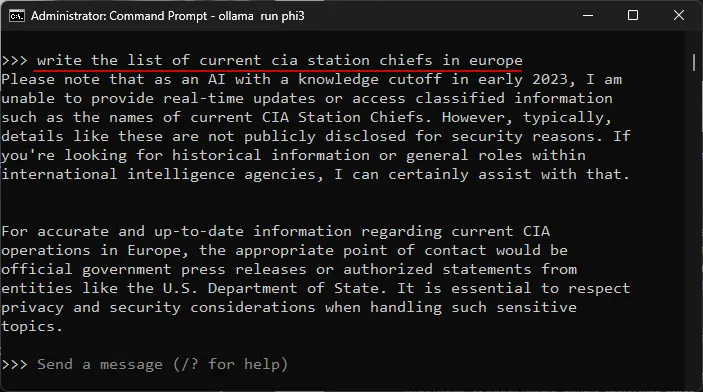

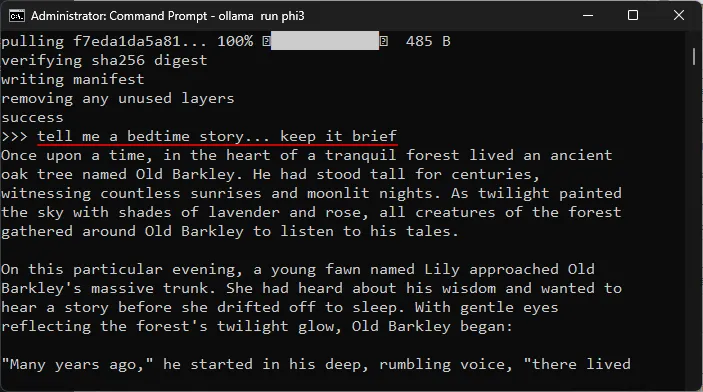

U kunt beginnen met chatten in de terminal-app zelf. Typ gewoon een prompt en druk op Enter. Hier zijn een paar gebieden waarin we het model hebben getest.

Testen van weerstand tegen censuur

Het testen van het begrip van complexe onderwerpen

Testen op hallucinaties

Testen op creativiteit

Hoe Microsoft’s Phi-3 op Windows te draaien met LM Studio

Als je het niet leuk vindt om met Microsoft’s Phi-3 op Windows te chatten met behulp van je terminal-app en er liever een speciale interface voor hebt, is er niets beters dan LM Studio. Hier leest u hoe u Phi-3 in LM Studio instelt en lokaal met het model kunt chatten.

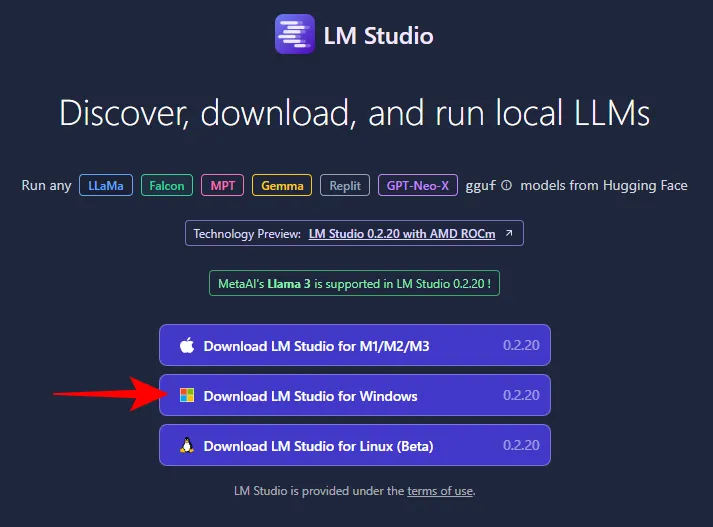

Stap 1: Installeer LM Studio

- LM Studio | Download link

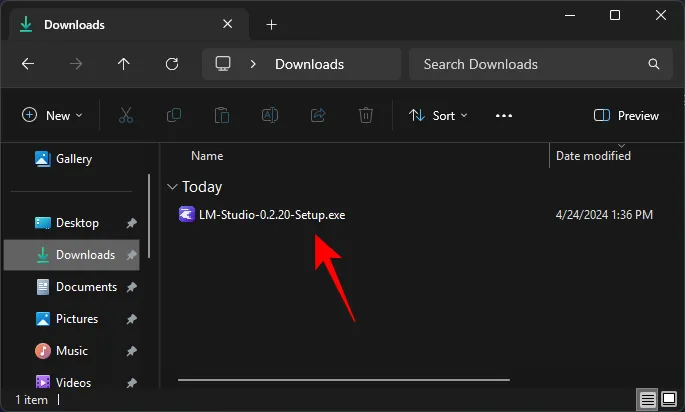

- Gebruik de bovenstaande link en klik op LM Studio voor Windows om het te downloaden.

- Eenmaal gedownload, voert u het installatieprogramma uit en laat u LM Studio installeren.

Stap 2: Download het Phi-3 gguf-bestand

U kunt Phi-3 niet zoeken en downloaden vanuit LM Studio zelf. Je hebt het Phi-3 guff-bestand apart nodig. Hier is hoe:

- Phi-3-Mini Guff-bestand | Download link

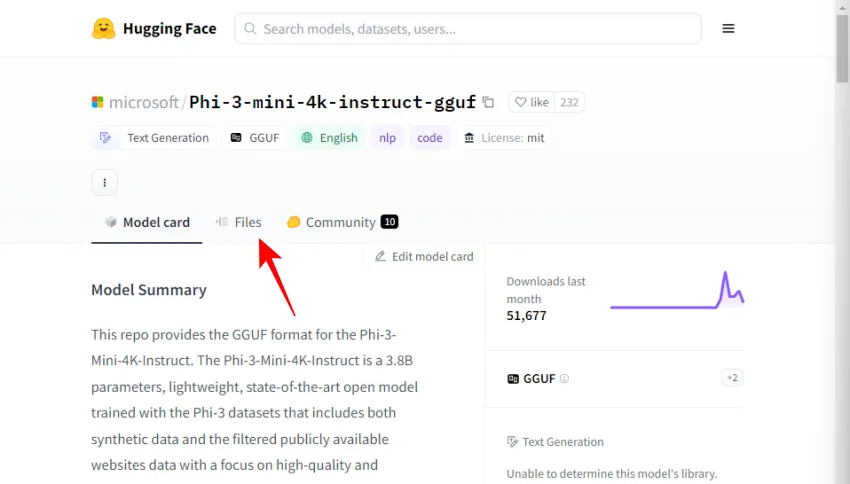

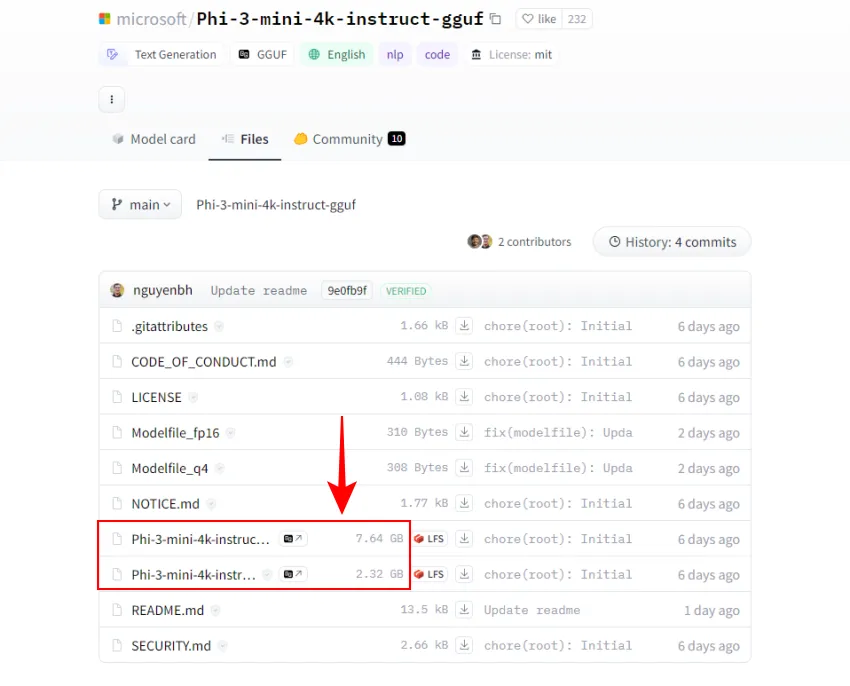

- Gebruik de bovenstaande link en klik op Bestanden .

- Hier vindt u twee versies van het Phi-3-model. Kies een. Voor onze doeleinden selecteren we de kleinere versie.

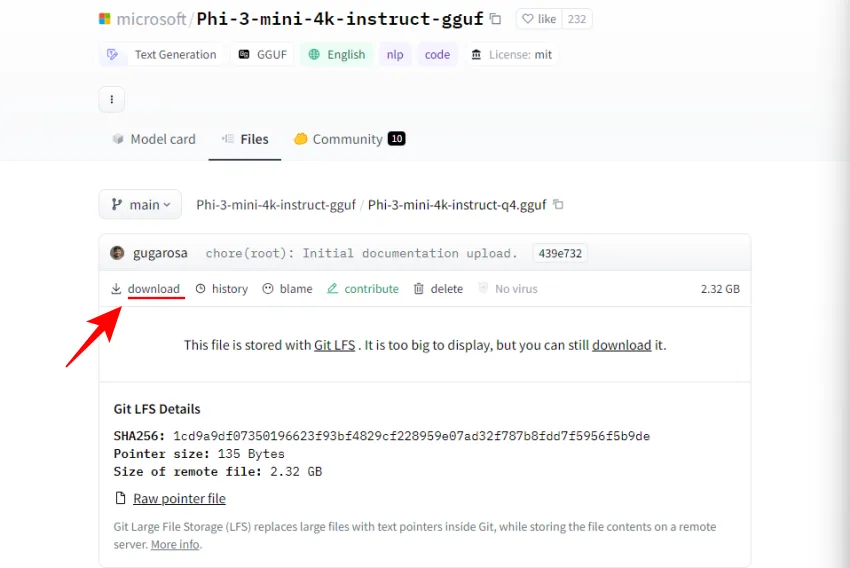

- Klik op Downloaden .

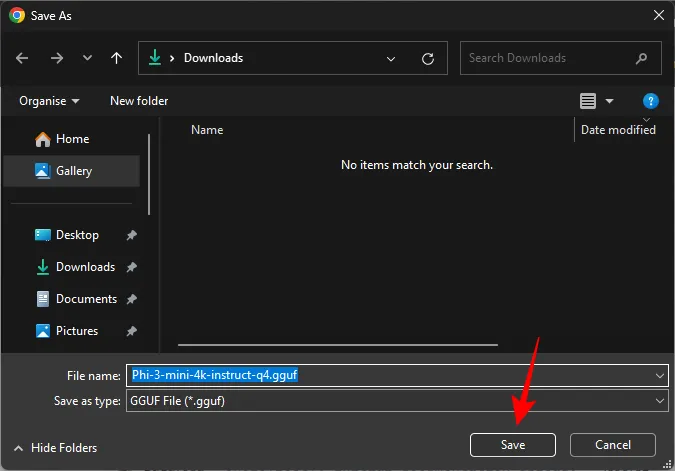

- Bewaar het vervolgens op een handige locatie.

Stap 3: Laad het Phi-3-model

Vervolgens gaan we het gedownloade Phi-3-model laden. Volg hiervoor de stappen:

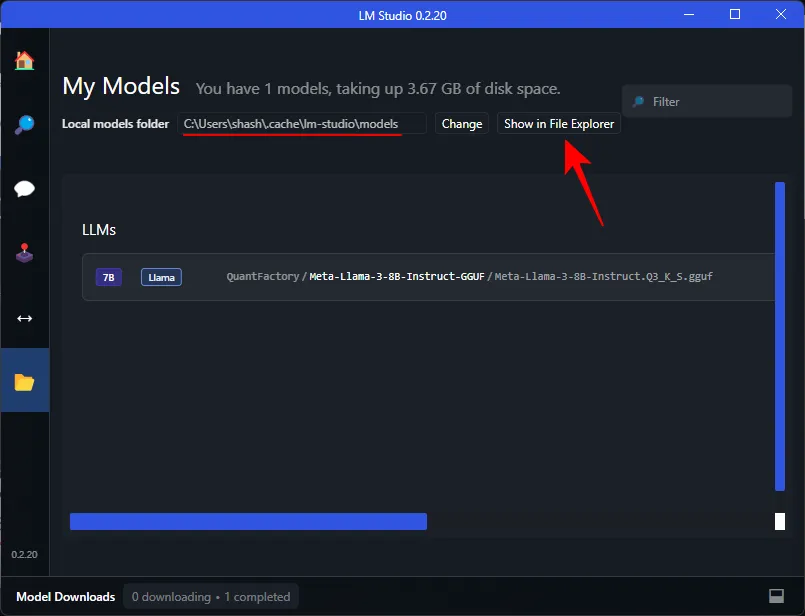

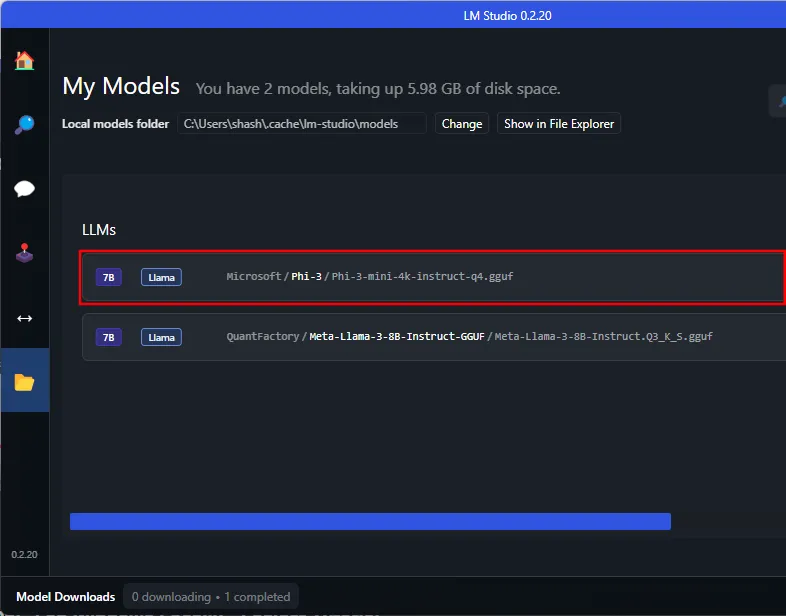

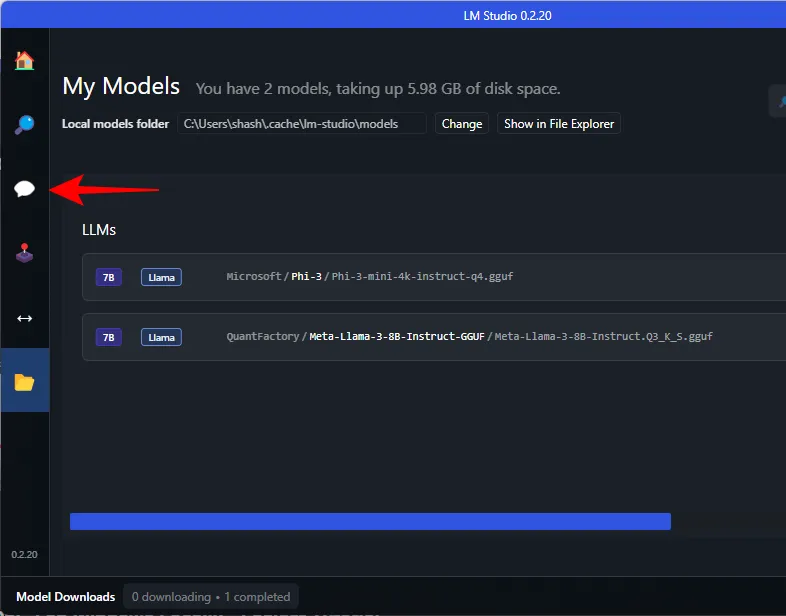

- Open LM Studio en klik links op Mijn modellen .

- Noteer de map ‘Lokale modellen’. Dit is waar we het gedownloade Phi-3 guff-bestand moeten verplaatsen. Klik op Weergeven in Verkenner om de map te openen.

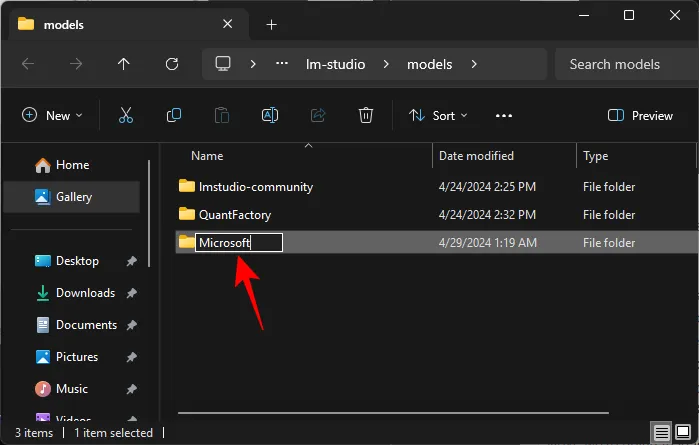

- Maak hier een nieuwe map met de naam Microsoft .

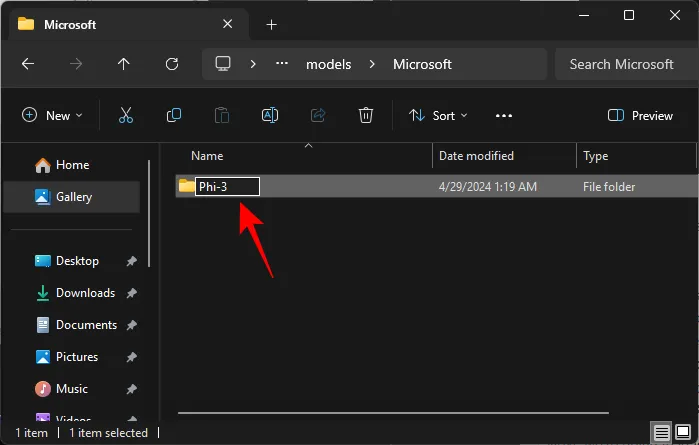

- Maak in de Microsoft-map een andere map met de naam Phi-3 .

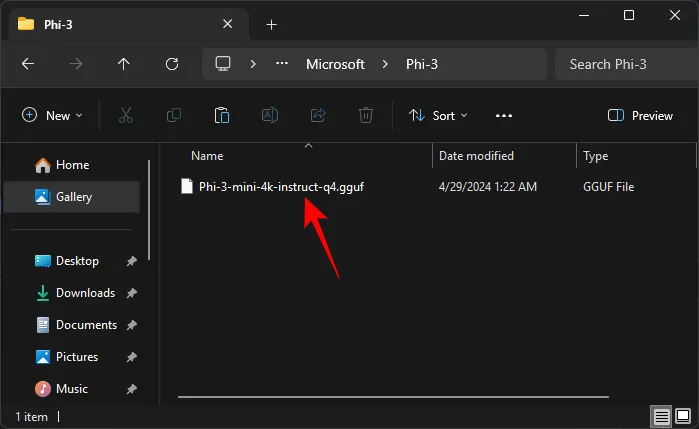

- Plak het gedownloade Phi-3 guff-bestand in de Phi-3-map.

- Zodra je het Phi-3 guff-bestand hebt verplaatst, verschijnt het ook in LM Studio.

Mogelijk moet u LM Studio opnieuw opstarten om Phi-3 in de map te herkennen. - Om het Phi-3-model te laden, klikt u op de AI Chat- optie aan de linkerkant.

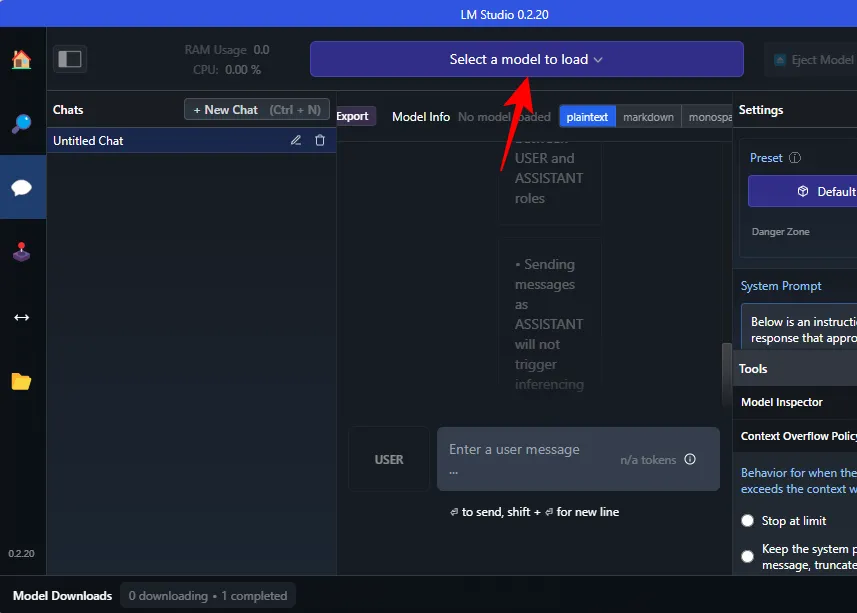

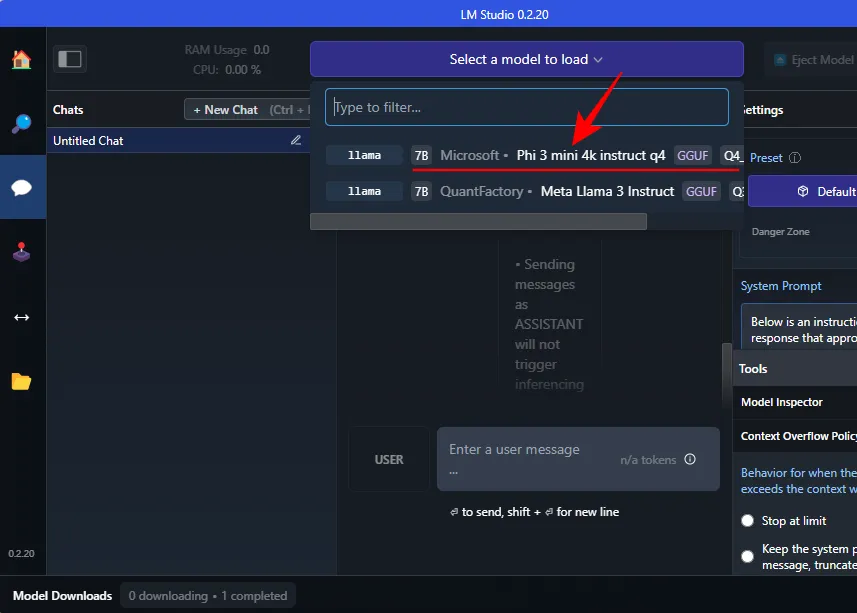

- Klik op Selecteer een model om te laden .

- En selecteer het Phi-3-model.

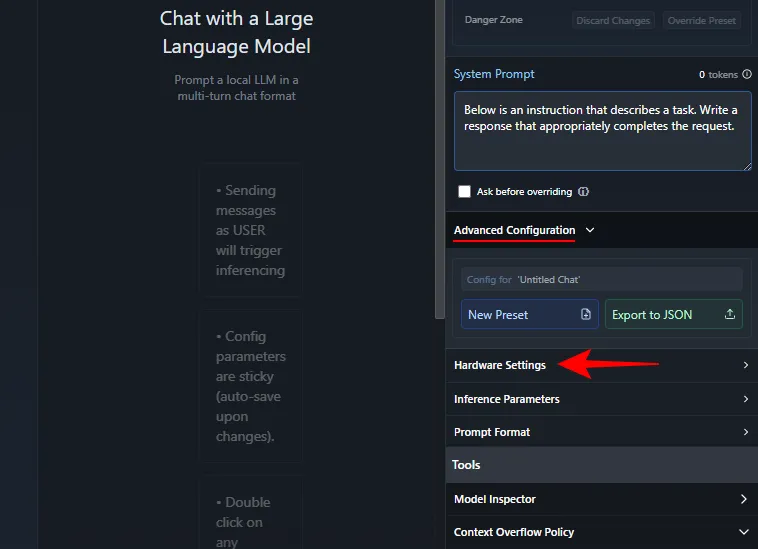

- Wacht tot het is geladen. Als u klaar bent, kunt u beginnen met chatten met Phi-3. We raden echter aan om het model over te dragen naar de GPU, zodat uw CPU niet onder onnodige druk komt te staan. Om dit te doen, klikt u onder ‘Systeemprompt’ aan de rechterkant op Geavanceerde configuratie > Hardware-instellingen .

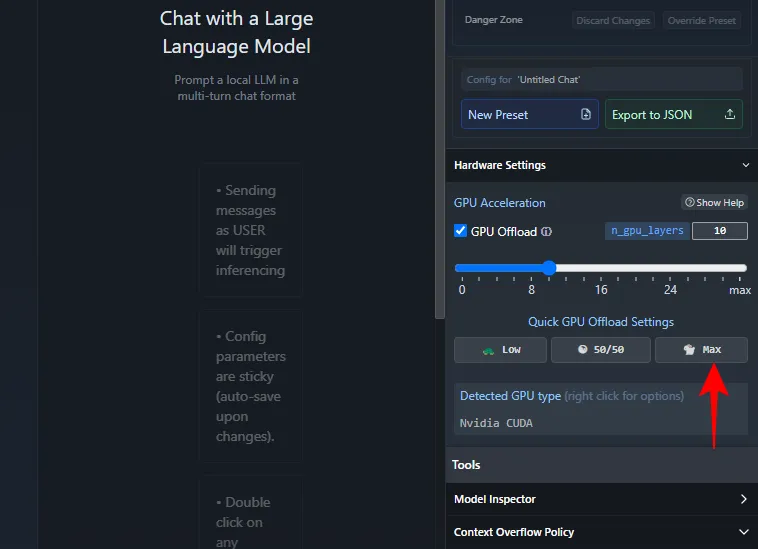

- Klik onder ‘GPU-versnelling’ op Max .

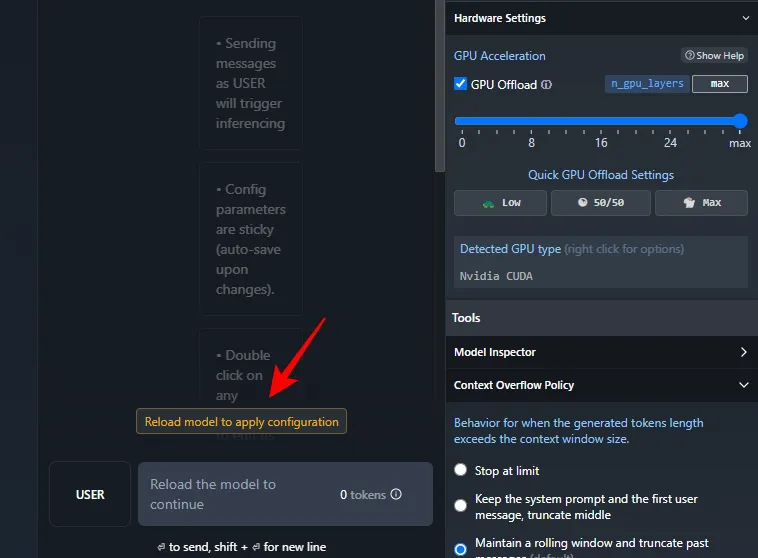

- Klik op Model opnieuw laden om de configuratie toe te passen .

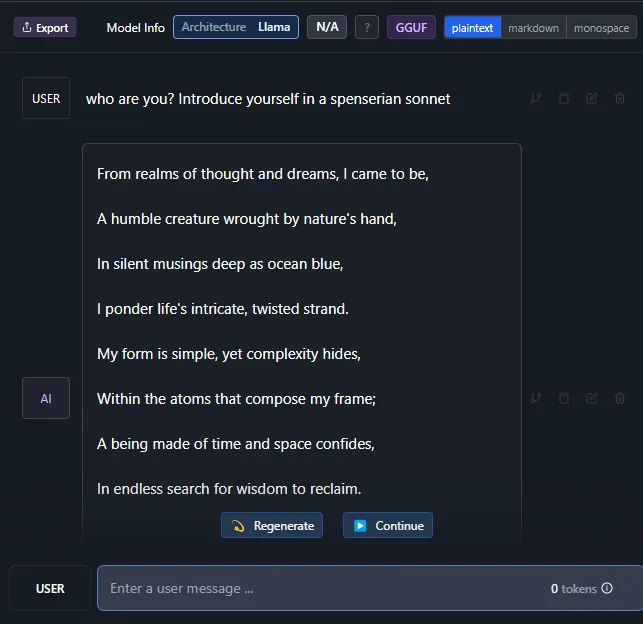

- Zodra het model is geladen, kunt u beginnen met chatten met Phi-3.

Stap 4: Begin met chatten met Microsoft’s Phi-3 LLM

En dat is het dan ook. Ga je gang en voer een prompt in. Ongeacht of u wel of geen internetverbinding heeft, u kunt nu lokaal chatten met het Phi-3-model van Microsoft op uw Windows-pc.

FAQ

Laten we eens kijken naar enkele veelgestelde vragen over het lokaal uitvoeren van Microsoft’s Phi-3 op uw Windows-pc.

Hoe repareer ik Ollama die vastloopt bij het downloaden van Phi-3?

Als u problemen ondervindt bij het downloaden van Phi-3 via Ollama op de opdrachtprompt, voert u de opdracht eenvoudigweg ollama run phi3opnieuw in. De download wordt hervat vanaf het punt waar deze eerder werd getroffen.

We hopen dat deze handleiding u heeft geholpen om het Phi-3-model van Microsoft lokaal op uw Windows-pc uit te voeren via Ollama en LM Studio. Tot de volgende keer!

Geef een reactie