Beste open source-alternatieven voor Crawl4AI: beste opties vergeleken

Crawl4AI dient als een aanvullende tool voor webcrawlen en data-extractie, met name gericht op de vereisten van grote taalmodellen (LLM’s) en talloze AI-gebaseerde applicaties. Toch is het niet de enige kanshebber in deze ruimte. In dit artikel zullen we de beste open-source alternatieven voor Crawl4AI verkennen .

Toonaangevende open source-alternatieven voor Crawl4AI

Hieronder vindt u enkele opvallende open-sourcealternatieven voor Crawl4AI.

- Schrapen

- Collie

- PySpider

- X-Crawl

- Vuurkruipen

1] Slordig

Scrapy onderscheidt zich als een Python-gebaseerd open-source framework dat is ontworpen voor web scraping en crawling. Het stelt gebruikers in staat om efficiënt data uit webpagina’s te halen. Dankzij het gebruik van Twisted, een asynchroon netwerkframework, verbetert Scrapy de prestaties en verwerkingssnelheid.

Dit framework ondersteunt de toevoeging van middleware en pipelines, wat aangepaste gegevensverwerking mogelijk maakt. Scrapy is bedreven in het beheren van verzoeken, het traceren van links en het extraheren van informatie met behulp van CSS-selectors en XPath, en past naadloos in uw huidige omgeving.

Daarnaast biedt Scrapy een gebruiksvriendelijke interface, die het proces van het volgen en extraheren van data van verschillende websites vereenvoudigt. Het platform wordt ondersteund door een levendige community en uitgebreide documentatie.

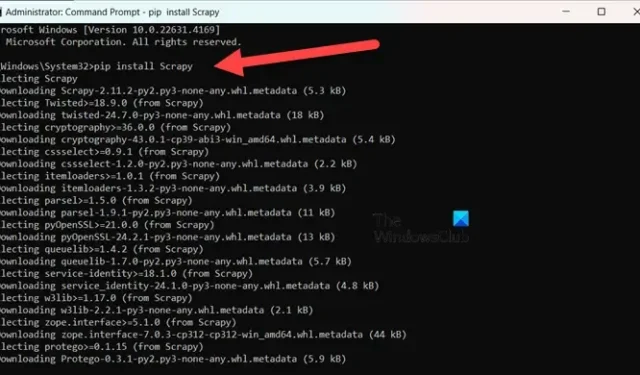

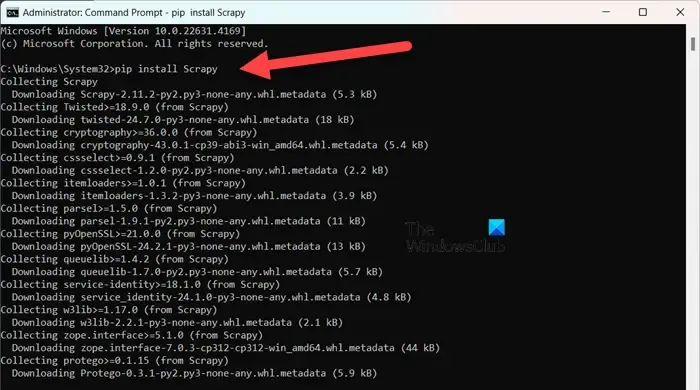

Om Scrapy te installeren , moet u ervoor zorgen dat u Python 3.8 of hoger gebruikt (CPython is de standaard, maar PyPy wordt ook ondersteund). Als u Anaconda of Miniconda gebruikt, installeert u het pakket via het conda-forge-kanaal met de volgende opdracht:

conda install -c conda-forge scrapy

Als alternatief kunt u, als u de voorkeur geeft aan PyPI, de opdracht uitvoeren in een opdrachtprompt met verhoogde bevoegdheden:

pip install Scrapy

Ga naar scrapy.org voor meer informatie over deze tool .

2] Collie

Colly is een eenvoudige scrapingbibliotheek die is ontwikkeld voor Golang. Het vereenvoudigt het proces van het verzenden van HTTP-verzoeken, HTML-parsing en het ophalen van gegevens van websites. Colly bevat functies waarmee ontwikkelaars door webpagina’s kunnen navigeren, elementen kunnen filteren met CSS-selectors en verschillende uitdagingen op het gebied van gegevensextractie kunnen aanpakken.

De opvallende eigenschap van Colly is de opmerkelijke prestatie, die meer dan 1000 verzoeken per seconde kan verwerken op één core; deze snelheid neemt toe met extra cores. Het bereikt deze efficiëntie dankzij de ingebouwde caching en ondersteuning voor zowel synchrone als asynchrone scraping.

Colly kent echter wel beperkingen, zoals het ontbreken van JavaScript-rendering en een kleinere community, wat leidt tot minder extensies en minder documentatie.

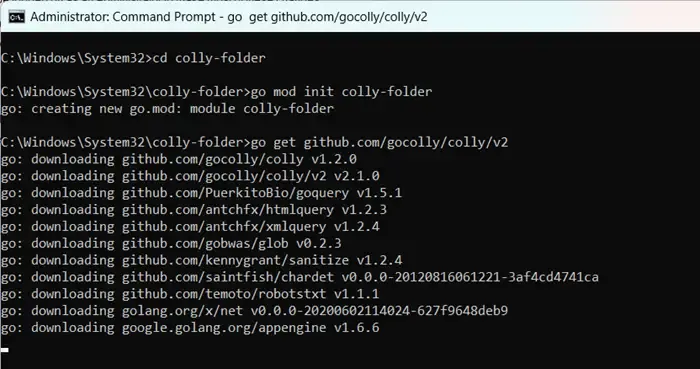

Om aan de slag te gaan met Colly, installeert u eerst Golang door go.dev te bezoeken . Na de installatie start u uw computer opnieuw op, opent u de opdrachtprompt als beheerder en voert u de volgende opdrachten in:

mkdir colly-folder cd colly-folder

go mod init colly-folder

go get github.com/gocolly/colly/v2

U kunt “colly-folder” hernoemen naar wat u maar wilt. Nadat u de module hebt gebouwd, kunt u uw webscraper uitvoeren met go run main.go.

3] PySpider

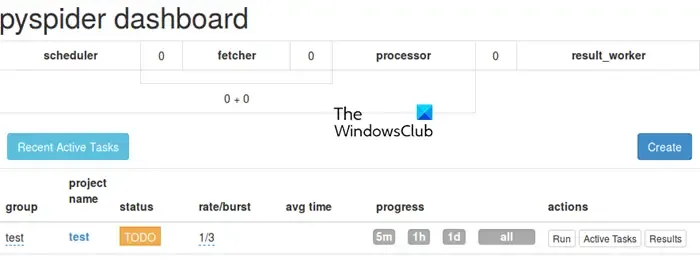

PySpider werkt als een uitgebreid webcrawlsysteem met een intuïtieve webgebaseerde gebruikersinterface, die het beheer en de monitoring van uw crawlers vereenvoudigt. Het is uitgerust om websites te verwerken die rijk zijn aan JavaScript door de integratie met PhantomJS.

In tegenstelling tot Colly biedt PySpider uitgebreide taakbeheermogelijkheden, waaronder het plannen en prioriteren van taken, waarmee het Crawl4AI in dit opzicht overtreft. Het is echter vermeldenswaard dat het qua prestaties achter kan blijven bij vergelijking met Crawl4AI vanwege de async-architectuur van laatstgenoemde.

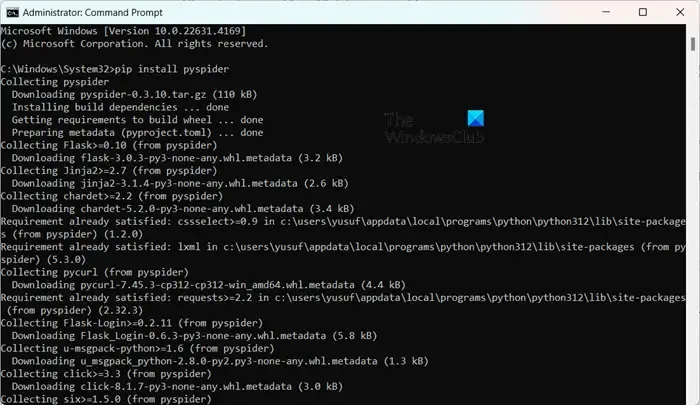

Het installeren van PySpider is ongecompliceerd, vooral als u Python al hebt ingesteld. U kunt het gewoon uitvoeren pip install pyspiderin een verhoogde opdrachtprompt. Om te beginnen gebruikt u gewoon de opdracht pyspideren opent u de interface op http://localhost:5000/ in uw webbrowser.

4] X-Crawl

X-Crawl is een flexibele bibliotheek voor Node.js die gebruikmaakt van AI-technologieën om de efficiëntie van webcrawlen te verbeteren. Deze bibliotheek integreert AI-mogelijkheden om de ontwikkeling van effectieve webcrawlers en scrapers te vergemakkelijken.

X-Crawl excelleert in het beheren van dynamische content die gegenereerd wordt door JavaScript, een noodzaak voor veel moderne websites. Het biedt ook talloze aanpassingsopties, afgestemd op het finetunen van de crawling-ervaring op uw behoeften.

Het is belangrijk om op te merken dat er een aantal verschillen zijn tussen Crawl4AI en X-Crawl, voornamelijk gebaseerd op uw favoriete programmeertaal: Crawl4AI gebruikt Python, terwijl X-Crawl geworteld is in Node.js.

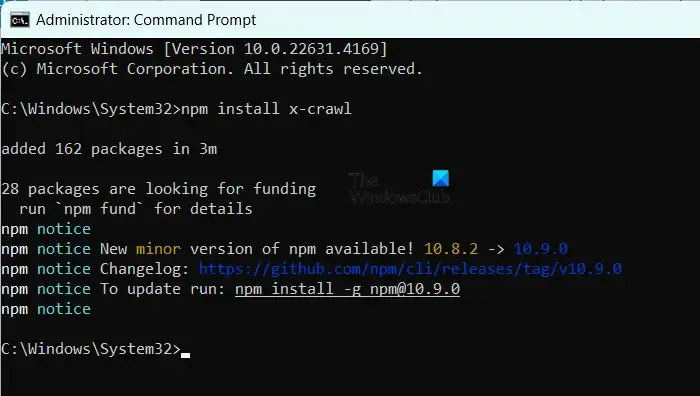

Om X-Crawl te installeren, moet u ervoor zorgen dat Node.js op uw computer staat. Voer vervolgens de opdracht uit npm install x-crawl.

5] Vuurkruipen

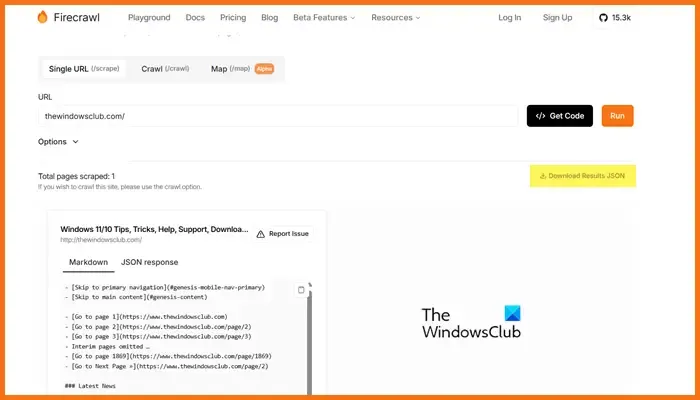

Firecrawl, ontwikkeld door Mendable.ai, is een geavanceerde web scraping tool die webdata omzet in netjes georganiseerde markdowns of andere formaten, geoptimaliseerd voor grote taalmodellen (LLM’s) en AI-toepassingen. Het genereert outputs die klaar zijn voor LLM-gebruik, wat de integratie van deze content in diverse taalmodellen en AI-oplossingen vergemakkelijkt. De tool wordt geleverd met een gebruiksvriendelijke API om crawling-jobs in te dienen en resultaten te verkrijgen. Ga voor meer informatie over Firecrawl naar firecrawl.dev , voer de website-URL in die u wilt scannen en klik op Run.

Welk open source-hulpmiddel is optimaal voor webontwikkeling?

Er is een overvloed aan open-source webontwikkelingstools beschikbaar die u kunt gebruiken. Overweeg Visual Studio Code of Atom voor codebewerking. Als u frontend-frameworks nodig hebt, zijn Bootstrap en Vue.js uitstekende keuzes, terwijl Django en Express.js goed van pas komen voor backend-ontwikkeling. Daarnaast bieden platforms als Git, GitHub, Figma, GIMP, Slack en Trello ook open-sourceopties die uw webontwikkelingsworkflow kunnen verbeteren.

Zijn open source GPT-modellen toegankelijk?

Ja, er bestaan verschillende open-source GPT-modellen, waaronder GPT-Neo van EleutherAI, Cerebras-GPT, BLOOM, OpenAI’s GPT-2 en NVIDIA/Microsoft’s Megatron-Turing NLG. Deze modellen bieden een scala aan oplossingen om aan verschillende vereisten te voldoen, van algemene taalverwerking tot modellen die zijn ontworpen voor meertalige mogelijkheden of taken met hoge prestaties.

Geef een reactie