Hoe u uw website kunt beschermen tegen AI-scraping

Op dit moment is uw website misschien een all-you-can-eat buffet voor hongerige AI-scrapers die belast zijn met het verzamelen van data voor de training van grote taalmodellen zoals ChatGPT. Als u niet wilt dat uw waardevolle content het volgende door AI gegenereerde antwoord wordt, moet u uw website beschermen tegen deze nieuwe bedreiging voor intellectueel eigendom.

Hoe voorkom je dat AI scrapt?

Het beschermen van uw website tegen AI-scraping is niet zo’n uitdaging als het lijkt. Sterker nog, veel van de beproefde methoden die worden gebruikt om traditionele webscraping te bestrijden, zijn net zo effectief tegen hun AI-aangedreven tegenhangers.

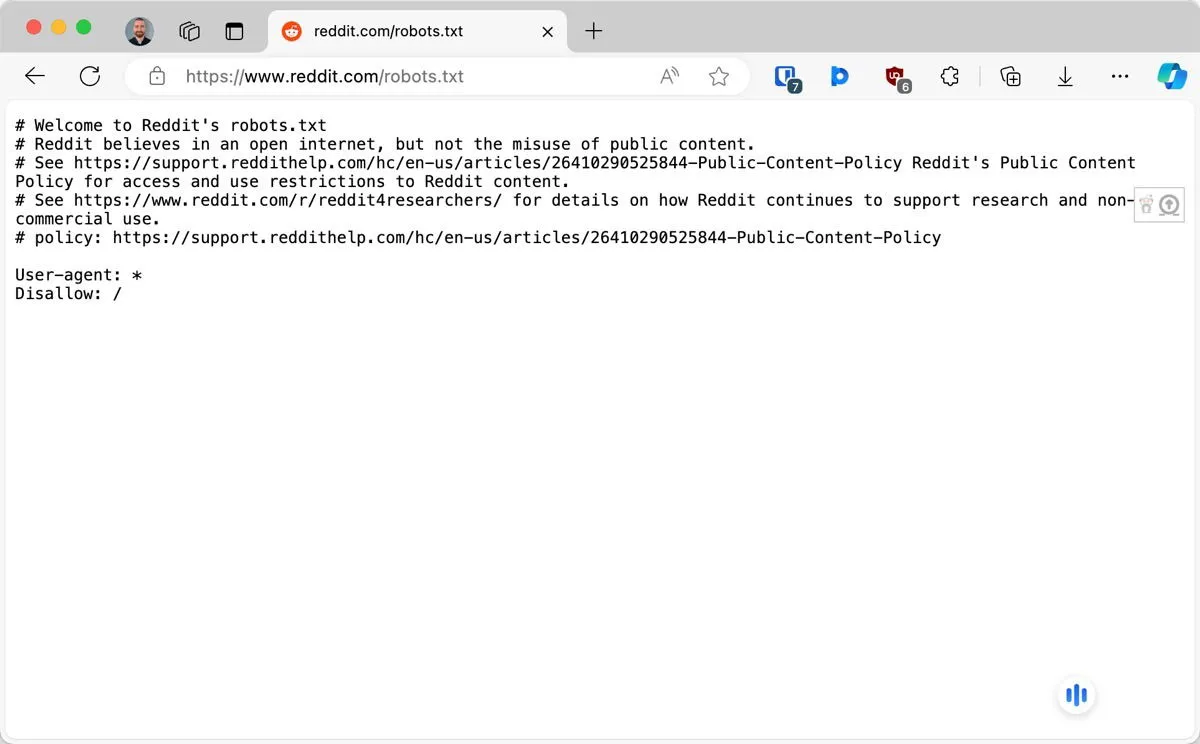

1. Configureer robots.txt om specifieke AI-bots te blokkeren

Het robots.txt-bestand is de eerste verdedigingslinie van uw website tegen ongewenste crawlers, waaronder crawlers van OpenAI en Anthropic. Dit bestand wordt gebruikt om het Robots Exclusion Protocol te implementeren en goed opgevoede bots te informeren over welke delen van uw site ze mogen bezoeken.

Je zou het robots.txt-bestand in de rootdirectory van een website moeten kunnen vinden. Als het daar niet staat, kun je het met elke teksteditor maken. Om een specifieke AI-bot te blokkeren, hoef je maar twee regels te schrijven:

De eerste regel identificeert de bot en de tweede regel vertelt hem om geen pagina’s te openen. In het bovenstaande voorbeeld blokkeren we de crawler van OpenAI. Hier zijn de namen van andere AI-bots die u zou moeten overwegen te blokkeren: Google-Extended, Claude-Web, FacebookBot en anthropic-ai.

2. Implementeer snelheidsbeperking en IP-blokkering

Snelheidsbeperking en IP-blokkering werken door de verkeersstroom naar uw website te bewaken en te controleren:

- Rate limiting stelt een limiet in op het aantal verzoeken dat een gebruiker (of bot) binnen een bepaald tijdsbestek kan doen. Als een bezoeker deze limiet overschrijdt, wordt hij tijdelijk geblokkeerd of worden zijn verzoeken vertraagd.

- Met IP-blokkering kunt u daarentegen specifieke IP-adressen of -bereiken die u als bronnen van scraping-activiteiten hebt geïdentificeerd, volledig blokkeren.

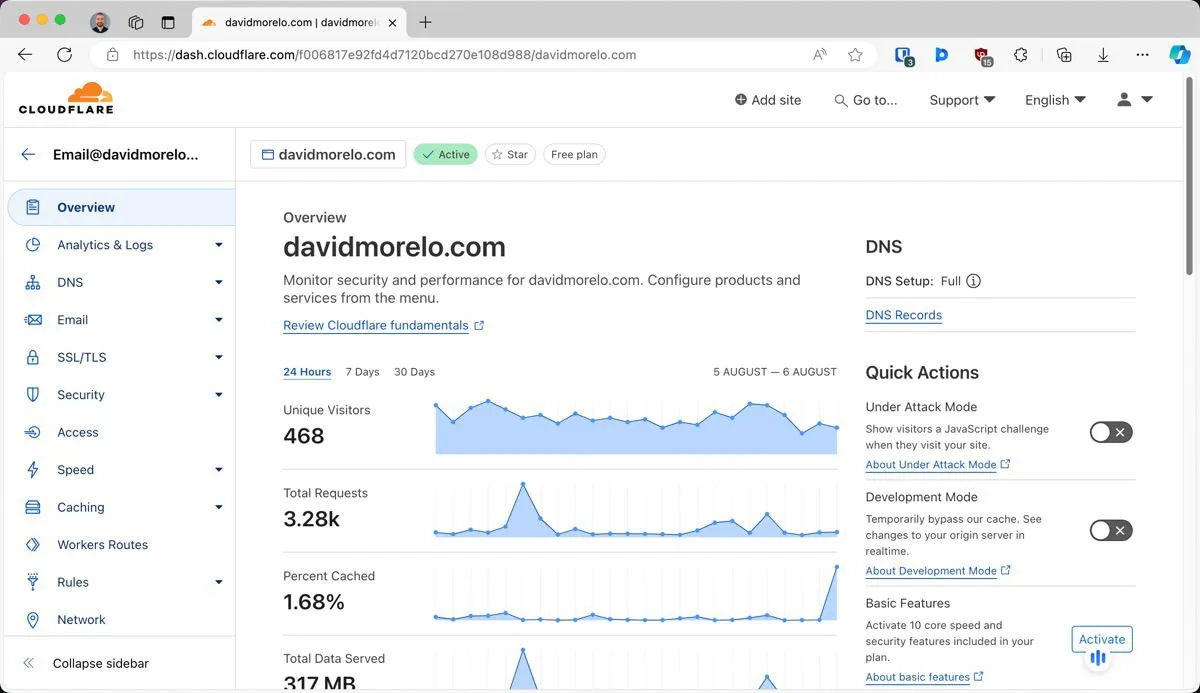

Een van de eenvoudigste manieren om deze technieken te implementeren, is door gebruik te maken van Cloudflare, een populaire content delivery network (CDN) en beveiligingsservice.

Cloudflare bevindt zich tussen uw server en het internet in het algemeen, waar het fungeert als een beschermend schild voor uw website. Zodra u uw website achter Cloudflare hebt geplaatst, kunt u snelheidsbeperkende regels configureren en IP-blokken beheren vanaf een gebruiksvriendelijk dashboard.

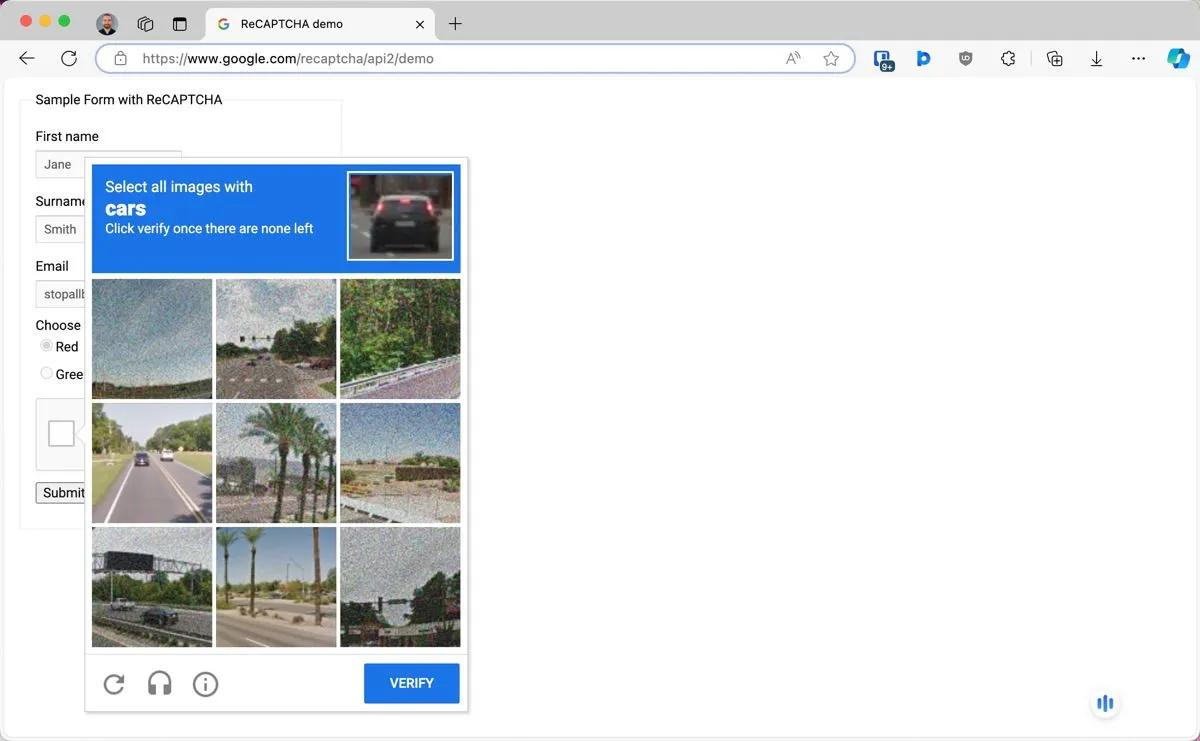

3. Gebruik CAPTCHA’s en andere menselijke verificatiemethoden

CAPTCHA’s (Completely Automated Public Turing test to tell Computers and Humans Apart) zijn een beproefde methode om menselijke gebruikers van bots te onderscheiden.

Een van de populairste en tegelijkertijd meest effectieve CAPTCHA’s is Google’s reCAPTCHA. Om het te gebruiken, moet u naar de reCAPTCHA-beheerconsole gaan en u aanmelden voor een API-sleutelpaar. Vervolgens kunt u een WordPress-plug-in gebruiken zoals Advanced Google reCAPTCHA of een aangepaste implementatie maken op basis van de officiële documentatie .

4. Gebruik dynamische content rendering-technieken

Een andere slimme manier om uw website te beschermen tegen AI-scraping is het gebruiken van dynamische content rendering-technieken. Het idee is simpel maar effectief: wanneer een AI-scraping-bot uw site bezoekt, ontvangt deze waardeloze content of helemaal niets, terwijl gewone bezoekers de juiste, volledige content zien.

In de praktijk werkt het als volgt:

- Uw server identificeert de agent die de site bezoekt en maakt daarbij onderscheid tussen gewone gebruikers en potentiële AI-bots.

- Op basis van deze identificatie bepaalt uw server met behulp van JavaScript-logica welke inhoud moet worden weergegeven.

- Voor menselijke bezoekers levert de server de volledige versie van uw site. Voor bots levert het een andere set content.

Omdat AI-scrapers doorgaans geen JavaScript-code verwerken (alleen eenvoudige HTML-inhoud), kunnen ze niet beseffen dat ze voor de gek zijn gehouden.

5. Stel inhoudsauthenticatie en gated access in

Een van de meest onfeilbare manieren om je content te beschermen tegen AI-scrapers is om het simpelweg achter een digitale poort te zetten. Deze bots kunnen immers alleen oogsten wat openbaar toegankelijk is.

De eenvoudigste vorm van deze bescherming is om gebruikers te laten inloggen om toegang te krijgen tot bepaalde delen van uw website. Dit alleen al kan AI-scraperbots afschrikken, omdat ze doorgaans niet de mogelijkheid hebben om accounts aan te maken of zichzelf te authenticeren.

Voor degenen die nog een stap verder willen gaan, kan het plaatsen van een deel of al uw content achter een betaalmuur een nog sterkere bescherming bieden. WordPress-gebruikers kunnen dit bijvoorbeeld eenvoudig implementeren met behulp van plugins zoals MemberPress .

Natuurlijk moet u een balans vinden tussen bescherming en toegankelijkheid. Niet alle bezoekers zijn bereid om een account aan te maken om toegang te krijgen tot uw content, laat staan om ervoor te betalen. De haalbaarheid van deze aanpak hangt volledig af van de aard van uw content en de verwachtingen van uw publiek.

6. Watermerk of vergiftig uw afbeeldingen

Digitale watermerken zijn een klassieke techniek voor het beschermen van intellectueel eigendom, maar het evolueert om de uitdagingen van het AI-tijdperk aan te gaan. Een opkomende techniek in deze ruimte is datavergiftiging, waarbij subtiele wijzigingen in uw content worden aangebracht die voor mensen niet waarneembaar zijn, maar die AI-systemen die proberen het te scrapen of analyseren, kunnen verwarren of verstoren.

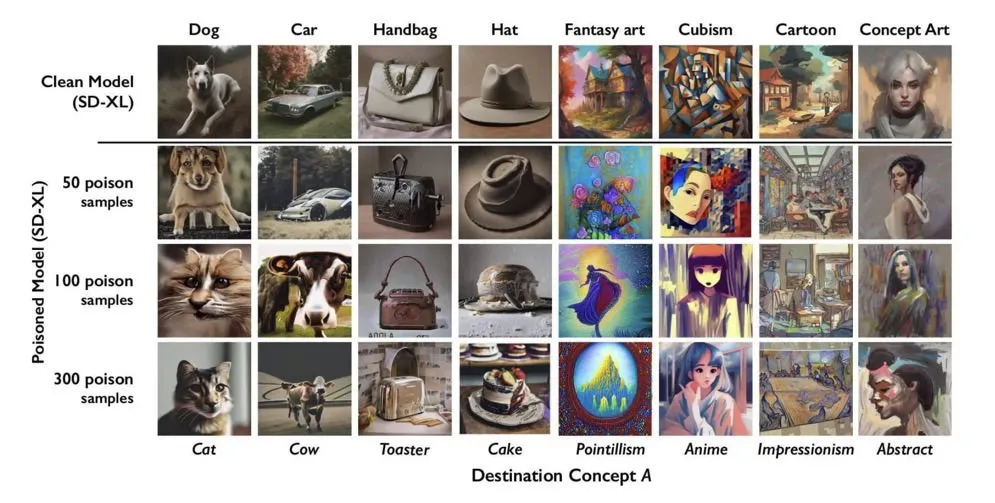

Tools zoals Glaze kunnen afbeeldingen op manieren veranderen waardoor ze moeilijk nauwkeurig te verwerken zijn voor AI-modellen, terwijl ze er voor menselijke kijkers nog steeds normaal uitzien. Er is ook Nightshade , dat datavergiftiging een stap verder brengt door actief in te grijpen in AI-training.

Door kleine wijzigingen in afbeeldingen aan te brengen, kan Nightshare de aannames die AI-modellen tijdens de training maken, ‘doorbreken’. Als een AI-systeem probeert te leren van deze vergiftigde afbeeldingen, kan het moeite hebben om nauwkeurige representaties te genereren.

Theoretisch gezien kan uw content, als deze goed is gewatermerkt of vergiftigd, nog steeds worden gescraped, maar AI-bedrijven zullen deze minder snel opnemen in hun trainingsdata. Ze kunnen zelfs actief voorkomen dat ze in de toekomst van uw site scrapen om te voorkomen dat hun datasets worden verontreinigd.

7. Maak gebruik van DMCA-verwijderingsmeldingen en auteursrechtwetten

Hoewel de voorgaande methoden zich richten op het voorkomen van AI-scraping met behulp van technische maatregelen, is het soms beter om een andere aanpak te kiezen en gebruik te maken van de Digital Millennium Copyright Act (DMCA)-kennisgevingen en auteursrechtwetten.

Als u ontdekt dat uw content is gescraped en zonder toestemming wordt gebruikt, kunt u een DMCA-verwijderingsbericht indienen. Dit is een formeel verzoek om uw auteursrechtelijk beschermde materiaal van een website of platform te laten verwijderen.

Als uw DMCA-verwijderingsverzoeken niet worden gehonoreerd (en wees erop voorbereid dat dit niet zal gebeuren), kunt u een rechtszaak aanspannen. U zult niet de eerste zijn die dat doet.

OpenAI en Microsoft worden momenteel aangeklaagd voor schendingen van het auteursrecht door het Center for Investigative Reporting, samen met verschillende andere nieuwsorganisaties. Deze rechtszaken beweren dat AI-bedrijven auteursrechtelijk beschermde content gebruiken zonder toestemming of compensatie om hun modellen te trainen. Hoewel de uitkomst van deze zaken nog moet worden bepaald, banen ze de weg voor anderen om te volgen.

Omslagafbeelding gemaakt met DALL-E. Alle screenshots door David Morelo.

Geef een reactie