Wat is AI Web Scraping? De nieuwe manier om data te verzamelen

Heb je ooit openbaar beschikbare data, zoals prijzen, beoordelingen van klanten of vastgoedlijsten, van een website moeten halen, maar had je daar moeite mee? Steeds vaker gebruiken mensen AI-webscraping: ze combineren kunstmatige intelligentie (AI) met traditionele scrapingmethoden om data van het hele web te halen.

Wat is AI-webscraping?

AI web scraping is een geavanceerde aanpak voor data-extractie die de kracht van kunstmatige intelligentie combineert met traditionele web scraping-technieken. Het is alsof je je gewone web scraper een breinupgrade geeft: zodat hij zelfstandig kan denken, leren en zich kan aanpassen.

Omdat AI web scraping zoveel vormen kan hebben, kan de ene toepassing er compleet anders uitzien dan de andere. Bovendien ontwikkelt AI-technologie zich nog steeds razendsnel, dus wat nu nog niet mogelijk is, kan over een paar maanden mogelijk zijn.

Is AI-webscraping legaal?

Wij verstrekken geen juridisch advies. De wetgeving omtrent webscraping kan per land en rechtsgebied aanzienlijk verschillen. Raadpleeg daarom altijd een jurist voor advies dat specifiek is voor uw situatie.

Web scraping, of het nu door AI is verbeterd of niet, is over het algemeen legaal als u openbaar beschikbare gegevens van het internet verzamelt. Het sleutelwoord hier is “openbaar”. Als de informatie vrij toegankelijk is zonder dat er inloggegevens nodig zijn of beveiligingsmaatregelen moeten worden omzeild, is het doorgaans fair game.

Om extra veilig te zijn, moet u altijd rekening houden met de servicevoorwaarden van de website die u wilt scrapen. Veel websites verbieden scrapen expliciet in hun servicevoorwaarden. Hoewel het schenden van deze voorwaarden niet per se illegaal is, kan het mogelijk leiden tot civiele rechtszaken.

Wees ook voorzichtig dat u nooit een te grote belasting op de webservice creëert met uw scraping. Agressieve scraping die de servers van een website overbelast, kan worden beschouwd als een vorm van een denial of service (DoS)-aanval en juridische gevolgen hebben.

Waarin verschilt AI-webscraping van handmatig scrapen?

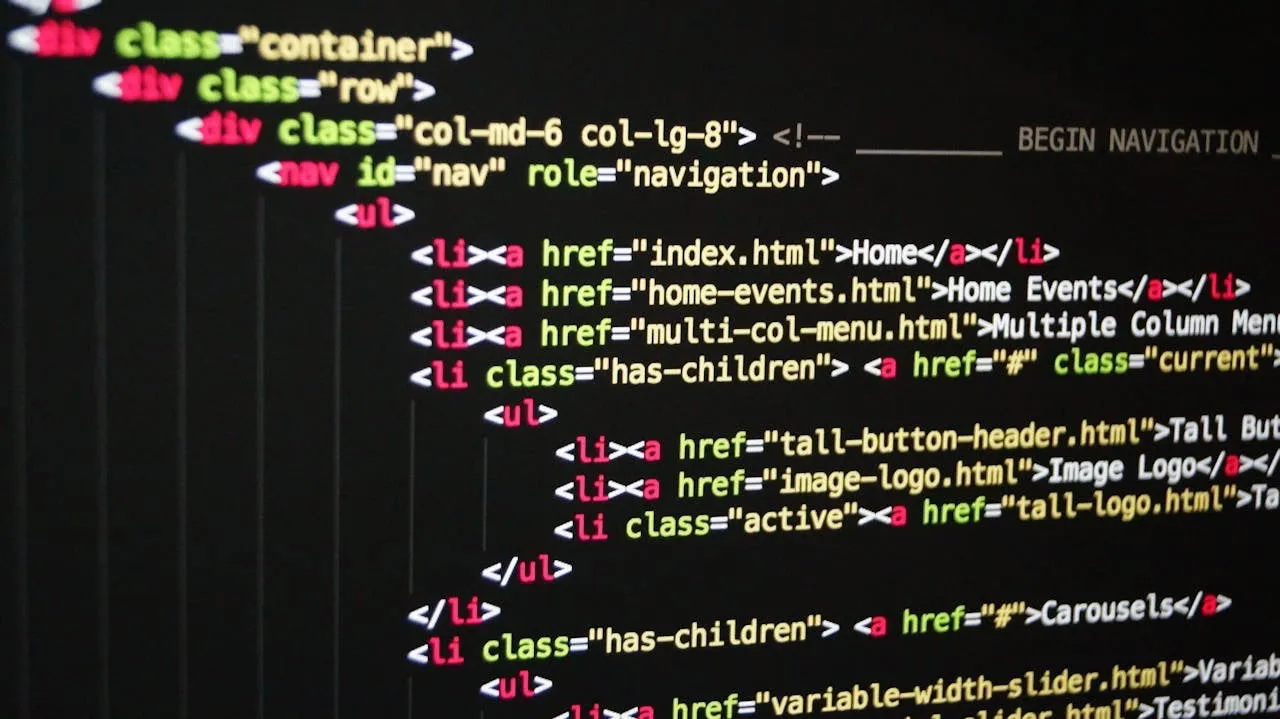

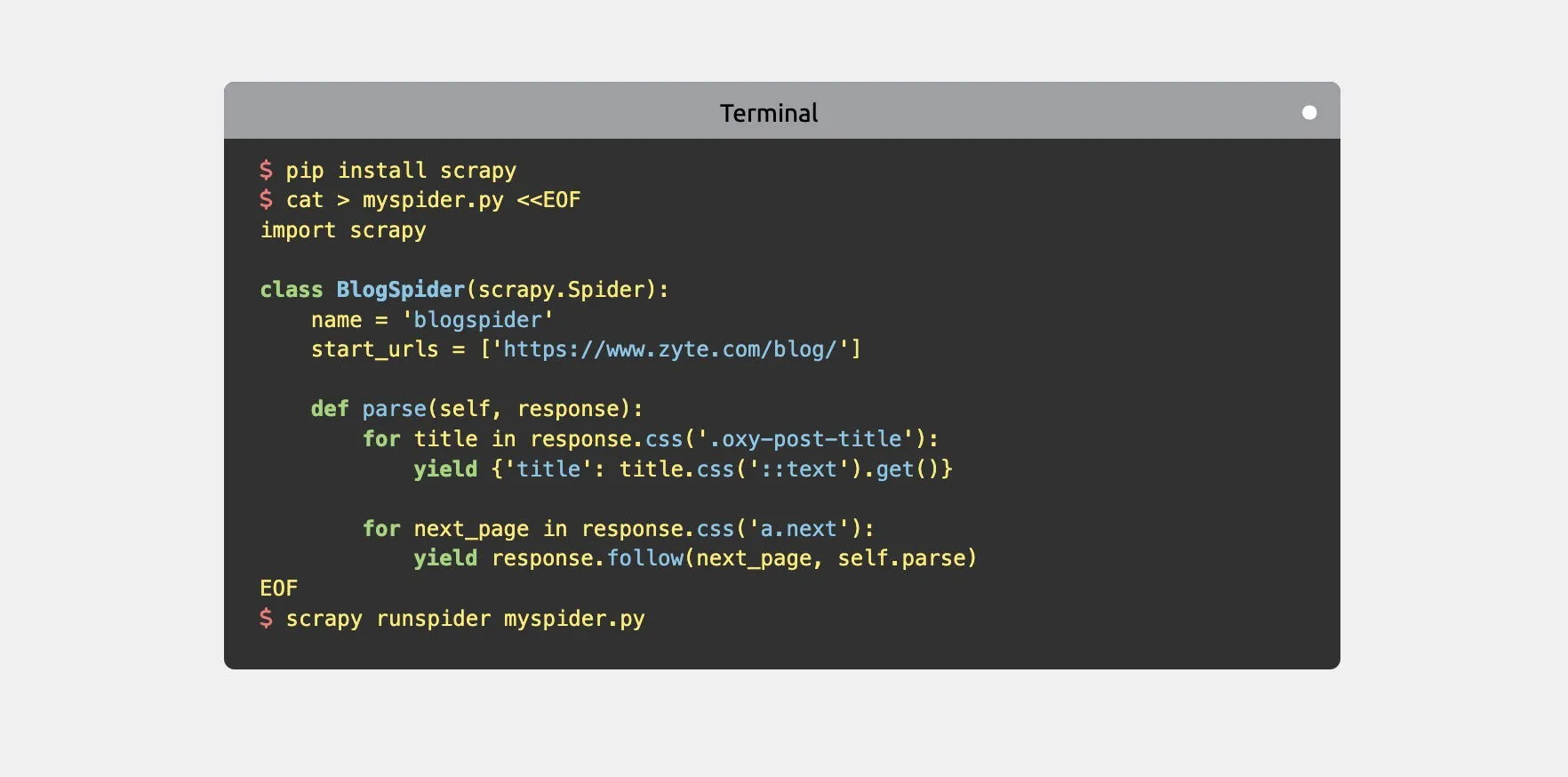

Traditionele web scraping omvat doorgaans het schrijven van aangepaste scripts of het gebruiken van tools zoals Beautiful Soup , Scrapy of Puppeteer om gegevens van websites te extraheren. Deze methoden vertrouwen op vooraf gedefinieerde regels en patronen om specifieke elementen van webpagina’s te vinden en te extraheren.

Zodra de gegevens zijn verzameld, is er vaak nog aanvullende verwerking en analyse nodig. Hiervoor kan gebruik worden gemaakt van spreadsheetsoftware of hulpmiddelen voor gegevensanalyse, zoals de Pandas-bibliotheek van Python .

Wanneer deze traditionele web scraping technieken worden gecombineerd met AI, hebben we het over AI web scraping. Hieronder volgen enkele voorbeelden van hoe de combinatie er in de praktijk uit kan zien:

- Met behulp van machine learning-modellen kunt u door complexe websites navigeren en eenvoudig dynamische inhoud en JavaScript-gerenderde pagina’s verwerken.

- Dankzij de visuele mogelijkheden van AI kunnen scrapers gegevens uit visuele content halen, niet alleen uit tekst.

- AI kan veranderingen in websitestructuren detecteren en zich hierop aanpassen. Hierdoor is er minder behoefte aan voortdurend onderhoud van scraping-scripts.

- Relevante informatie kan uit tekst worden gehaald op basis van een complex begrip van de context en semantiek van de gekopieerde tekst.

- Productbeoordelingen of opmerkingen op sociale media kunnen in een AI worden ingevoerd om sentimentanalyses uit te voeren en zo de emotionele toon van tekstgegevens te meten.

Zoals u kunt zien, kan AI in beeld komen in zowel de dataverzamelings- als data-analysefases van het webscrapingproces. In de dataverzamelingsfase verbetert AI het vermogen van de scraper om door websites te navigeren, relevante data te identificeren en zich in realtime aan te passen aan veranderingen. In de data-analysefase kan AI de verzamelde data verwerken en interpreteren op manieren die verder gaan dan eenvoudige extractie.

Wat zijn de belangrijkste voordelen van AI-scraping?

AI-aangedreven webscraping brengt een heleboel voordelen met zich mee. Laten we eens wat dieper ingaan op enkele van de belangrijkste.

Aanpassingsvermogen aan websitewijzigingen

Websites evolueren voortdurend, wat traditionele scrapers kapot kan maken. AI-aangedreven tools kunnen zich direct aanpassen aan deze veranderingen door nieuwe patronen te herkennen en hun scrapingstrategieën dienovereenkomstig aan te passen. Dit betekent minder downtime en onderhoud voor uw dataverzamelingsinspanningen.

Visie-gebaseerde data-analyse

Traditionele scrapers zijn beperkt tot tekstuele informatie, maar AI kan waardevolle inzichten uit afbeeldingen, grafieken en infographics halen. Dit opent een geheel nieuwe dimensie van data die voorheen ontoegankelijk was. AI kan bijvoorbeeld productfoto’s analyseren om kenmerken, kleuren en stijlen te identificeren, wat ongelooflijk handig is voor e-commerceconcurrenten die trends volgen.

Natuurlijke taalverwerking

AI kan de context en betekenis van verzamelde tekstgegevens begrijpen. Zoals eerder vermeld, kunnen bedrijven sentimentanalyse gebruiken om klanttevredenheid te meten op basis van verzamelde beoordelingen, of het kan grote hoeveelheden tekst samenvatten, content van buitenlandse markten vertalen en nog veel meer.

Wat zijn de uitdagingen en valkuilen van AI-webscraping?

Hoewel AI-webscraping talloze voordelen biedt, kent het ook uitdagingen. De belangrijkste zorg is de onvoorspelbare aard van AI-uitvoer. AI-modellen kunnen soms onverwachte of onjuiste resultaten produceren. Dit fenomeen, in AI-kringen vaak ‘hallucinatie’ genoemd, treedt op wanneer de AI aannemelijk klinkende informatie genereert die niet nauwkeurig is. In de context van webscraping kan dit geschraapte gegevens betekenen die correct lijken, maar in werkelijkheid door de AI zijn gefabriceerd.

Een andere mogelijke uitdaging is de afhankelijkheid van een externe AI-service, zoals ChatGPT of Claude. U kunt problemen ondervinden met de beschikbaarheid van de service, wijzigingen in prijsmodellen of aanpassingen aan de mogelijkheden van de AI die uw scraping-activiteiten kunnen verstoren.

AI web scraping is een nieuwe manier om openbaar beschikbare data van het web te verzamelen. Het combineert traditionele web scraping technieken met geavanceerde kunstmatige intelligentie bots om complexe websites te verwerken, inzichten uit visuele content te halen, zich aan te passen aan veranderingen in webstructuren en meer.

Afbeelding door David Morelo.

Geef een reactie