Crawl4AI의 최고 오픈소스 대안: 최상의 옵션 비교

Crawl4AI는 웹 크롤링 및 데이터 추출을 위한 보완 도구로, 특히 대규모 언어 모델(LLM) 및 수많은 AI 기반 애플리케이션의 요구 사항을 충족합니다. 그럼에도 불구하고 이 분야에서 유일한 경쟁자는 아닙니다. 이 기사에서는 Crawl4AI 의 최고 오픈소스 대안을 살펴보겠습니다 .

Crawl4AI의 주요 오픈소스 대안

Crawl4AI의 주요 오픈소스 대안은 다음과 같습니다.

- 긁힌

- 콜리

- 파이스파이더

- X-크롤

- 파이어크롤

1] 엉성함

Scrapy는 웹 스크래핑 및 크롤링을 위해 설계된 Python 기반 오픈소스 프레임워크로 두드러집니다. 사용자가 웹 페이지에서 데이터를 추출할 수 있도록 효율적으로 지원합니다. 비동기 네트워킹 프레임워크인 Twisted를 사용하여 Scrapy는 성능과 처리 속도를 향상시킵니다.

이 프레임워크는 미들웨어와 파이프라인 추가를 지원하여 사용자 지정 데이터 처리를 허용합니다. Scrapy는 CSS 선택기와 XPath를 사용하여 요청을 관리하고, 링크를 추적하고, 정보를 추출하는 데 능숙하여 현재 환경에 완벽하게 어울립니다.

또한, Scrapy는 사용자 친화적인 인터페이스를 제공하여 다양한 웹사이트에서 데이터를 추적하고 추출하는 과정을 간소화합니다. 이 플랫폼은 활기찬 커뮤니티와 포괄적인 문서로 지원됩니다.

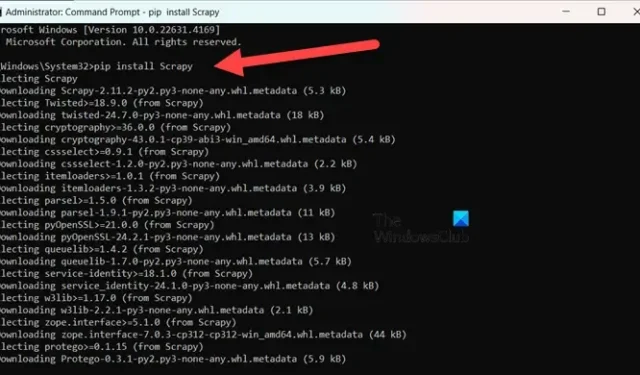

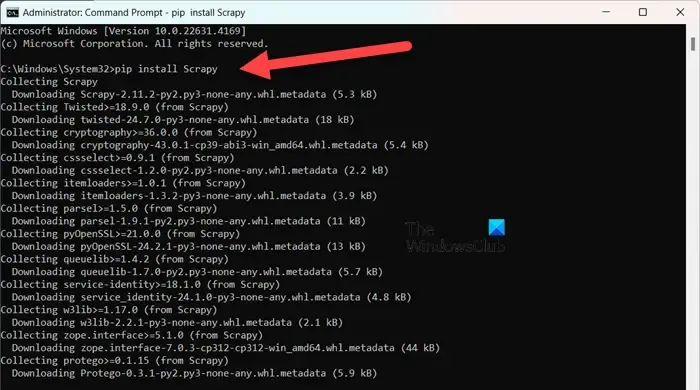

Scrapy를 설치 하려면 Python 3.8 이상을 사용해야 합니다(CPython이 기본이지만 PyPy도 지원됩니다). Anaconda 또는 Miniconda를 사용하는 경우 다음 명령으로 conda-forge 채널을 통해 패키지를 설치합니다.

conda install -c conda-forge scrapy

또는 PyPI를 선호하는 경우 관리자 권한 명령 프롬프트에서 명령을 실행하세요.

pip install Scrapy

이 도구에 대해 더 자세히 알아보려면 scrapy.org를 방문하세요 .

2] 콜리

Colly는 Golang을 위해 개발된 간단한 스크래핑 라이브러리입니다. HTTP 요청 전송, HTML 구문 분석 및 웹사이트에서 데이터 검색 프로세스를 간소화합니다. Colly는 개발자가 웹 페이지를 탐색하고 CSS 선택기를 사용하여 요소를 필터링하고 다양한 데이터 추출 과제를 해결할 수 있는 기능을 제공합니다.

Colly의 두드러진 특징은 놀라운 성능으로, 단일 코어에서 초당 1000개 이상의 요청을 처리할 수 있습니다. 이 속도는 추가 코어와 함께 증가합니다. 내장된 캐싱과 동기 및 비동기 스크래핑 지원 덕분에 이러한 효율성을 달성합니다.

하지만 Colly에는 JavaScript 렌더링 기능이 없고 커뮤니티 규모가 작다는 한계가 있어 확장 기능이 적고 문서도 부족하다는 단점이 있습니다.

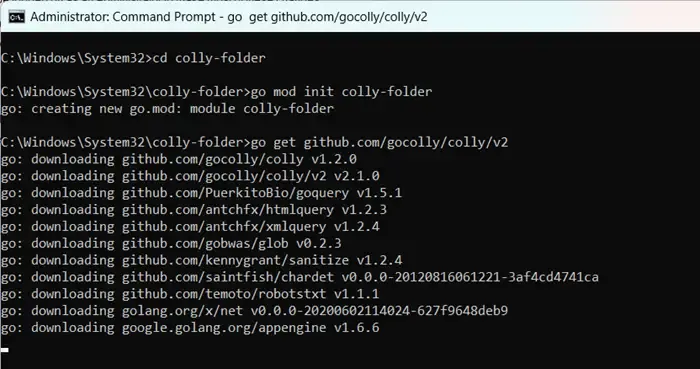

Colly를 시작하려면 먼저 go.dev를 방문하여 Golang을 설치합니다 . 설치 후 컴퓨터를 다시 시작하고 관리자 권한으로 명령 프롬프트를 열고 다음 명령을 입력합니다.

mkdir colly-folder cd colly-folder

go mod init colly-folder

go get github.com/gocolly/colly/v2

“colly-folder”의 이름을 원하는 대로 바꿀 수 있습니다. 모듈을 빌드한 후 .을 사용하여 웹 스크래퍼를 실행할 수 있습니다 go run main.go.

3] 파이스파이더

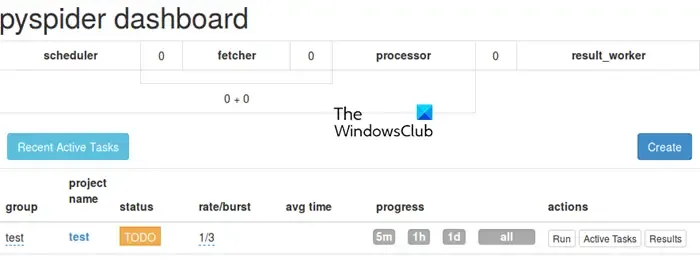

PySpider는 직관적인 웹 기반 사용자 인터페이스를 특징으로 하는 포괄적인 웹 크롤링 시스템으로 작동하여 크롤러의 관리 및 모니터링을 간소화합니다. PhantomJS와 통합하여 JavaScript가 풍부한 웹사이트를 처리할 수 있도록 갖춰져 있습니다.

Colly와 달리 PySpider는 작업 스케줄링 및 우선순위 지정을 포함한 광범위한 작업 관리 기능을 제공하며, 이 측면에서 Crawl4AI보다 성능이 뛰어납니다. 그러나 Crawl4AI의 비동기 아키텍처로 인해 성능이 떨어질 수 있다는 점에 유의해야 합니다.

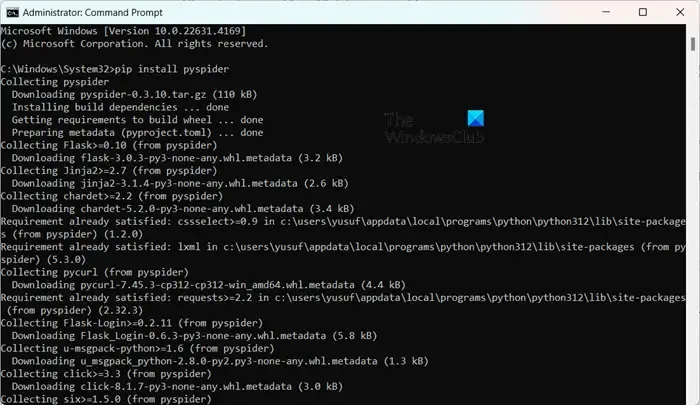

PySpider 설치는 복잡하지 않습니다. 특히 Python을 이미 설치했다면 더욱 그렇습니다. 단순히 pip install pyspider관리자 권한 명령 프롬프트에서 실행할 수 있습니다. 시작하려면 명령을 사용 pyspider하고 웹 브라우저에서 http://localhost:5000/에서 인터페이스에 액세스하기만 하면 됩니다.

4] X-크롤

X-Crawl은 Node.js를 위한 유연한 라이브러리로, AI 기술을 활용하여 웹 크롤링 효율성을 향상시킵니다. 이 라이브러리는 효과적인 웹 크롤러와 스크래퍼의 개발을 용이하게 하기 위해 AI 기능을 통합합니다.

X-Crawl은 많은 현대 웹사이트에 필수적인 JavaScript로 생성된 동적 콘텐츠를 관리하는 데 탁월합니다. 또한 사용자의 필요에 맞게 크롤링 경험을 미세 조정하도록 맞춤화된 수많은 사용자 정의 옵션도 제공합니다.

Crawl4AI와 X-Crawl 사이에는 몇 가지 차이점이 있는데, 이는 주로 선호하는 프로그래밍 언어에 따라 달라집니다. Crawl4AI는 Python을 사용하는 반면, X-Crawl은 Node.js에 기반을 두고 있습니다.

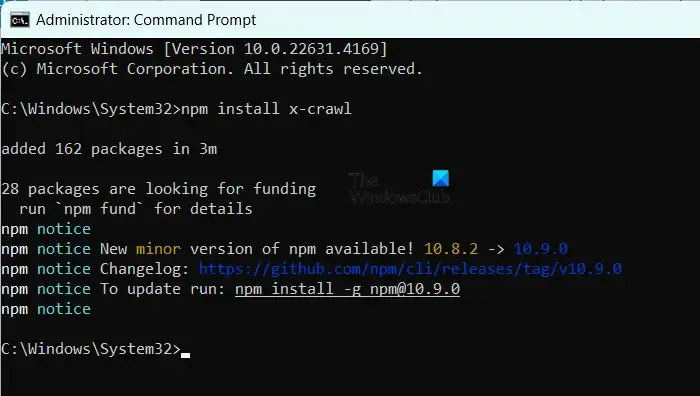

X-Crawl을 설치하려면 컴퓨터에 Node.js가 있는지 확인한 다음 명령을 실행하세요 npm install x-crawl.

5] 파이어크롤

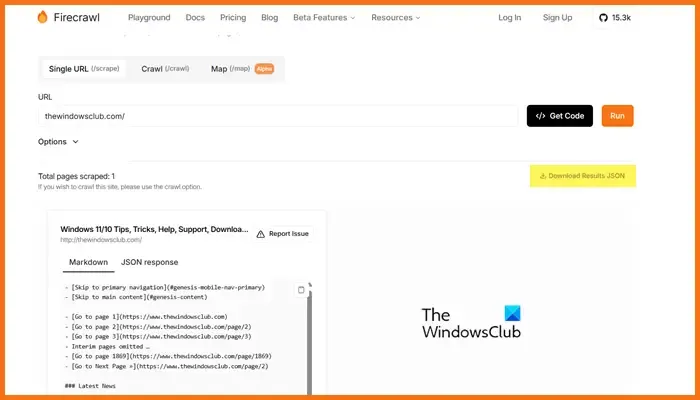

Mendable.ai에서 개발한 Firecrawl은 웹 데이터를 깔끔하게 정리된 마크다운이나 다른 형식으로 변환하는 정교한 웹 스크래핑 도구로, 대규모 언어 모델(LLM) 및 AI 애플리케이션에 최적화되어 있습니다. LLM에서 사용할 수 있는 출력을 생성하여 이 콘텐츠를 다양한 언어 모델과 AI 솔루션에 통합하는 것을 용이하게 합니다. 이 도구에는 크롤링 작업을 제출하고 결과를 얻을 수 있는 사용하기 쉬운 API가 함께 제공됩니다. Firecrawl에 대한 자세한 내용은 firecrawl.dev를 방문하여 스캔하려는 웹사이트 URL을 입력하고 실행을 클릭합니다.

웹 개발에 가장 적합한 오픈소스 도구는 무엇인가?

여러분이 활용할 수 있는 수많은 오픈소스 웹 개발 도구가 있습니다. 코드 편집을 위해 Visual Studio Code나 Atom을 고려하세요. 프런트엔드 프레임워크가 필요한 경우 Bootstrap과 Vue.js가 훌륭한 선택이고, Django와 Express.js는 백엔드 개발에 적합합니다. 또한 Git, GitHub, Figma, GIMP, Slack, Trello와 같은 플랫폼도 웹 개발 워크플로를 향상시킬 수 있는 오픈소스 옵션을 제공합니다.

오픈소스 GPT 모델에 접근할 수 있나요?

네, EleutherAI의 GPT-Neo, Cerebras-GPT, BLOOM, OpenAI의 GPT-2, NVIDIA/Microsoft의 Megatron-Turing NLG를 포함하여 다양한 오픈소스 GPT 모델이 있습니다. 이러한 모델은 범용 언어 처리부터 다국어 기능이나 고성능 작업을 위해 제작된 모델에 이르기까지 다양한 요구 사항에 맞는 다양한 솔루션을 제공합니다.

답글 남기기