Opera, 로컬 AI 모델을 통합하는 최초의 주요 브라우저가 됨

알아야 할 사항

- Opera는 약 150개의 로컬 LLM에 대한 기본 지원을 추가한 최초의 브라우저입니다.

- 로컬 LLM은 개인 정보 보호 및 보안을 강화하고 AI 모델에 오프라인으로 액세스하는 데 이상적입니다. 그러나 속도는 기계의 성능에 따라 달라집니다.

- Opera One의 개발자 스트림에서 로컬 AI 모델에 액세스할 수 있습니다.

Opera는 회사의 AI 통합 브라우저인 Opera One의 개발자 스트림에 150개의 로컬 LLM(대형 언어 모델) 변형에 대한 지원을 통합하고 있습니다. AI에 대한 실험적 로컬 지원이 브라우저에 추가된 것은 처음이며 브라우저 자체에서 바로 AI 모델에 쉽게 액세스할 수 있습니다.

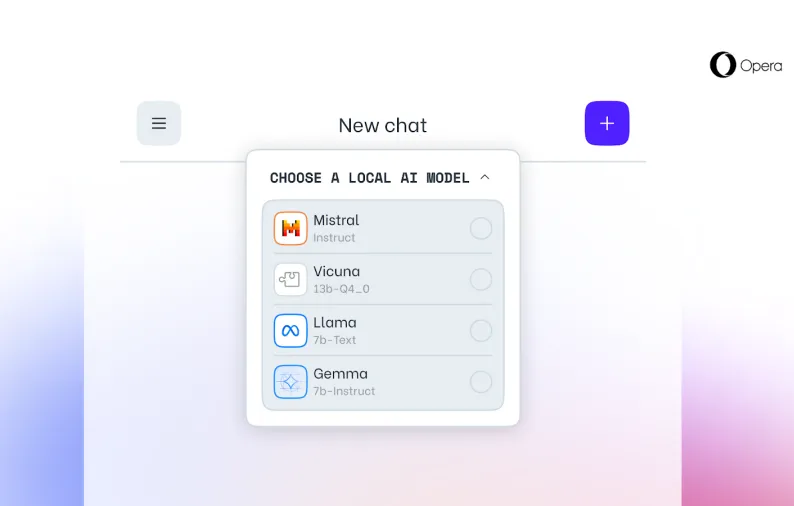

Opera One에서 가장 유명한 지역 LLM으로는 Meta의 Llama, Google의 Gemma, Vicuna 및 Mistral AI의 Mixtral 등이 있습니다. 이는 Opera 고유의 Aria 챗봇에 추가됩니다.

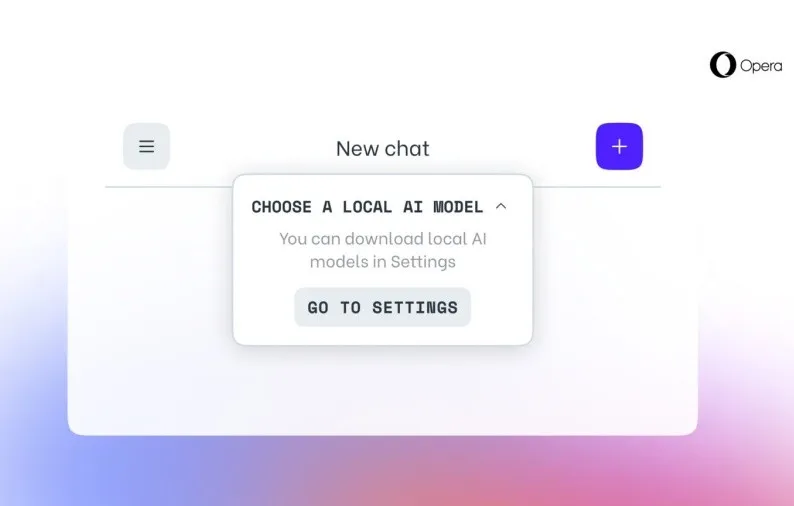

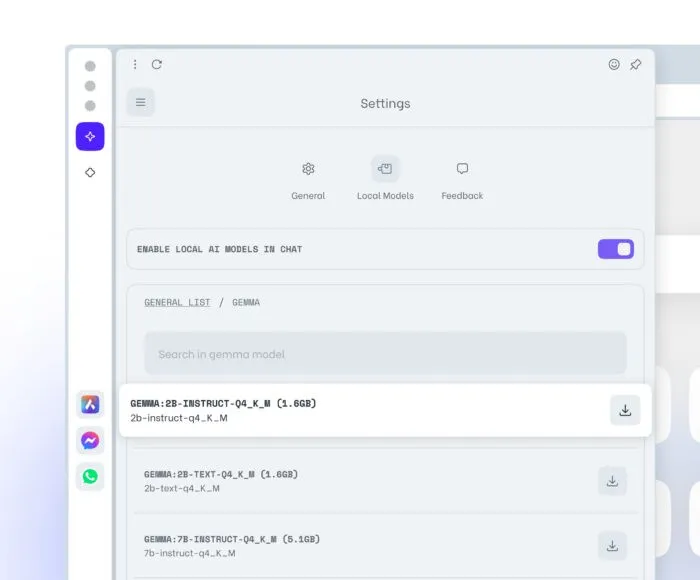

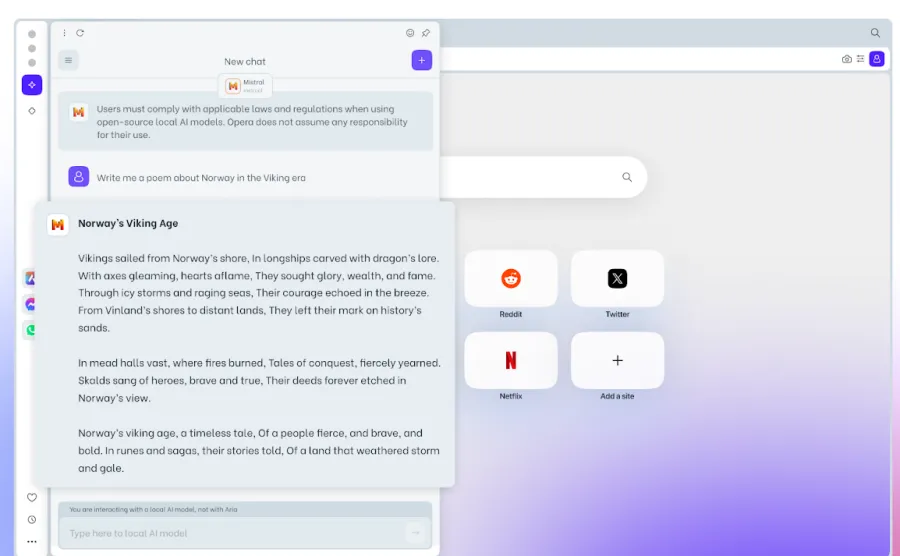

Opera One 개발자 사용자는 최신 브라우저 버전으로 업데이트한 다음, 테스트할 모델을 선택하고, 새 기능을 활성화하고 , 로컬 LLM을 컴퓨터에 다운로드하여 시작할 수 있습니다. 일반적인 LLM에는 2~10GB의 저장 공간이 필요합니다. 다운로드한 후에는 Aria 대신 로컬 LLM으로 전환하여 사용할 수 있습니다.

로컬 LLM은 데이터가 컴퓨터 외부로 유출되지 않기 때문에 더 나은 개인 정보 보호 및 보안, 오프라인 사용 및 전체적으로 향상된 브라우저 경험과 같은 여러 가지 이점을 제공합니다. 로컬 LLM의 한 가지 단점은 처리가 컴퓨터의 하드웨어 기능에 전적으로 의존하기 때문에 서버 기반 LLM에 비해 출력 제공 속도가 느릴 수 있다는 것입니다. 따라서 대부분의 최신 시스템에서는 제대로 작동하더라도 오래된 장치에서는 리소스 부족을 느낄 수 있습니다.

그럼에도 불구하고, 로컬 AI 모델을 브라우저 자체에 통합하는 것은 Opera에게 있어서 큰 진전이며, 우리는 이것이 다른 주요 브라우저들 사이에서 추세가 되는 것을 아직 볼 수 없을 것입니다.

답글 남기기