Microsoft의 Phi-3 AI 모델은 모든 Intel CPU 및 GPU 라인업에서 작동합니다.

우리 모두는 LLM을 빠르고 원활하게 실행하고 싶지만 강력한 구성을 감당할 수는 없습니다. 이것이 바로 Microsoft가 실제로는 아주 작은 컴퓨터에서 로컬로 작동할 수 있는 SLM(작은 언어 모델)인 Phi-3을 만든 이유입니다.

이제 인텔은 전체 CPU 및 GPU 라인업에서 Microsoft의 최신 Phi-3 AI 모델에 대한 전폭적인 지원을 발표 하여 게임을 강화했습니다 . 이러한 움직임은 단순히 시대에 발맞추기 위한 것이 아닙니다. 특히 강력하지 않은 장치의 개인화 및 효율성과 관련하여 AI 컴퓨팅에서 가능한 것의 경계를 넓히는 것입니다.

Intel과 Microsoft는 모든 사람에게 강력한 AI 처리 기능을 제공합니다.

그렇다면 Microsoft Phi-3의 가장 큰 장점은 무엇일까요? 글쎄요, AI의 접근성과 효율성을 높이는 것이 중요합니다. Phi-3 모델은 처리 능력이 제한된 장치에서 원활하게 실행되도록 설계되어 개발자와 사용자 모두에게 획기적인 변화를 가져왔습니다. 스마트폰이나 소형 가정용 기기에 고급 AI의 힘이 있다고 상상해보세요. 그것이 바로 우리가 보고 있는 미래입니다.

Intel은 이미 이러한 모델과 원활하게 작동하도록 하드웨어를 최적화했습니다. Gaudi AI 가속기부터 Xeon 및 Core Ultra CPU, 그리고 Arc GPU까지 Intel이 모두 참여합니다. 이는 더 나은 성능, 더 효율적인 AI 처리, 그리고 궁극적으로 사용자를 위한 더 풍부하고 개인화된 경험을 의미합니다.

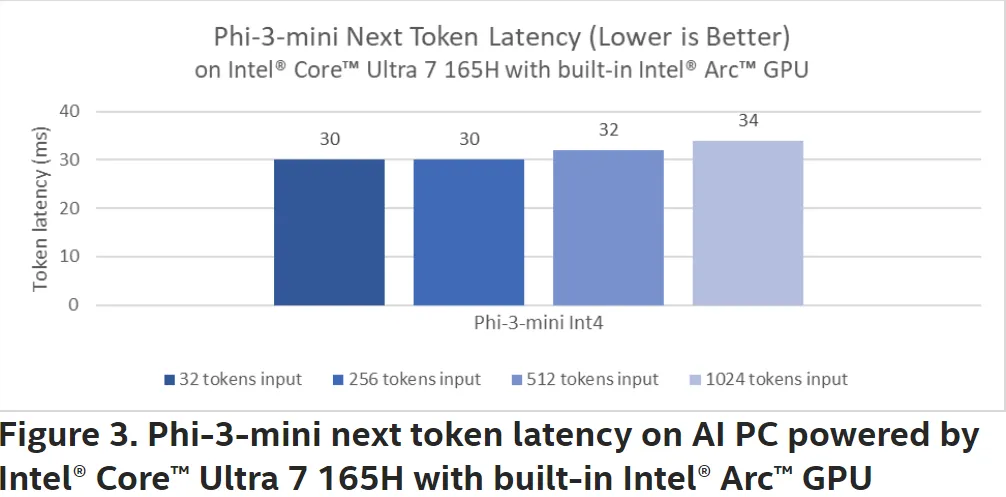

Intel에 따르면 6세대 Xeon CPU는 이전 모델에 비해 Phi-3 모델에서 두 배의 성능을 보여줍니다. 그리고 엣지 AI 프로세스와 관련하여 Core Ultra CPU 플랫폼은 개인화 및 응답성 측면에서 상당한 발전을 이루고 있습니다. 벤치 마크는 에 있으며 결과는 인상적입니다. 특히 Arc A770 GPU와 쌍을 이루는 Intel의 Core Ultra 7 165H에서 테스트된 Phi-3 미니 모델의 경우 더욱 그렇습니다.

더 스마트한 홈 기기부터 더 직관적인 개인 기기에 이르기까지 가능성은 무궁무진하며, 모두 이전보다 더 접근하기 쉽고 효율적인 AI를 기반으로 합니다.

AI는 곧 우리 주변의 모든 지능형 장치에 융합될 것입니다. 나는 인터넷 어디에서나 찾을 수 있는 종말 시나리오에 들어가고 싶지 않지만 이 모든 것이 약간 걱정스럽다는 데 동의해야 합니다.

인텔의 새로운 개발에 대해 어떻게 생각하시나요? 아래 댓글에 여러분의 의견을 자유롭게 표현해 주세요.

답글 남기기