Android에서 로컬로 LLM을 실행하는 방법

알아야 할 사항

- Android 기기에 MLC Chat과 같은 앱을 설치하여 로컬에서 LLM을 실험하고 채팅하세요.

- 사용 가능한 모델 중 하나를 다운로드하고 ‘채팅’ 아이콘을 탭하여 선택한 LLM과 채팅을 시작하세요.

- MLC Chat 앱을 사용하면 Gemma 2b, RedPajama, Llama3, Phi-2, Mistral 및 Llama2를 다운로드할 수 있습니다.

PC에서 로컬로 실행할 수 있는 다양한 LLM이 있습니다. 하지만 스마트폰의 경우 옵션이 약간 제한됩니다. 소규모 언어 모델을 실행하거나 LLM을 처리하기에 충분한 처리 능력을 갖춘 프리미엄 장치가 있어야 합니다. 어느 쪽이든 로컬 및 오프라인으로 언어 모델과 채팅하는 것이 가능합니다.

Android에서 로컬로 LLM을 실행하는 방법

대규모 언어 모델은 크기가 크며 상당한 계산 능력이 필요합니다. 그러나 Android 기기에 SLM(소규모 언어 모델)과 LLM을 실행할 수 있는 충분한 리소스가 있더라도 사용자 친화적인 인터페이스로 이를 실험할 수 있는 앱이 여전히 필요합니다.

MLC Chat과 같은 앱이 유용한 곳입니다. MLC Chat 앱을 사용하여 Android에서 로컬로 LLM을 실행하려면 아래 단계를 따르세요.

1단계: MLC 채팅 앱 설치

- MLC 채팅 앱 | 다운로드 링크

- 먼저, 위의 링크를 클릭하여 MLC Chat 앱용 APK를 다운로드하세요. 메시지가 표시되면 무시하고 다운로드를 탭합니다 .

- MLCChat 앱을 설치하세요 . 완료되면 엽니 다 .

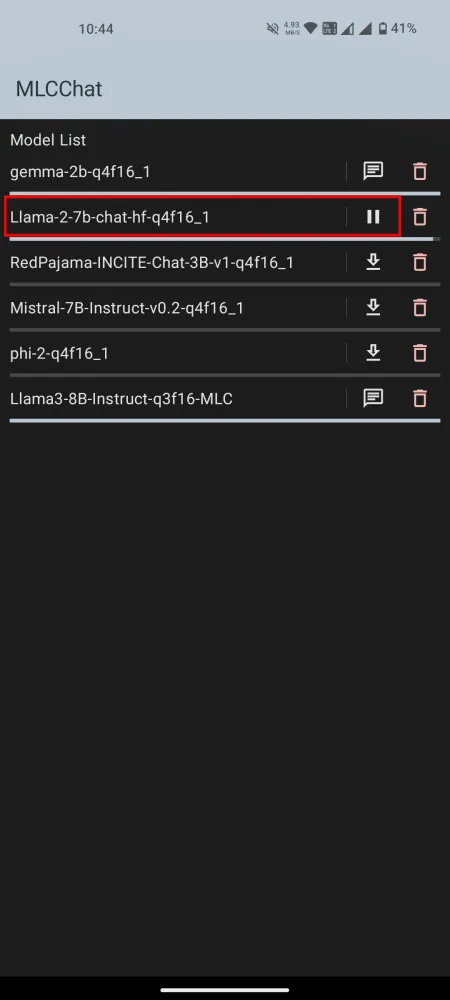

2단계: LLM 다운로드

MLCChat 앱에는 다운로드할 수 있는 사용 가능한 모델 목록이 있습니다. 원하는 모델 옆에 있는 다운로드 링크를 탭하고 다운로드될 때까지 기다립니다.

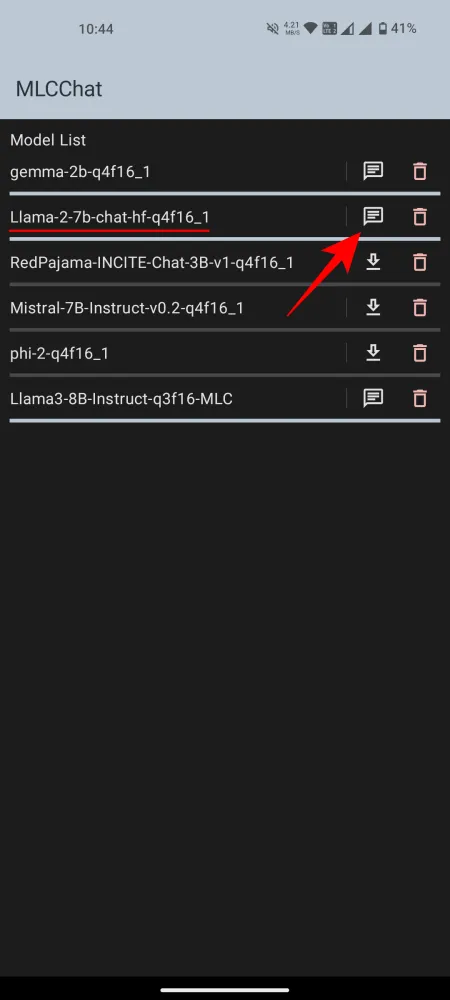

3단계: 설치된 LLM 실행

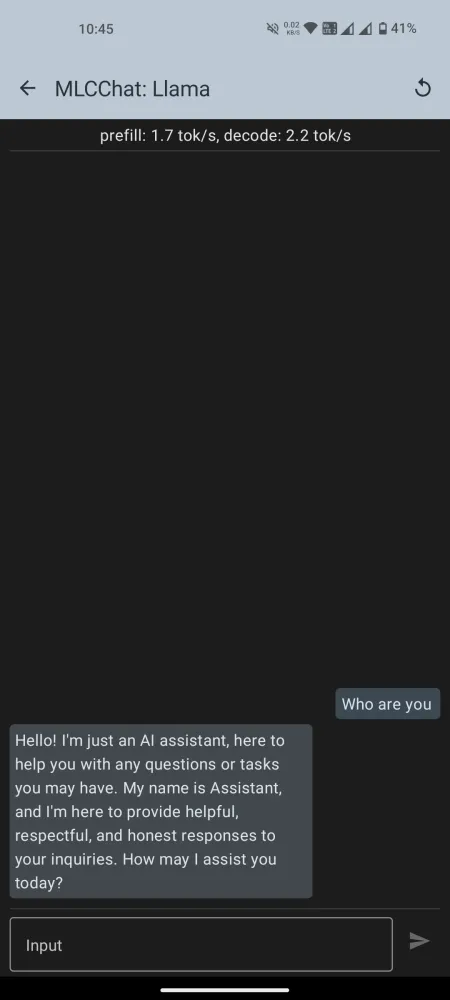

다운로드가 완료되면 옆에 있는 채팅 아이콘을 탭하여 채팅을 시작하세요. 모델이 초기화될 때까지 기다립니다. 준비가 되면 AI와 채팅을 시작하세요.

MLCChat 앱의 사용 가능한 모델 목록에는 Llama3와 같이 많은 처리 능력이 필요한 일부 모델이 있다는 점에 유의하세요. 그러나 언제든지 모델을 설치하고 모델이 충분히 원활하게 실행되는지 테스트할 수 있습니다. 그렇지 않다면 더 작은 언어 모델을 사용해 보세요.

테스트(Nothing Phone 1)에서 Gemma-2b는 로드에 실패했고 Llama3는 시스템 UI를 종료했습니다. 잘 작동한 것은 Llama-2와 Phi-2였습니다. LLM과 다른 소규모 언어 모델의 주요 차이점은 학습되는 정보(매개변수)의 폭입니다. 따라서 귀하의 필요와 Android 장치의 기능에 따라 모델을 선택하십시오.

Android 기기에 로컬로 LLM을 설치하고 실행할 수 있었기를 바랍니다. 다음 시간까지!

답글 남기기