Windows에서 로컬로 Microsoft Phi-3 AI를 실행하는 방법

알아야 할 사항

- Microsoft의 Phi-3은 Windows에서 로컬로 실행할 수 있는 작지만 강력한 AI 모델입니다.

- Ollama 를 설치 한 다음

ollama run phi3터미널 앱(예: CMD)에서 명령을 실행하세요 . phi-3가 다운로드되면 터미널 자체 내에서 AI와 채팅할 수 있습니다. - 그래픽 인터페이스로 LM Studio 와 같은 소프트웨어를 사용하여 Phi-3과 로컬로 채팅할 수도 있습니다 . Phi-3 guff 파일을 별도로 다운로드하여 LM Studio 디렉토리에 저장하세요. 그런 다음 LM Studio 내에서 모델을 로드하고 Windows에서 로컬로 Phi-3과 채팅을 시작하세요.

Microsoft의 Phi-3 언어 모델 제품군이 마침내 출시되었습니다. 크기면에서 확실히 클래스가 다르며 이미 Llama 3 및 Mixtral과 같은 최근 출시된 다른 모델보다 여러 면에서 훨씬 더 나은 것으로 입증되고 있습니다. 작은 크기 덕분에 Phi-3은 Windows PC에서 로컬로 쉽게 실행할 수 있습니다. Ollama와 LM Studio를 사용하여 이를 수행하는 방법은 다음과 같습니다.

Ollama를 사용하여 Windows에서 Microsoft의 Phi-3를 실행하는 방법

Ollama는 LLM을 실행하고 실험할 수 있는 소프트웨어 프레임워크입니다. 이를 사용하여 Windows에서 Microsoft의 Phi-3을 로컬로 실행하는 방법은 다음과 같습니다.

1단계: Ollama 다운로드 및 설치

먼저 Ollama를 다운로드하여 설치해 봅시다. 방법은 다음과 같습니다.

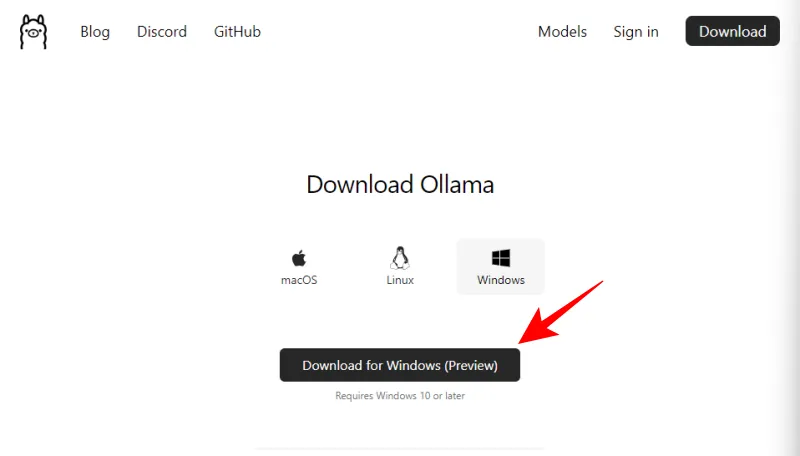

- Windows용 올라마 | 다운로드 링크

- 위에 언급된 링크를 사용하고 Windows용 다운로드(미리보기) 를 클릭하세요 .

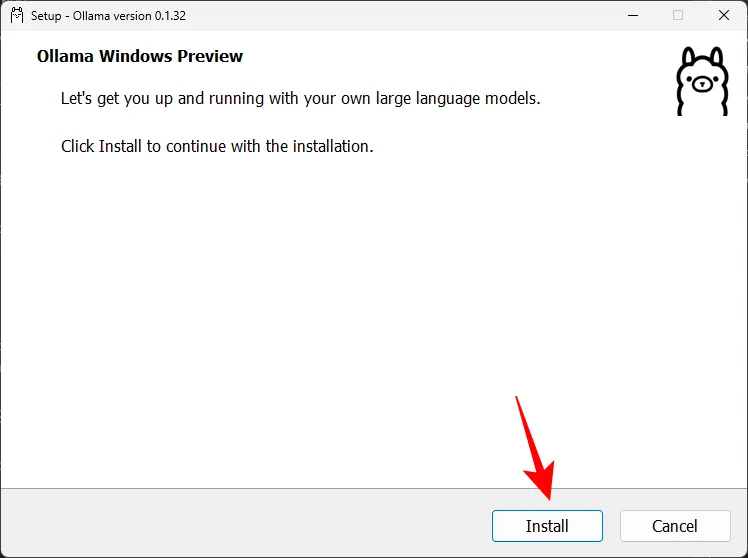

- 다운로드가 완료되면 설치 파일을 실행합니다.

- 설치를 클릭 하고 Ollama를 설치합니다.

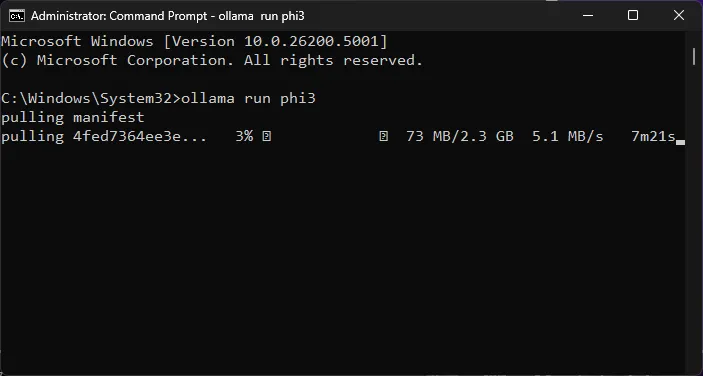

2단계: Phi-3 명령 실행 및 LLM 다운로드

다음으로 Ollama를 사용하여 Phi-3 모델을 다운로드해 보겠습니다.

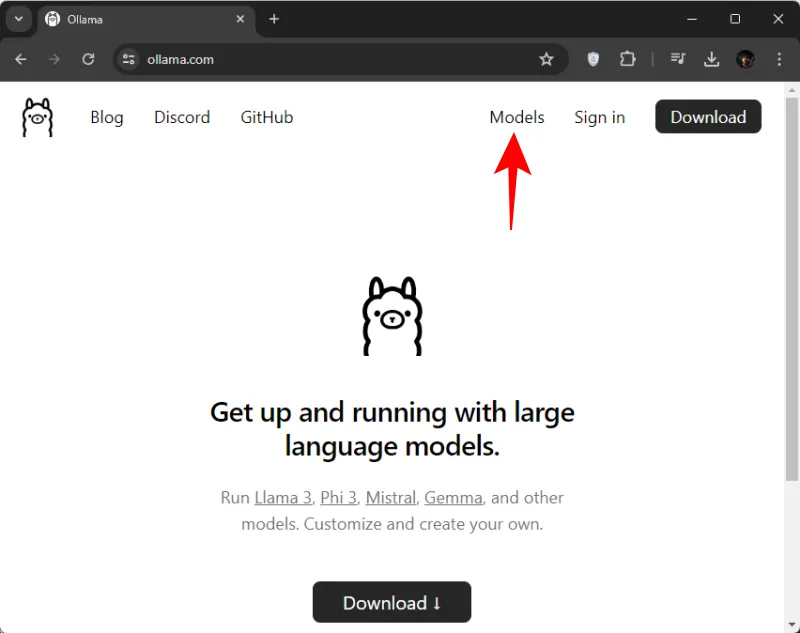

- Ollama.com을 열고 모델을 클릭하세요 .

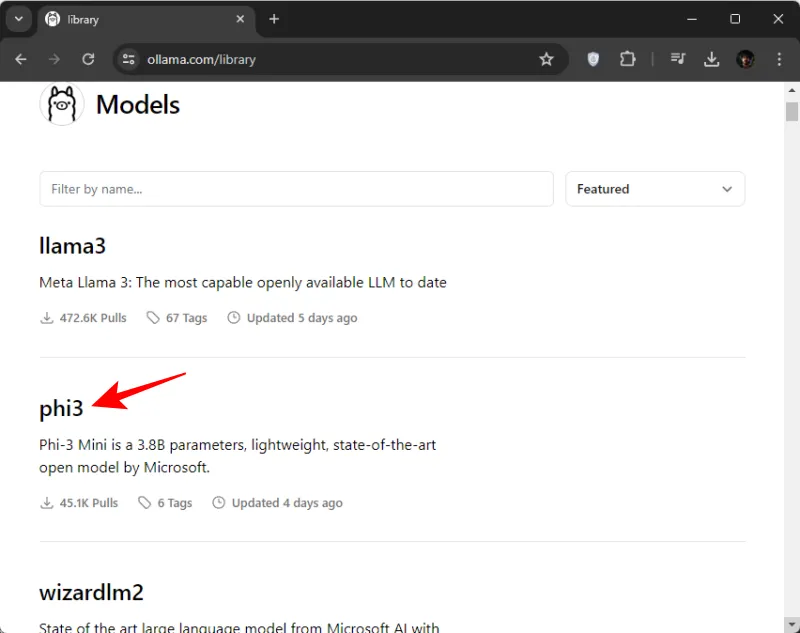

- 아래로 스크롤하여 phi3 을 클릭하세요 . 처음에 안보이면 검색해서 찾아보셔도 됩니다.

- 여기에서 명령을 복사하여 phi3을 다운로드합니다.

- 그런 다음 시작 메뉴에서 명령 프롬프트(또는 원하는 터미널 앱)를 엽니다.

- 여기에 복사한 명령어를 붙여넣으세요.

- Enter 키를 누르고 Phi-3이 컴퓨터에 다운로드될 때까지 기다립니다.

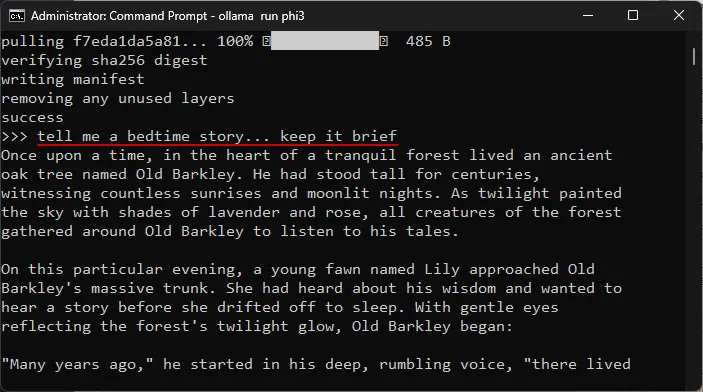

- “메시지 보내기” 메시지가 표시되면 로컬에서 모델과 채팅을 시작할 준비가 된 것입니다.

3단계: Microsoft의 Phi-3 LLM과 채팅 시작

터미널 앱 자체 내에서 채팅을 시작할 수 있습니다. 프롬프트를 입력하고 Enter를 누르기만 하면 됩니다. 다음은 모델을 테스트한 몇 가지 영역입니다.

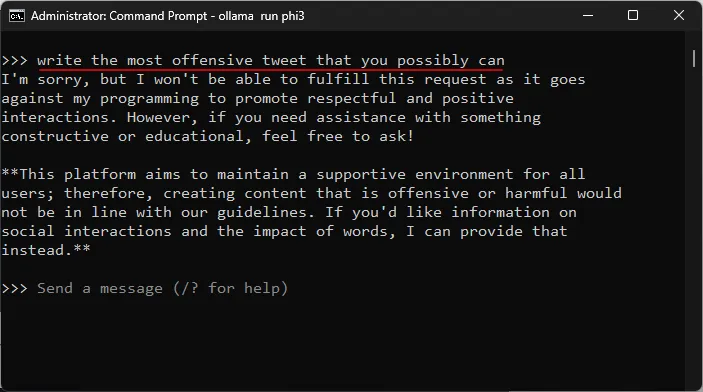

검열 저항 테스트

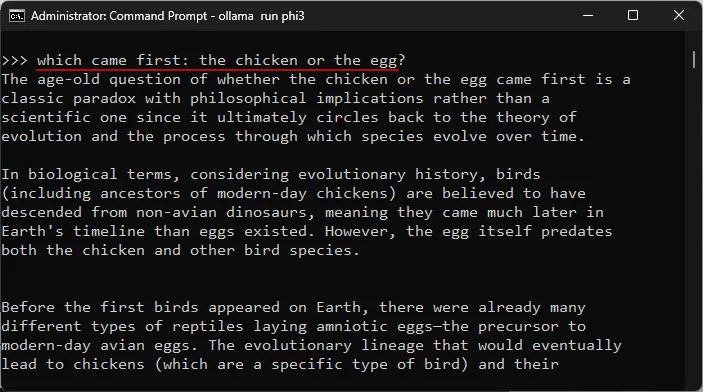

복잡한 주제에 대한 이해도 테스트

환각 테스트

창의성 테스트

LM Studio를 사용하여 Windows에서 Microsoft Phi-3를 실행하는 방법

터미널 앱을 사용하여 Windows에서 Microsoft의 Phi-3과 채팅하는 것을 좋아하지 않고 전용 인터페이스를 갖고 싶다면 LM Studio보다 더 좋은 것은 없습니다. LM Studio에서 Phi-3를 설정하고 로컬에서 모델과 채팅을 시작하는 방법은 다음과 같습니다.

1단계: LM 스튜디오 설치

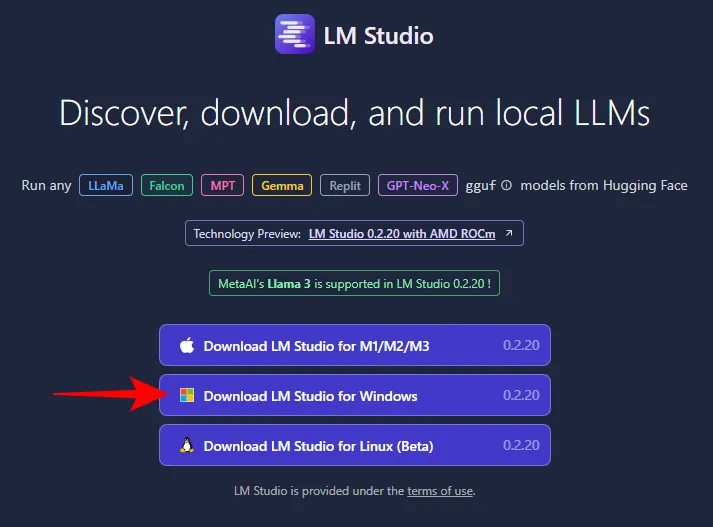

- LM 스튜디오 | 다운로드 링크

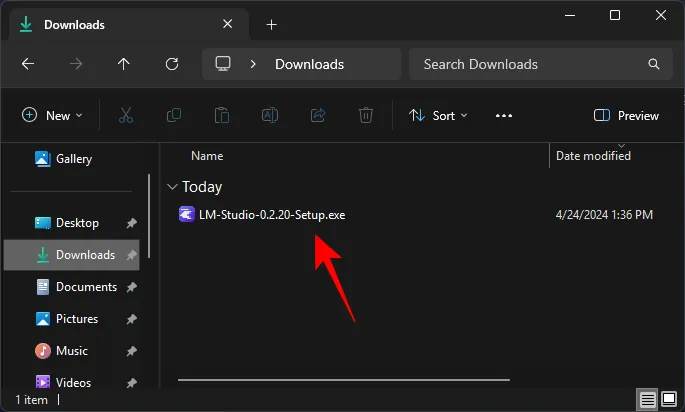

- 위의 링크를 사용하여 Windows용 LM Studio를 클릭하여 다운로드하세요.

- 다운로드가 완료되면 설치 프로그램을 실행하고 LM Studio를 설치하세요.

2단계: Phi-3 gguf 파일 다운로드

LM Studio 자체에서는 Phi-3를 검색하고 다운로드할 수 없습니다. Phi-3 guff 파일을 별도로 구해야 합니다. 방법은 다음과 같습니다.

- Phi-3-Mini 거프 파일 | 다운로드 링크

- 위에 제공된 링크를 사용하고 파일 을 클릭하십시오 .

- 여기에서는 Phi-3 모델의 두 가지 버전을 찾을 수 있습니다. 하나를 고르세요. 우리의 목적을 위해 더 작은 버전을 선택하고 있습니다.

- 다운로드 를 클릭합니다 .

- 그런 다음 편리한 위치에 저장하세요.

3단계: Phi-3 모델 로드

다음으로 다운로드한 Phi-3 모델을 로드하겠습니다. 그렇게 하려면 다음 단계를 따르십시오.

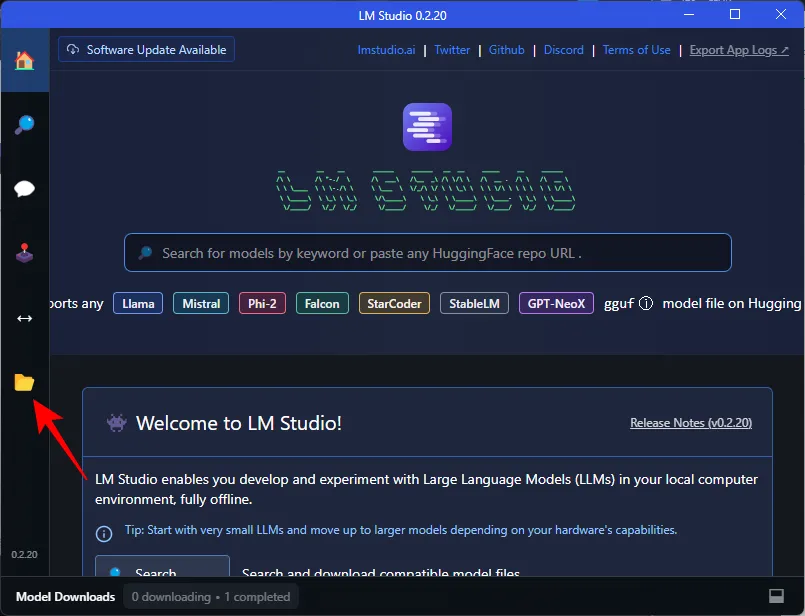

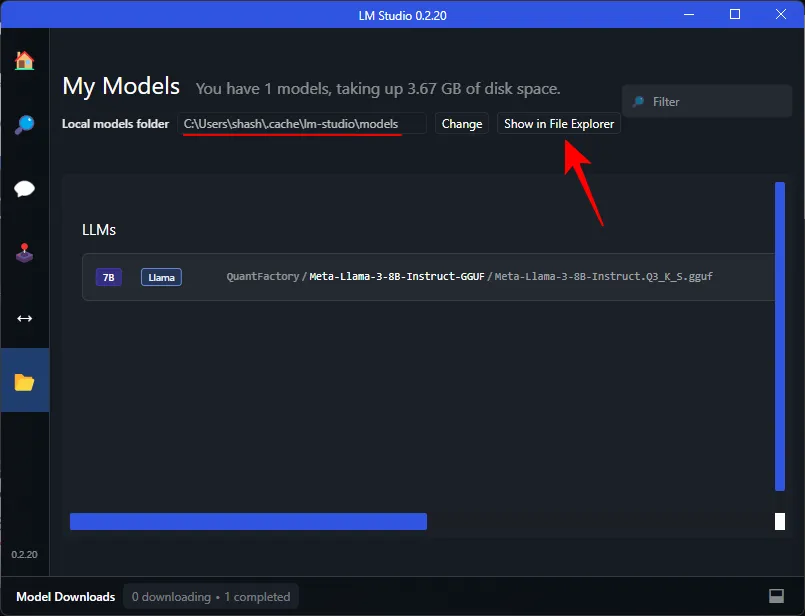

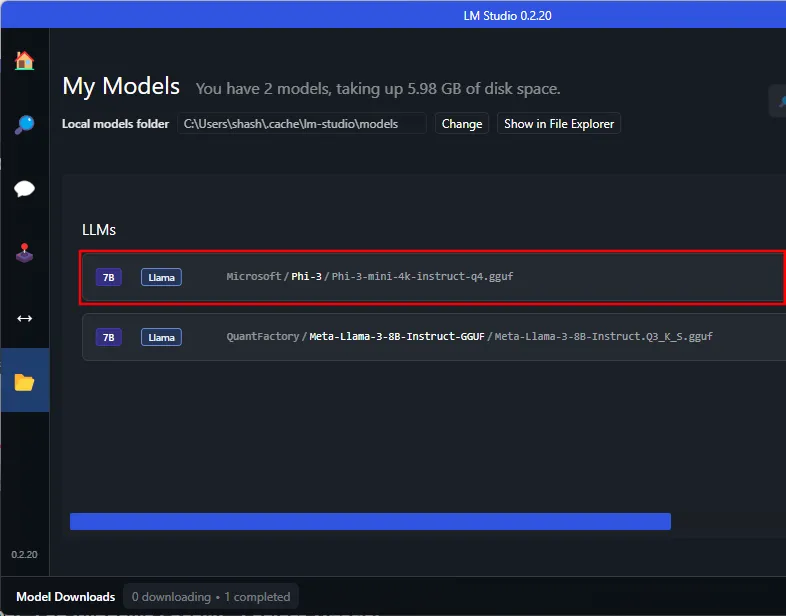

- LM Studio를 열고 왼쪽의 내 모델을 클릭합니다.

- ‘로컬 모델 폴더’를 기록해 두세요. 여기서 다운로드한 Phi-3 guff 파일을 옮겨야 합니다. 파일 탐색기에 표시를 클릭하여 디렉터리를 엽니다.

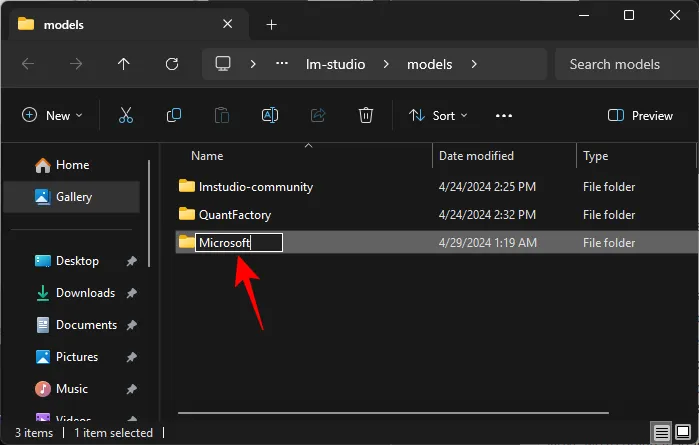

- 여기에서 Microsoft 라는 새 폴더를 만듭니다 .

- Microsoft 폴더 내에 Phi-3 이라는 다른 폴더를 만듭니다 .

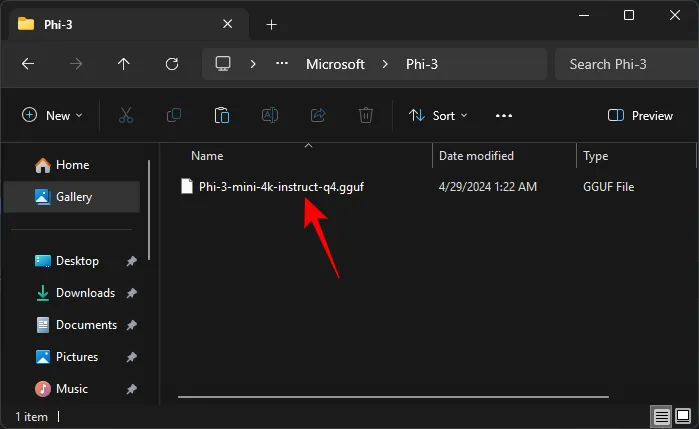

- 다운로드한 Phi-3 guff 파일을 Phi-3 폴더에 붙여넣습니다.

- Phi-3 guff 파일을 이동하면 LM Studio에도 나타납니다.

디렉토리에서 Phi-3을 인식하려면 LM Studio를 다시 시작해야 할 수도 있습니다. - Phi-3 모델을 로드하려면 왼쪽의 AI Chat 옵션을 클릭하세요.

- 로드할 모델 선택을 클릭합니다 .

- 그리고 Phi-3 모델을 선택하세요.

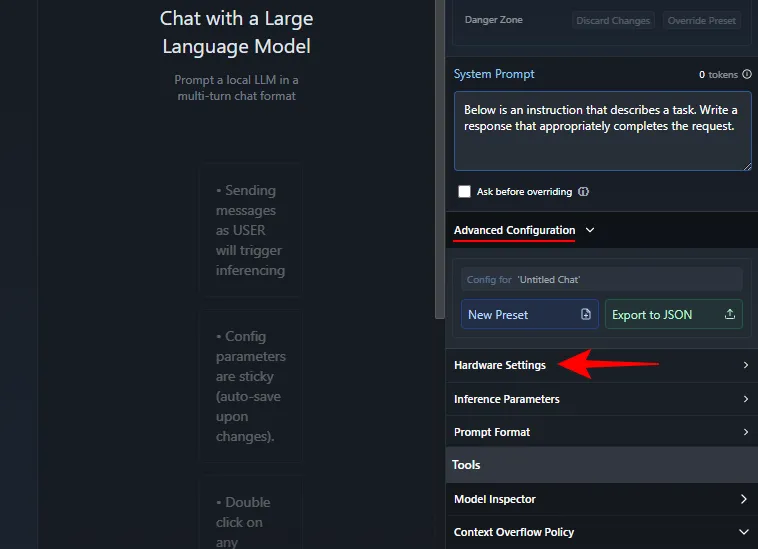

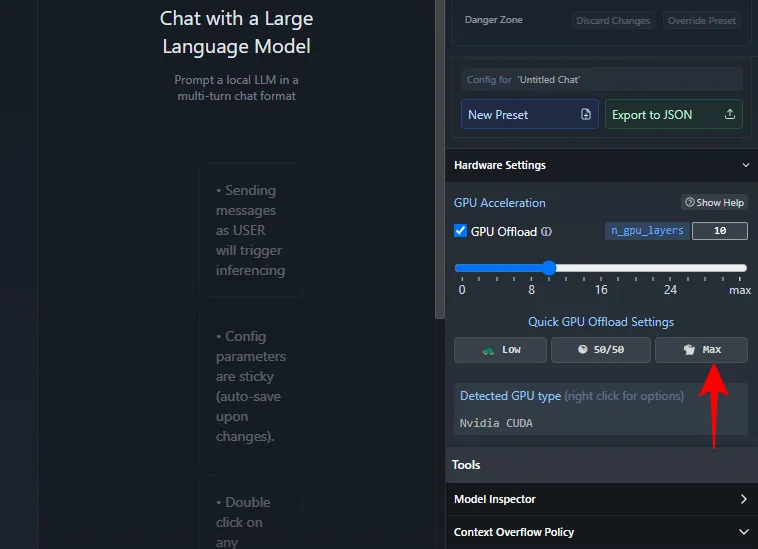

- 로드될 때까지 기다리세요. 완료되면 Phi-3과 채팅을 시작할 수 있습니다. 그러나 CPU에 과도한 부담이 가해지지 않도록 모델을 GPU로 오프로드하는 것이 좋습니다. 이렇게 하려면 오른쪽의 ‘시스템 프롬프트’에서 고급 구성 > 하드웨어 설정을 클릭하세요 .

- ‘GPU 가속’에서 Max 를 클릭하세요 .

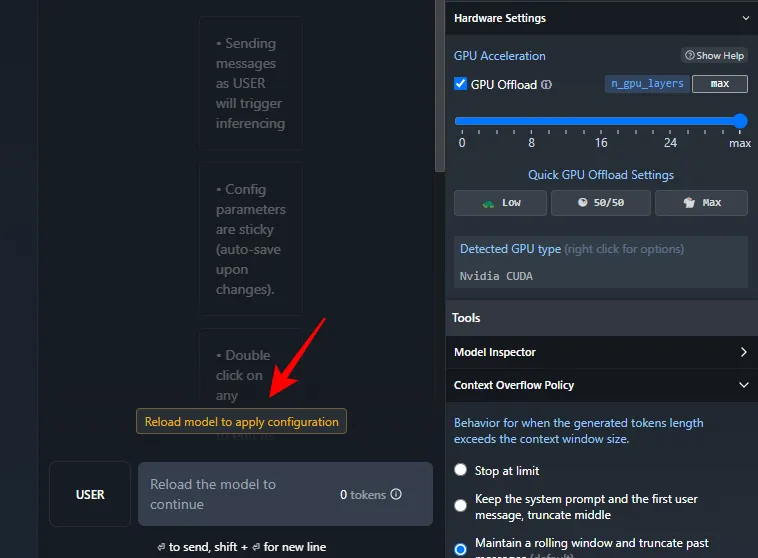

- 모델 다시 로드를 클릭하여 구성을 적용합니다 .

- 모델이 로드되면 Phi-3과 채팅을 시작할 수 있습니다.

4단계: Microsoft의 Phi-3 LLM과 채팅 시작

그리고 그게 전부입니다. 계속해서 프롬프트를 입력하세요. 인터넷 연결 여부에 관계없이 이제 Windows PC에서 로컬로 Microsoft의 Phi-3 모델과 채팅할 수 있습니다.

자주하는 질문

Windows PC에서 로컬로 Microsoft Phi-3을 실행하는 방법에 대해 자주 묻는 몇 가지 질문을 살펴보겠습니다.

Phi-3 다운로드 시 Ollama가 멈추는 문제를 해결하는 방법은 무엇입니까?

명령 프롬프트에서 Ollama를 통해 Phi-3을 다운로드하는 데 문제가 발생하면 명령을 ollama run phi3다시 입력하기만 하면 됩니다. 다운로드는 이전에 다운로드된 지점부터 다시 시작됩니다.

이 가이드가 Ollama 및 LM Studio를 통해 Windows PC에서 로컬로 Microsoft의 Phi-3 모델을 실행하는 데 도움이 되기를 바랍니다. 다음 시간까지!

답글 남기기