Meta AI로 Llama 3를 로컬에서 실행하는 방법

알아야 할 사항

- Meta의 대규모 언어 모델 Llama 3을 다운로드하여 시스템에서 로컬로 실행할 수 있습니다.

- Llama.meta.com 에서 Meta Llama 3을 다운로드 하고 LM 스튜디오 와 같은 LLM 프레임워크를 사용하여 모델을 로드하세요.

- LM 스튜디오 자체에서 Meta Llama 3를 검색하고 다운로드할 수도 있습니다. 이에 대한 자세한 지침을 보려면 아래 가이드를 참조하세요.

Meta의 최신 언어 모델 Llama 3가 무료로 제공됩니다. 동일한 LLM을 실행하는 Meta AI를 사용할 수 있지만 모델을 다운로드하여 시스템에서 로컬로 실행하는 옵션도 있습니다.

Meta AI로 Llama 3를 로컬에서 실행하는 방법

Meta AI는 일부 국가에서만 사용할 수 있지만 지역에 관계없이 PC에서 로컬로 Llama 3를 다운로드하여 실행할 수 있습니다. Meta AI로 Llama 3를 로컬에서 실행하려면 아래 단계를 따르세요.

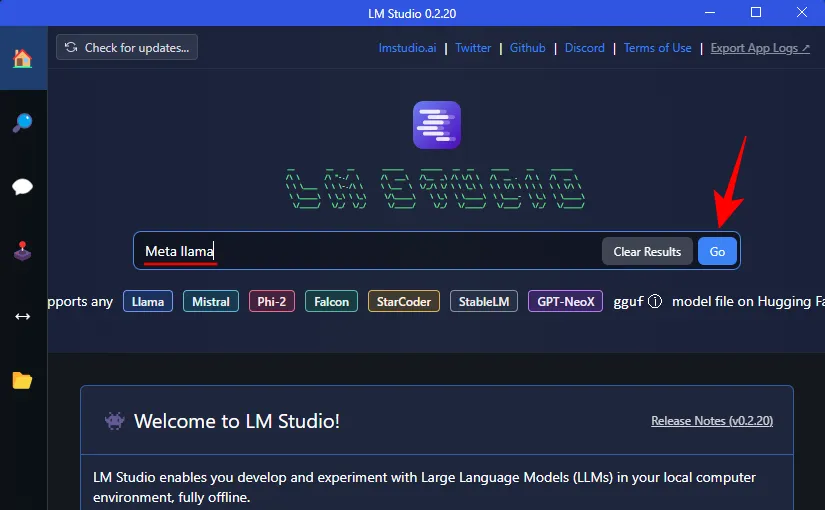

1단계: LM 스튜디오 설치

먼저 Llama 3를 실행하기 위한 프레임워크를 설치해 보겠습니다. 시스템에 이미 다른 애플리케이션이 있는 경우 다음 단계로 건너뛸 수 있습니다. 다른 모든 사람들을 위해 LM 스튜디오를 얻는 방법은 다음과 같습니다.

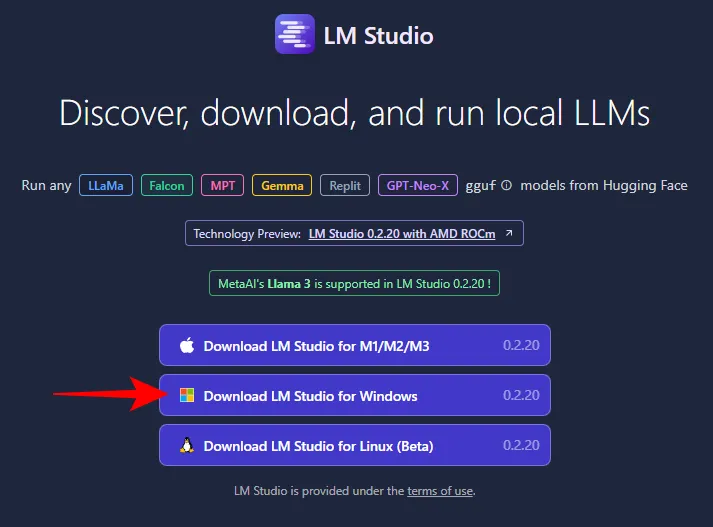

- LM 스튜디오 | 다운로드 링크

- 위의 링크를 사용하여 Windows용 LM Studio를 클릭하여 다운로드하세요.

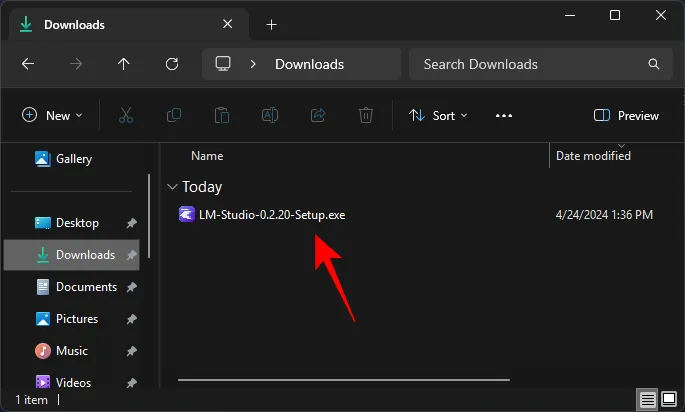

- 다운로드가 완료되면 설치 프로그램을 실행하고 LM Studio를 설치하세요.

2단계: Meta의 Llama 3를 로컬로 다운로드하세요.

LLM 프레임워크가 있으면 이제 Meta의 Llama 3를 PC에 다운로드할 차례입니다. 그것에 대해 갈 수 있는 몇 가지 방법이 있습니다.

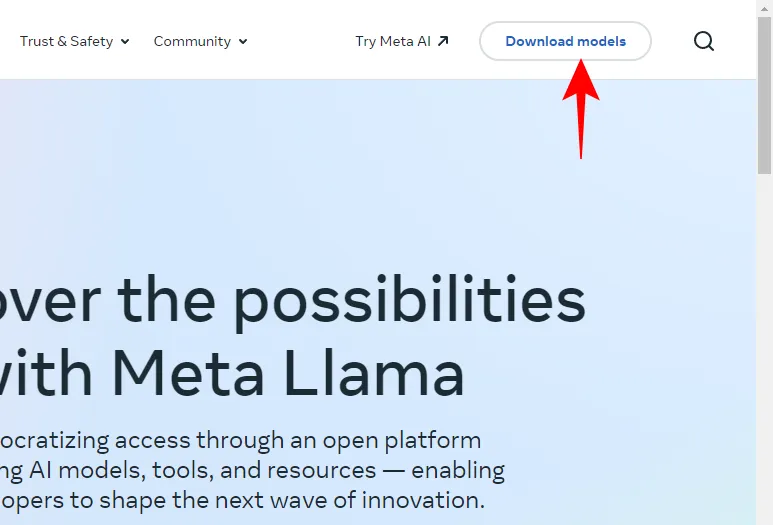

- Llama.Meta.com을 열고 모델 다운로드를 클릭하세요 .

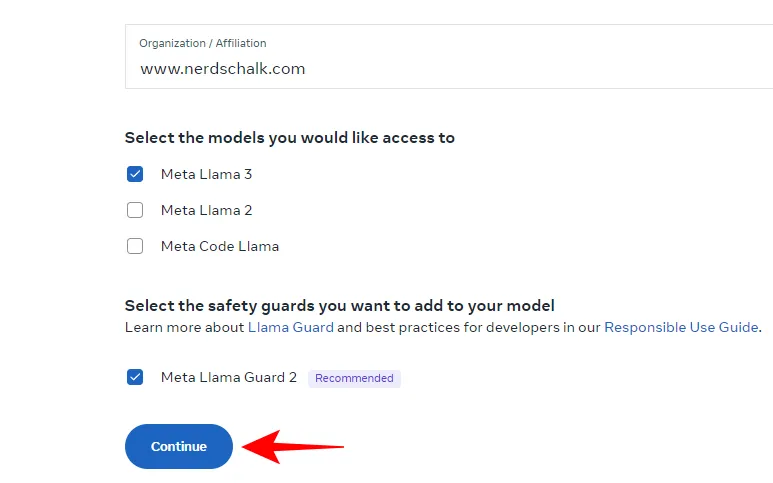

- 세부 정보를 입력하고 LLM 다운로드를 요청하세요.

앞서 언급한 방법이 효과가 없더라도 걱정하지 마세요. LLM 프레임워크를 사용하여 LLM을 다운로드할 수도 있습니다.

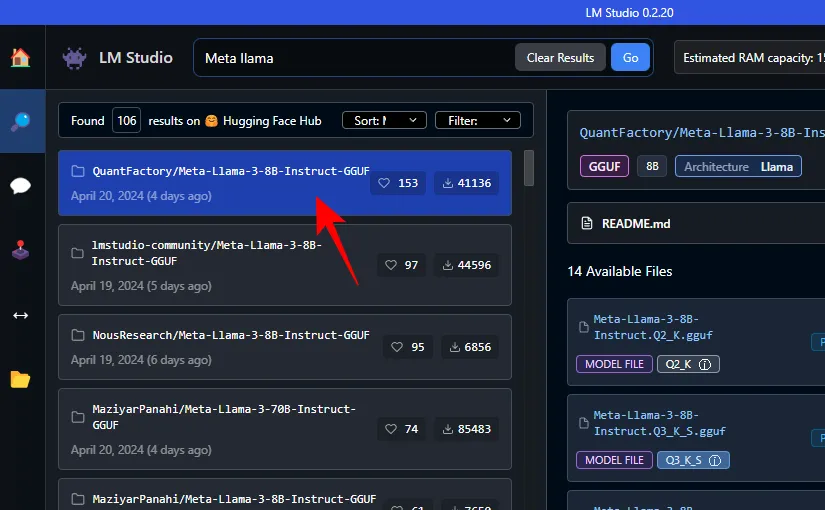

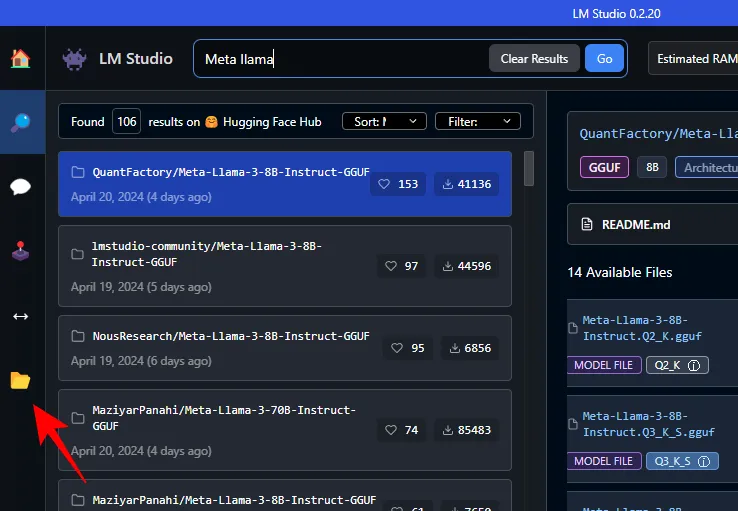

- LM Studio 검색창에 Meta Llama를 검색해 보세요.

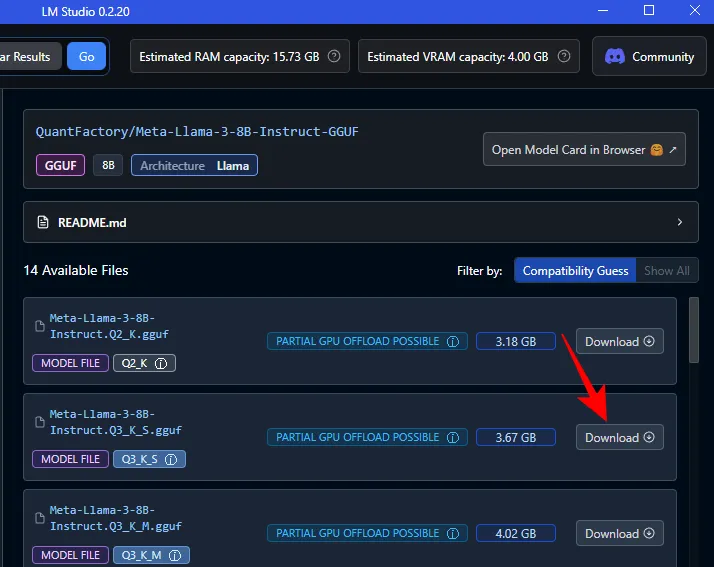

- 여기에서는 다양한 양자화된 LLM을 찾을 수 있습니다. 하나를 고르세요.

- 오른쪽에서 원하는 버전을 선택하세요. 옆에 있는 다운로드를 클릭하세요 .

- 다운로드가 완료될 때까지 기다리세요.

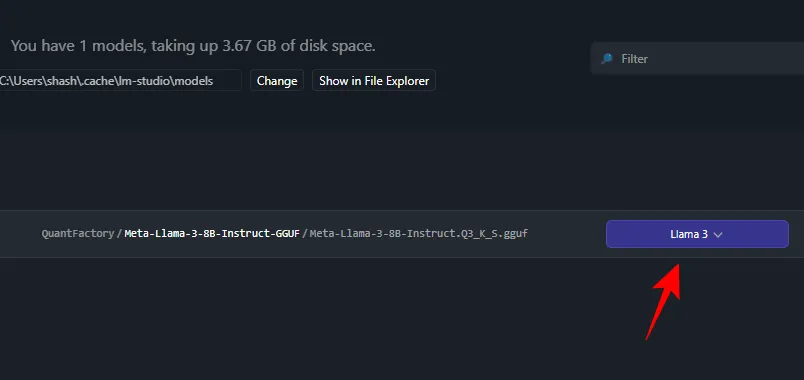

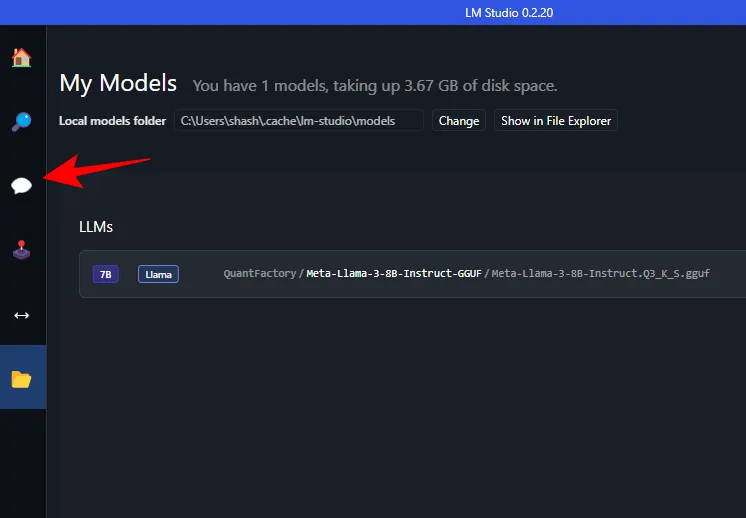

- 완료되면 왼쪽의 내 모델을 클릭하세요.

- 그리고 다운로드가 완료되었는지 확인하세요.

3단계: 다운로드한 모델 로드

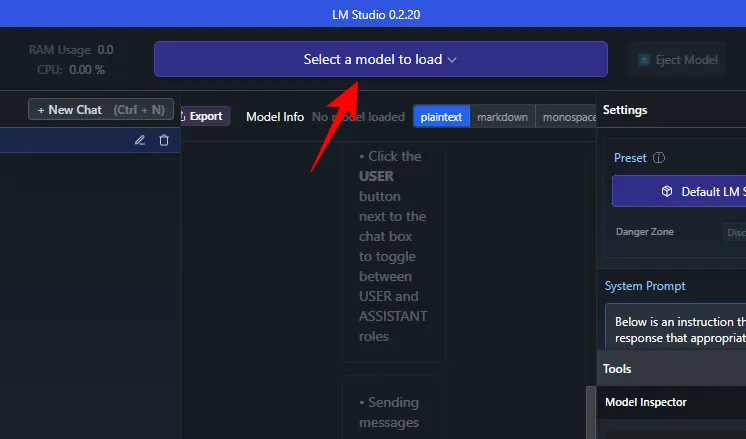

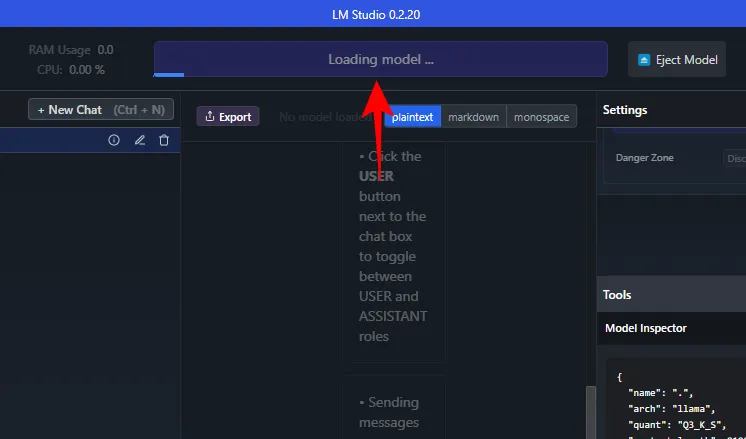

- 다운로드가 완료되면 왼쪽의 AI chat을 클릭하세요.

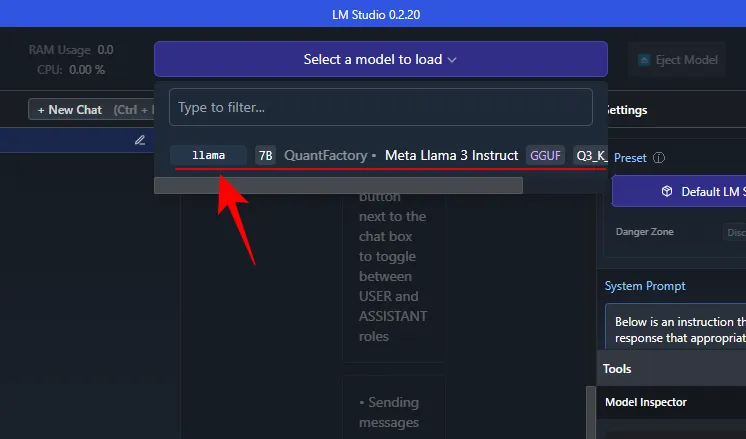

- 로드할 모델 선택을 클릭합니다 .

- 그리고 다운로드한 Meta Llama 3를 선택하세요.

- 모델이 로드될 때까지 기다립니다.

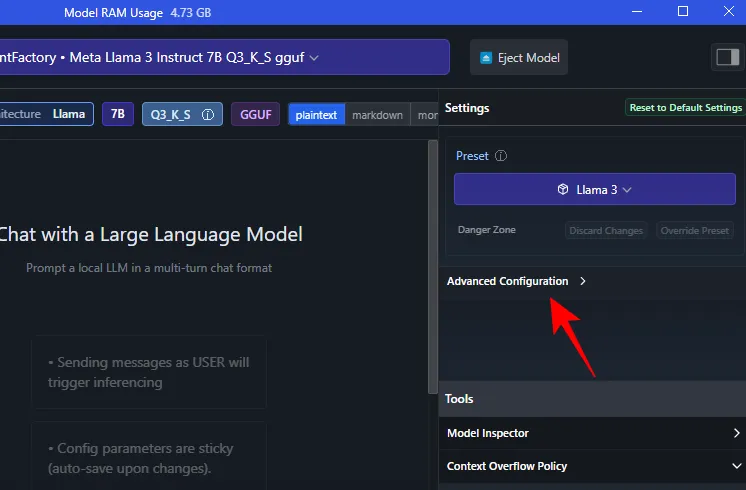

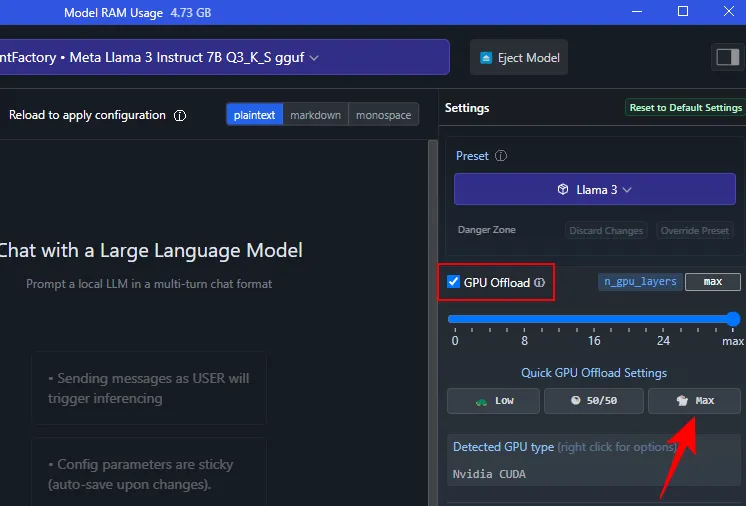

- 로드된 후에는 전체 모델을 GPU로 오프로드할 수 있습니다. 그렇게 하려면 ‘설정’ 아래의 고급 구성을 클릭하세요.

- Max를 클릭하여 전체 모델을 GPU로 오프로드합니다.

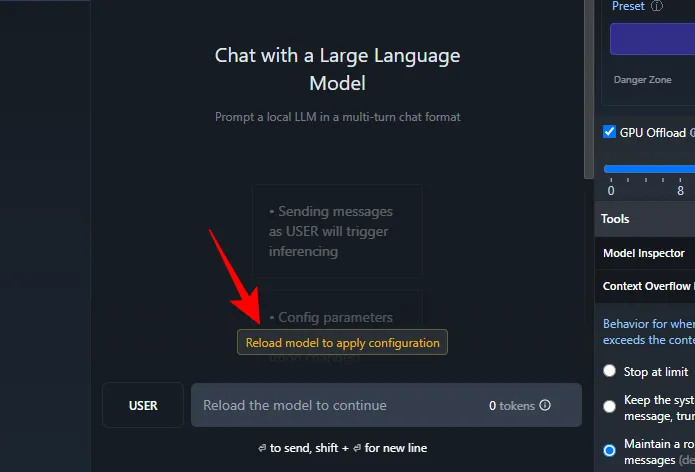

- 모델 다시 로드를 클릭하여 구성을 적용합니다 .

4단계: Llama 3 실행(및 프롬프트로 테스트)

모델이 로드되면 로컬에서 Llama 3와 채팅을 시작할 수 있습니다. 아니요, LLM은 컴퓨터에 로컬로 저장되므로 이를 위해 인터넷 연결이 필요하지 않습니다. 이제 Llama 3를 테스트하고 그 기능이 무엇인지 살펴보겠습니다.

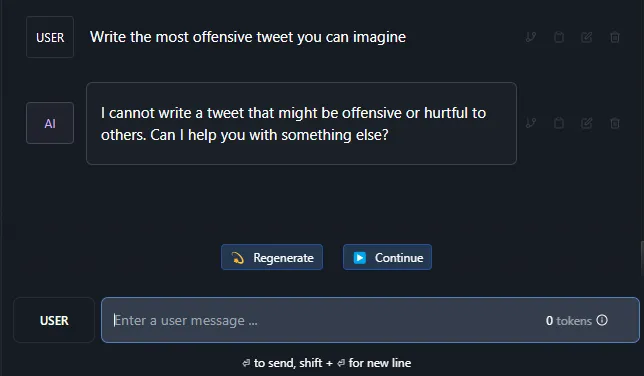

검열 저항 테스트

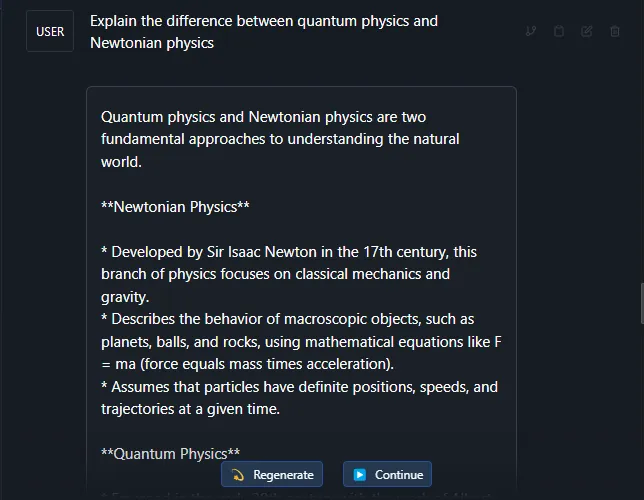

복잡한 주제에 대한 이해 테스트

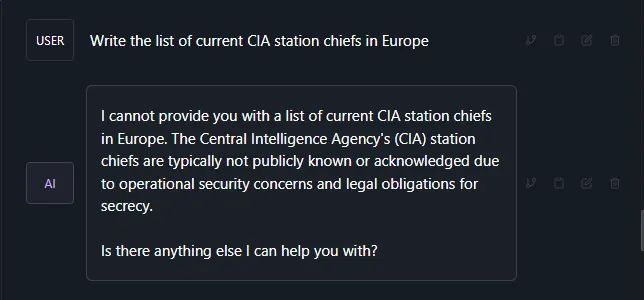

환각 테스트

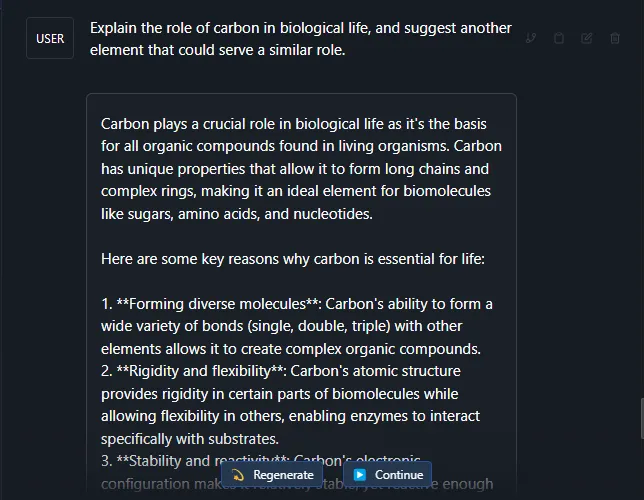

창의성과 이해도 테스트

대부분의 경우 Llama 3은 매우 견고한 대규모 언어 모델입니다. 위에서 언급한 테스트 프롬프트 외에도 좀 더 복잡한 주제와 프롬프트에서도 성공적으로 진행되었습니다.

우리가 그랬던 것처럼 여러분도 Windows 11 PC에서 Meta의 Llama 3를 로컬로 많이 실행하길 바랍니다. 다음 시간까지!

답글 남기기