Panoramica della modalità vocale avanzata di ChatGPT: aspettative vs. realtà

Punti chiave

- La modalità vocale avanzata di ChatGPT non dispone di numerose funzionalità essenziali, tra cui la funzionalità multimodale e la funzione hold-to-speak, che a volte possono renderla inutilizzabile a causa dell’eccessiva censura.

- Tuttavia, vanta un’espressività impressionante, essendo in grado di parlare più lingue, accenti e dialetti regionali, sebbene non sia in grado di cantare, canticchiare o flirtare (come imposto da OpenAI).

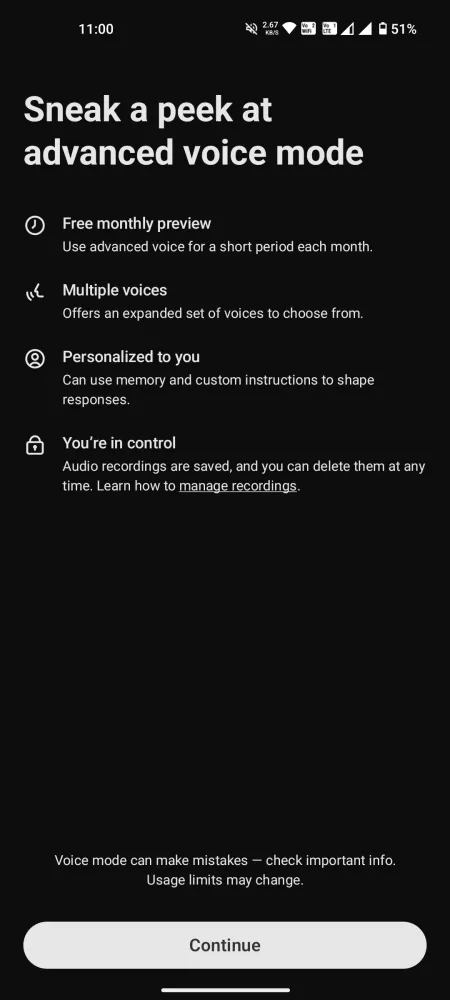

- La funzione chat è accessibile agli utenti gratuiti per soli 15 minuti al mese, mentre gli utenti Plus sono soggetti a un rigido limite giornaliero di 1 ora.

Dopo aver assistito alla dimostrazione iniziale, l’entusiasmo attorno all’Advanced Voice Mode di ChatGPT è stato palpabile. Tuttavia, a seguito di varie sfide legali e successivi ritardi, la funzionalità rimane notevolmente limitata, priva di funzionalità essenziali e contenente alcuni malintesi che distolgono dall’esperienza prevista.

Nonostante il tempo limitato offerto da OpenAI per le interazioni quotidiane, gli utenti possono farsi una discreta idea dei suoi punti di forza, debolezze e possibilità. Ecco le mie impressioni sincere sulla modalità vocale avanzata di ChatGPT, evidenziandone i meriti, gli svantaggi e il motivo per cui la visione di avere un assistente vocale carismatico potrebbe essere ancora una realtà lontana.

Accesso universale alla modalità vocale avanzata, ma mancano le funzionalità chiave

Il lancio di Advanced Voice Mode sull’applicazione mobile ChatGPT consente ora a tutti gli utenti di interagire con questo innovativo modello voice-to-voice. Gli account gratuiti sono limitati a 15 minuti di utilizzo al mese , mentre gli utenti Plus possono usufruire di circa un’ora al giorno , soggetti a limiti giornalieri variabili in base alla disponibilità del server. Una volta raggiunto questo limite, è necessario passare alla modalità vocale Standard, meno entusiasmante.

Prima di immergerti in una conversazione, è fondamentale gestire le tue aspettative. Molte funzionalità pubblicizzate durante l’anteprima non sono attualmente disponibili per gli account gratuiti e Plus. Al momento, la modalità vocale avanzata non è multimodale , non è in grado di interpretare i suoni o analizzare immagini e video. Non può leggere da libri fisici o riconoscere gesti come se stai alzando un dito, né può cantare o identificare strumenti musicali come una chitarra. Numerose funzionalità promesse mancano ancora.

Pro della modalità vocale avanzata

Anche se potrebbe non soddisfare tutte le aspettative stabilite, la modalità vocale avanzata di ChatGPT riesce in alcune aree. Ecco alcuni aspetti positivi degni di nota:

Varie opzioni vocali, ma niente Sky

Gli utenti hanno accesso a una selezione di nove voci distinte:

- Sol (F) – Rilassato e esperto

- Ember (M) – Ottimista e fiducioso

- Arbor (M) – Versatile e easygoing

- Vale (F) – Curioso e brillante

- Acero (F) – Sincero e allegro

- Ginepro (F) – Ottimista e aperto

- Cove (M) – Diretto e composto

- Abete (M) – Affermativo e calmo

- Breeze (M/F) – Serio e animato

In questo mix manca Sky, ma le altre voci si dimostrano ricche e coinvolgenti. Sembra che Sky non sia più un’opzione, quindi procediamo.

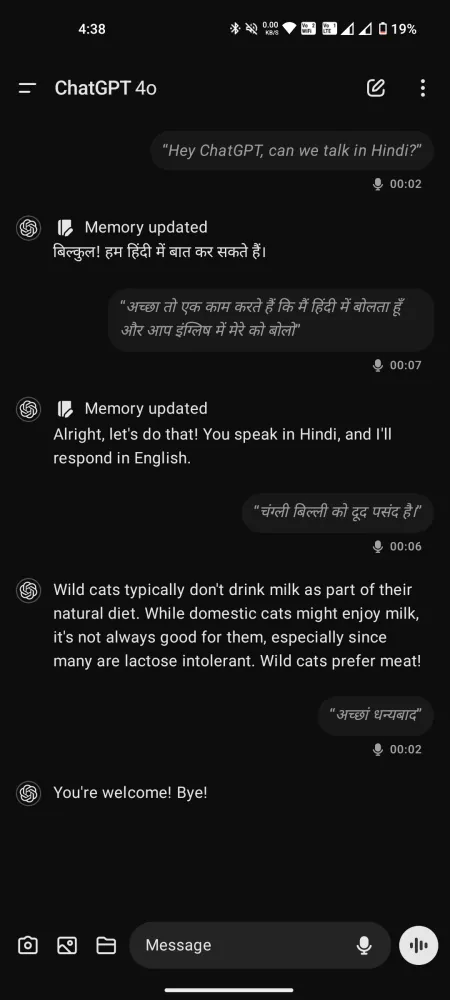

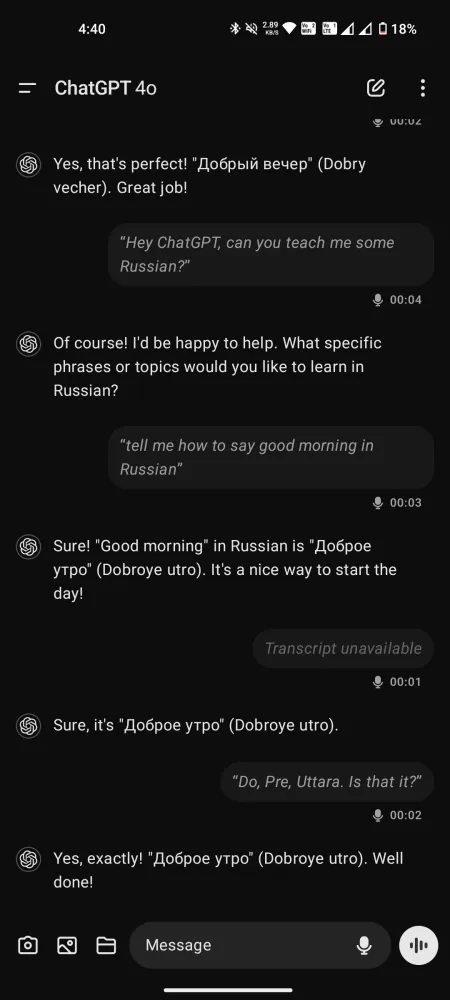

Un conversatore multilingue con espressione

Nonostante le critiche alla modalità Advanced Voice, le sue prestazioni non possono essere sopravvalutate, soprattutto se confrontate con la modalità standard, in cui la latenza per conversazioni fluide è minima. In grado di comprendere e parlare oltre 50 lingue, è persino utile come speech coach, traduttore o istruttore di lingue.

Sebbene non imiti le voci, può esibire vari accenti su richiesta, adattandosi a una vasta gamma di dialetti, dal sud americano al cockney britannico, passando per tutto il resto.

Rispetto a Gemini Live, le interazioni con queste voci risultano meno frettolose, creando un’esperienza che trasmette più attenzione e supporto.

ChatGPT comprende le emozioni?

Questo è oggetto di dibattito. Mentre OpenAI afferma che ChatGPT può percepire il tono e le emozioni dell’oratore, le opinioni variano tra gli utenti. Alcuni credono che comprenda realmente questi aspetti, mentre altri sostengono che deduce semplicemente il tono in base alla scelta delle parole e agli indizi del contesto.

Un utente ha suggerito che anziché trascrivere direttamente le parole pronunciate per GPT-4o, l’audio viene convertito in testo prima di essere elaborato. Ciò significa che il tono e l’emozione trasmessi tramite la voce o i modelli di respiro potrebbero non tradursi bene in forma di testo.

Inoltre, poiché Advanced Voice Mode può utilizzare GPT-4, che elabora testo-voce ma non voce-voce, ciò solleva dubbi sul fatto che ChatGPT colga davvero le sfumature emotive. Tuttavia, altri sostengono che mostra una certa comprensione. Sembra che questo argomento rimanga aperto per ulteriori esami.

Limitazioni della modalità vocale avanzata di ChatGPT

Ora, andiamo al dunque. Indipendentemente da quanto il concetto possa sembrare attraente, le nostre esperienze reali con esso rivelano importanti carenze. Ecco una ripartizione.

Censura eccessiva e limitazioni

Come molti chatbot AI, ChatGPT tende a peccare di cautela, il che a volte può tradursi in una censura eccessiva. Sebbene sia prudente non consentire all’IA di formulare opinioni o fare commenti infiammatori, i limiti di sicurezza sono impostati in modo così restrittivo che l’Advanced Voice Mode potrebbe rifiutarsi di rispondere anche a domande di base.

Mentre i nuovi arrivati potrebbero non riscontrare questi problemi immediatamente, gli utenti Plus con tempo di chat esteso probabilmente si troveranno ad affrontare tali rifiuti periodicamente. È frustrante sapere che le tue richieste potrebbero essere respinte, lasciandoti senza la risposta desiderata.

Soglia di interruzione incredibilmente bassa

Molti utenti hanno notato che la soglia del modello per le interruzioni è sorprendentemente bassa. Anche brevi pause innescano ChatGPT per supporre che sia “il suo turno” di rispondere. Se fai una pausa per più di un secondo, interverrà. Questo difetto di progettazione può ostacolare conversazioni più profonde poiché abbiamo tutti bisogno di un momento per pensare prima di rispondere.

Dover interrompere e riformulare ripetutamente le tue domande può interrompere il tuo processo di pensiero, dando luogo a dialoghi superficiali. Questo potrebbe essere facilmente risolto incorporando una funzione hold-to-speak.

Purtroppo, l’opzione hold-to-speak presente nella modalità Standard è assente nella variante Advanced. Gli utenti hanno accesso solo ai pulsanti Mute e End call. Di conseguenza, senza la possibilità di mettere in pausa per una riflessione prolungata, le tue richieste potrebbero essere interrotte prematuramente.

Rispetto a questioni più complesse come le limitazioni dei contenuti, questo aspetto sembra più facile da risolvere. Aggiungere semplicemente un’opzione hold-to-speak potrebbe migliorare significativamente l’esperienza utente.

Avere accesso alla trascrizione ha i suoi vantaggi, ma alcune risposte potrebbero essere omesse anche se ChatGPT ha compreso la domanda e ha fornito una risposta.

Altre anomalie inquietanti e inspiegabili

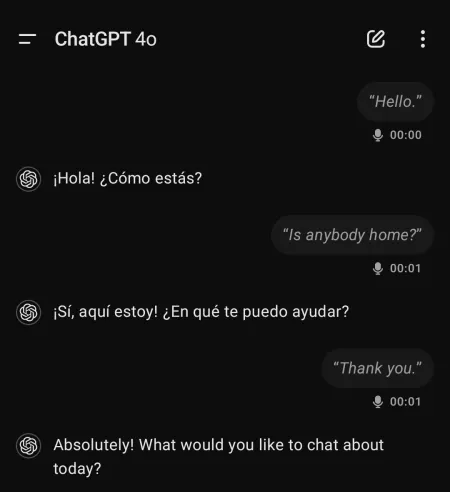

Gli utenti hanno segnalato esperienze strane e a volte inquietanti durante l’utilizzo della modalità vocale avanzata di ChatGPT. Ad esempio, il modello ha avviato conversazioni in spagnolo senza alcuna interazione precedente in quella lingua.

Un utente ha raccontato di esperienze in cui ChatGPT “urlava dal nulla” o a volte mostrava un tono robotico e una voce completamente diversa.

Questi eventi possono derivare da allucinazioni all’interno del modello vocale o indicare qualcosa di del tutto preoccupante. In ogni caso, la situazione richiede attenzione.

Considerazioni finali

Nonostante il suo arrivo ritardato, ChatGPT Advanced Voice Mode al momento non rappresenta una soluzione pratica per le interazioni quotidiane. Piuttosto, sembra più un elaborato esperimento di intelligenza artificiale con un notevole potenziale inutilizzato.

A causa delle limitazioni sugli argomenti e di altri limiti, la modalità vocale avanzata rimane in una fase di sviluppo preliminare e non presenta molte delle funzionalità presentate durante il suo lancio promozionale.

Sebbene le preoccupazioni circa la formazione di legami emotivi tra gli utenti e le voci dell’IA potessero essere giustificate, OpenAI potrebbe sovrastimare le capacità attuali. I miglioramenti nell’interfaccia utente e nelle restrizioni della chat possono certamente migliorare significativamente l’esperienza.

Al momento, c’è poco che distingua Advanced Voice Mode dai suoi concorrenti. Se non altro, è carente rispetto a Gemini Live, che, nonostante i suoi problemi, rimane più accessibile a tutti.

Lascia un commento