Le migliori alternative open source a Crawl4AI: le migliori opzioni a confronto

Crawl4AI funge da strumento complementare per il web crawling e l’estrazione di dati, in particolare per soddisfare i requisiti dei grandi modelli linguistici (LLM) e di numerose applicazioni basate sull’intelligenza artificiale. Tuttavia, non è l’unico contendente in questo spazio. In questo articolo, esploreremo le migliori alternative open source a Crawl4AI .

Le principali alternative open source a Crawl4AI

Di seguito sono elencate alcune notevoli alternative open source a Crawl4AI.

- Raschiante

- Collie

- PySpider

- Strisciando a X

- Fuoco strisciante

1] Frattale

Scrapy si distingue come framework open source basato su Python progettato per web scraping e crawling. Consente in modo efficiente agli utenti di estrarre dati dalle pagine web. Grazie all’uso di Twisted, un framework di networking asincrono, Scrapy migliora le prestazioni e la velocità di elaborazione.

Questo framework supporta l’aggiunta di middleware e pipeline, consentendo l’elaborazione personalizzata dei dati. Scrapy è abile nel gestire le richieste, tracciare i link ed estrarre le informazioni usando selettori CSS e XPath, integrandosi perfettamente nel tuo ambiente attuale.

Inoltre, Scrapy offre un’interfaccia user-friendly, semplificando il processo di tracciamento ed estrazione dei dati da vari siti web. La piattaforma è supportata da una comunità vivace e da una documentazione completa.

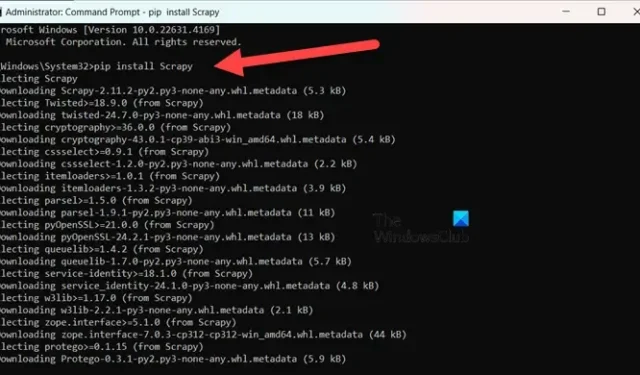

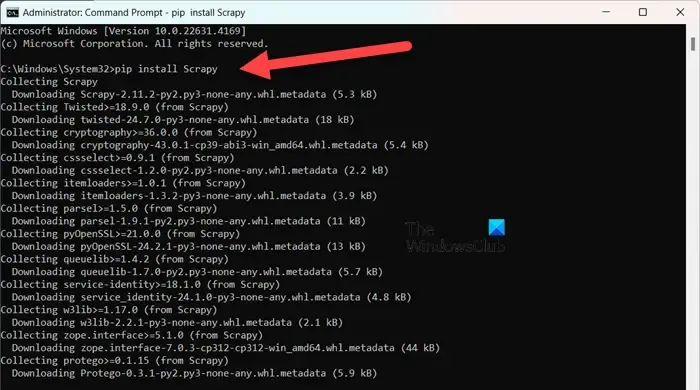

Per installare Scrapy , assicurati di usare Python 3.8 o superiore (CPython è l’impostazione predefinita, ma è supportato anche PyPy). Se stai usando Anaconda o Miniconda, installa il pacchetto tramite il canale conda-forge con il seguente comando:

conda install -c conda-forge scrapy

In alternativa, per coloro che preferiscono PyPI, eseguire il comando in un Prompt dei comandi con privilegi elevati:

pip install Scrapy

Per approfondire questo strumento, visita scrapy.org .

2] Collie

Colly è una libreria di scraping semplice sviluppata per Golang. Semplifica il processo di invio di richieste HTTP, analisi HTML e recupero di dati da siti Web. Colly presenta funzioni che consentono agli sviluppatori di navigare nelle pagine Web, filtrare elementi utilizzando selettori CSS e affrontare varie sfide di estrazione dati.

La caratteristica distintiva di Colly è la sua notevole performance, in grado di elaborare oltre 1000 richieste al secondo su un singolo core; questa velocità aumenta con core aggiuntivi. Raggiunge tale efficienza grazie al suo caching integrato e al supporto per scraping sincrono e asincrono.

Tuttavia, Colly presenta delle limitazioni, come la mancanza di rendering JavaScript e una community più piccola, che comportano meno estensioni e una documentazione più limitata.

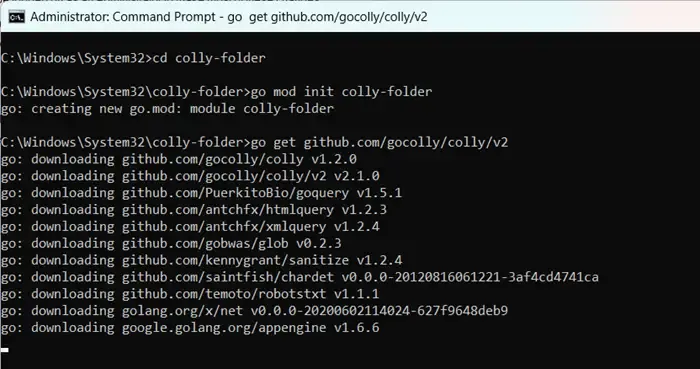

Per iniziare a usare Colly, installa prima Golang visitando go.dev . Dopo l’installazione, riavvia il computer, apri il Prompt dei comandi come amministratore e inserisci i comandi:

mkdir colly-folder cd colly-folder

go mod init colly-folder

go get github.com/gocolly/colly/v2

Puoi rinominare “colly-folder” come preferisci. Dopo aver creato il modulo, puoi eseguire il tuo web scraper usando go run main.go.

3] PySpider

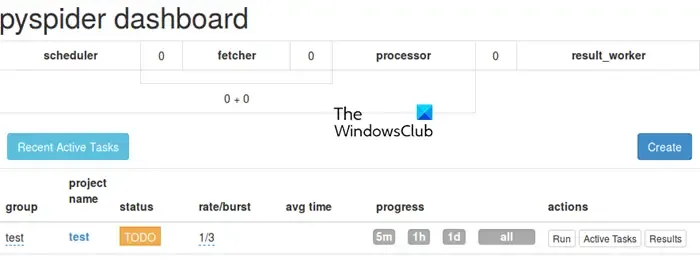

PySpider funziona come un sistema di web crawling completo, caratterizzato da un’interfaccia utente intuitiva basata sul web, semplificando la gestione e il monitoraggio dei tuoi crawler. È attrezzato per gestire siti web ricchi di JavaScript tramite la sua integrazione con PhantomJS.

A differenza di Colly, PySpider offre ampie capacità di gestione delle attività, tra cui la pianificazione e la definizione delle priorità delle attività, superando Crawl4AI in questo senso. Tuttavia, vale la pena notare che potrebbe avere un ritardo nelle prestazioni se confrontato con Crawl4AI a causa dell’architettura asincrona di quest’ultimo.

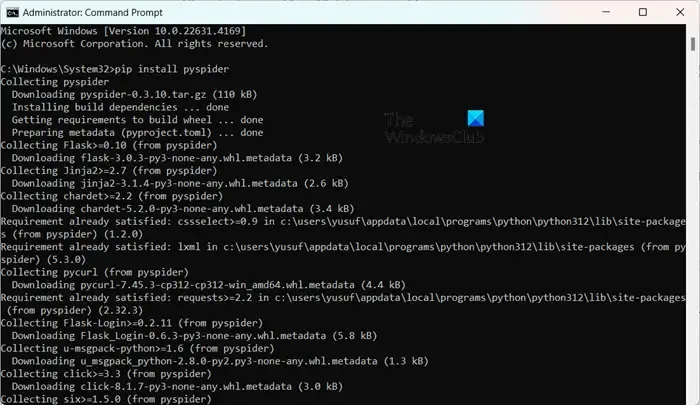

Installare PySpider è semplice, soprattutto se hai già impostato Python. Puoi semplicemente eseguire pip install pyspiderin un Prompt dei comandi con privilegi elevati. Per iniziare, usa semplicemente il comando pyspidere accedi all’interfaccia su http://localhost:5000/ nel tuo browser web.

4] Strisciando a X

X-Crawl è una libreria flessibile per Node.js che utilizza tecnologie AI per migliorare l’efficienza del web crawling. Questa libreria integra capacità AI per facilitare lo sviluppo di web crawler e scraper efficaci.

X-Crawl eccelle nella gestione di contenuti dinamici generati da JavaScript, una necessità per molti siti Web moderni. Fornisce inoltre numerose opzioni di personalizzazione, studiate su misura per adattare l’esperienza di scansione alle tue esigenze.

È importante notare alcune distinzioni tra Crawl4AI e X-Crawl, principalmente basate sul linguaggio di programmazione preferito: Crawl4AI utilizza Python, mentre X-Crawl è basato su Node.js.

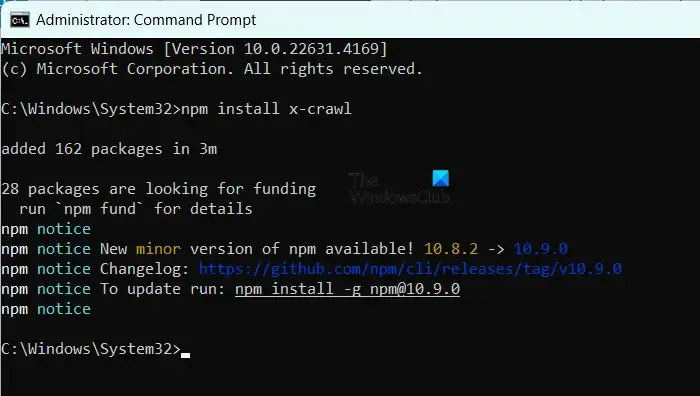

Per installare X-Crawl, assicurati di avere Node.js sul tuo computer, quindi esegui semplicemente il comando npm install x-crawl.

5] Fuoco strisciante

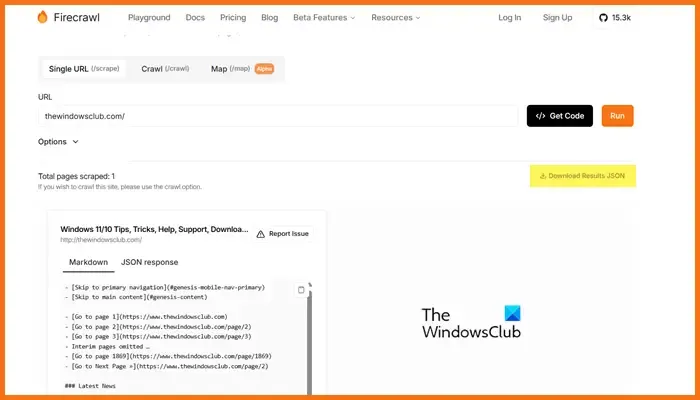

Firecrawl, sviluppato da Mendable.ai, è un sofisticato strumento di web scraping che trasforma i dati web in markdown ordinatamente organizzati o altri formati, ottimizzati per modelli linguistici di grandi dimensioni (LLM) e applicazioni AI. Genera output pronti per l’uso LLM, facilitando l’integrazione di questo contenuto in diversi modelli linguistici e soluzioni AI. Lo strumento è dotato di un’API di facile utilizzo per inviare lavori di scansione e ottenere risultati. Per maggiori dettagli su Firecrawl, visita firecrawl.dev , inserisci l’URL del sito web che desideri analizzare e fai clic su Esegui.

Quale strumento open source è ottimale per lo sviluppo web?

Sono disponibili una pletora di strumenti di sviluppo web open source che puoi utilizzare. Per la modifica del codice, considera Visual Studio Code o Atom. Se hai bisogno di framework frontend, Bootstrap e Vue.js sono delle scelte eccellenti, mentre Django ed Express.js sono ottimi per lo sviluppo backend. Inoltre, piattaforme come Git, GitHub, Figma, GIMP, Slack e Trello offrono anche opzioni open source che possono migliorare il tuo flusso di lavoro di sviluppo web.

I modelli GPT open source sono accessibili?

Sì, esistono vari modelli GPT open source, tra cui GPT-Neo di EleutherAI, Cerebras-GPT, BLOOM, GPT-2 di OpenAI e Megatron-Turing NLG di NVIDIA/Microsoft. Questi modelli forniscono una gamma di soluzioni per soddisfare requisiti diversi, dall’elaborazione del linguaggio generica ai modelli creati per capacità multilingue o attività ad alte prestazioni.

Lascia un commento