Come proteggere il tuo sito web dallo scraping AI

In questo momento, il tuo sito web potrebbe essere un buffet all-you-can-eat per gli affamati scraper di AI incaricati della raccolta di dati per l’addestramento di grandi modelli linguistici come ChatGPT. Se non vuoi che i tuoi preziosi contenuti diventino la prossima risposta generata dall’AI, allora devi proteggere il tuo sito web da questa nuova minaccia alla proprietà intellettuale.

Come prevenire lo scraping dall’IA

Proteggere il tuo sito web dallo scraping AI non è così difficile come potrebbe sembrare. Infatti, molti dei metodi collaudati usati per combattere il web scraping tradizionale sono ugualmente efficaci contro le loro controparti basate sull’AI.

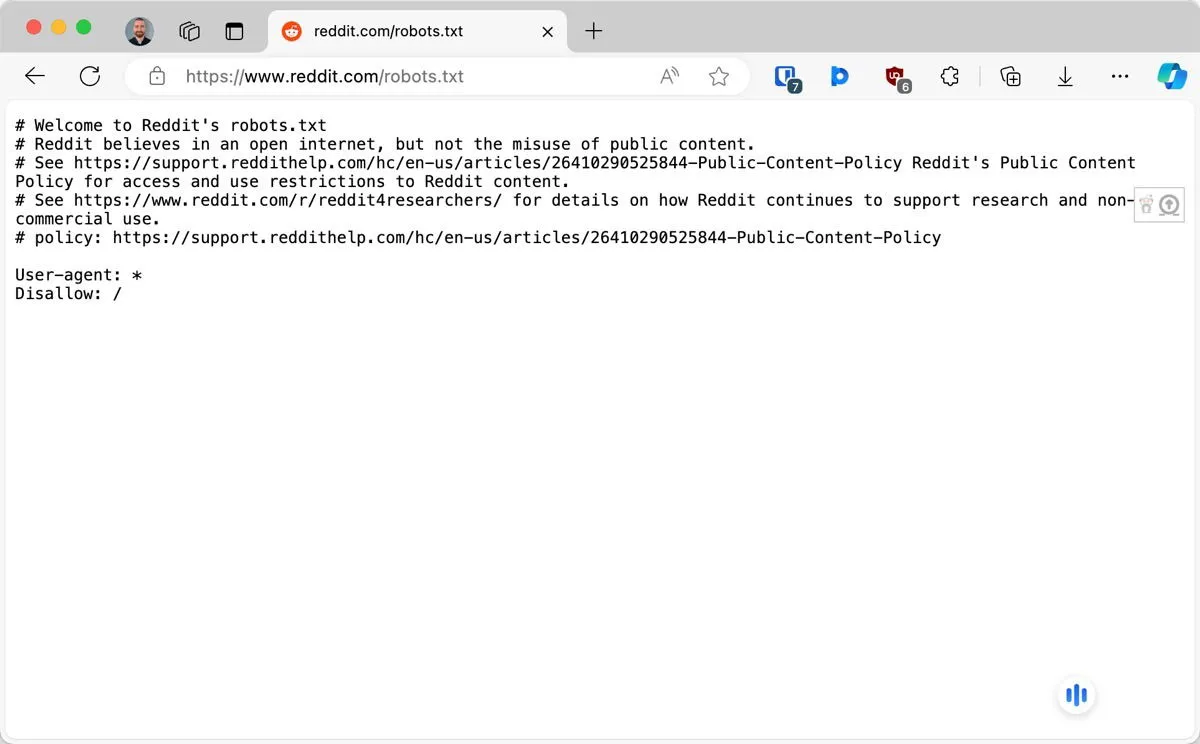

1. Configurare robots.txt per bloccare specifici bot AI

Il file robots.txt è la prima linea di difesa del tuo sito web contro i crawler indesiderati, inclusi quelli che appartengono a OpenAI e Anthropic. Questo file viene utilizzato per implementare il protocollo Robots Exclusion Protocol e informare i bot ben educati su quali parti del tuo sito sono autorizzati ad accedere.

Dovresti riuscire a trovare il file robots.txt nella directory principale di un sito web. Se non è lì, puoi crearlo usando qualsiasi editor di testo. Per bloccare uno specifico bot AI, devi scrivere solo due righe:

La prima riga identifica il bot, e la seconda riga gli dice di non accedere ad alcuna pagina. Nell’esempio sopra, stiamo bloccando il crawler di OpenAI. Ecco i nomi di altri bot AI che dovresti considerare di bloccare: Google-Extended, Claude-Web, FacebookBot e anthropic-ai.

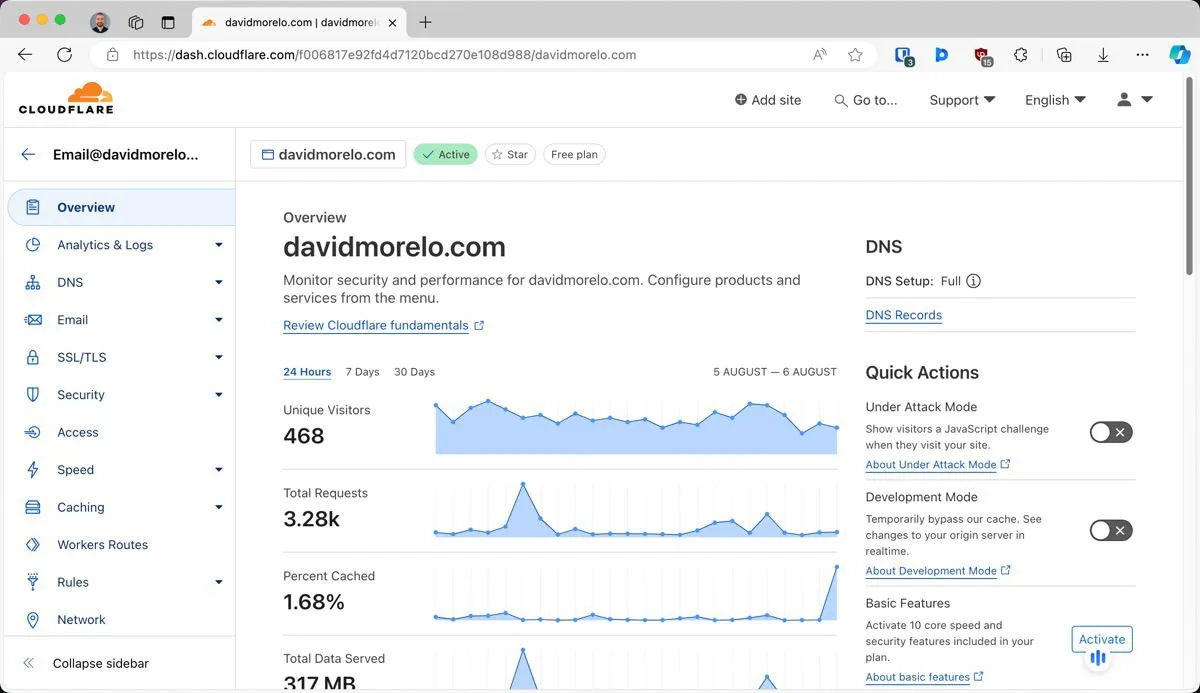

2. Implementare la limitazione della velocità e il blocco IP

La limitazione della velocità e il blocco IP funzionano monitorando e controllando il flusso di traffico verso il tuo sito web:

- Il rate limiting imposta un limite al numero di richieste che un utente (o bot) può effettuare entro un intervallo di tempo specifico. Se un visitatore supera questo limite, viene temporaneamente bloccato o le sue richieste vengono rallentate.

- Il blocco IP, d’altro canto, consente di vietare del tutto specifici indirizzi IP o intervalli di indirizzi IP identificati come fonti di attività di scraping.

Uno dei modi più semplici per implementare queste tecniche è utilizzare Cloudflare, un popolare servizio di sicurezza e rete per la distribuzione di contenuti (CDN).

Cloudflare si trova tra il tuo server e Internet in generale, dove funge da scudo protettivo per il tuo sito web. Una volta posizionato il tuo sito web dietro Cloudflare, puoi configurare regole di limitazione della velocità e gestire i blocchi IP da una dashboard intuitiva.

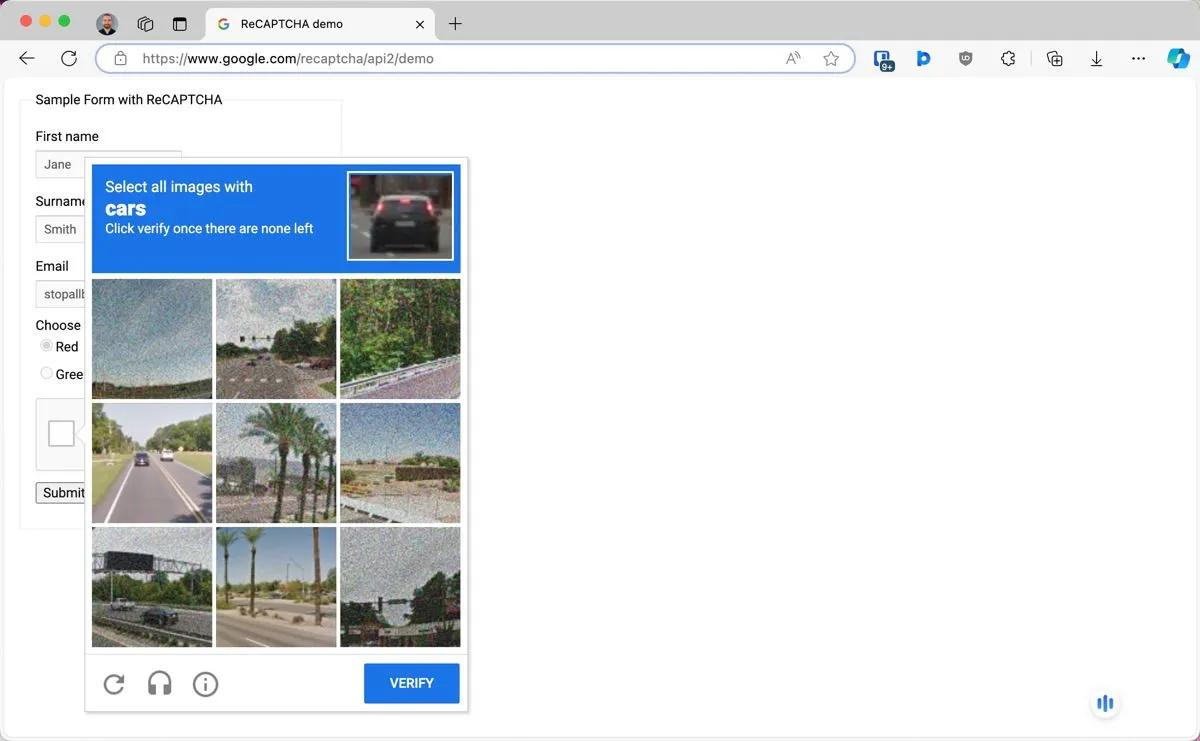

3. Utilizzare CAPTCHA e altri metodi di verifica umana

I CAPTCHA (Completely Automated Public Turing test to tell Computers and Humans Apart) sono un metodo collaudato per distinguere gli utenti umani dai bot.

Uno dei CAPTCHA più popolari e, allo stesso tempo, efficaci è reCAPTCHA di Google. Per utilizzarlo, devi visitare la console di amministrazione di reCAPTCHA e registrarti per una coppia di chiavi API. Quindi puoi usare un plugin WordPress come Advanced Google reCAPTCHA o creare un’implementazione personalizzata basata sulla documentazione ufficiale .

4. Utilizzare tecniche di rendering di contenuti dinamici

Un altro modo intelligente per proteggere il tuo sito web dallo scraping AI è usare tecniche di rendering di contenuti dinamici. L’idea è semplice ma efficace: quando un bot di scraping AI visita il tuo sito, riceve contenuti senza valore o niente del tutto, mentre i visitatori abituali vedono il contenuto corretto e completo.

Ecco come funziona in pratica:

- Il tuo server identifica l’agente che accede al sito, distinguendo tra utenti abituali e potenziali bot AI.

- Sulla base di questa identificazione, il server decide quale contenuto servire utilizzando la logica JavaScript.

- Per i visitatori umani, il server fornisce la versione completa del tuo sito. Per i bot, fornisce un set di contenuti diverso.

Poiché gli scraper AI in genere non elaborano alcun codice JavaScript (solo contenuti HTML di base), non hanno modo di rendersi conto di essere stati ingannati.

5. Impostare l’autenticazione dei contenuti e l’accesso controllato

Uno dei modi più infallibili per proteggere i tuoi contenuti dagli scraper AI è semplicemente metterli dietro un cancello digitale. Dopotutto, questi bot possono raccogliere solo ciò che è accessibile al pubblico.

La forma più semplice di questa protezione è richiedere agli utenti di effettuare l’accesso per accedere a determinate parti del tuo sito web. Questo da solo può scoraggiare i bot scraper AI, poiché in genere non hanno la capacità di creare account o autenticarsi.

Per coloro che vogliono fare un ulteriore passo avanti, mettere parte o tutto il contenuto dietro un paywall può fornire una protezione ancora più forte. Gli utenti di WordPress, ad esempio, possono facilmente implementarlo utilizzando plugin come MemberPress .

Naturalmente, devi trovare un equilibrio tra protezione e accessibilità. Non tutti i visitatori potrebbero essere disposti a creare un account solo per accedere ai tuoi contenuti, per non parlare di pagarli. La fattibilità di questo approccio dipende interamente dalla natura dei tuoi contenuti e dalle aspettative del tuo pubblico.

6. Aggiungi filigrane o avvelena le tue immagini

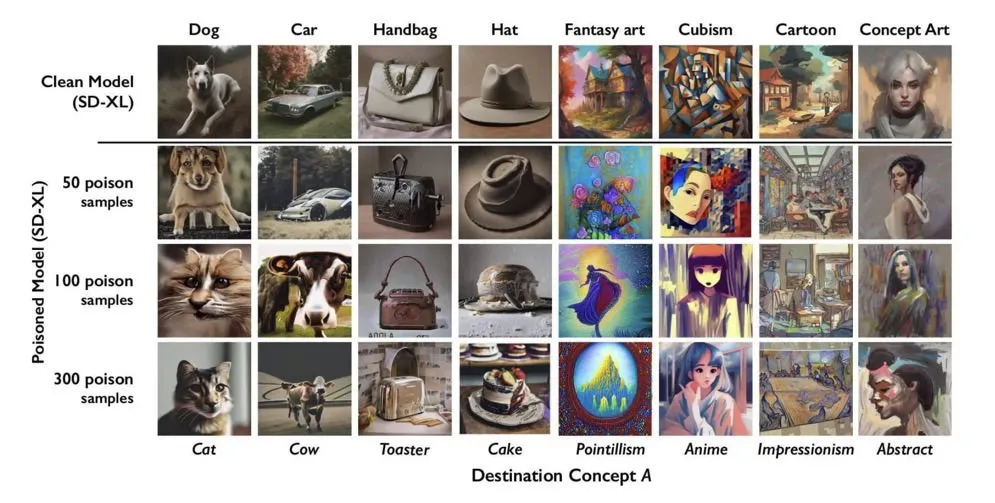

La filigrana digitale è una tecnica classica per proteggere la proprietà intellettuale, ma si sta evolvendo per rispondere alle sfide dell’era dell’intelligenza artificiale. Una tecnica emergente in questo ambito è il data poisoning, che comporta l’apportare modifiche impercettibili ai contenuti, impercettibili agli esseri umani ma che possono confondere o interrompere i sistemi di intelligenza artificiale che cercano di estrarli o analizzarli.

Strumenti come Glaze possono alterare le immagini in modi che le rendono difficili da elaborare in modo accurato per i modelli AI, pur continuando a sembrare normali agli osservatori umani. C’è anche Nightshade , che porta l’avvelenamento dei dati a un livello superiore interferendo attivamente con l’addestramento AI.

Introducendo piccole modifiche alle immagini, Nightshare può “rompere” le ipotesi che i modelli di intelligenza artificiale fanno durante l’addestramento. Se un sistema di intelligenza artificiale cerca di imparare da queste immagini avvelenate, potrebbe avere difficoltà a generare rappresentazioni accurate.

In teoria, se il tuo contenuto è ben filigranato o avvelenato, potrebbe comunque essere copiato, ma le aziende di intelligenza artificiale saranno meno propense a includerlo nei loro dati di training. Potrebbero persino evitare attivamente di copiare dal tuo sito in futuro per evitare di contaminare i loro set di dati.

7. Sfrutta gli avvisi di rimozione DMCA e le leggi sul copyright

Sebbene i metodi precedenti si concentrino sulla prevenzione dello scraping tramite intelligenza artificiale mediante misure tecniche, a volte è meglio adottare un approccio diverso, sfruttando le notifiche del Digital Millennium Copyright Act (DMCA) e le leggi sul copyright.

Se scopri che il tuo contenuto è stato copiato e utilizzato senza autorizzazione, puoi emettere un avviso di rimozione DMCA. Si tratta di una richiesta formale per far rimuovere il tuo materiale protetto da copyright da un sito web o da una piattaforma.

Nel caso in cui le tue notifiche di rimozione DMCA non vengano rispettate (e dovresti essere preparato al fatto che ciò non accadrà), puoi passare all’azione legale e non saresti il primo a farlo.

OpenAI e Microsoft sono attualmente citate in giudizio per violazioni del copyright dal Center for Investigative Reporting, insieme a diverse altre organizzazioni giornalistiche. Queste cause legali sostengono che le aziende di intelligenza artificiale stanno utilizzando contenuti protetti da copyright senza autorizzazione o compenso per addestrare i loro modelli. Sebbene l’esito di questi casi debba ancora essere determinato, spianano la strada ad altri da seguire.

Immagine di copertina creata usando DALL-E. Tutti gli screenshot sono di David Morelo.

Lascia un commento