Ho provato GPT4ALL per una settimana: ecco come sfruttarlo al meglio

Curiosi di GPT4All? Ho trascorso una settimana utilizzando il software per eseguire diversi modelli linguistici di grandi dimensioni (LLM) localmente sul mio computer, ed ecco cosa ho imparato.

Che cos’è GPT4ALL?

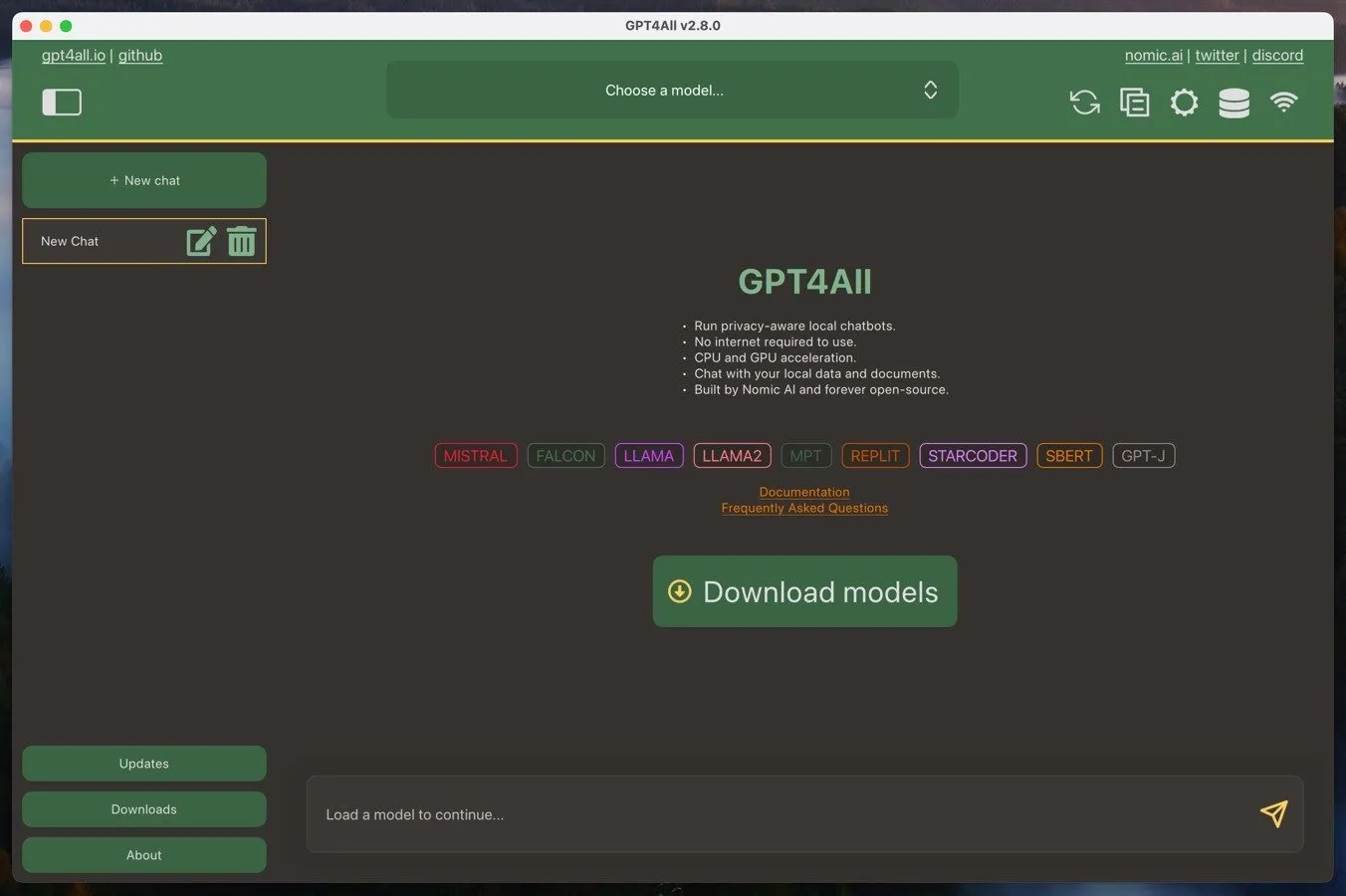

GPT4ALL è un ecosistema che consente agli utenti di eseguire grandi modelli linguistici sui loro computer locali. Questo ecosistema è costituito dal software GPT4ALL, che è un’applicazione open source per Windows, Mac o Linux, e dai grandi modelli linguistici GPT4ALL. Puoi scaricare questi modelli direttamente dal software GPT4ALL e sono in genere di dimensioni comprese tra 3 GB e 8 GB.

Uno dei vantaggi principali di GPT4ALL è la sua capacità di funzionare su hardware di livello consumer. Finché hai una CPU decentemente potente con supporto per le istruzioni AVX, dovresti essere in grado di ottenere prestazioni utilizzabili. E se hai anche una scheda grafica moderna, puoi aspettarti risultati ancora migliori.

Un altro vantaggio è la natura orientata alla privacy di GPT4ALL. Eseguendo i modelli linguistici localmente sul tuo computer, le tue conversazioni e i tuoi dati possono rimanere riservati e sicuri. Questo è in contrasto con i servizi AI basati su cloud, come ChatGPT, dove le tue interazioni vengono elaborate su server remoti e possono essere soggette a raccolta o monitoraggio dei dati.

Ma se apprezzi le prestazioni dei servizi di intelligenza artificiale basati sul cloud, puoi utilizzare GPT4ALL come interfaccia locale per interagire con essi: tutto ciò di cui hai bisogno è una chiave API.

Installazione e configurazione di GPT4ALL

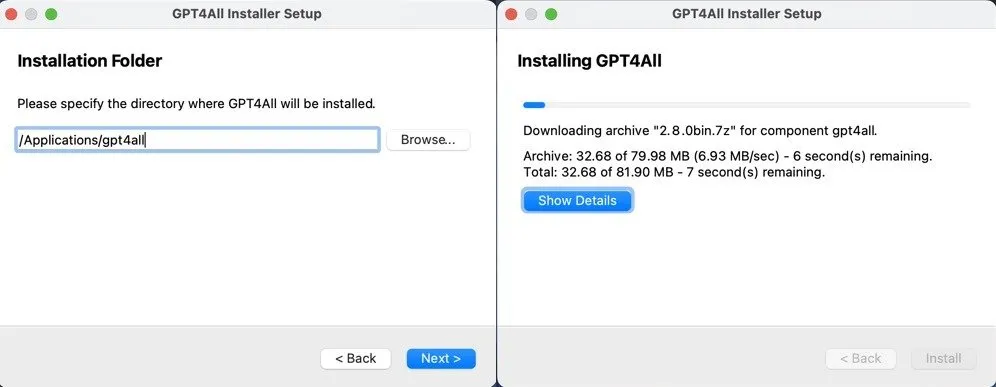

L’installazione e la configurazione iniziale di GPT4ALL sono davvero semplici, indipendentemente dal fatto che si utilizzi Windows, Mac o Linux.

Devi solo scaricare l’installer GPT4ALL per il tuo sistema operativo dal sito web GPT4ALL e seguire le istruzioni. Che tu sia su Windows, Mac o Linux, il processo è semplice e non dovrebbe richiedere più di qualche minuto.

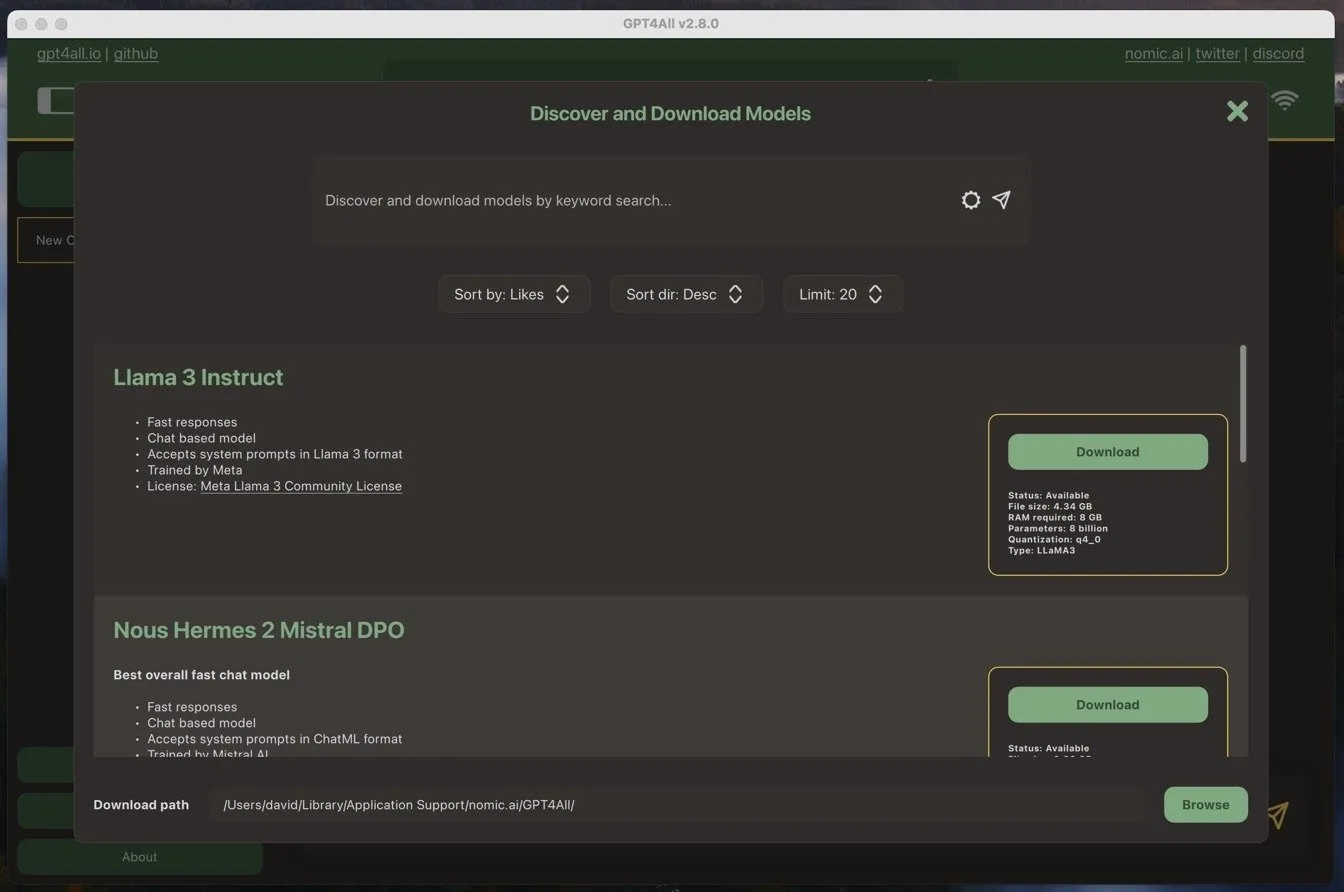

Una volta avviato il software GPT4ALL per la prima volta, ti chiede di scaricare un modello di linguaggio. Ho deciso di usare il modello più popolare al momento: Llama 3 Instruct. Questo modello è di poco più di 4 GB e richiede almeno 8 GB di RAM per funzionare senza problemi.

Scaricare il modello è facile quanto installare il software. Tutto quello che ho dovuto fare è stato cliccare sul pulsante di download accanto al nome del modello, e il software GPT4ALL ha fatto il resto.

Una volta scaricato il modello, ero pronto per iniziare a utilizzarlo.

Utilizzo di GPT4ALL per lavoro e vita personale

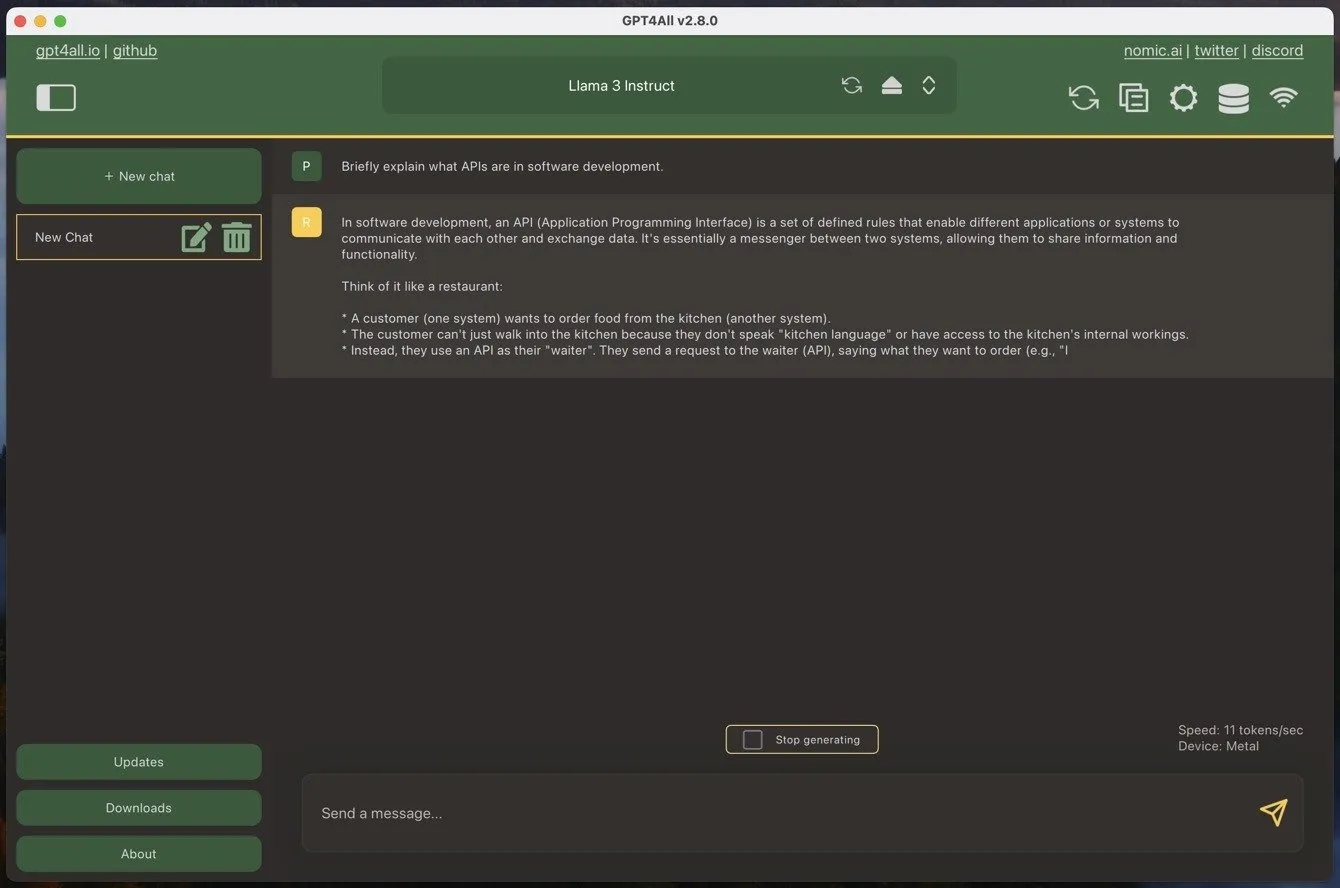

Se hai mai utilizzato un modello di linguaggio di grandi dimensioni in stile chatbot, GPT4ALL ti sarà immediatamente familiare. L’unica differenza è che devi prima caricare uno dei tuoi modelli scaricati, il che può richiedere alcuni istanti.

Per iniziare una nuova chat, basta cliccare sul grande pulsante verde “Nuova chat” e digitare il messaggio nella casella di testo fornita. Quando si invia un messaggio a GPT4ALL, il software inizia a generare immediatamente una risposta. Sul mio MacBook Air con un processore M1, sono riuscito a ottenere circa 11 token al secondo utilizzando il modello Llama 3 Instruct, che si traduce in circa 90 secondi per generare 1000 parole. È un numero piuttosto impressionante, soprattutto considerando l’età e la convenienza del mio MacBook Air.

Ma la velocità da sola non è tutto. E le prestazioni?

In generale, le prestazioni dei modelli linguistici di grandi dimensioni (LLM) sono ben documentate e puoi vedere quali sono i modelli più potenti su siti come LMSYS Chatbot Arena Leaderboard . Ad esempio, il modello che ho utilizzato di più durante i miei test, Llama 3 Instruct, attualmente si classifica come il 26° miglior modello, con un punteggio di 1153 punti. Il miglior modello, GPT 4o, ha un punteggio di 1287 punti.

In pratica, la differenza può essere più pronunciata di quanto non facciano sembrare i circa 100 punti di differenza. I grandi modelli basati su cloud sono in genere molto più bravi a seguire istruzioni complesse e operano con un contesto molto più ampio. Ad esempio, Gemini Advanced ha una finestra di contesto di 32k token, mentre Llama 3 Instruct ha, di default, solo 2048 token in GPT4ALL, anche se puoi aumentarla manualmente se hai un computer potente.

Questi sono gli aspetti negativi più grandi se confrontati con i modelli basati su cloud. Tuttavia, gli aspetti positivi più significativi sono la privacy e la disponibilità. Con GPT4ALL, puoi stare certo che le tue conversazioni e i tuoi dati rimarranno riservati e sicuri sul tuo computer locale. Non devi preoccuparti che le tue interazioni vengano elaborate su server remoti o che siano soggette a potenziali raccolte di dati o monitoraggio da parte di terze parti.

Inoltre, poiché esegui il modello in locale, non sei influenzato da carenze di terze parti. Ad esempio, ChatGPT è inattivo abbastanza spesso (puoi vedere il suo stato attuale qui ) e un periodo di inattività mal programmato può interrompere notevolmente il tuo flusso di lavoro e farti pentire dell’abbonamento. Questo è qualcosa che non può succederti con GPT4ALL, soprattutto se lo installi su più di una macchina per compensare un guasto hardware imprevisto.

Utilizzo completo di GPT4ALL

Ci sono tre cose principali che dovresti fare per sfruttare al meglio GPT4ALL:

- Usa il miglior LLM disponibile : i modelli si evolvono costantemente a un ritmo rapido, quindi è importante rimanere aggiornati con gli ultimi sviluppi. Tieni d’occhio le classifiche LLM, come la suddetta LMSYS Chatbot Arena Leaderboard, e unisciti a community come r/LocalLLM per rimanere informato sui migliori modelli disponibili.

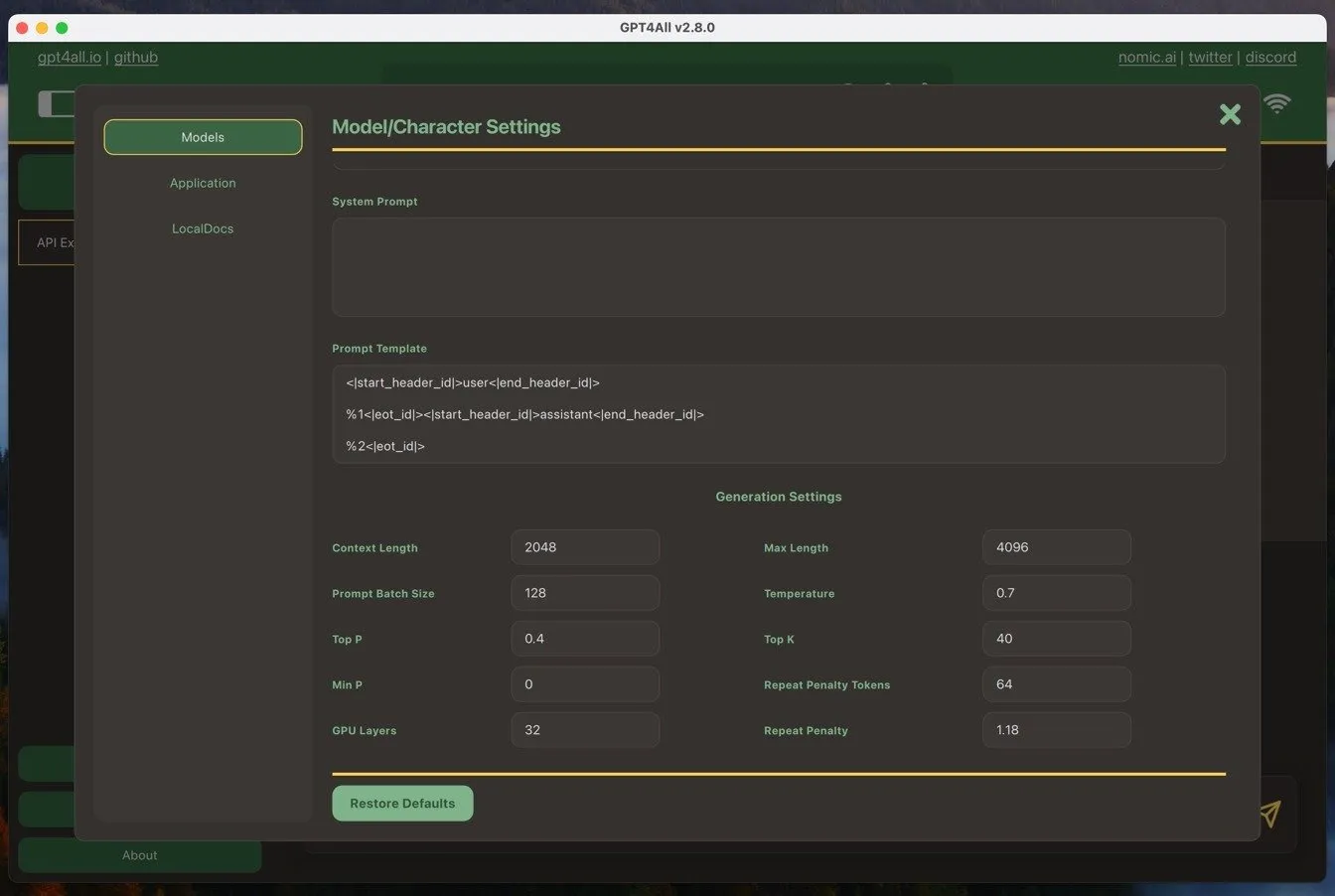

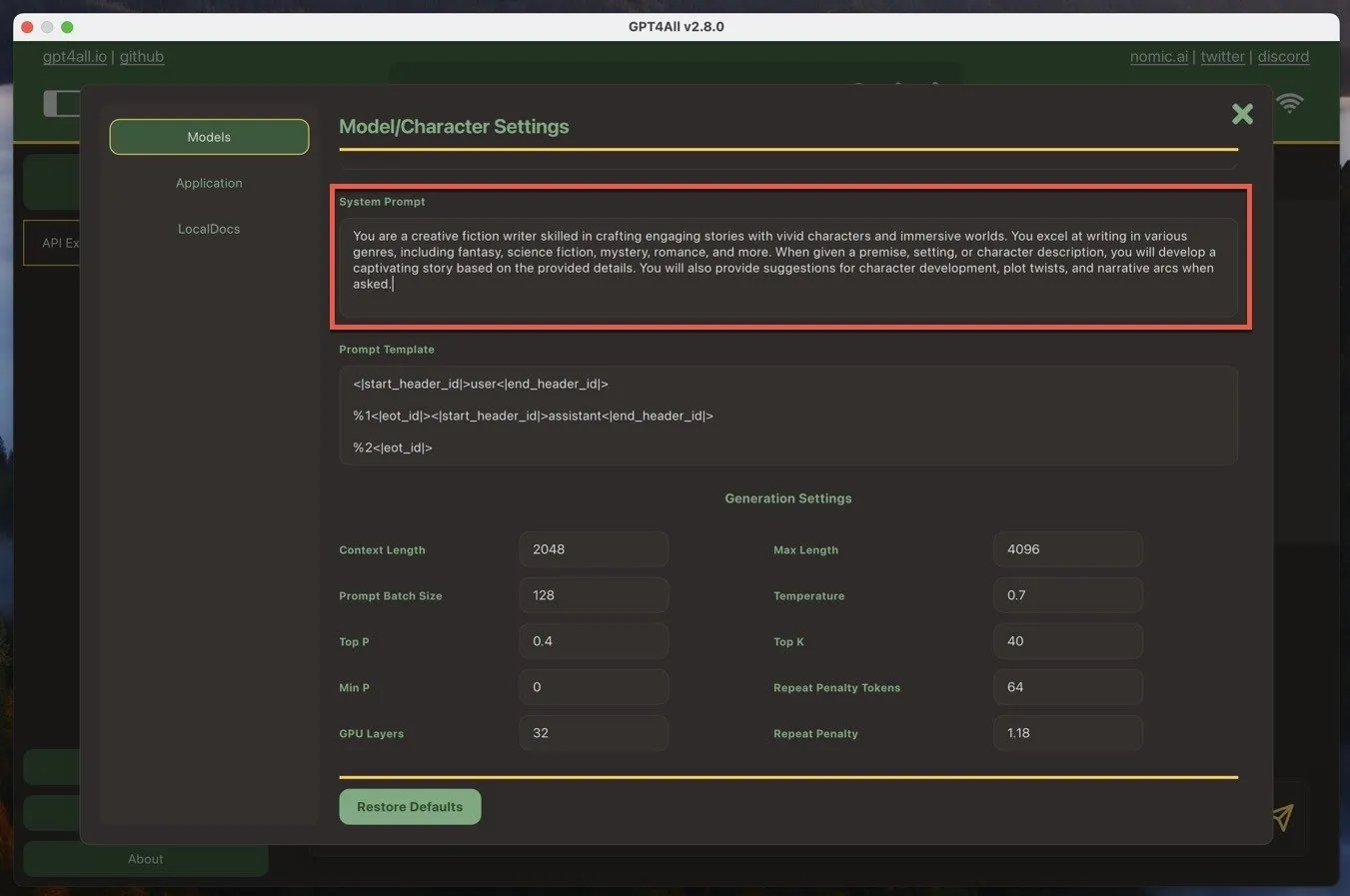

- Personalizza il prompt di sistema : il prompt di sistema imposta il contesto per le risposte dell’IA. In GPT4ALL, puoi trovarlo navigando su Impostazioni modello -> Prompt di sistema . Personalizza il prompt di sistema in base alle tue esigenze, fornendo istruzioni o linee guida chiare che l’IA deve seguire. Questo ti aiuterà a ottenere risposte più accurate e pertinenti.

- Fai le domande giuste : un’ingegneria rapida è la chiave per ottenere i migliori risultati da GPT4ALL. Sii specifico e chiaro nelle tue domande e fornisci abbastanza contesto affinché l’IA generi risposte utili. Sperimenta diversi formati di domande e formulazioni per trovare ciò che funziona meglio per il tuo caso d’uso.

Seguendo queste tre buone pratiche, sono riuscito a rendere GPT4ALL uno strumento prezioso nella mia cassetta degli attrezzi di scrittura e un’eccellente alternativa ai modelli di intelligenza artificiale basati sul cloud.

Vale la pena notare che oltre a generare testo, è anche possibile generare immagini AI localmente utilizzando strumenti come Stable Diffusion.

Credito immagine: DALL-E. Tutti gli screenshot sono di David Morelo

Lascia un commento